Flink在实时安全数据分析与异常检测中的应用

版权申诉

"该资源是一份关于基于Flink的安全数据分析与异常检测的演讲稿,由汇付天下的高级信息安全工程师贾林杰分享。内容涵盖了安全领域数据的特点、处理流程,以及对比了基于ELK的日志收集及分析方案,并介绍了Apache Flink在实时安全数据分析中的优势。"

在安全数据分析与异常检测领域,数据的多样性和复杂性是关键挑战。数据来自不同的源头,如主机、网络、应用和安全设备,类型繁多,结构复杂,关联分析难度大。此外,由于数据是持续不断的流数据,其量级巨大,因此对实时性的要求非常高,及时发现异常对于降低风险至关重要。

安全领域的数据处理流程分为四个阶段:数据收集、数据处理、数据分析和数据输出。在数据收集阶段,需要全面收集各种日志、告警和外部情报;处理阶段则涉及数据标准化、字段扩展和关联;分析阶段执行多维度指标计算和条件判断;最后,通过分析结果进行可视化、规则检测和特征提取。

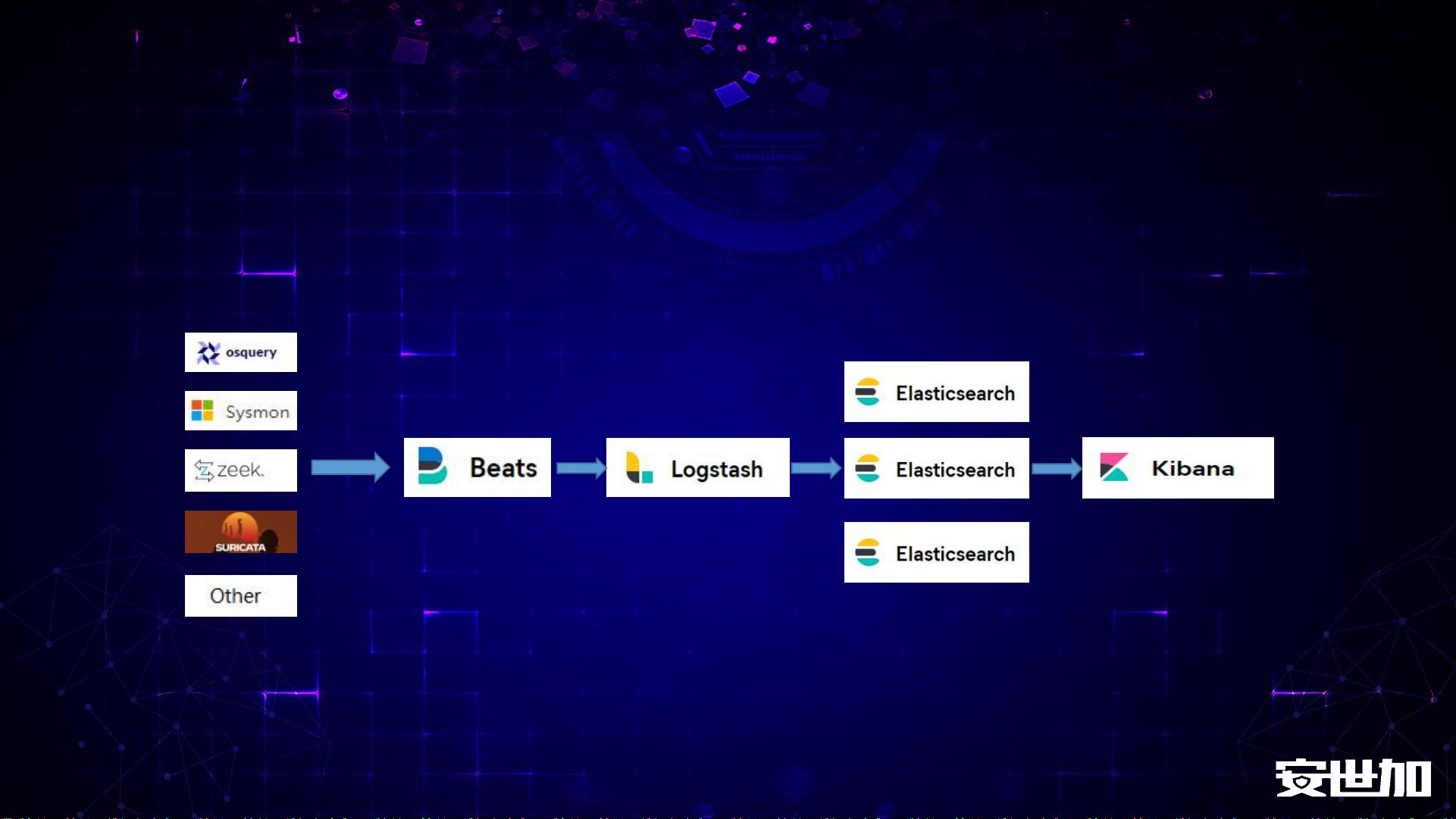

基于ELK(Elasticsearch、Logstash、Kibana)的日志收集和分析方案具有一定的优势,如Beats快速接入数据,Logstash进行数据清洗和过滤,Elasticsearch提供强大的分布式搜索功能,以及Kibana的可视化展示。然而,ELK套件在数据清洗、转换、扩展和有状态计算方面存在局限,不适用于长时间跨度的大数据存储。

Apache Flink是一个强大的流处理引擎,适合处理无界和有界数据流,支持有状态计算,这使得它在实时安全数据分析中具有显著优势。Flink能够在保证低延迟的同时处理大量数据,适应安全场景中实时告警的需求。通过Flink,可以构建更高效、灵活的数据处理管道,实现复杂的数据关联和分析,同时,它还具备良好的可扩展性,能够处理长时间跨度的大量数据。

这份资料探讨了如何利用现代技术如Flink来优化安全数据分析和异常检测的流程,以应对不断增长的数据挑战和实时需求,提高安全防护的能力。

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-10-21 上传

2023-07-07 上传

智慧化智能化数字化方案

- 粉丝: 569

- 资源: 1万+

最新资源

- AirKiss技术详解:无线传递信息与智能家居连接

- Hibernate主键生成策略详解

- 操作系统实验:位示图法管理磁盘空闲空间

- JSON详解:数据交换的主流格式

- Win7安装Ubuntu双系统详细指南

- FPGA内部结构与工作原理探索

- 信用评分模型解析:WOE、IV与ROC

- 使用LVS+Keepalived构建高可用负载均衡集群

- 微信小程序驱动餐饮与服装业创新转型:便捷管理与低成本优势

- 机器学习入门指南:从基础到进阶

- 解决Win7 IIS配置错误500.22与0x80070032

- SQL-DFS:优化HDFS小文件存储的解决方案

- Hadoop、Hbase、Spark环境部署与主机配置详解

- Kisso:加密会话Cookie实现的单点登录SSO

- OpenCV读取与拼接多幅图像教程

- QT实战:轻松生成与解析JSON数据