神经网络个体公平性证明与优化方法

62 浏览量

更新于2024-06-19

收藏 2.07MB PDF 举报

“神经网络的个体公平性保证”

在当前的数字化时代,神经网络已经成为人工智能领域的核心工具,广泛应用于诸如决策支持、风险评估和推荐系统等场景。然而,随着它们的普及,也引发了对模型公平性的担忧。这篇论文深入探讨了前馈神经网络(NN)的个体公平性(Individual Fairness, IF)的证明问题,旨在确保模型的决策不会因个人的敏感属性(如种族、性别)而产生歧视。

个体公平性概念由Dwork等人在2012年提出,它要求模型在所有与敏感属性无关的个体之间保持一致的决策行为。不同于群体公平性,个体公平性关注每个个体的具体情况,而不是整体统计特性,从而提供更严格的公平性保证。论文中提到的NN-δ-IF公式是实现这一目标的一种方式,它限制了任意两个NN相似个体之间的输出差异不超过一个最大决策容差δ0。

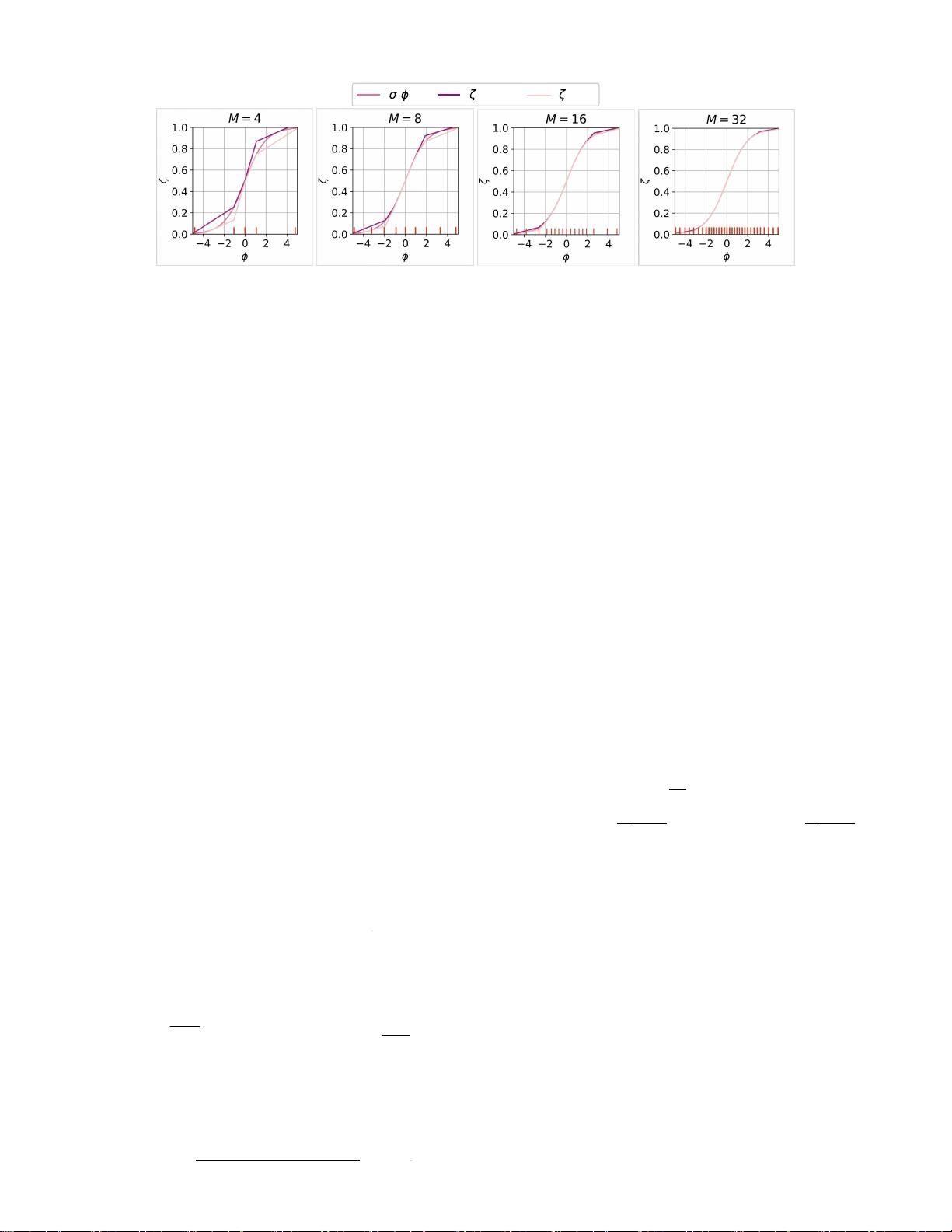

论文中,作者使用马氏距离(Mahalanobis distance)等度量来衡量个体之间的相似性,并通过分段线性函数对神经网络的非线性全局行为进行上界和下界估计。他们将这个问题转化为混合线性规划问题,通过求解该问题可以计算出IF保证。这种方法被应用于四个常见的公平性基准数据集,展示了解决方案的有效性。

为了在训练过程中进一步促进公平性,论文还提出了修改NN损失函数的方法,以鼓励模型学习公平的决策边界。实验结果表明,使用这种方法训练的神经网络在公平性和性能上都优于现有的最先进的技术。

尽管个体公平性提供了更强的保障,但在实际应用中仍面临挑战,比如计算复杂性增加、可能牺牲模型的效率以及难以找到合适的相似性度量。此外,个体公平性的实施需要谨慎处理,因为它可能与模型的其他目标(如准确率或召回率)存在冲突。

这篇论文为神经网络的公平性研究提供了新的理论框架和实用工具,对于理解并改进机器学习模型的公平性具有重要意义。它不仅为确保模型在敏感属性上的公平决策提供了理论基础,也为未来的研究和实践提供了指导。通过这样的工作,我们可以期望在未来的人工智能系统中看到更加公正和包容的决策过程。

2024-06-03 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-07-14 上传

2009-09-27 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性