艺术与科学:神经网络可解释性技术的深度剖析

发布时间: 2024-09-06 03:31:49 阅读量: 96 订阅数: 48

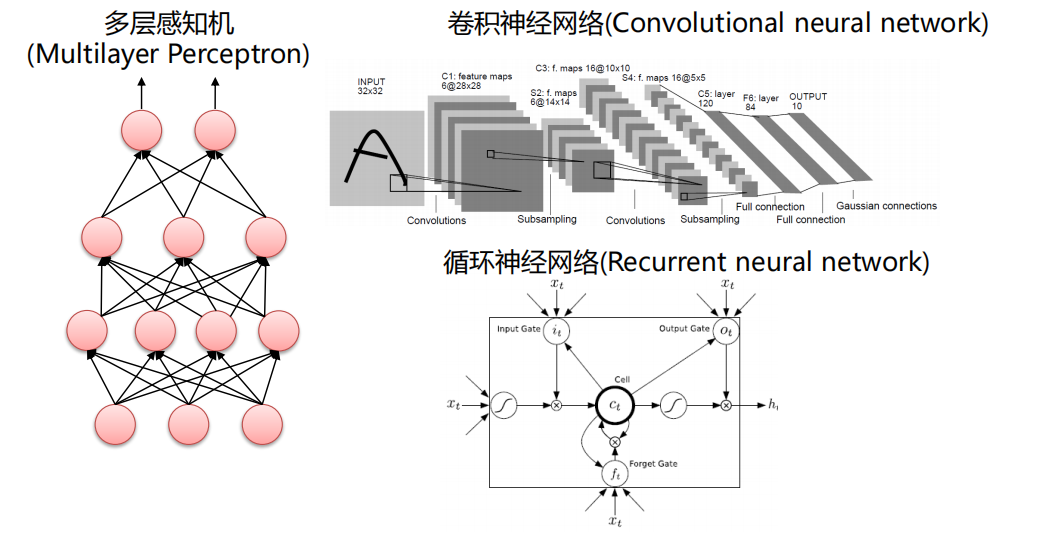

# 1. 神经网络可解释性技术概述

在人工智能领域,神经网络可解释性技术被广泛讨论,它主要是指对复杂神经网络模型的决策过程和结果进行解释和理解的能力。近年来,随着深度学习技术的迅猛发展和广泛应用,神经网络正变得越来越复杂,从而使得其工作原理对于使用者而言变得越来越不透明。这种现象引发了业界对模型的“黑盒”效应的担忧。因此,可解释性技术成为了一个热门话题,它不仅关系到模型的透明度和可信任度,也与安全、合规性以及技术创新紧密相关。本章将概览神经网络可解释性技术的重要性、挑战以及分类,为读者提供一个清晰的起点,以便更好地理解后续章节中的技术细节和实践应用。

# 2. 可解释性技术的理论基础

### 2.1 机器学习中的可解释性概念

在机器学习领域,可解释性指的是理解模型预测或决策的能力。可解释的模型能够提供透明度,让研究人员和终端用户明白模型是如何工作的,以及其预测依据是什么。

#### 2.1.1 可解释性的重要性

可解释性对于机器学习模型至关重要,主要体现在以下几个方面:

- **信任与合规性**:可解释的模型更容易被用户接受,尤其是在需要高度透明度的领域,如医疗和金融。

- **调试与改进**:能够理解模型的工作原理可以帮助开发者识别并修正错误,提高模型的准确度。

- **防止偏见与不公平**:通过分析模型的决策过程,可以识别并纠正潜在的偏见,确保模型的公平性。

#### 2.1.2 可解释性与模型性能的关系

尽管可解释性非常重要,但它并不总是与模型性能成正比。复杂的模型往往具有更高的预测准确性,但其黑盒特性使得可解释性降低。因此,设计时需要在性能与可解释性之间做出权衡。

### 2.2 神经网络可解释性的挑战

神经网络由于其深度和复杂性,被视为“黑盒”模型。如何在保持高性能的同时,提供足够的可解释性,是当前研究的热点和难点。

#### 2.2.1 复杂性与黑盒问题

神经网络的复杂性使得其决策过程难以解释。每个神经元的权重和激活值共同决定了最终输出,但这些内部机制对于人类来说难以理解。

#### 2.2.2 可解释性与模型准确性的权衡

为了提高模型的解释性,可能会牺牲一定的模型准确度。例如,使用决策树来替代神经网络,尽管决策树更易于理解,但其性能往往不如神经网络。

### 2.3 可解释性技术的分类

为了应对上述挑战,研究者们开发了多种可解释性技术,这些技术主要分为两类:模型特定的可解释性方法和模型无关的可解释性方法。

#### 2.3.1 模型特定的可解释性方法

模型特定的方法指的是专门为某种类型的模型设计的解释技术。例如,对于深度学习模型,可以使用权重可视化、神经元激活映射等技术来观察模型内部的运作。

#### 2.3.2 模型无关的可解释性方法

模型无关的方法适用于多种类型的机器学习模型。这些方法通常通过分析输入和输出之间的关系,构建可解释的代理模型来模拟原模型的行为,例如LIME(Local Interpretable Model-agnostic Explanations)和SHAP(SHapley Additive exPlanations)。

以上是第二章的概览,我们将逐步深入探讨每个子章节的具体内容。

# 3. 实现神经网络可解释性的实践技巧

## 3.1 模型可视化技术

神经网络模型内部的运作对于大多数人而言是黑盒的,但借助可视化技术,我们能一窥模型内部究竟发生了什么。这不仅可以帮助我们理解模型的决策过程,还能提高我们对模型性能的信心。

### 3.1.1 权重可视化

权重可视化是研究者最常使用的可视化技术之一。通过观察不同层之间的连接权重,我们可以推断出网络中哪些特征对于特定任务是重要的。例如,在图像识别任务中,权重可视化可以帮助我们发现网络是否真正地学会了识别边缘或角点等图像特征。

权重可视化通常涉及到对权重矩阵的某种形式的转置或者缩放操作,以便于将权重映射到可视化的图像上。下面是一个权重可视化的简单代码示例:

```python

import matplotlib.pyplot as plt

import numpy as np

# 假设我们有一个权重矩阵 w,其形状为 (num_features, height, width)

w = model.get_weights()[0] # 从某一个卷积层获取权重

# 重塑权重矩阵,并将其可视化

fig, axes = plt.subplots(1, w.shape[0], figsize=(10, 10))

for i, ax in enumerate(axes):

ax.imshow(w[i, :, :, 0], cmap='viridis') # 可视化第一个卷积核的权重

plt.show()

```

在上面的代码块中,`model.get_weights()` 是用来从模型中提取权重的方法,而 `plt.imshow` 是用来显示图像的函数。权重矩阵 `w` 中的每个二维切片代表一个过滤器的权重,这些权重决定了过滤器能检测出什么样的特征。

### 3.1.2 神经元激活映射

神经元激活映射是对输入数据在网络中传播时各层神经元激活情况的可视化。这种技术可以帮助我们理解哪些输入特征激活了特定的神经元,从而揭示模型是如何作出决策的。

为了获取神经元激活数据,我们通常会使用一个预训练的模型,并对单个样本进行前向传播。下面是一个简单的方法来获取一个卷积层的激活映射:

```python

from keras.models import Model

import numpy as np

# 加载预训练模型

model = load_model('path_to_model')

# 创建一个新的模型,输入与原模型相同,输出为某一层的激活情况

layer_outputs = [layer.output for layer in model.layers if 'conv' in layer.name] # 只选取卷积层

activation_model = Model(inputs=model.input, outputs=layer_outputs)

# 对图像进行预测以获取激活数据

activations = activation_model.predict(image_array)

# 打印第一个激活层的输出形状

print(activations[0].shape)

```

在上述代码块中,我们通过构建一个新的模型 `activation_model` 来获取原模型中卷积层的输出。`image_array` 是我们将要送入模型中的输入数据。通过这种方式,我们获得了神经元的激活映射,进而可以使用可视化技术进一步分析。

## 3.2 局部可解释模型

局部可解释模型(LIME)和SHAP值(SHapley Additive exPlanations)是两种流行的工具,用来解释单个预测或决策。它们通过提供模型的局部近似来解释个体预测,而不是试图解释整个模型。

### 3.2.1 LIME算法详解

LIME是一种流行的局部可解释模型方法,它通过扰动输入数据来理解单个预测。LIME的核心思想是在输入数据的局部区域内建立一个可解释的模型,比如线性回归模型,然后解释这个简单模型的预测结果。

为了使用LIME,我们首先需要确定哪些特征是重要的。LIME通过随机扰动数据样本,并观察这些扰动对模型预测结果的影响来进行。下面是如何使用LIME的一个例子:

```python

from lime.lime_tabular import LimeTabularExplainer

# 训练好的模型和一个数据样本

model = train_model() # 训练模型的函数

data = load_data() # 加载数据的函数

instance = data.iloc[0] # 选取一个实例

# 使用LIME解释器

explainer = LimeTabularExplainer(training_data=data, # 训练数据集

feature_names=data.columns, # 特征名称

class_names=['negative', 'positive'], # 类别名称

discretize_continuous=True)

# 对选定的实例进行解释

exp = explainer.explain_instance(instance, model.predict_proba, num_features=5, labels=[1])

# 输出可视化图表

exp.show_in_notebook(show_table=True, show_all=False)

```

在上面的代码块中,`LimeTabularExplainer` 负责创建LIME解释器,`explain_inst

0

0