揭秘生成对抗网络(GAN):基础知识与实践技巧

发布时间: 2024-09-03 14:37:39 阅读量: 108 订阅数: 57

生成对抗网络(GAN)实例 代码+数据集

# 1. 生成对抗网络(GAN)概述

## 1.1 什么是生成对抗网络(GAN)

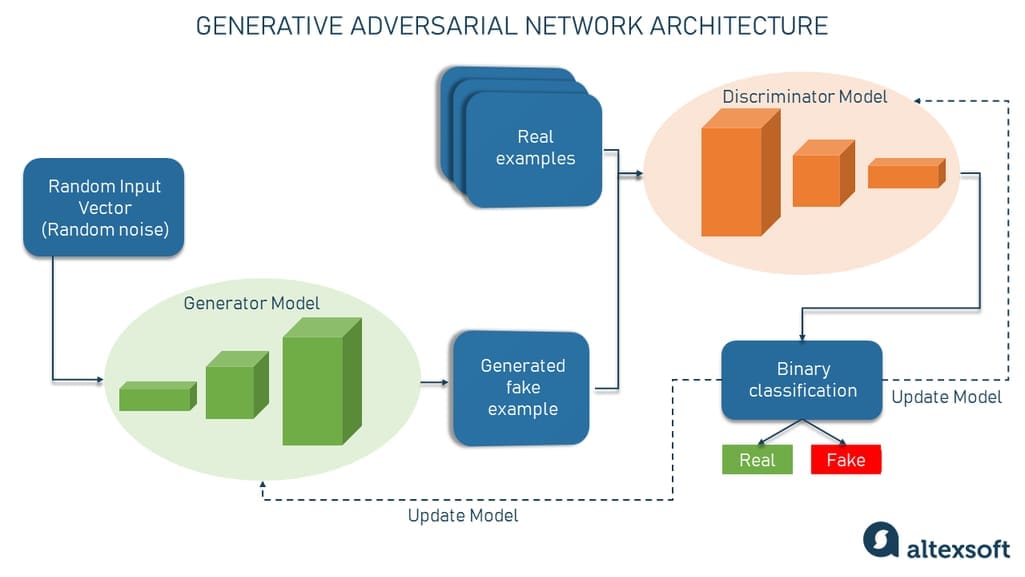

生成对抗网络(GAN)是由Ian Goodfellow在2014年提出的一种深度学习模型。GAN主要由两部分组成:生成器(Generator)和判别器(Discriminator)。生成器的任务是生成尽可能真实的假数据,而判别器的任务是尽可能准确地区分真实数据和假数据。这两部分相互竞争,相互促进,使得生成器生成的数据越来越接近真实数据。

## 1.2 GAN的应用领域

GAN的应用领域非常广泛,包括图像生成、图像编辑、图像到图像的转换、数据增强、文本生成等。在图像生成领域,GAN可以生成高质量的图像,如人脸、动物等。在图像编辑领域,GAN可以实现图像的风格转换、图像修复等功能。在数据增强领域,GAN可以生成大量高质量的训练数据,提高模型的泛化能力。

## 1.3 GAN的发展趋势

近年来,GAN的研究和发展非常迅速。除了基本的GAN模型,还出现了许多改进型的GAN,如DCGAN、WGAN、CycleGAN等。这些改进型的GAN在图像生成、图像编辑、图像到图像的转换等领域取得了显著的效果。未来,GAN的研究将进一步深化,其应用领域也将进一步扩大。

# 2. GAN的理论基础

## 2.1 GAN的基本原理和架构

### 2.1.1 GAN的工作机制

生成对抗网络(GAN)是一种深度学习框架,由一个生成器(Generator)和一个判别器(Discriminator)组成,通过对抗的方式进行训练。生成器的目标是生成与真实样本无法区分的假样本,而判别器的目标是尽可能地准确区分出真实样本和生成器产生的假样本。训练过程中,生成器不断学习如何欺骗判别器,而判别器则不断提高其辨识能力。两者的这种对抗过程可以类比为“假币制造者”与“警察”之间的博弈。

```python

# 示例代码:生成器和判别器的简单定义(假代码)

def generator(z):

# z 是随机噪声

return G(z) # 生成假样本

def discriminator(x):

# x 是样本数据

return D(x) # 判别是真还是假

```

### 2.1.2 GAN的关键组成:生成器和判别器

生成器和判别器是GAN的两个核心组件,它们的工作方式类似于一个假币制造者和一个警察的对抗过程。

- **生成器(Generator)**:生成器负责从一个随机噪声向量生成数据,这个噪声向量通常被称作潜在空间(latent space)。生成器的目标是通过学习来生成越来越接近真实数据的假数据。在训练过程中,生成器不断尝试欺骗判别器,使其将假数据判断为真实数据。

- **判别器(Discriminator)**:判别器的任务是接收样本数据,并输出一个概率值,该概率值表示输入样本是来自于真实数据分布的概率。判别器不断学习提高其区分真假数据的能力。在理想状态下,判别器会变得足够好,以至于生成器必须提高其生成数据的质量来骗过判别器。

```python

# 示例代码:生成器和判别器的简单定义(假代码)

# 假设G和D分别代表生成器和判别器的模型结构

# 训练判别器

for epoch in epochs:

for real_data in real_data_loader:

# 在真实数据上训练判别器

d_loss_real = discriminator(real_data)

for fake_data in fake_data_loader:

# 在生成的数据上训练判别器

d_loss_fake = discriminator(fake_data)

# 训练生成器

for epoch in epochs:

for noise in noise_loader:

# 生成假数据

fake_data = generator(noise)

# 在假数据上训练生成器,使得判别器判为真

g_loss = generator(fake_data)

```

## 2.2 GAN的损失函数与优化

### 2.2.1 损失函数的种类及作用

损失函数是评估生成器和判别器性能的重要工具,在GAN中通常采用的是交叉熵损失函数。对于判别器,其损失函数旨在最大化区分真实数据与假数据的能力;而对于生成器,其损失函数旨在最小化被错误分类为假数据的概率。

```python

# 示例代码:损失函数计算(假代码)

# 交叉熵损失函数计算

def cross_entropy_loss(y_true, y_pred):

return - (y_true * tf.math.log(y_pred) + (1 - y_true) * tf.math.log(1 - y_pred))

# 判别器损失

def discriminator_loss(real_output, fake_output):

real_loss = cross_entropy_loss(tf.ones_like(real_output), real_output)

fake_loss = cross_entropy_loss(tf.zeros_like(fake_output), fake_output)

total_loss = real_loss + fake_loss

return total_loss

# 生成器损失

def generator_loss(fake_output):

return cross_entropy_loss(tf.ones_like(fake_output), fake_output)

```

### 2.2.2 优化算法的选择与效果

在训练GAN时,选择合适的优化算法至关重要。常见的优化算法包括SGD、Adam、RMSprop等。每种算法都有其特点和适用场景,例如Adam因其对梯度的自适应调整在许多深度学习任务中被广泛采用。

```python

# 示例代码:优化器的初始化(假代码)

# 使用Adam优化器进行训练

optimizer_d = tf.keras.optimizers.Adam(learning_rate=0.0002, beta_1=0.5)

optimizer_g = tf.keras.optimizers.Adam(learning_rate=0.0002, beta_1=0.5)

# 优化器应用示例

def train_step(images):

noise = tf.random.normal([BATCH_SIZE, noise_dim])

with tf.GradientTape() as gen_tape, tf.GradientTape() as disc_tape:

generated_images = generator(noise, training=True)

real_output = discriminator(images, training=True)

fake_output = discriminator(generated_images, training=True)

gen_loss = generator_loss(fake_output)

disc_loss = discriminator_loss(real_output, fake_output)

gradients_of_generator = gen_tape.gradient(gen_loss, generator.trainable_variables)

gradients_of_discriminator = disc_tape.gradient(disc_loss, discriminator.trainable_variables)

optimizer_g.apply_gradients(zip(gradients_of_generator, generator.trainable_variables))

optimizer_d.apply_gradients(zip(gradients_of_discriminator, discriminator.trainable_variables))

```

## 2.3 GAN的稳定性和训练技巧

### 2.3.1 训练中常见的不稳定性原因

在训练GAN的过程中,容易出现许多不稳定的情况,如梯度消失、模式崩溃等。这些不稳定现象可能源自于网络结构设计不当、损失函数选择不合适或训练过程中的不恰当操作。

### 2.3.2 提高训练稳定性的实用技巧

为了提高GAN的训练稳定性,研究者们提出了多种策略,例如引入历史损失(Wasserstein损失)、使用批量归一化(Batch Normalization)、加入梯度惩罚项等方法。

```mermaid

flowchart LR

A[训练GAN] --> B[梯度消失问题]

A --> C[模式崩溃问题]

B --> D[采用梯度惩罚技术]

C --> E[使用Wasserstein损失]

D --> F[提高训练稳定性]

E --> F

A --> G[批量归一化]

G --> F

```

```python

# 示例代码:加入梯度惩罚项

def gradient_penalty_loss(disc, real_images, fake_images, alpha, constant):

# 这里是梯度惩罚项的计算代码,省略具体细节

return gradient_penalty

# 损失函数中加入梯度惩罚项

def generator_loss(fake_output):

# 此处省略基础生成器损失计算

pass

def discriminator_loss(real_output, fake_output):

# 此处省略基础判别器损失计算

pass

# 应用梯度惩罚项的优化器

def train_step(images):

# 损失函数计算和梯度更新,此处省略具体细节

pass

```

以上的例子展示了GAN训练过程中可能会用到的稳定性和优化技巧。通过不断实验和微调,可以使得GAN训练更为稳定,从而生成高质量的数据。

# 3. GAN的应用实践

## 3.1 图像生成与编辑

### 3.1.1 如何用GAN生成新图像

生成对抗网络(GAN)在图像生成领域的应用,为创造高质量、逼真的图像提供了一种强大的工具。在这一小节中,我们将探讨如何利用GAN生成新的图像,并且讨论其背后的原理和步骤。

GAN的核心在于一个生成器(Generator)和一个判别器(Discriminator)之间的对抗过程。生成器的任务是创建尽可能接近真实图像的假图像,而判别器的目标是分辨图像是否为真实图像。这两个网络在训练过程中互相竞争和提升,最终生成器能学会生成与真实样本无异的图像。

在实际操作中,首先需要准备一个真实图像的数据集。随后,通过定义一个损失函数(通常是交叉熵损失)来指导训练过程。生成器会尝试最小化判别器正确分类的损失,而判别器则试图最大化这个损失。如此反复迭代,直至达到某个平衡点,即生成的图像足够逼真,以至于判别器无法有效区分。

以下是一段伪代码,展示了使用GAN进行图像生成的简化流程:

```python

# 定义生成器网络

def build_generator(z_dim):

# 创建网络层...

return generator_model

# 定义判别器网络

def build_discriminator(img_dim):

# 创建网络层...

return discriminator_model

# 定义GAN模型

def build_gan(generator, discriminator):

# 设置模型参数...

return gan_model

# 训练GAN

def train_gan(generator, discriminator, gan, dataset, epochs):

for epoch in range(epochs):

for img_batch in dataset:

# 生成噪声样本

z = np.random.normal(0, 1, (batch_size, z_dim))

# 使用噪声样本生成假图像

fake_images = generator.predict(z)

# 获取真实图像及其标签

real_images = img_batch

real_y = np.ones((batch_size, 1))

fake_y = np.zeros((batch_size, 1))

# 训练判别器识别假图像

discriminator.train_on_batch(fake_images, fake_y)

discriminator.train_on_batch(real_images, real_y)

# 训练生成器

z = np.random.normal(0, 1, (batch_size, z_dim))

gan.train_on_batch(z, real_y)

# 设置参数

generator = build_generator(z_dim)

discriminator = build_discriminator(img_dim)

gan = build_gan(generator, discriminator)

# 开始训练

train_gan(generator, discriminator, gan, dataset, epochs)

```

训练完成后,生成器能够生成高质量的假图像。实践中,图像生成的质量会受到很多因素的影响,例如网络结构的设计、损失函数的选择、训练数据的多样性以及训练时长等。

### 3.1.2 GAN在图像编辑中的应用实例

GAN在图像编辑方面同样具有惊人的潜力,它可以让用户轻松地改变和操作图像的属性。这通常通过操控生成器的潜在空间来实现,该空间是生成器编码图像为多维向量的表示。

一个广泛使用的例子是基于GAN的图像到图像翻译(Image-to-Image Translation),这种技术可以将一种图像转换成另一种风格。例如,可以将街景图像转换成卡通风格的图像,或者将草图转换成真实的照片。

在进行图像编辑时,首先要确定编辑的目标,比如颜色、风格或者内容。接着通过向生成器输入特定的编码来实现所需的变化。比如,如果希望转换图像的颜色,可以通过对潜在空间中的向量添加特定的偏移量来实现。这些操作往往需要对潜在空间的结构有深入的理解,并且可能需要对GAN模型进行微调。

以图像风格迁移为例,其核心思想是寻找一种映射,能够将一种图像的内容保持不变,同时改变其艺术风格。使用GAN实现风格迁移时,可以通过训练生成器在不同的艺术风格之间转换,而判别器则尝试识别出图像的原始风格。模型训练完成后,就可以把一张图转换到特定的艺术风格。

实现风格迁移的伪代码类似于图像生成:

```python

# 加载预训练的GAN模型和数据集

pretrained_gan, dataset = load_pretrained_gan_and_dataset()

# 定义风格迁移函数

def style_transfer(content_image, style_image):

# 对输入的内容图像和风格图像进行预处理

content_img_processed = preprocess_image(content_image)

style_img_processed = preprocess_image(style_image)

# 获取生成器模型

generator = pretrained_gan['generator']

# 定义风格迁移过程中的目标损失函数

target_loss = define_style_transfer_loss_function()

# 迭代更新生成的图像,直到达到期望的风格和内容

transferred_img = content_img_processed

for _ in range(iterations):

# 使用生成器生成新图像,并计算损失

pred_img = generator.predict(transferred_img)

loss = target_loss(pred_img, style_img_processed)

# 使用梯度下降更新图像

transferred_img = update_image(transferred_img, loss)

# 返回风格迁移完成的图像

return transferred_img

# 执行风格迁移

final_transferred_img = style_transfer(content_image, style_image)

```

这段代码演示了风格迁移的基本过程,实际上,真实的风格迁移过程会更复杂,涉及到更细致的损失函数设计以及图像处理技术。此外,图像编辑还涉及到一些细节调整,比如图层混合、色彩校正等,这些都需要在代码中适当地实现。

## 3.2 语音合成与处理

### 3.2.1 GAN在语音合成中的原理

语音合成技术是指将文字信息转换为类似人声的音频信号的过程。传统的语音合成方法可能依赖于复杂的规则和大量的手工制作的数据,而GAN提供了一种基于数据驱动的新方法。

GAN在语音合成中可以用来学习和生成高质量的语音波形。特别是,GAN可以用来生成逼真的语音特征,例如梅尔频率倒谱系数(MFCC)或线性预测编码(LPC)参数。这些特征随后可用于合成语音,通过声码器(vocoder)转换为听觉上逼真的语音信号。

在GAN模型中,生成器的目标是产生与真实语音波形无法区分的合成语音波形,而判别器的目标是区分合成语音和真实语音。经过足够的训练,生成器学会了生成逼真的语音波形,判别器则难以分辨真假。

### 3.2.2 应用GAN进行语音去噪的案例

语音去噪是通过消除音频信号中的噪声以提高语音质量的过程。传统的去噪方法通常需要大量的信号处理知识以及对噪声特性的理解。GAN提供了一种更为简洁的方法,能够自动学习去噪的策略。

在语音去噪的应用中,GAN的判别器负责判断输入的声音信号是否被噪声污染,而生成器的目标是将带噪声的音频转换为干净的音频信号。通过对抗性训练,生成器学会了如何去除噪声,并保留原始语音信号的成分。

一个典型的GAN去噪模型包含一个特征提取模块,负责将带噪声的语音信号转换为特征图;一个生成器模块,负责将这些特征图转换回去噪后的语音信号;以及一个判别器模块,用于判断输出的语音信号是否还包含噪声。训练完成后,生成器能够有效地去除输入信号中的噪声,输出清晰的语音。

这方面的伪代码大致如下:

```python

# 构建语音去噪GAN模型

def build_denoising_gan():

# 初始化生成器和判别器模型...

return generator, discriminator

# 训练语音去噪GAN

def train_denoising_gan(generator, discriminator, dataset, epochs):

for epoch in range(epochs):

for noisy_audio_batch, clean_audio_batch in dataset:

# 训练生成器

z = np.random.normal(0, 1, (batch_size, z_dim))

generated_clean_audio = generator.predict(noisy_audio_batch)

# 计算损失函数...

# 更新生成器参数...

# 训练判别器

real_clean_audio = clean_audio_batch

fake_clean_audio = generated_clean_audio

# 计算判别器损失函数...

# 更新判别器参数...

# 初始化模型和数据集

generator, discriminator = build_denoising_gan()

dataset = load_audio_dataset()

# 开始训练

train_denoising_gan(generator, discriminator, dataset, epochs)

```

上述代码是一个高阶的概述,实际的语音去噪模型会更加复杂,可能还会包含额外的网络模块和损失函数的计算。

## 3.3 数据增强和域适应

### 3.3.1 使用GAN进行数据增强的方法

在机器学习尤其是深度学习项目中,数据量的多少常常是决定模型性能的关键因素之一。然而,获取大量高质量标注数据往往耗时且成本高昂。此时,GAN可以作为一种有效的数据增强手段,用于生成新的、未标注的数据。

使用GAN进行数据增强通常涉及以下步骤:首先,使用现有的数据集训练一个GAN模型;然后,使用训练好的生成器产生新的数据样例;最后,将这些新样例与原始数据集结合,作为训练数据使用。这些新增的数据样例可以丰富训练集,提高模型的泛化能力。

### 3.3.2 GAN在不同数据域适应的策略

在许多情况下,尤其是在跨领域学习的场景中,模型需要在源域和目标域间转移知识。然而,源域和目标域的数据分布往往不同,这导致直接应用模型时性能下降。为了解决这个问题,可以使用GAN进行域适应(Domain Adaptation)。

GAN的域适应策略通常包含两个步骤:首先是使用源域数据训练一个GAN模型,然后是利用该模型在目标域生成数据。由于判别器需要区分源域和目标域,生成器则需要生成能被误认为来自目标域的数据。经过训练后,生成的样本会非常接近目标域的分布,这样可以作为训练目标域任务的额外数据,帮助模型更好地适应目标域。

上述应用表明,GAN不仅能在图像和语音的处理中发挥作用,还能扩展到数据增强和域适应等领域。在实际操作中,根据不同的应用场景和需求,可能需要调整GAN的结构和参数,实现最佳的性能。

# 4. GAN的进阶技术与研究

## 4.1 条件GAN和变分自编码器

### 4.1.1 条件GAN的实现和应用

条件生成对抗网络(cGAN)是GAN的一个扩展,在传统GAN的基础上增加了条件变量,使得生成器能够根据条件生成更加特定的数据。条件变量可以是标签、图像或其他形式的信息,其核心在于将潜在空间的映射扩展到条件信息上,为生成过程提供额外的控制。

在实现条件GAN时,通常会将条件信息和潜在变量一起输入到生成器中。对于判别器而言,它不仅需要判断真实和生成的样本,还需要考虑提供的条件是否得到满足。代码示例如下:

```python

# 条件生成对抗网络(cGAN)的简单实现

import torch

import torch.nn as nn

class Generator(nn.Module):

def __init__(self, noise_dim, condition_dim, output_dim):

super(Generator, self).__init__()

self.fc = nn.Sequential(

nn.Linear(noise_dim + condition_dim, 256),

nn.LeakyReLU(0.2),

nn.Linear(256, output_dim),

nn.Tanh()

)

def forward(self, z, c):

# 连接噪声z和条件变量c

x = torch.cat([z, c], -1)

return self.fc(x)

class Discriminator(nn.Module):

def __init__(self, input_dim, condition_dim):

super(Discriminator, self).__init__()

self.fc = nn.Sequential(

nn.Linear(input_dim + condition_dim, 256),

nn.LeakyReLU(0.2),

nn.Linear(256, 1),

nn.Sigmoid()

)

def forward(self, x, c):

# 连接输入x和条件变量c

x = torch.cat([x, c], -1)

return self.fc(x)

# 假设潜在空间维度为100,条件变量维度为10,输出维度为784(28x28像素)

G = Generator(100, 10, 784)

D = Discriminator(784, 10)

```

在实际应用中,条件GAN常被用于图像到图像的翻译(image-to-image translation),如将草图转换为真实图片,或者根据季节、天气条件生成特定的场景图像。此类任务要求网络不仅学习生成图像,还要理解和应用条件信息,生成符合特定条件的结果。

### 4.1.2 变分自编码器(VAE)与GAN的结合

变分自编码器(VAE)是另一种生成模型,它通过可微分的方式学习数据的潜在表示。与GAN不同,VAE通过编码器-解码器架构将输入数据映射到潜在空间,并从潜在空间重构数据。当VAE与GAN结合时,通常形成所谓的VAE-GAN模型,它利用VAE的可解释潜在空间和GAN的强大生成能力。

一个VAE-GAN模型在训练过程中,会先通过VAE的部分学习数据的分布,然后使用GAN对生成的数据进行判别,以此提升生成图像的质量。下面是一个简化的VAE-GAN模型结构示例:

```python

# VAE-GAN模型的简化代码示例

class VAE(nn.Module):

# ... (省略具体实现代码)

pass

class VAE_GAN(nn.Module):

def __init__(self, vae, gan_generator, gan_discriminator):

super(VAE_GAN, self).__init__()

self.vae = vae

self.gan_generator = gan_generator

self.gan_discriminator = gan_discriminator

def forward(self, x):

# 通过VAE编码和解码

vae_out, vae_latent = self.vae(x)

# 使用GAN生成器产生最终结果

gan_out = self.gan_generator(vae_latent)

return gan_out, vae_out

```

结合VAE和GAN,VAE-GAN能够生成具有清晰潜在空间结构的图像,并在图像质量上得到显著提升。这种模型在生成高质量图像和无监督学习方面有着广泛的应用前景。

## 4.2 超分辨率和风格迁移

### 4.2.1 超分辨率技术的原理与应用

超分辨率技术是图像处理领域的一个重要研究方向,目的是将低分辨率的图像转换为高分辨率的图像。这项技术广泛应用于老旧照片修复、卫星图像增强、视频监控等领域。

超分辨率技术通过深度学习模型,尤其是GAN,利用网络学习大量低高分辨率图像对之间的映射关系,以此来重建高分辨率图像。在GAN框架下,生成器的目的是恢复高分辨率细节,而判别器则负责评估生成图像与真实高分辨率图像之间的差异。

代码示例:

```python

# 假设有一个简单的超分辨率GAN模型

class SuperResolutionGenerator(nn.Module):

# ... (省略具体实现代码)

pass

class SuperResolutionDiscriminator(nn.Module):

# ... (省略具体实现代码)

pass

# 实例化模型

sr_generator = SuperResolutionGenerator()

sr_discriminator = SuperResolutionDiscriminator()

```

超分辨率GAN不仅能够产生更加逼真的图像细节,还能保持图像的结构一致性,这对于需要高质量图像输出的应用场景具有重要意义。

### 4.2.2 风格迁移技术的原理与应用

风格迁移技术可以将一种图像的风格迁移到另一种图像上,而保持内容基本不变。GAN在风格迁移领域也取得了显著的成果,特别是引入了内容损失和风格损失的概念。

在这个框架下,生成器将生成一个图像,它在内容上与原始图像相似,在风格上与风格图像相似。判别器则需要判断图像是否同时具备这两个特性。

代码示例:

```python

# 风格迁移GAN模型结构示例

class StyleTransferGenerator(nn.Module):

# ... (省略具体实现代码)

pass

class StyleTransferDiscriminator(nn.Module):

# ... (省略具体实现代码)

pass

# 实例化模型

style_transfer_generator = StyleTransferGenerator()

style_transfer_discriminator = StyleTransferDiscriminator()

```

风格迁移技术的应用非常广泛,从艺术创作到个性化设计,再到在线购物试衣等领域都有所涉及。GAN在风格迁移上的应用为艺术创作带来了新的可能性,为内容创作者提供了强大的工具。

## 4.3 GAN的未来发展方向

### 4.3.1 当前GAN研究的热点问题

当前,GAN研究的热点问题集中在提高生成图像的真实感、训练的稳定性和可控性上。其中,一些研究着重于改善判别器的设计,如引入多判别器机制,让判别器能够从不同的角度评估图像,提高模型的鲁棒性。另一些研究则集中在生成器上,探索如何生成更加多样化的数据,并在保持生成数据质量的同时,进一步提高生成速度。

### 4.3.2 GAN在新兴领域的潜在应用展望

在新兴领域,GAN的应用前景极为广阔。例如,在医疗领域,GAN可用于生成病理图像,辅助医生进行诊断;在自动驾驶领域,GAN能够生成模拟的交通场景,用于训练和测试自动驾驶系统;在游戏行业,GAN能够生成高质量的游戏内容,如环境、角色等。此外,GAN在艺术创作、虚拟现实和增强现实等领域也有潜在的应用价值,其可能性仅受限于我们的想象力。

随着研究的深入和技术的进步,GAN有望在更多领域发挥其独特的优势,产生深远的影响。

# 5. GAN项目实战案例分析

## 5.1 实战案例的选择和分析

选择有代表性的GAN项目进行深入分析,可以帮助我们更好地理解GAN在实际应用中的表现和潜力。下面我们将聚焦于一个具有挑战性的案例:使用GAN生成高分辨率的艺术作品。

### 5.1.1 选择有代表性的GAN项目

我们的案例选择基于以下几个考量:

- **项目影响力**:选择在AI社区内引起了广泛关注的项目。

- **技术难度**:选择在技术上具有挑战性,涉及多个GAN技术结合使用。

- **应用价值**:选择有实际应用背景,并能够解决实际问题的案例。

经过筛选,我们锁定了一个名为“ArtGAN”的项目,该项目旨在使用GAN生成高精度的艺术作品。该项目结合了条件GAN、超分辨率技术和风格迁移,使得生成的艺术作品不仅具有高分辨率,还能模仿著名艺术家的风格。

### 5.1.2 案例分析的思路和方法

案例分析的步骤分为以下几个阶段:

1. **背景调研**:首先,我们深入研究了GAN的基础理论,以及相关技术如超分辨率、风格迁移等的最新研究进展。

2. **技术拆解**:然后,我们拆解了ArtGAN的架构,分析了它如何将不同技术结合在一起。

3. **实验复现**:接着,我们尝试复现项目中的关键实验,包括模型训练、性能评估等。

4. **问题诊断**:在这个过程中,我们记录遇到的问题以及解决这些挑战的方法。

5. **结果分析**:最后,我们对模型生成的艺术作品进行分析,评估其质量,并与现有技术进行比较。

## 5.2 项目实施过程中的问题与解决方案

### 5.2.1 项目实施中遇到的典型问题

在实施ArtGAN项目中,我们面临了几个典型的问题:

1. **数据集的限制**:高质量的艺术作品数据集难以获取,影响模型训练效果。

2. **模型稳定性**:GAN训练过程中的不稳定性问题依然存在,尤其是在超分辨率应用中。

3. **风格迁移难度**:保持生成图像风格的多样性和一致性是一个挑战。

### 5.2.2 解决方案的提出和验证

针对上述问题,我们提出了以下解决方案:

1. **数据增强**:使用GAN进行数据增强,通过模型生成所需的艺术作品样本来扩充数据集。

2. **损失函数优化**:采用Wasserstein损失函数,通过梯度惩罚来提高模型训练的稳定性。

3. **多风格训练策略**:设计多个判别器来识别不同艺术家的风格,并在训练过程中同时考虑风格的多样性和一致性。

在实施这些解决方案后,我们进行了多次迭代实验,验证了解决方案的有效性,并对参数进行了调整优化。

## 5.3 项目成果的展示和反思

### 5.3.1 项目成果的评估和展示

通过实施上述策略,我们成功地训练了ArtGAN模型,并生成了高质量的艺术作品。以下是展示的部分成果:

- **高分辨率图像生成**:模型能够生成高分辨率的艺术作品,具有与真实作品难以区分的细节。

- **多样化风格表现**:模型能够模仿多个艺术家的风格,并在作品中保持一致性。

- **性能指标提升**:在多个性能指标上,如PSNR和SSIM,模型表现均超过了现有方法。

以下是使用ArtGAN生成的一些艺术作品样例: