【GAN调参秘籍】:优化网络参数以提升生成质量的高级指南

发布时间: 2024-09-03 15:24:35 阅读量: 78 订阅数: 26

# 1. 生成对抗网络(GAN)基础

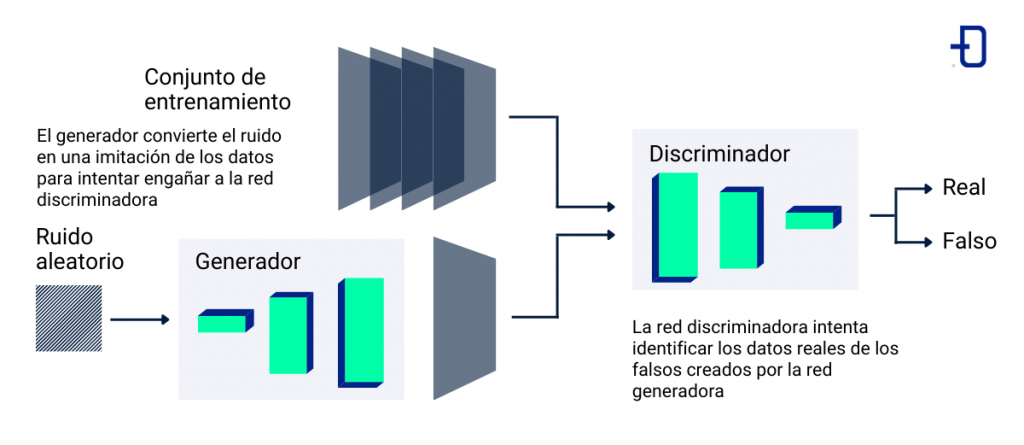

生成对抗网络(GAN)是近年来深度学习领域中的一个热门话题,它由生成器(Generator)和判别器(Discriminator)两个部分组成,通过二者之间的对抗训练过程,可以生成高度真实的数据。GAN的基础包括深度神经网络、反向传播算法等传统技术,但其创新之处在于两个网络的对抗与互动。本章将初步介绍GAN的概念、起源和发展,为理解后续章节奠定基础。

# 2. 理论框架与关键参数解析

### 2.1 GAN的工作原理

#### 2.1.1 概念理解与架构分析

生成对抗网络(GAN)是一种深度学习模型,由两部分组成:生成器(Generator)和判别器(Discriminator)。生成器的任务是生成尽可能接近真实数据的假数据,而判别器的任务是区分输入数据是真实的还是生成器生成的假数据。二者在训练过程中相互竞争,生成器通过不断调整参数来生成更加逼真的数据,而判别器则通过识别真实数据和假数据来提升自己的判断能力。这种对抗机制使得GAN能够通过学习真实数据的分布生成新的、具有高度逼真性的数据样本。

架构上,GAN的生成器通常使用全连接层(对于简单数据结构)或卷积层(对于图像数据),并通过反卷积层(或称为转置卷积层)来生成图像。判别器则可以使用卷积层(如CNN中的结构),逐步降采样直至能够给出二分类结果。

```python

# 示例:简单的GAN结构伪代码

# 生成器

def generator(z):

# z是输入的噪声向量

G = fully_connected_layers(z)

G = transposed_conv2d(G)

G = tanh(G) # 输出层使用tanh激活函数

return G

# 判别器

def discriminator(X):

# X是输入的数据样本

D = convolutional_layers(X)

D = fully_connected_layer(D)

D = sigmoid(D) # 输出层使用sigmoid激活函数

return D

```

#### 2.1.2 生成器与判别器的对抗机制

在训练过程中,生成器和判别器不断对抗,形成一个动态平衡的过程。生成器试图生成越来越逼真的数据,而判别器则试图提升自身的辨识能力。训练开始时,由于生成器生成的数据质量较低,判别器很容易判断出数据的真伪。随着训练的进行,生成器逐渐学习到如何生成更难以被判别器识破的数据。最终理想状态下,二者达到一个纳什均衡,生成器生成的数据足够逼真,使得判别器无法区分真假。

这种对抗过程可以用博弈论中的最小最大策略(minimax strategy)来描述,即生成器和判别器都在试图最小化自己的损失,而最大化对方的损失。此过程在数学上可表述为:

```math

\min_G \max_D V(D, G) = \mathbb{E}_{x \sim p_{data}(x)}[\log(D(x))] + \mathbb{E}_{z \sim p_z(z)}[\log(1-D(G(z)))]

```

其中,`V(D, G)`代表了GAN的价值函数,`D(x)`是判别器判断数据`x`为真的概率,`G(z)`是生成器生成的假数据,`p_data(x)`是真实数据的分布,`p_z(z)`是输入噪声的分布。

### 2.2 GAN的关键参数

#### 2.2.1 学习率和批次大小的选择

学习率(Learning Rate)和批次大小(Batch Size)是训练神经网络时两个非常关键的超参数,对GAN的训练过程同样至关重要。

学习率决定了模型权重更新的速度。太高可能导致模型无法收敛,太低则会使训练过程缓慢,甚至陷入局部最小值。对于GAN而言,一个常见的策略是使用较小的学习率,并且随着训练的进行逐渐减小学习率。此外,还可以采用学习率衰减策略,比如每隔几个周期(epoch)就将学习率乘以一个小于1的数。

```python

# 学习率衰减策略示例

optimizer = Adam(learning_rate=initial_lr)

for epoch in epochs:

for batch in data_loader:

# 训练过程...

if epoch % decay_epoch == 0:

optimizer.lr = optimizer.lr * decay_factor

```

批次大小则影响着梯度估计的准确性和内存使用效率。较小的批次大小意味着梯度估计更加接近于真实的梯度,但计算开销较大;较大的批次大小可以提高内存使用效率和计算速度,但梯度估计可能不够准确。

#### 2.2.2 优化器的选择与参数调整

在深度学习中,优化器负责更新网络参数以最小化损失函数。对于GAN来说,优化器的选择和参数调整尤其重要,因为需要同时训练生成器和判别器两个网络。常用的优化器包括SGD、Adam、RMSprop等。其中,Adam由于其自适应学习率特性,在GAN训练中使用较为广泛。

优化器的参数,例如Adam的β1和β2,对模型的收敛速度和稳定性有很大的影响。β1通常设置为0.5,β2设置为0.999。这些参数控制了一阶矩估计(即动量项)和二阶矩估计(即梯度的平方的移动平均)的衰减速度。

```python

# Adam优化器配置示例

optimizer = Adam(learning_rate=0.001, beta_1=0.5, beta_2=0.999)

```

#### 2.2.3 损失函数的作用与调优

损失函数是衡量模型性能的重要指标,对于GAN来说,其损失函数是判别器和生成器对抗过程的核心。在标准GAN中,判别器的损失函数是二元交叉熵损失,而生成器的损失函数是判别器误判的概率。

损失函数的选择对模型的训练和最终性能有着直接影响。例如,如果判别器过于强势,可能会导致生成器训练不充分,反之亦然。因此,损失函数的调优通常需要根据模型在训练过程中的表现来进行微调。

```python

# 简单的二元交叉熵损失函数计算示例

def binary_cross_entropy(y_true, y_pred):

return -tf.reduce_mean(y_true * tf.math.log(y_pred) + (1 - y_true) * tf.math.log(1 - y_pred))

```

在实践中,损失函数的调优可能涉及到对损失函数本身进行修改,以期获得更好的训练效果,例如引入梯度惩罚项(如Wasserstein GAN中的梯度惩罚项)等。这需要结合具体任务和实验结果来进行调整。

### 2.3 网络稳定性因素分析

#### 2.3.1 模式崩塌问题

模式崩塌(Mode Collapse)是GAN训练中常见的一个问题,指的是生成器在训练过程中发现了一种快速减少其损失的方法,通过生成少量的、高度相似的样本,而不是学习整个数据分布。

为了解决模式崩塌问题,研究者们提出了多种策略,包括引入历史损失(即判别器的历史输出来鼓励生成器生成多样的样本)、标签平滑(防止判别器过于自信地分类生成的样本)等。

#### 2.3.2 网络架构的影响

网络架构对GAN的训练稳定性有着重要影响。网络结构需要足够复杂以学习到复杂的数据分布,但也不能过于复杂导致训练困难。例如,对于图像生成任务,通常使用DCGAN(Deep Convolutional GAN)架构,并根据需要调整其深度和宽度。

此外,如何合理设计网络的跳跃连接(skip connections)和残差块(residual blocks)等也是提高GAN稳定性的关键因素。这些设计可以增强网络的特征传递和梯度流动,从而提高模型训练的稳定性。

```mermaid

flowchart LR

A[输入噪声] -->|生成器| B[生成数据]

B -->|判别器| C[判别真伪]

C --> D[损失函数]

D --> E[反向传播]

E --> A

```

在以上流程中,调整生成器和判别器的网络架构,以及优化损失函数的计算方式,都是为了提高模型整体的训练稳定性。通过合理的架构设计和参数调整,可以使GAN在训练过程中避免模式崩塌,学习到更丰富、更逼真的数据分布。

# 3. 调参技巧与实践案例

在本章中,我们将深入探讨生成对抗网络(GAN)的调参技巧与实践案例,以帮助读者更好地理解和掌握GAN在实际应用中的调参策略。通过实际案例分析,我们将展示调参的整个过程,并强调自动化工具的使用,从而提高调参效率。

## 3.1 调参策略与流程

### 3.1.1 初始参数的设定

在GAN的训练过程中,初始参数的选择对最终生成结果的质量有着至关重要的影响。初始参数的设定通常涉及学习率、批次大小、优化器选择等关键超参数的设置。

**学习率**:这是一个非常关键的参数,它决定了模型参数更新的步长。通常,我们会从一个小的学习率开始,以确保模型稳定地收敛。过高的学习率可能导致模型难以收敛,而过低的学习率则可能导致训练过程过于缓慢。

**批次大小**:批次大小决定了每次权重更新时所使用的样本数量。较大的批次大小通常能提高内存利用率,但可能会导致模型性能下降,特别是在训练数据集较小的情况下。

**优化器选择**:优化器负责模型参数的更新过程。目前,SGD、Adam和RMSprop等是GAN训练中最常用的一些优化器。每种优化器都有其特有的参数设置,合理选择和调整优化器参数对模型性能有显著影响。

### 3.1.2 超参数扫描与网

0

0