【HDFS HA的故障恢复与备份策略】:掌握关键措施保障数据安全

发布时间: 2024-10-29 03:19:01 阅读量: 47 订阅数: 47

IncompatibleClassChangeError(解决方案).md

# 1. HDFS高可用性概述

Hadoop分布式文件系统(HDFS)作为一个存储大数据的平台,其高可用性(HA)是至关重要的。高可用性不仅保证了数据的持久性,还保障了在系统组件出现故障时能够无缝地继续提供服务。HDFS HA的基本目标是在发生硬件故障、软件缺陷或网络问题时,能维持数据服务的连续性和完整性。

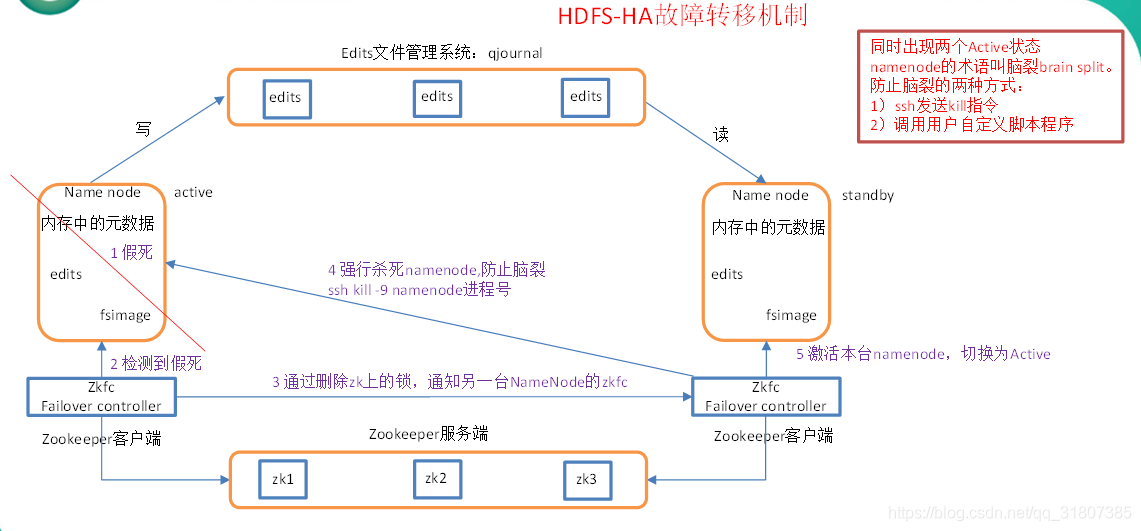

HDFS HA架构通过减少单点故障的机会来实现。系统的关键组件,如NameNode,采用主备模式运行,实现故障自动转移,从而避免了因单个节点故障导致整个系统不可用的风险。此外,HDFS提供了故障恢复机制,包括故障检测、自动切换以及数据备份和恢复策略,这些都是实现高可用性不可或缺的部分。

在接下来的章节中,我们将深入探讨故障恢复机制、监控和备份策略等重要话题,以帮助读者充分理解和掌握HDFS高可用性的关键组成。我们会结合理论和实践,介绍故障处理的策略,以及如何优化HDFS HA以适应不断变化的数据存储需求。

# 2. 故障恢复机制的理论与实践

## 2.1 HDFS故障恢复基础

### 2.1.1 HDFS的故障类型

在Hadoop分布式文件系统(HDFS)中,故障可以被分类为两大类:硬件故障和软件故障。硬件故障通常包括节点硬件失效、网络设备故障、电源问题等,这些硬件问题可能会导致系统中一个或多个节点暂时或永久性地无法访问。另一方面,软件故障可能涉及HDFS守护进程的异常退出、程序bug、配置错误、操作失误等。

### 2.1.2 故障自动检测和响应流程

HDFS设计有内建的故障自动检测机制,主要依赖于心跳信号(heartbeats)和超时机制来监测各个DataNode的状态。NameNode会定期从DataNode接收心跳信号,以确认其活跃性。如果某个DataNode停止发送心跳,NameNode会将其视为宕机,并启动相应的恢复流程。整个故障检测和响应流程如下:

1. **心跳检测**:DataNode定期向NameNode发送心跳信号,表明自己正在正常工作。

2. **超时处理**:如果NameNode在预定的时间内未能收到某个DataNode的心跳,则标记该节点为失效。

3. **副本复制**:NameNode随后会安排从其他健康DataNode上复制丢失的数据块,以保持数据的冗余性。

4. **状态更新**:一旦故障节点恢复,它会尝试与NameNode重新建立连接并重新注册,NameNode会根据需要更新其状态和任务分配。

## 2.2 集群健康检查与监控

### 2.2.1 常用监控工具介绍

为了确保HDFS集群的稳定性,运维团队通常会使用一系列监控工具来跟踪集群的健康状况。这些工具包括:

- **Nagios**:一个用于监控IT基础设施的开源系统和应用监控工具。

- **Ganglia**:一个高性能、可扩展的分布式系统监控工具,适用于大规模集群。

- **Ambari**:Hortonworks提供的一个开源工具,用于配置、管理和监控Hadoop集群。

### 2.2.2 实时监控策略实施

实施实时监控的关键步骤包括:

1. **安装监控工具**:在集群中安装并配置所选的监控工具。

2. **定义监控指标**:确定需要监控的关键性能指标,如CPU使用率、内存消耗、磁盘空间、网络流量等。

3. **设置阈值和警报**:根据系统运行情况,设置合理的阈值,并在达到这些阈值时发送警报。

4. **监控数据可视化**:使用仪表板将监控数据可视化,帮助运维团队快速了解集群状态。

5. **定期审计和调整**:定期检查监控系统的有效性,并根据系统的演进和需求变化进行调整。

## 2.3 故障恢复操作的详细步骤

### 2.3.1 节点故障的恢复流程

当检测到DataNode故障时,HDFS会采取以下步骤进行恢复:

1. **故障检测**:NameNode检测到DataNode故障后,会从集群中移除该节点。

2. **数据复制**:为了恢复数据冗余,NameNode会从其他DataNode上复制缺失的数据块。

3. **任务重分配**:对那些正在向故障DataNode写入数据的任务进行重分配,确保数据写入过程不会中断。

4. **故障节点恢复**:当故障DataNode恢复后,它会尝试重新注册到NameNode,并根据需要重新同步数据。

### 2.3.2 网络分区与脑裂问题处理

网络分区(Network Partition)和脑裂(Split-brain)是HDFS集群中遇到的较为复杂的问题。网络分区可能会导致节点间的通信中断,而脑裂问题则是在网络分区后,集群被分成两个孤立的部分,它们各自独立地运行。

为了解决这些问题,HDFS采用了以下策略:

- **Quorum Journal Manager**:使用多个NameNode和共享存储来避免单点故障,并通过Quorum机制确保数据的一致性。

- ** fencing**:对于参与网络分区的节点,实施隔离(fencing)操作,阻止它们访问数据,直到网络分区问题解决。

- **脑裂检测**:HDFS通过维护锁和版本号来检测脑裂,并利用仲裁投票机制确保只有一个节点可以执行写操作。

在HDFS中,故障恢复机制的设计是为了确保数据的持久性和集群的高可用性。理解这些机制的工作原理对于维护一个稳定运行的Hadoop集群至关重要。通过不断优化故障检测和恢复流程,可以最大程度地减少故障对业务的影响。

# 3. 备份策略的理论与实践

## 3.1 HDFS数据备份基础

### 3.1.1 备份的必要性与挑战

在企业级的大数据环境中,数据的备份是一个不可或缺的部分。备份数据的必要性主要体现在以下几个方面:

- **数据丢失的防范**:硬盘故障、软件bug、操作失误等都可能导致数据丢失,备份机制可以将损失降至最低。

- **灾难恢复**:面对自然灾害、电力问题、硬件损坏等不可抗力因素,备份数据是恢复业务的唯一手段。

- **合规性要求**:某些行业或地区可能有数据保留的法律要求,备份可以保证企业遵守这些规定。

然而,备份也面临着

0

0