YOLOv8网络结构图:从原理到实战,全面解读其设计精髓

发布时间: 2024-07-20 03:31:28 阅读量: 797 订阅数: 55

YOLOv8模型部署指南:从训练到实战应用

# 1. YOLOv8网络结构图简介

YOLOv8是YOLO目标检测算法的最新版本,于2022年4月发布。它在YOLOv7的基础上进行了多项改进,包括:

- 采用新的骨干网络CSPDarknet53,具有更强的特征提取能力。

- 引入了Focus和Mish激活函数,提高了模型的收敛速度和精度。

- 增强了特征提取网络,增加了Spatial Attention Module和Path Aggregation Network,提升了特征的表达能力。

- 优化了检测头,采用了新的检测层和NMS算法,提高了目标检测的准确性和速度。

# 2. YOLOv8网络结构图理论剖析

### 2.1 YOLOv8的总体架构

#### 2.1.1 网络结构的演变

YOLOv8继承了YOLO系列网络的总体架构,采用单阶段目标检测框架。与前代相比,YOLOv8在网络结构上进行了优化和创新,主要体现在以下方面:

- **深度加宽:**YOLOv8采用了更深的网络结构,增加了网络层数和通道数,从而提升了网络的特征提取能力。

- **轻量化:**YOLOv8通过使用轻量化的CSPDarknet53骨干网络和Focus模块,降低了网络的计算量,同时保持了较高的精度。

- **多尺度特征融合:**YOLOv8引入Path Aggregation Network(PAN),实现了不同尺度特征的融合,增强了网络对不同大小目标的检测能力。

#### 2.1.2 YOLOv8的创新点

YOLOv8的创新点主要体现在以下几个方面:

- **Mish激活函数:**YOLOv8采用了Mish激活函数,该函数具有平滑、非单调的特性,可以提升网络的非线性表达能力。

- **Spatial Attention Module (SAM):**YOLOv8在特征提取网络中加入了SAM模块,该模块可以增强网络对空间信息的关注,提升目标定位的精度。

- **Soft-NMS:**YOLOv8在后处理阶段采用了Soft-NMS算法,该算法可以有效抑制重叠目标的检测框,提升检测精度。

### 2.2 YOLOv8的骨干网络

#### 2.2.1 CSPDarknet53

YOLOv8采用CSPDarknet53作为骨干网络,该网络结构基于Darknet53改进而来。CSPDarknet53的主要特点如下:

- **CSP结构:**CSPDarknet53采用了CSP(Cross Stage Partial)结构,将网络划分为多个阶段,每个阶段包含多个残差块。CSP结构可以有效减少网络的计算量,同时保持较高的精度。

- **残差连接:**CSPDarknet53中的残差块采用了残差连接,该连接可以缓解梯度消失问题,提升网络的训练稳定性和收敛速度。

- **空间金字塔池化:**CSPDarknet53在网络的末端加入了空间金字塔池化(SPP)模块,该模块可以提取不同尺度的特征,增强网络对不同大小目标的检测能力。

#### 2.2.2 Focus和Mish激活函数

**Focus模块:**Focus模块是YOLOv8中引入的一个新模块,其作用是将输入图像缩小为原来的1/4,同时增加通道数。Focus模块可以有效减少网络的计算量,同时保持图像中的关键信息。

**Mish激活函数:**Mish激活函数是一种平滑、非单调的激活函数,其公式为:

```

Mish(x) = x * tanh(ln(1 + exp(x)))

```

Mish激活函数具有以下特点:

- 非单调性:Mish激活函数是非单调的,这使得网络可以学习更复杂的特征。

- 平滑性:Mish激活函数的导数是连续的,这使得网络的训练更加稳定。

### 2.3 YOLOv8的特征提取网络

#### 2.3.1 Spatial Attention Module (SAM)

SAM模块是一种空间注意力机制,其作用是增强网络对空间信息的关注。SAM模块的结构如下图所示:

```mermaid

graph LR

subgraph SAM

A[Spatial Attention]

B[1x1 Conv]

C[Sigmoid]

D[Multiply]

A --> B

B --> C

C --> D

D --> A

end

```

SAM模块的具体工作流程如下:

1. 将特征图输入到1x1卷积层中,生成一个通道数为1的特征图。

2. 将生成的特征图通过Sigmoid激活函数,得到一个空间注意力图。

3. 将空间注意力图与输入特征图相乘,得到增强了空间信息的特征图。

#### 2.3.2 Path Aggregation Network (PAN)

PAN模块是一种特征融合模块,其作用是将不同尺度的特征融合起来。PAN模块的结构如下图所示:

```mermaid

graph LR

subgraph PAN

A[P3]

B[P4]

C[P5]

D[1x1 Conv]

E[Upsample]

F[Concat]

A --> D

B --> D

C --> D

D --> E

E --> F

F --> A

F --> B

F --> C

end

```

PAN模块的具体工作流程如下:

1. 将不同尺度的特征图输入到1x1卷积层中,生成通道数相同的特征图。

2. 将生成的特征图通过上采样操作,调整到相同的尺度。

3. 将调整后的特征图进行拼接,得到融合了不同尺度信息的特征图。

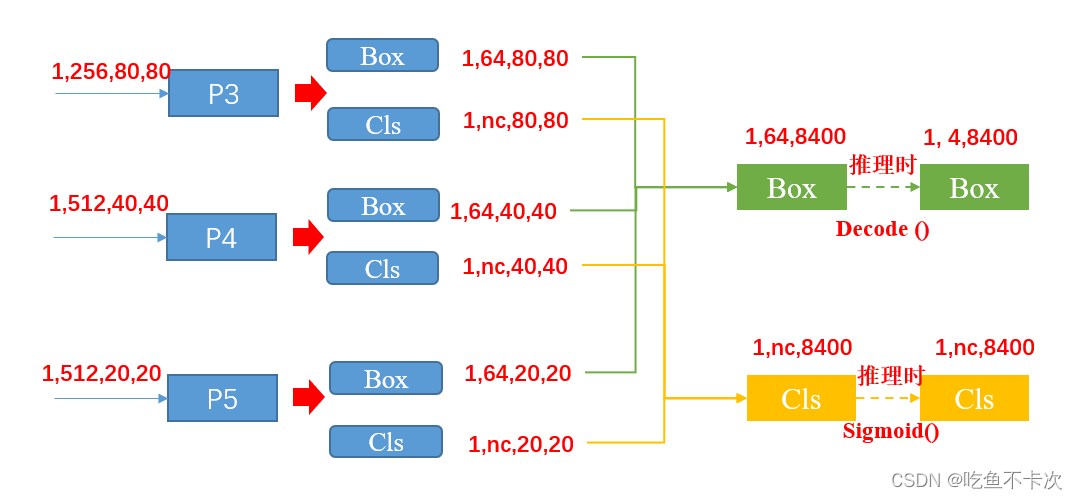

### 2.4 YOLOv8的检测头

#### 2.4.1 YOLOv8的检测层

YOLOv8的检测层是一个3x3的卷积层,其作用是将特征图中的每个单元预测为一个目标检测框和一个目标类别。检测层的输出格式为:

```

[x, y, w, h, confidence, class1, class2, ..., classN]

```

其中:

- (x, y)是目标检测框的中心点坐标。

- (w, h)是目标检测框的宽高。

- confidence是目标检测框的置信度。

- class1, class2, ..., classN是目标检测框所属类别的概率分布。

#### 2.4.2 NMS和Soft-NMS

**NMS(Non-Maximum Suppression):**NMS是一种后处理算法,其作用是抑制重叠的目标检测框。NMS的具体工作流程如下:

1. 根据目标检测框的置信度对目标检测框进行排序。

2. 从置信度最高的目标检测框开始,依次遍历所有目标检测框。

3. 如果当前目标检测框与之前的目标检测框的重叠面积超过阈值,则丢弃当前目标检测框。

**Soft-NMS:**Soft-NMS是一种改进的NMS算法,其作用是抑制重叠的目标检测框,同时保留更多的目标信息。Soft-NMS的具体工作流程如下:

1. 根据目标检测框的置信度对目标检测框进行排序。

2. 从置信度最高的目标检测框开始,依次遍历所有目标检测框。

3. 如果当前目标检测框与之前的目标检测框的重叠面积超过阈值,则降低当前目标检测框的置信度。

4. 重复步骤3,直到所有目标检测框的置信度都低于阈值。

# 3. YOLOv8网络结构图实践应用

### 3.1 YOLOv8的训练流程

#### 3.1.1 数据集准备

训练YOLOv8模型需要准备高质量的训练数据集。常用的数据集包括COCO、VOC和ImageNet。

* **COCO数据集:**包含超过20万张图像,标注了91个目标类别。

* **VOC数据集:**包含超过2万张图像,标注了20个目标类别。

* **ImageNet数据集:**包含超过100万张图像,标注了1000个目标类别。

#### 3.1.2 训练参数设置

训练YOLOv8模型时,需要设置以下主要参数:

* **batch_size:**训练过程中每个批次的数据量。

* **epochs:**训练模型的迭代次数。

* **learning_rate:**优化器使用的学习率。

* **weight_decay:**用于正则化的权重衰减。

#### 3.1.3 训练过程监控

训练过程中,需要监控以下指标:

* **loss:**模型的损失函数值。

* **accuracy:**模型的准确率。

* **mAP:**模型的平均精度。

### 3.2 YOLOv8的推理部署

#### 3.2.1 模型转换和优化

训练好的YOLOv8模型需要转换为推理框架支持的格式。常用的推理框架包括TensorFlow、PyTorch和ONNX。

#### 3.2.2 推理环境搭建

推理环境需要包括以下组件:

* **推理框架:**用于加载和执行模型。

* **GPU或CPU:**用于加速推理过程。

* **摄像头或视频流:**用于提供输入数据。

#### 3.2.3 实时目标检测演示

部署YOLOv8模型后,可以进行实时目标检测演示。以下是一个示例代码:

```python

import cv2

import numpy as np

# 加载模型

model = cv2.dnn.readNetFromDarknet("yolov8.cfg", "yolov8.weights")

# 初始化摄像头

cap = cv2.VideoCapture(0)

while True:

# 读取帧

ret, frame = cap.read()

# 预处理帧

frame = cv2.resize(frame, (640, 640))

frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

# 执行推理

blob = cv2.dnn.blobFromImage(frame, 1 / 255.0, (640, 640), (0, 0, 0), swapRB=True, crop=False)

model.setInput(blob)

detections = model.forward()

# 后处理检测结果

for detection in detections[0, 0]:

confidence = detection[2]

if confidence > 0.5:

x1, y1, x2, y2 = (detection[3:7] * np.array([frame.shape[1], frame.shape[0], frame.shape[1], frame.shape[0]])).astype(np.int)

cv2.rectangle(frame, (x1, y1), (x2, y2), (0, 255, 0), 2)

# 显示帧

cv2.imshow("frame", frame)

# 退出循环

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# 释放摄像头

cap.release()

# 销毁窗口

cv2.destroyAllWindows()

```

### 3.2.4 训练过程监控

训练过程中,需要监控以下指标:

* **loss:**模型的损失函数值。

* **accuracy:**模型的准确率。

* **mAP:**模型的平均精度。

# 4. YOLOv8网络结构图进阶应用

### 4.1 YOLOv8的自定义训练

#### 4.1.1 自建数据集的标注和预处理

自定义训练YOLOv8模型的第一步是构建自己的数据集。数据集的质量和多样性直接影响模型的性能。

**数据集标注:**

* 使用标注工具(如LabelImg、VGG Image Annotator)对图像中的目标进行标注。

* 标注目标的边界框和类别。

* 确保标注准确无误,避免出现错标或漏标。

**数据集预处理:**

* 将图像和标注信息转换为YOLOv8训练所需的格式。

* 对图像进行预处理,如调整大小、归一化、增强(旋转、翻转、裁剪)。

* 预处理过程有助于提高模型的泛化能力和鲁棒性。

#### 4.1.2 训练参数的调整和优化

自定义训练YOLOv8模型时,需要根据数据集和任务调整训练参数。

**超参数调整:**

* 学习率、批大小、迭代次数等超参数对模型训练过程有显著影响。

* 通过网格搜索或其他优化方法确定最佳超参数组合。

**优化策略:**

* 使用优化器(如Adam、SGD)更新模型权重。

* 采用学习率衰减策略(如余弦退火)以提高训练稳定性。

* 使用数据增强技术(如MixUp、CutMix)以防止模型过拟合。

### 4.2 YOLOv8的模型集成

#### 4.2.1 模型融合的策略和方法

模型集成是一种提高YOLOv8模型性能的有效方法。

**模型融合策略:**

* **平均集成:**对多个模型的预测结果取平均值。

* **加权平均集成:**根据每个模型的性能分配权重,然后取加权平均值。

* **级联集成:**将多个模型串联起来,每个模型处理不同阶段的特征。

**模型融合方法:**

* **特征融合:**在检测头之前融合不同模型的特征。

* **预测融合:**在检测头之后融合不同模型的预测结果。

* **混合模型:**训练一个新模型,其权重由多个模型的权重组合而成。

#### 4.2.2 集成模型的性能提升

模型集成可以带来以下性能提升:

* **鲁棒性增强:**集成模型对噪声和异常值更加鲁棒。

* **泛化能力提高:**集成模型可以学习不同模型的优点,从而提高泛化能力。

* **精度提升:**集成模型通常比单个模型具有更高的精度。

### 4.3 YOLOv8的边缘部署

#### 4.3.1 轻量化模型的压缩和剪枝

边缘设备通常具有计算能力和内存资源有限。因此,需要将YOLOv8模型进行轻量化。

**模型压缩:**

* **知识蒸馏:**将大型模型的知识转移到小型模型中。

* **量化:**将浮点权重和激活值转换为低精度格式。

* **剪枝:**去除对模型性能影响较小的权重。

**模型剪枝:**

* **过滤器剪枝:**去除冗余的卷积过滤器。

* **通道剪枝:**去除不重要的特征通道。

* **结构剪枝:**去除整个层或模块。

#### 4.3.2 边缘设备的部署和优化

将轻量化模型部署到边缘设备需要考虑以下因素:

**部署环境:**

* 确定边缘设备的硬件架构、操作系统和可用资源。

* 根据设备限制调整模型和推理引擎。

**推理优化:**

* **批处理:**同时处理多个图像以提高推理速度。

* **并行计算:**利用多核或GPU进行并行推理。

* **内存优化:**优化模型和推理引擎的内存占用。

# 5. YOLOv8网络结构图未来发展

### 5.1 YOLOv8的持续优化

#### 5.1.1 算法创新和模型改进

YOLOv8作为目标检测领域的标杆模型,其未来的发展方向之一是持续优化算法和模型结构。以下是一些潜在的改进方向:

- **注意力机制的引入:**注意力机制可以帮助模型专注于图像中更重要的区域,从而提升检测精度。未来,YOLOv8可以考虑引入不同的注意力机制,例如自注意力或通道注意力,以进一步提升模型的性能。

- **特征金字塔的优化:**特征金字塔是YOLOv8特征提取网络的关键组成部分。未来,可以探索新的特征金字塔结构,例如FPN+,BiFPN或PANet,以提取更丰富的特征信息。

- **损失函数的改进:**损失函数是训练模型的关键因素。未来,可以研究新的损失函数,例如Focal Loss或DIoU Loss,以更好地衡量模型的预测误差,从而提升模型的训练效果。

#### 5.1.2 训练数据的扩充和增强

训练数据的质量和数量对模型的性能至关重要。未来,YOLOv8可以从以下方面扩充和增强训练数据:

- **更多数据集的引入:**目前,YOLOv8主要在COCO数据集上进行训练。未来,可以引入更多不同领域和场景的数据集,例如VOC、ImageNet或Cityscapes,以提升模型的泛化能力。

- **数据增强技术的应用:**数据增强技术可以生成更多样化的训练样本,从而防止模型过拟合。未来,YOLOv8可以探索新的数据增强技术,例如MixUp、CutMix或RandAugment,以进一步提升模型的鲁棒性。

- **合成数据的利用:**合成数据可以弥补真实数据的不足,从而扩充训练数据集。未来,YOLOv8可以考虑利用合成数据,例如Sim10k或GTA5,以进一步提升模型的训练效果。

### 5.2 YOLOv8的应用拓展

#### 5.2.1 更多领域的应用场景

YOLOv8在目标检测领域取得了巨大的成功,但其应用场景远不止于此。未来,YOLOv8可以拓展到更多领域,例如:

- **视频目标检测:**YOLOv8可以应用于视频目标检测,以实现实时目标跟踪、行为分析和异常事件检测等任务。

- **医学图像分析:**YOLOv8可以应用于医学图像分析,以辅助疾病诊断、器官分割和病灶检测等任务。

- **无人驾驶:**YOLOv8可以应用于无人驾驶,以实现车辆检测、行人检测和障碍物检测等任务。

#### 5.2.2 与其他技术领域的融合

YOLOv8可以与其他技术领域融合,以实现更强大的功能。以下是一些潜在的融合方向:

- **自然语言处理(NLP):**YOLOv8可以与NLP技术结合,实现图像和文本的联合理解,从而提升目标检测的语义理解能力。

- **强化学习(RL):**YOLOv8可以与RL技术结合,实现目标检测的强化学习,从而提升模型的鲁棒性和适应性。

- **边缘计算:**YOLOv8可以与边缘计算技术结合,实现目标检测的边缘部署,从而满足低延迟和低功耗的应用需求。

# 6. YOLOv8网络结构图总结与展望

YOLOv8作为目标检测领域的又一里程碑,在速度、精度和鲁棒性方面取得了显著提升。其创新的网络结构和优化策略为目标检测算法的发展提供了新的思路。

回顾YOLOv8的演进历程,我们可以看到其在以下方面的贡献:

- **网络结构的简化:**YOLOv8采用CSPDarknet53作为骨干网络,并通过Focus和Mish激活函数等优化,实现了更轻量化的网络结构,同时保持了较高的精度。

- **特征提取的增强:**Spatial Attention Module和Path Aggregation Network的引入,增强了网络提取特征的能力,提高了目标检测的准确性。

- **检测头的优化:**YOLOv8的检测层采用Anchor-Free的设计,并结合NMS和Soft-NMS算法,进一步提升了目标检测的性能。

展望未来,YOLOv8网络结构图仍有广阔的发展空间:

- **算法创新:**随着深度学习技术的不断发展,新的算法和模型不断涌现,YOLOv8可以进一步融合这些创新,提升其性能。

- **模型改进:**通过优化网络结构、改进训练策略和扩充训练数据,可以进一步提升YOLOv8的精度和泛化能力。

- **应用拓展:**YOLOv8的应用场景不仅限于目标检测,还可以拓展到其他领域,如图像分割、人脸识别和视频分析等。

随着YOLOv8网络结构图的不断发展和完善,它将继续在目标检测领域发挥重要作用,为更多应用场景提供高效、准确的解决方案。

0

0