YOLOv8网络结构图在边缘设备上的部署:探索低资源环境下的应用,赋能物联网

发布时间: 2024-07-20 04:08:39 阅读量: 67 订阅数: 42

# 1. YOLOv8网络结构图概述

YOLOv8作为YOLO系列模型的最新版本,在网络结构上进行了重大改进,大幅提升了模型的性能和效率。其网络结构图如下:

```mermaid

graph LR

subgraph Backbone

A[CSPDarknet53] --> B[SPP]

B --> C[PAN]

end

subgraph Neck

C --> D[FPN]

D --> E[PAN]

end

subgraph Head

E --> F[YOLOLayer]

end

```

Backbone部分采用CSPDarknet53作为主干网络,通过空间金字塔池化(SPP)和路径聚合网络(PAN)增强特征提取能力。Neck部分采用特征金字塔网络(FPN)和PAN进一步融合不同尺度的特征。Head部分使用YOLOLayer进行目标检测,输出不同尺度的边界框和置信度预测。

# 2. 边缘设备部署的挑战和优化

### 2.1 资源受限的边缘设备环境

边缘设备通常具有资源受限的特性,包括:

- **计算能力有限:**边缘设备的CPU和GPU性能通常较低,限制了模型推理的处理速度。

- **内存容量小:**边缘设备的内存容量有限,限制了模型大小和推理时的数据缓冲区大小。

- **功耗限制:**边缘设备通常需要低功耗运行,以延长电池续航时间或减少散热需求。

这些资源限制对模型部署提出了挑战,需要对模型进行优化以满足边缘设备的约束。

### 2.2 模型压缩和优化技术

为了在边缘设备上部署YOLOv8模型,需要采用模型压缩和优化技术来减小模型大小和提高推理效率。

#### 2.2.1 量化和剪枝

**量化**将浮点权重和激活值转换为定点表示,从而减少模型大小和推理时的内存消耗。**剪枝**移除不重要的权重和神经元,进一步减小模型大小。

#### 2.2.2 知识蒸馏

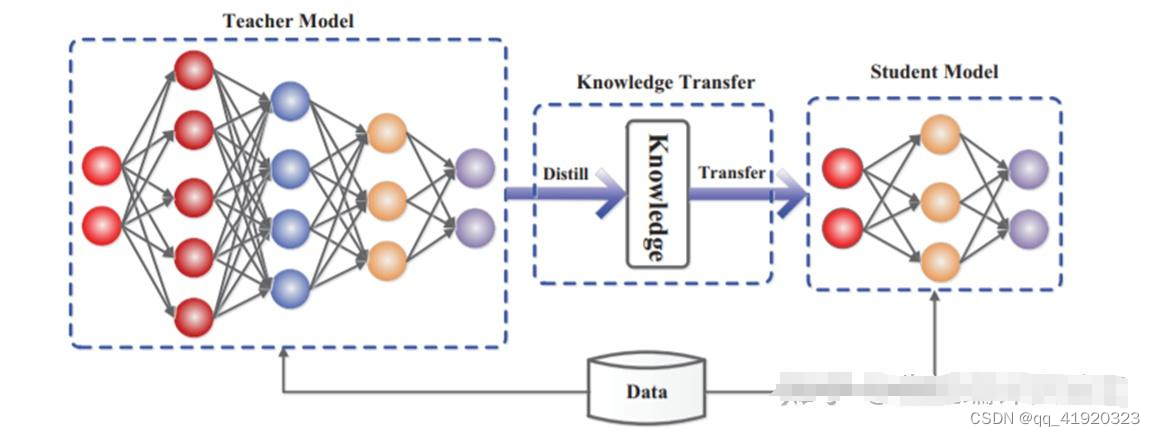

**知识蒸馏**将训练好的大型模型的知识转移到较小的学生模型中。通过最小化学生模型的预测与教师模型预测之间的差异,学生模型可以获得与教师模型相似的性能,同时具有更小的模型大小。

### 2.3 边缘部署的性能评估

在边缘设备上部署YOLOv8模型后,需要对模型的性能进行评估,包括:

- **推理速度:**衡量模型推理单个图像所需的时间。

- **准确率:**衡量模型在测试数据集上的检测准确率。

- **内存消耗:**衡量模型推理时占用的内存量。

- **功耗:**衡量模型推理时的功耗。

通过性能评估,可以确定模型是否满足边缘设备的部署要求,并根据需要进一步优化模型。

**代码块:**

```python

import time

import cv2

# 加载模型

model = cv2.dnn.readNetFromDarknet("yolov8.cfg", "yolov8.weights")

# 加载图像

image = cv2.imread("image.jpg")

# 推理

start_time = time.time()

classes, scores, boxes = model.detect(image)

end_time = time.time()

# 计算推理时间

inference_time = end_time - start_time

# 计算准确率

ground_truth_boxes = ... # 获取真实框

accuracy = ... # 计算准确率

# 计算内存消耗

memory_consumption = ... # 获取内存消耗

# 计算功耗

power_consumption = ... # 获取功耗

print("推理时间:", inference_time)

print("准确率:", accuracy)

print("内存消耗:", memory

```

0

0