【性能飙升揭秘】:Hadoop 3.x与2.x性能比较,数据处理能力翻倍!

发布时间: 2024-10-27 21:05:54 阅读量: 116 订阅数: 30

Hadoop 2.x与3.x 22点比较,Hadoop 3.x比2.x的改进

# 1. Hadoop概述及其发展

## 1.1 Hadoop定义与起源

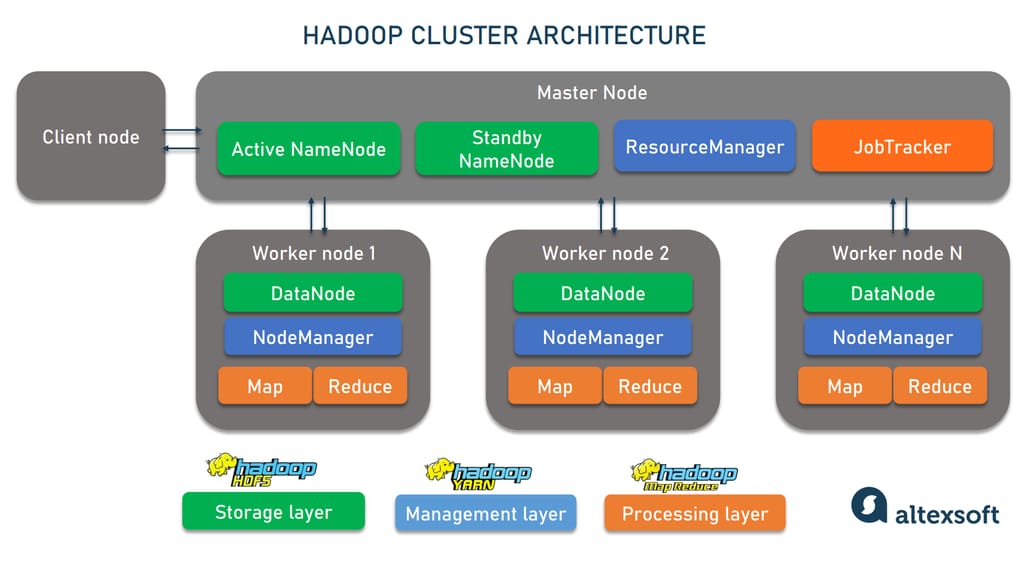

Hadoop是一个由Apache软件基金会开发的开源框架,它允许用户在分布式系统中存储和处理大量数据。它提供了一个存储解决方案——Hadoop Distributed File System(HDFS),以及一个并行处理框架——MapReduce。Hadoop的设计灵感来源于Google的一篇关于MapReduce算法和Google File System(GFS)的论文,其目标是处理大规模数据集,实现可伸缩和可靠的数据处理。

## 1.2 Hadoop的发展历程

自2006年推出以来,Hadoop经历了多个版本的迭代和发展,每个版本都带来了显著的改进。Hadoop 1.x版本主要提供了核心的存储和计算功能。到了Hadoop 2.x,引入了YARN(Yet Another Resource Negotiator)框架,这个新架构将资源管理和作业调度功能分离开来,为Hadoop生态系统带来了更广泛的应用范围和更高的资源利用率。随着Hadoop 3.x的发布,架构进一步优化,引入了诸如HDFS联邦、Erasure Coding和更优的资源管理等特性,旨在支持更大规模的数据存储和处理,提高了系统的可用性、扩展性和性能。

# 2. Hadoop 2.x核心组件分析

### 2.1 Hadoop 2.x架构组成

#### 2.1.1 HDFS的高可用性机制

Hadoop分布式文件系统(HDFS)是Hadoop生态系统中的关键组件,负责存储大数据。在Hadoop 2.x版本中,HDFS引入了高可用性(High Availability, HA)机制,使得Hadoop集群能够容忍NameNode的故障,从而保证集群的高可用性和稳定性。

高可用性机制主要通过引入Active-Standby的NameNode对实现。在这种配置下,存在一个活动的NameNode和一个或多个待命的Standby NameNode。活动的NameNode负责处理所有客户端的文件系统操作请求,而待命的Standby NameNode则同步活动节点的状态,以实现快速故障切换。

高可用性配置的关键组件包括:

- **Quorum Journal Manager (QJM)**: 一个由多个JournalNode组成的共享存储系统,用于维护活动和待命NameNode之间编辑日志的一致性。

- **Active NameNode**: 负责处理所有客户端操作请求的NameNode。

- **Standby NameNode**: 同步活动NameNode的状态,并在需要时接管成为活动节点。

- **Failover Controller**: 管理NameNode故障切换的控制器。

在高可用性环境下,一旦活动NameNode出现故障,Standby NameNode可以迅速接管,继续提供服务,从而最小化停机时间。

```

Diagram Not Shown:

```

```mermaid

stateDiagram

[*] --> ActiveNameNode: Start HA

ActiveNameNode --> StandbyNameNode: Sync state

state ActiveNameNode {

[*] --> ClientRequests: Handle

}

state StandbyNameNode {

[*] --> JournalNodesSync: Sync edits

JournalNodesSync --> [*]

}

ActiveNameNode --> StandbyNameNode: Failover

StandbyNameNode --> ClientRequests: Takeover

```

在配置HDFS高可用性时,需要设置多个JournalNode(通常奇数个),以确保集群中编辑日志的一致性。同时需要配置Zookeeper,用于故障检测和故障转移过程中的协调。

#### 2.1.2 YARN的资源管理与作业调度

YARN(Yet Another Resource Negotiator)是Hadoop 2.x引入的资源管理框架,它将资源管理和作业调度/监控功能分离,使得Hadoop能够支持除MapReduce之外的多种数据处理模型。

在YARN中,资源管理由ResourceManager(RM)负责,它负责整个系统的资源分配和调度,维护一个全局资源池。每个应用程序由一个ApplicationMaster(AM)管理,AM负责与RM协商资源、监控任务的执行以及处理作业失败的重试逻辑。

YARN的工作流程主要包括以下几个步骤:

1. **客户端提交作业**: 提交的作业信息被封装成一个ApplicationMaster实例。

2. **ResourceManager分配资源**: RM为每个AM分配一个Container,Container是资源(如CPU、内存)的抽象表示。

3. **ApplicationMaster执行作业**: AM在分配到的Container上运行作业,监控作业的执行状态。

4. **ResourceManager调度和监控**: RM监控资源使用情况,负责调度新的资源请求和跟踪资源的使用情况。

```

Diagram Not Shown:

```

```mermaid

graph LR

A[Client] -->|submit job| B[ResourceManager]

B -->|allocate Container| C[ApplicationMaster]

C -->|run tasks| D[NodeManager]

D -->|report status| B

style B stroke:#f66,stroke-width:2px

style C stroke:#6f6,stroke-width:2px

```

YARN架构的灵活性允许各种不同的计算框架在同一资源池中运行,如MapReduce、Spark、Tez等。这种设计提升了Hadoop集群的资源利用率和扩展性。

### 2.2 Hadoop 2.x数据处理流程

#### 2.2.1 MapReduce编程模型详解

MapReduce是一个分布式计算模型,由Google提出,被Hadoop采纳为数据处理的主要范式。其主要思想是将任务分解为两个阶段:Map阶段和Reduce阶段。

- **Map阶段**:Map操作读取输入数据,并将其转换为一系列的键值对中间数据,这些中间数据表示原始输入数据的某种特征。

- **Shuffle过程**:Hadoop自动处理中间数据的排序和分组,确保相同键值的数据被发送到同一个Reducer。

- **Reduce阶段**:Reduce操作对具有相同键值的中间数据进行聚合处理,生成最终的输出结果。

MapReduce模型的关键特点包括:

- **扩展性**:模型可以扩展到大规模集群。

- **容错性**:自动处理节点故障。

- **灵活性**:适用于各种数据处理任务。

```java

// Example MapReduce code block

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

```

MapReduce编程模型通过用户定义的Map和Reduce函数来处理数据。在实际应用中,开发者需要编写相应的Map函数和Reduce函数,然后通过Hadoop框架来执行计算任务。

#### 2.2.2 Hadoop生态系统中的数据流

Hadoop生态系统不仅包括HDFS和YARN,还有许多外围组件参与整个数据流的处理。这些组件包括数据采集的Flume和Kafka、数据集成的Sqoop、数据查询的Hive等。

数据处理流程通常包括以下步骤:

1. **数据采集**:使用Flume或Kafka等工具从各种数据源中采集日志数据。

2. **数据传输**:通过Sqoop将采集的数据批量传输到HDFS存储。

3. **数据处理**:使用MapReduce或Spark等处理框架对数据进行转换和分析。

4. **数据查询和分析**:通过Hive或Impala对处理后的数据执行SQL查询。

数据的输入、处理和输出构成了Hadoop生态系统的数据流。在这个生态系统中,各个组件各司其职,协同工作,以支持大规模数据处理。

```mermaid

graph LR

A[Data Source] -->|collect| B[Flume/Kafka]

B -->|transfer| C[Sqoop]

C -->|store| D[HDFS]

D -->|process| E[MapReduce/Spark]

E -->|query/analyze| F[Hive/Impala]

style A fill:#f9f,stroke:#333,stroke-width:2px

style B fill:#f9f,stroke:#333,stroke-width:2px

style C fill:#f9f,stroke:#333,stroke-width:2px

style D fill:#f9f,stroke:#333,stroke-width:2px

style E fill:#f9f,stroke:#333,stroke-width:2px

style F fill:#f9f,stroke:#333,stroke-width:2px

```

在数据处理过程中,数据流向非常关键,合理的数据流向设计能显著提高数据处理效率和查询响应速度。

### 2.3 Hadoop 2.x性能优化案例研究

#### 2.3.1 配置调整与参数优化

Hadoop集群的性能优化通常首先从配置调整和参数优化开始。合理配置HDFS和YARN的相关参数可以大幅提高集群的工作效率。

在HDFS中,常见的优化参数包括:

- `dfs.replication`: 数据块的副本数量。适当降低这个值可以减少磁盘I/O开销,但会牺牲数据的可靠性。

- `dfs.block.size`: 块大小。更大块大小可以提高读写吞吐量,但会增加Map任务的内存消耗。

在YARN中,重要的优化参数包括:

- `yarn.nodemanager.resource.memory-mb`: NodeManager可分配给应用程序的内存总量。

- `yarn.scheduler.maximum-allocation-mb`: Scheduler能分配的最大内存。

```

// Example Hadoop configuration

fs.defaultFS=hdfs://namenode:8020

dfs.replication=3

dfs.block.size=256MB

yarn.scheduler.maximum-allocation-mb=8192

yarn.nodemanager.resource.memory-mb=8192

```

调整这些参数时,需要根据具体的应用场景和硬件资源进行权衡,以获得最佳的性能表现。

#### 2.3.2 实际应用中的性能瓶颈分析

在Hadoop的实际应用中,性能瓶颈可能出现在多个环节,如HDFS的I/O、网络通信、CPU计算等。针对性能瓶颈的分析和优化是提升整体性能的关键。

性能瓶颈分析的方法包括:

- **监控工具**:使用如Ganglia、Nagios等监控工具实时监控集群状态。

- **日志分析**:分析Hadoop的日志文件,寻找错误和性能瓶颈的线索。

- **性能测试**:使用Apache JMeter、Hadoop自带的Benchmark脚本进行性能测试。

一旦找到性能瓶颈,可以通过增加硬件资源、优化Hadoop配置或改进应用程序逻辑等方法来解决。

```shell

# Running a MapReduce job to test performance

hadoop jar /path/to/mrjob.jar InputClass /path/to/input /path/to/output

```

性能优化是一个持续的过程,需要不断地对集群进行监控、分析和调整。通过不断地优化和调校,可以逐步提升Hadoop集群的性能,以满足各种复杂应用场景的需求。

# 3. Hadoop 3.x新特性解读

## 3.1 Hadoop 3.x架构升级

### 3.1.1 HDFS联邦和NameNode高可用性的增强

Hadoop 3.x 在架构上引入了HDFS联邦(HDFS Federation)机制,解决了单个NameNode的扩展性限制问题。联邦架构允许在Hadoop集群中存在多个NameNode,每个NameNode管理文件系统的不同命名空间。这样的设计提高了系统的扩展性和可靠性。HDFS联邦可以水平扩展,通过增加更多的NameNode来分散元数据的负载,从而避免了以往版本中随着文件数量增加导致的性能瓶颈。

为了进一步提高系统的可靠性,Hadoop 3.x 对NameNode的高可用性也进行了增强。高可用性配置允许两个NameNode节点同时运行,一个处于活动状态,另一个处于热备份状态。通过使用ZooKeeper来同步元数据状态,确保当活动NameNode出现故障时,备份节点能够迅速接管,确保了整个系统的高可用性。这一特性对于需要7x24小时运行的大数据集群来说至关重要。

### 3.1.2 YARN与ResourceManager的改进

YARN(Yet Another Resource Negotiator)作为Hadoop 2.x引入的核心组件,负责资源管理和作业调度。到了Hadoop 3.x,ResourceManager得到了进一步的优化和改进。在新版本中,YARN的ResourceManager引入了资源调度器的可插拔设计,这使得用户可以根据需要选择不同的调度策略。比如Fair Scheduler和Capacity Scheduler都有了更好的扩展性和改进,为集群的资源管理带来了更高的灵活性。

另一个改进是YARN在资源分配方面的优化。Hadoop 3.x 通过引入了Container级别的资源规格(Resource Specification),允许对资源分配进行更细致的控制。用户可以通过指定CPU、内存等资源的使用上限,来提高作业的执行效率,同时避免了资源的过度分配导致的浪费。

```

<配置示例代码>

# YARN的ResourceManager配置示例

yarn.resourcemanager.scheduler.class: org.apache.hadoop.yarn.server.resourcemanager.scheduler.capacity.CapacityScheduler

yarn.resourcemanager.resource-tracker.address: ${namenode_host}:${namenode_port}

yarn.resourcemanager.address: ${namenode_host}:${namenode_port}

yarn.resourcemanager.scheduler.resource-types: memory,vcores

yarn.scheduler.capacity资源配置示例:

yarn.scheduler.capacity.root资源配置示例:

```

以上配置的解释和参数说明如下:

- `yarn.resourcemanager.scheduler.class`: 设置YARN中ResourceManager使用的调度器类。

- `yarn.resourcemanager.resource-tracker.address` 和 `yarn.resourcemanager.address`: 这两个参数用于指定ResourceManager的网络地址和端口。

- `yarn.scheduler.capacity.resource-types`: 定义资源类型,Hadoop 3.x支持内存(memory)和虚拟核心(vcores)。

- `yarn.scheduler.capacity` 和其子属性:允许对YARN集群的资源分配进行分层配置,包括root、default等队列的资源配比。

## 3.2 Hadoop 3.x中的新组件

### 3.2.1 Erasure Coding的数据保护机制

在Hadoop 3.x版本中,引入了Erasure Coding(EC)作为数据保护的新机制,以替代旧版本中常见的三副本策略。Erasure Coding可以提供与三副本相当的容错能力,但同时大幅度降低了存储成本。对于存储大量数据的大数据集群来说,这一改进意味着能够节省大量的存储空间。

Erasure Coding通过将数据分割成多个块,并对每个块进行编码,生成一定数量的校验块。这样即使部分块发生故障,系统也能够利用剩余的数据块和校验块重构出丢失的数据。这种方法相比于三副本策略,最多可以节省50%的存储空间,这对于存储成本高昂的数据中心来说是个重大的改进。

### 3.2.2 Hadoop集群的安全性提升 - Knox与Kerberos

为了更好地保护Hadoop集群免受安全威胁,Hadoop 3.x集成了更多的安全性特性。其中,Knox和Kerberos的集成对于增强集群安全性起到了关键作用。Knox是Hadoop集群的一个网关服务,提供了对集群服务的统一入口点。通过Knox,管理员可以更加集中地控制对Hadoop集群的访问权限,同时实现对数据传输过程中的加密保护。

Kerberos是一种网络认证协议,用于在不安全的网络环境中提供强认证。通过与Kerberos的集成,Hadoop集群在身份验证和授权方面更加严格。所有用户和服务都必须通过Kerberos的认证才能访问集群资源,这大大提高了安全性。管理员还可以通过Kerberos来精细地控制哪些用户和服务可以访问集群中的哪些资源。

## 3.3 Hadoop 3.x的性能提升与扩展性

### 3.3.1 大数据集处理能力的飞跃

Hadoop 3.x在处理大数据集方面进行了显著的改进,包括对HDFS文件系统的扩展性和性能的提升。HDFS增加了对超大文件的处理能力,可以更好地存储和处理PB级别的数据集。除了硬件层面的扩展,Hadoop 3.x还在软件层面增加了对数据存储和访问效率的优化,比如通过引入存储性能优化和改进的数据本地化策略。

Hadoop 3.x还支持存储在对象存储(如Amazon S3)上的数据,这意味着不再需要传统的HDFS,就能通过Hadoop集群直接访问和处理存储在云服务中的数据。这一特性极大地扩展了Hadoop的应用场景,特别是在云原生环境中。

### 3.3.2 资源管理的灵活性与可伸缩性

Hadoop 3.x提供了更加灵活和可扩展的资源管理机制。ResourceManager的改进使得集群资源的分配更加细致和高效,支持按需分配资源,减少了资源闲置的时间和空间。另一方面,YARN的调度器变得可插拔,管理员可以根据不同的作业需求选择合适的调度策略,这提供了更高的调度灵活性。

此外,Hadoop 3.x还增强了对容器(Docker)的支持,这使得它可以更加方便地在集群中部署和管理不同的应用程序。容器化技术可以帮助用户创建轻量级的虚拟化环境,加速应用部署,提高资源利用率,进一步增强了集群的可伸缩性。

```

<代码块示例>

# Docker容器的配置示例

FROM ubuntu:18.04

# 安装Hadoop组件

RUN apt-get update && apt-get install -y hadoop-mapreduce-hdfs

# 设置环境变量

ENV JAVA_HOME=/usr/lib/jvm/default-java

# 拷贝数据到容器中

COPY input /input

# 配置Hadoop环境

RUN bin/hdfs dfs -mkdir -p /user/root/input && \

bin/hdfs dfs -put /input/* /user/root/input

# 执行MapReduce作业

RUN bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-*.jar grep input output 'dfs[a-z.]+'

```

以上代码块是一个Docker容器中安装和配置Hadoop MapReduce环境,并运行一个简单的MapReduce作业的示例。代码中,首先从Ubuntu的基础镜像创建一个容器,然后安装Hadoop的MapReduce组件,设置JAVA_HOME环境变量,将输入数据拷贝到容器中的指定位置,并创建HDFS目录,将数据上传到HDFS。最后,执行了一个简单的MapReduce作业,示例中使用grep操作来处理输入数据,并将结果存储到output目录中。

这段代码展示了如何在一个Docker容器内快速搭建Hadoop环境,并执行数据处理作业,体现了Hadoop 3.x对容器化部署的支持和优化。

# 4. Hadoop 3.x与2.x性能比较实验

Hadoop 3.x的发布为大数据处理带来了许多令人兴奋的新特性。随着企业对于数据处理能力需求的不断增长,对新旧版本Hadoop进行性能比较和分析是至关重要的。在本章节中,我们将深入探讨如何设置实验环境、执行比较实验,并对实验结果进行详细的分析与讨论。

## 4.1 实验环境与工具准备

在进行Hadoop版本性能比较之前,确保实验环境是标准和一致的至关重要。我们将描述如何搭建实验环境、配置集群,并选择恰当的性能测试工具。

### 4.1.1 环境搭建和集群配置

搭建Hadoop 2.x和Hadoop 3.x集群环境应遵循以下步骤:

1. 准备硬件资源:至少需要4台机器,每台机器至少8GB内存和4核CPU。

2. 安装操作系统:推荐使用Ubuntu Server 18.04 LTS作为操作系统。

3. 安装Java环境:Hadoop运行需要Java环境,确保所有机器上都安装了Java 8。

4. 配置SSH免密登录:集群中的所有机器都需要配置免密登录,以便于管理。

5. 安装Hadoop:在每台机器上按照官方文档安装Hadoop 2.x和Hadoop 3.x。

具体配置时,需要编辑Hadoop配置文件,如`hadoop-env.sh`, `core-site.xml`, `hdfs-site.xml`, `mapred-site.xml`, 和`yarn-site.xml`,分别设置环境变量、HDFS参数、YARN参数和MapReduce参数。

示例的`hdfs-site.xml`配置片段如下:

```xml

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>***</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>***</value>

</property>

</configuration>

```

### 4.1.2 性能测试工具与基准数据集

为了保证实验的客观性,我们需要选择合适的性能测试工具和准备标准的基准数据集。常用的性能测试工具有:

- Yahoo! Cloud Serving Benchmark (YCSB)

- HiBench

- Terasort

基准数据集方面,可以选择如TB级的Wikipedia数据集、NYC Taxi Trip数据集等。通过这些数据集可以模拟真实世界的大数据处理场景。

## 4.2 实验设计与执行

### 4.2.1 数据处理与任务调度性能测试

实验设计需要关注Hadoop集群在数据处理和任务调度方面的表现。以下是实验设计的关键点:

- **MapReduce作业性能**:运行相同的数据集和相同的MapReduce作业,比较两个版本的执行时间。

- **资源利用率**:监控CPU、内存和磁盘IO的使用情况,分析资源管理的效率。

- **任务调度**:观察不同版本中YARN是如何调度任务的,包括作业启动时间和任务处理速度。

执行的MapReduce作业示例代码如下:

```java

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

}

```

### 4.2.2 存储性能与容错机制的比较

HDFS是Hadoop的核心存储系统,其性能直接影响整体集群的性能。在本实验中,我们将对HDFS的存储性能和容错机制进行测试。

- **写入性能**:测试在不同的数据集大小下,Hadoop 2.x与Hadoop 3.x的写入速度。

- **读取性能**:读取已存储的数据,比较Hadoop 2.x与Hadoop 3.x的读取速度和吞吐量。

- **容错能力**:模拟节点故障,测试Hadoop 2.x与Hadoop 3.x的容错恢复时间。

在HDFS测试中,可以使用Hadoop自带的`hadoop fs -put`命令来测试写入速度,使用`hadoop fs -get`命令来测试读取速度。

## 4.3 实验结果分析与结论

通过一系列精心设计的实验,我们可以收集到Hadoop 3.x和Hadoop 2.x在不同性能指标下的表现数据。

### 4.3.1 Hadoop 3.x在不同规模下的表现

根据实验结果,我们可以看到Hadoop 3.x在处理大规模数据集时表现如何。以下是可能的分析和结论:

- Hadoop 3.x能够更有效地利用硬件资源,特别是在大规模数据集处理时。

- 相比Hadoop 2.x,3.x在处理速度快和稳定性方面有显著提升。

通过以下mermaid流程图,可以表示Hadoop 3.x与2.x在不同规模数据集下处理流程的性能对比:

```mermaid

graph LR

A[开始实验] --> B[设置实验环境]

B --> C[执行基准测试]

C --> D[数据处理测试]

D --> E[任务调度测试]

E --> F[存储性能测试]

F --> G[容错机制测试]

G --> H[分析实验结果]

H --> |Hadoop 3.x表现更优| I[验证3.x的性能提升]

H --> |Hadoop 2.x表现更优| J[分析2.x优势]

I --> K[得出结论]

J --> K[得出结论]

```

### 4.3.2 Hadoop 3.x对业务性能的实际影响评估

最后,分析Hadoop 3.x在实际业务场景中的表现至关重要。以下是评估的几个方面:

- **成本效益分析**:Hadoop 3.x是否为业务带来了更高的成本效益?

- **业务流程优化**:Hadoop 3.x是否帮助优化了业务流程?

- **用户满意度**:业务用户对Hadoop 3.x的处理速度和稳定性是否满意?

对这些方面的分析,将有助于企业决定是否升级到Hadoop 3.x版本。表格形式的对比如下:

| 评估项目 | Hadoop 2.x的表现 | Hadoop 3.x的表现 | 改进点分析 |

|-----------------------|----------------|----------------|---------|

| 数据处理速度 | | | |

| 任务调度效率 | | | |

| 存储性能 | | | |

| 容错恢复时间 | | | |

| 用户满意度 | | | |

通过以上实验结果的分析和讨论,我们可以得出Hadoop 3.x相比2.x在性能上的确切改进,并根据具体业务需求和成本预算做出明智的决策。

# 5. Hadoop 3.x性能优化实战

## 5.1 针对Hadoop 3.x的性能优化策略

### 5.1.1 集群配置的最佳实践

配置Hadoop集群以实现最佳性能是优化过程中至关重要的一环。在Hadoop 3.x中,由于底层架构的改进,集群配置策略也随之变化。一些关键的配置项,如内存分配、CPU核心分配以及网络优化,都需要根据具体应用场景进行调整。例如,HDFS的块大小(dfs.block.size)配置参数直接影响到数据的读写效率,一般而言,大数据集处理时块大小应较大,以减少NameNode的元数据压力和提高数据传输效率。

### 5.1.2 作业调优技巧与监控指标

调优Hadoop作业运行时,需要关注几个关键的监控指标,包括但不限于任务执行时间、CPU和内存使用率、网络I/O以及磁盘I/O。使用YARN的Resource Manager Web UI可以实时查看资源的分配和使用情况,从而对作业进行针对性的调优。例如,如果发现资源利用率不高,则可以适当减少资源的预留量(yarn.nodemanager预留内存),或者提高资源的弹性分配。

## 5.2 实际案例分析

### 5.2.1 大型企业的数据仓库优化案例

大型企业在数据仓库的构建过程中,会面临大规模数据的存储和查询优化问题。Hadoop 3.x为这类企业提供了更多的优化手段。以某大型零售企业为例,他们将原有的数据仓库迁移到了基于Hadoop 3.x的架构中。通过调整HDFS的块大小和启用Erasure Coding,他们成功提升了数据存储的效率和可靠性。同时,通过配置合适的YARN资源调度策略,保证了关键的ETL作业能够获得足够的计算资源。

### 5.2.2 实时数据分析的性能调优实例

实时数据分析场景中,Hadoop 3.x通过引入更多的优化策略和工具,如Apache Tez或Apache Spark,可以实现亚秒级的数据处理和分析。例如,在金融市场的实时数据分析中,通过调整Spark作业的并行度(spark.default.parallelism)和内存管理策略(spark.executor.memory),可以极大提升数据处理的速度和系统稳定性。在某些场景下,通过将数据预先分区和缓存到内存中,可以显著降低数据访问延迟。

## 5.3 未来展望与技术趋势

### 5.3.1 云原生Hadoop的探索与挑战

云原生Hadoop是未来的方向之一,这意味着Hadoop将更好地与云基础设施集成,从而提供更加弹性的资源管理和调度能力。在云原生的环境中,Hadoop组件需要与容器化技术(如Kubernetes)和云存储服务(如Amazon S3)无缝集成。这一过程中,面临的挑战包括数据持久性、网络I/O优化以及多租户环境下的安全隔离。

### 5.3.2 Hadoop在AI和机器学习领域的应用前景

随着大数据和AI的结合日益紧密,Hadoop在机器学习和AI领域的应用前景也非常广阔。Hadoop的可扩展性和数据处理能力使其成为存储和预处理大规模数据集的理想平台。为了适应机器学习工作负载,Hadoop生态系统中的组件(如Hive、Pig)正不断优化,以支持更多复杂的数据分析任务。此外,Hadoop也在与深度学习框架(如TensorFlow和PyTorch)集成方面进行了探索,以简化模型训练和推理流程。

```markdown

| 组件 | 功能 | 优势 |

| --- | --- | --- |

| HDFS | 分布式存储 | 可靠性和扩展性 |

| YARN | 资源管理与作业调度 | 灵活性和资源优化 |

| Hive | 数据仓库工具 | SQL-like查询语言 |

| Spark | 实时数据处理 | 快速迭代和处理速度 |

```

- **表格说明:** 上表对比了Hadoop生态系统中几个核心组件的基本功能和优势。HDFS是数据存储的关键,YARN优化资源分配,Hive利用SQL-like语言处理大数据仓库任务,而Spark在实时数据处理上表现出色。

```mermaid

graph TD

A[数据源] -->|加载| B[HDFS]

B -->|存储| C[Hadoop集群]

C -->|处理| D[YARN]

D -->|资源管理| E[作业调度]

E -->|计算结果| F[用户界面]

```

- **mermaid流程图说明:** 从数据源到用户界面,Hadoop集群的数据处理和作业调度流程清晰展示。HDFS作为数据源的存储点,YARN的资源管理与作业调度协同工作,最终输出到用户界面。

# 6. 深入理解Hadoop生态系统

## 6.1 核心项目与外围组件

Hadoop生态系统是一系列开源软件项目的集合,它们协同工作,支持数据存储、处理和分析的各种需求。核心项目包括Hadoop自身以及HBase、ZooKeeper等。外围组件则包括用于数据集成和处理的工具,如Sqoop、Oozie等。

### 6.1.1 Hadoop生态系统全景图

生态系统的全景图展示了各个组件如何互相配合来实现大规模数据处理。从数据的导入导出、存储、计算,到资源管理和任务调度,以及集群的维护和安全机制,都有相应的组件对应。这个架构的灵活性和模块化设计使得企业可以根据自己的需求选择适合的工具。

### 6.1.2 数据集成与处理工具介绍

为了更好地理解Hadoop生态系统中的各个组件,我们有必要了解一些关键的数据集成和处理工具。例如,Sqoop能够高效地在Hadoop与传统关系数据库之间传输大量数据,而Oozie工作流调度器能够管理和执行Hadoop作业的复杂工作流。这些工具都是为了使得在Hadoop上运行数据处理任务更加简单和高效。

## 6.2 实时数据处理与分析

Hadoop被广泛用于批量数据处理,但随着技术的发展,实时数据处理和分析的需求日益增长。Hadoop生态系统通过引入一些新组件,如Apache Spark,来适应这种趋势。

### 6.2.1 Spark与Hadoop的融合

Apache Spark是一个快速、通用的计算引擎,它与Hadoop的融合给用户提供了更广泛的计算能力。Spark可以运行在Hadoop YARN上,共享HDFS存储资源,并且利用Hadoop的分布式存储优势。同时,Spark的内存计算能力使得它在处理速度上比传统的MapReduce有显著优势,特别是在需要迭代算法处理的场景下。

### 6.2.2 实时数据流处理框架Flume与Kafka

为了处理实时数据流,Hadoop生态系统引入了Flume和Kafka这样的工具。Flume是一个可靠、高可用的系统,用于有效地收集、聚合和移动大量日志数据。Kafka是一个分布式流媒体平台,它能以高吞吐量处理来自许多源的数据,并将其发布到多个消费者。这两个工具的引入让Hadoop有能力应对现代大数据处理中的实时性需求。

## 6.3 Hadoop在行业中的应用案例

Hadoop在多个行业中都有应用案例,其架构的灵活性使得它能够适用于多种业务场景。接下来,我们将探讨Hadoop在金融行业和互联网公司中的应用。

### 6.3.1 金融行业的数据处理应用

金融行业以其庞大的数据量和数据处理的实时性要求而闻名。Hadoop在金融行业的应用案例包括风险分析、欺诈检测、客户关系管理等。通过Hadoop,金融机构可以存储和分析历史和实时交易数据,从而更好地理解市场趋势,及时发现潜在的风险。

### 6.3.2 互联网公司的大数据分析实践

在互联网公司,Hadoop被用于用户行为分析、日志分析和推荐系统等。例如,一个社交媒体公司可能会使用Hadoop来分析用户生成的内容,以及用户的互动行为,用这些数据来改进算法和提供个性化的内容推荐。这些分析对于理解用户需求、提高用户体验至关重要。

## 代码块与示例

接下来是一个使用Hadoop进行MapReduce编程的基本代码示例。以下是一个简单的MapReduce程序,用于统计输入文本文件中每个单词出现的次数(Word Count)。

```java

public class WordCount {

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer

extends Reducer<Text,IntWritable,Text,IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

```

这个程序展示了如何通过定义Mapper和Reducer类来处理文本数据并计算单词出现次数。MapReduce模型保证了任务的可扩展性和容错性,这对于处理大规模数据集至关重要。

## 结论

Hadoop生态系统提供了从数据存储到实时处理的全面解决方案。它的组件化设计与高度可配置性允许不同规模的企业根据自己的需求定制大数据处理平台。随着实时处理需求的增加,Hadoop也在不断地进化,以适应现代数据处理的挑战。通过上述内容,我们可以看到Hadoop不仅是一个存储平台,也是一个强大的数据处理框架。在未来,我们可以预见Hadoop将在云计算、人工智能和机器学习等领域扮演更加重要的角色。

0

0