【Hive和Pig新纪元】:Hadoop 3.x带来的大数据分析工具变革

发布时间: 2024-10-27 21:28:00 阅读量: 45 订阅数: 49

Hadoop 2.x与3.x 22点比较,Hadoop 3.x比2.x的改进

# 1. Hadoop 3.x的架构与新特性

## Hadoop 3.x 架构概述

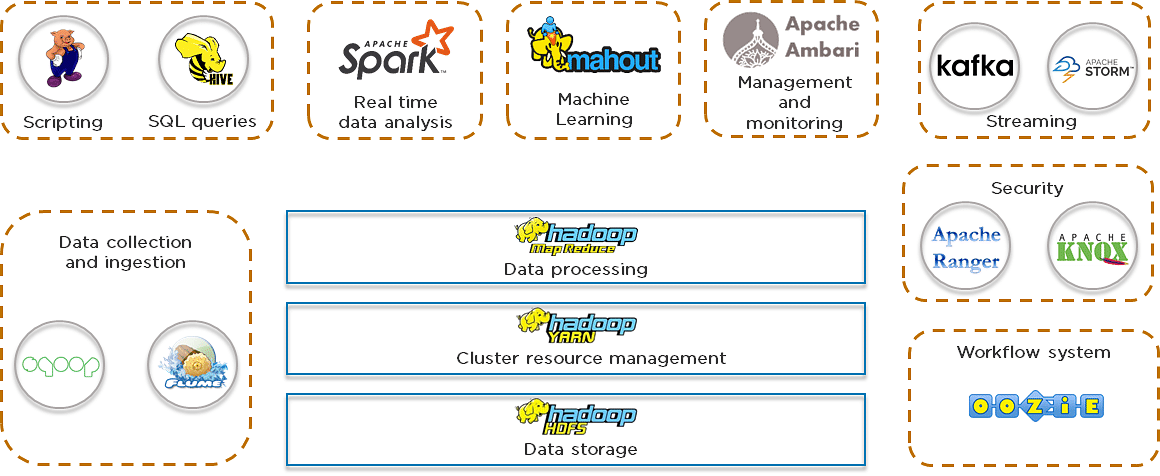

Hadoop 3.x 引入了多项架构改进,包括对大规模存储和计算能力的优化,以及高可用性和容错性的增强。它的核心组件包括HDFS、YARN和MapReduce,它们共同协作以支持大数据处理任务。HDFS(Hadoop Distributed File System)提供了高吞吐量的数据访问,YARN(Yet Another Resource Negotiator)负责资源管理和任务调度,而MapReduce则处理数据的分布式计算。

## 新特性与增强功能

Hadoop 3.x 带来了诸多新特性和性能改进。例如,它支持了更高容量的集群,通过引入HDFS联邦和Erasure Coding技术增强了数据的可靠性和存储效率。此外,引入了Kerberos基于角色的访问控制,进一步增强了系统的安全性。YARN上,改进了对GPU和其他异构资源的支持,这对于机器学习和深度学习应用来说非常重要。

## 对Hive和Pig的影响

随着Hadoop 3.x 的推出,Hive和Pig这样的大数据分析工具也得到了相应的升级。Hive 3.x 增加了对Hadoop 3.x 新特性的支持,比如对ACID事务的改进,从而能够更好地支持数据仓库的需求。而Pig则增强了对YARN的支持,使得在新版本Hadoop上进行数据流处理更为高效。这些改进对于IT专业人士而言,意味着他们在构建和维护大数据系统时将拥有更强大的工具和更大的灵活性。

# 2. Hive的进阶分析技术

## 2.1 Hive内部架构详解

### 2.1.1 Hive组件的构成与功能

Hive的核心由以下几个组件构成:Metastore、Driver、Compiler、Execution Engine和HDFS。这些组件协调工作,为用户提供了一种类SQL语言来查询存储在Hadoop文件系统中的大规模数据集。

- **Metastore** 是 Hive 的元数据仓库,负责存储表结构信息如表名、字段类型、数据位置等。它是一个关系型数据库,常用的后端存储系统有MySQL、Derby等。

- **Driver** 分为编译器和执行器。编译器将 HiveQL 语句转换成一系列的 MR/Tez/Sparke任务,而执行器负责协调这些任务的执行。

- **Compiler** 接收查询语句并生成逻辑执行计划,然后将逻辑执行计划转化为物理执行计划。它包含了两个阶段:词法分析和语法分析。

- **Execution Engine** 负责执行物理执行计划,将一个大的任务拆分成多个可以并行执行的小任务。

- **HDFS** 存储实际的数据文件,与Hadoop的集成让Hive可以处理存储在HDFS上的海量数据。

### 2.1.2 Hive与Hadoop生态的集成

Hive 集成到 Hadoop 生态系统中,利用了 Hadoop 的 MapReduce 引擎来处理数据。它将用户的 HiveQL 查询转换为 MapReduce 作业执行。这不仅允许了对大量数据的高效处理,而且还能借助 Hadoop 生态中的其他工具,比如 ZooKeeper、HBase 等。此外,Hive 也支持使用 Tez 或 Spark 引擎来加速数据处理。

## 2.2 Hive SQL优化技术

### 2.2.1 查询优化基础

Hive SQL 的查询优化通常涉及以下策略:

- **过滤器下推**:尽可能在数据读取之前进行过滤,减少数据量。

- **分区**:合理设置表分区,可以让查询时只扫描需要的分区,大大减少数据扫描量。

- **选择合适的存储格式**:比如 ORC 格式相比其他格式有较好的压缩比和读写性能。

- **使用合适的Join策略**:比如 Broadcast Join、Map Join 或者在Map端执行的Join等。

### 2.2.2 高级查询优化策略

在更复杂的查询中,我们可以使用更高级的优化策略:

- **子查询优化**:将子查询改写成 Join 操作,往往能获得更好的性能。

- **使用索引**:Hive 支持索引,合理利用索引可以加快数据检索速度。

- **参数调优**:调整执行计划中的参数,比如 `mapred.reduce.tasks`,可以优化任务执行。

## 2.3 实践Hive数据仓库建设

### 2.3.1 构建高效数据仓库流程

构建高效的数据仓库流程包括几个关键步骤:

1. **需求分析**:了解数据仓库需要解决的业务问题,明确数据仓库的目标。

2. **数据模型设计**:创建星型模型或雪花模型,设计维度表和事实表。

3. **ETL过程**:构建数据抽取、清洗和加载过程。

4. **数据优化存储**:选择合适的数据文件格式和存储方案,如分区、桶化等。

5. **查询优化**:根据查询模式调整表结构和索引。

6. **监控与维护**:定期检查性能瓶颈,进行数据归档和索引重建。

### 2.3.2 数据仓库案例分析

在某电商公司的数据仓库建设中,我们通过使用Hive构建了一个数据仓库来支持各种商业智能(BI)需求。以下是一些优化策略的实现:

- **分区策略**:按日期和区域对订单数据进行分区,使得查询时可以只扫描相关的分区。

- **存储格式**:将日志文件存储为ORC格式,以加快查询速度。

- **索引优化**:针对查询中经常作为过滤条件的字段,建立Bloom Filter索引,减少数据扫描量。

- **查询优化**:重写一些复杂查询,将子查询转化为Join操作,提高查询效率。

```sql

-- 示例:创建一个分区表

CREATE TABLE orders (

order_id INT,

customer_id STRING,

order_date STRING,

total_price DOUBLE

)

PARTITIONED BY (year INT, month INT, day INT)

STORED AS ORC;

```

在案例中,对性能的分析和调优一直是一个持续的过程,针对实际的查询负载和数据集特点不断进行调整和优化。

以上各节所述的内容,都是为了展示Hive在数据仓库建设中的高级分析技术,以及在实际操作中如何应用这些技术来达到优化性能的目的。

# 3. Pig的数据流处理机制

在现代的大数据处理框架中,Pig扮演着至关重要的角色。作为一种高级的数据流语言和执行框架,Pig允许用户进行复杂的数据转换和分析,而无需编写复杂且易错的Java代码。Pig Latin是其核心语言,提供了丰富的操作符和功能,使得处理大规模数据集变得更加灵活和高效。本章节将深入探讨Pig的数据流处理机制,从基本语法到复杂转换技巧,再到与其他Hadoop组件的协同作业。

## 3.1 Pig Latin语言解析

### 3.1.1 Pig Latin的核心语法

Pig Latin的设计目的是简化MapReduce编程模型,提供一种更加高层的数据处理语言。Pig Latin不是一种通用编程语言,而是一种数据流语言,专门用于数据分析任务。

Pig Latin的主要数据结构是关系,可以认为是一种表格数据。关系中的每一列是数据类型,而每一行则包含一个记录的所有字段值。Pig Latin的基本操作符包括加载数据、数据转换和数据存储等。

```pig

-- 示例Pig Latin脚本

A = LOAD 'input.txt' AS (f1: chararray, f2: int, f3: double);

B = FILTER A BY f2 > 20;

C = FOREACH B GENERATE f1, (f2 * 0.01) AS f2;

STORE C INTO 'output.txt';

```

以上脚本中,首先加载一个文本文件`input.txt`作为关系`A`,然后筛选出`f2`字段值大于20的记录形成新关系`B`,之后对关系`B`进行转换,计算新字段并存储输出到`output.txt`。

### 3.1.2 Pig脚本的编写和调试

Pig脚本的编写通常在Pig命令行接口(CLI)上进行,它提供了即时的反馈,使得调试和运行Pig脚本变得更加容易。用户可以在命令行中逐行执行Pig Latin语句,也可以编写完整的脚本文件后在CLI中执行。

Pig Latin提供了多种命令用于查看数据集的部分内容或统计信息,这对于调试Pig脚本非常有帮助。

```pig

-- 查看关系A的前5条记录

DUMP A;

-- 查看关系A的详细统计信息

DESCRIBE A;

```

## 3.2 Pig在数据转换中的应用

### 3.2.1 数据过滤与转换技巧

Pig Latin提供了强大的

0

0