【集群安全革新】:Hadoop 3.x中的Kerberos安全机制如何提升集群防护

发布时间: 2024-10-27 21:21:51 阅读量: 36 订阅数: 22

# 1. Hadoop集群安全的重要性

随着大数据技术的发展,企业越来越多地依赖于Hadoop集群来处理和存储大量的数据。然而,随着数据量的增长和集群规模的扩大,其安全管理也变得尤为重要。本章将探讨为什么Hadoop集群的安全性如此重要,以及安全管理对于保护企业数据资产和防止数据泄露的必要性。

## 1.1 数据安全的挑战

在分布式环境中,数据的存储和处理面临着多方面的安全威胁,包括但不限于未经授权的数据访问、数据篡改和数据泄露。对于Hadoop这样的分布式系统来说,攻击者可能利用集群中的一个薄弱环节来获取整个系统的访问权限。

## 1.2 企业数据资产保护

保护企业的数据资产是每个IT部门的首要任务之一。Hadoop集群包含敏感数据,如客户信息、财务记录等,这些都需要被安全地处理和保护。通过实施强有力的安全措施,可以降低数据泄露的风险,维护企业的信誉和合规性。

## 1.3 遵守法规和标准

随着数据保护法规的实施,如欧盟的通用数据保护条例(GDPR)和其他地区的类似法规,企业必须确保他们的数据处理过程符合这些法规的要求。因此,Hadoop集群的安全措施对于确保企业遵守这些法律标准至关重要。

Hadoop集群的安全性不仅关乎于技术层面的实施,也与企业整体战略紧密相关。在接下来的章节中,我们将进一步探讨如何利用Kerberos认证机制来加强Hadoop集群的安全防护。

# 2. Kerberos认证机制概述

### 2.1 Kerberos基础理论

#### 2.1.1 Kerberos协议的工作原理

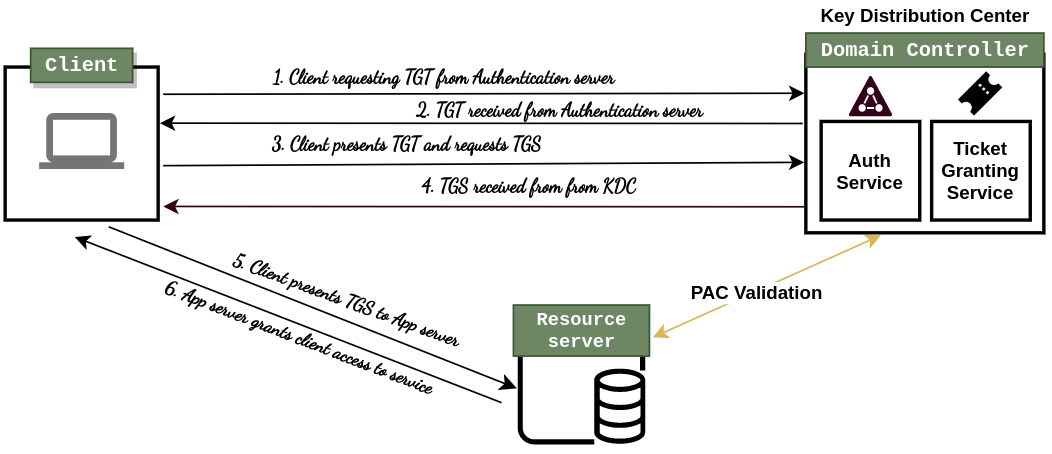

Kerberos是一种网络认证协议,它允许节点之间以安全的方式进行通信。在Kerberos体系中,所有通信活动都必须先通过一个中心认证服务器(通常称为KDC,Key Distribution Center)进行身份验证。协议的核心工作原理包括以下几个步骤:

1. **请求认证票据(Ticket-Granting Ticket,TGT)**:用户(客户端)向KDC发送一个认证请求,包括自己的身份标识,KDC验证用户的身份后,会发放一个TGT,这个票据包含了一个可以在票据授权服务器(Ticket-Granting Service,TGS)请求服务的会话密钥。

2. **服务票据请求**:用户携带TGT去访问特定服务(例如HDFS NameNode)。首先,用户需要向TGS发送一个服务票据请求,包括自己的TGT和请求访问服务的标识。

3. **服务票据的授权与发放**:TGS验证TGT的有效性后,会发放一个服务票据给用户。该服务票据仅对特定服务有效,并包含一个可以用于与服务端通信的会话密钥。

4. **服务访问**:用户获得服务票据后,将它发送给服务端。服务端验证服务票据的有效性,然后用其中的会话密钥与用户通信。

#### 2.1.2 Kerberos的关键组件和术语

- **KDC(Key Distribution Center)**:Kerberos系统中负责发放票据和会话密钥的中心认证服务器。

- **AS(Authentication Server)**:KDC中的一个组件,用于初次认证用户,发放TGT。

- **TGS(Ticket-Granting Server)**:KDC中的另一个组件,用于基于TGT发放服务票据。

- **Client**:请求服务的用户或应用。

- **Server**:提供服务的实体。

- **Ticket**:包含加密后的身份信息和会话密钥,用于证明身份和认证服务请求。

- **Session Key**:用于用户和服务端通信过程中的临时密钥。

- **Realm**:Kerberos认证域,一个管理域内的用户和服务。

### 2.2 Hadoop与Kerberos的结合

#### 2.2.1 Hadoop安全架构简介

Hadoop设计了一个安全框架,用来提供跨集群的安全通信。加入Kerberos认证机制的Hadoop集群,能够实现对用户和服务之间交互的安全性提升。Hadoop的安全架构主要包含以下几个方面:

- **Kerberos认证**:在用户和服务之间进行身份验证,确保交互双方的身份可信。

- **服务间通信加密**:通过Kerberos提供的会话密钥对服务间通信进行加密,保护数据传输过程的安全。

- **授权机制**:基于角色的访问控制(RBAC),限制用户对资源的访问权限。

- **审计功能**:记录安全相关的操作,用于事后分析和审计追踪。

#### 2.2.2 Kerberos在Hadoop中的应用

在Hadoop集群中,Kerberos被应用来对不同组件进行认证。Hadoop的主要组件,如NameNode、DataNode、ResourceManager以及历史服务器等,都需要与Kerberos集成,以确保安全通信。当一个用户尝试访问HDFS数据或者提交YARN任务时,系统会要求用户首先通过Kerberos认证,并且获取相应的票据。这样,集群中的各个组件能够相互验证彼此的身份,防止未授权访问。

### 第三章:Kerberos安全机制在Hadoop 3.x中的实现

#### 3.1 Hadoop 3.x集群安装与Kerberos集成

##### 3.1.1 安装前的准备工作

在安装Hadoop之前,首先要安装和配置Kerberos服务。这包括设置KDC服务器,配置Kerberos数据库,以及安装和配置必要的Kerberos客户端。这个阶段需要考虑的几个关键点如下:

- **选择Kerberos版本**:确认要安装的Kerberos版本,以及操作系统对它的支持。

- **安装Kerberos软件包**:在服务器上安装Kerberos,并确保所有必需的依赖项都已安装。

- **配置域名和主机**:确保集群中所有节点的主机名和域名设置正确,以避免认证过程中出现问题。

##### 3.1.2 配置Kerberos服务

安装完成后,需要对Kerberos进行详细配置。这涉及编辑Kerberos配置文件(例如krb5.conf),设置KDC和管理员服务等关键参数。

- **配置krb5.conf文件**:设定KDC服务器地址、认证域和加密类型等信息。

- **建立Kerberos数据库**:创建Kerberos数据库,这个数据库包含所有主体(用户和服务)的信息。

- **设置KDC服务**:包括AS服务和TGS服务的配置,确保服务能正常运行。

##### 3.1.3 配置Hadoop集群以使用Kerberos

配置Hadoop集群与Kerberos集成,意味着要修改Hadoop配置文件,指定Kerberos认证的参数,包括Kerberos主体、密钥表文件等。这包括但不限于以下配置项:

- **配置core-site.xml**:设定Hadoop集群所依赖的Kerberos参数,例如认证方式、密钥表文件路径等。

- **配置hdfs-site.xml和yarn-site.xml**:为HDFS和YARN指定Kerberos主体和密钥表。

- **配置mapred-site.xml**:对于MapReduce作业来说,设置相关的Kerberos参数。

#### 3.2 集群组件的Kerberos配置

##### 3.2.1 NameNode和DataNode的安全设置

NameNode作为Hadoop文件系统的元数据管理器,以及DataNode作为存储数据块的服务器,都需要严格的认证和授权机制来保障集群的安全。

- **NameNode的Kerberos配置**:设置NameNode的Kerberos主体,并配置其访问控制策略,确保仅授权用户可以操作文件系统的元数据。

- **DataNode的Kerberos配置**:配置DataNode的Kerberos主体和认证机制,保护数据块的安全存储。

##### 3.2.2 资源管理器的安全配置

YARN的ResourceManager负责资源管理和任务调度,其安全配置对于整个集群至关重要。

- **ResourceManager的Kerberos认证**:为ResourceManager设置Kerberos主体,并通过Kerberos密钥表文件进行认证。

- **Kerberos与YARN队列的集成**:确保Kerberos的用户和组映射与YARN的队列权限设置一致,实现资源的按权限分配。

##### 3.2.3 任务历史服务器及其他服务的认证设置

任务历史服务器和其他服务,如Hue、Hive等,同样需要通过Kerberos进行安全认证,以确保集群的整体安全。

- **任务历史服务器的Kerberos配置**:配置任务历史服务器,使得只有通过Kerberos认证的用户可以访问执行过的任务历史。

- **其他服务的认证**:例如,为Hue配置Kerberos主体,并确保其服务能够通过Kerberos进行安全通信。

##### 3.3.1 NameNode和DataNode的Kerberos配置代码示例

```xml

<configuration>

<!-- Kerberos configuration for Hadoop NameNode -->

<property>

<name>dfs.namenode.kerberos.principal</name>

<value>nn/_HOST@REALM</value>

</property>

<property>

<name>dfs.namenode.keytab.file</name

```

0

0