数据表示与转换:二进制与十六进制之间的魔法

发布时间: 2024-11-15 03:46:06 阅读量: 5 订阅数: 10

# 1. 数据表示与转换基础

在现代计算机科学中,数据的表示与转换是基础且关键的技术。几乎所有的数据处理,从编程到存储,再到网络通信,都离不开对数据进行适当的表示和转换。在本章中,我们将从宏观角度引入数据表示的基本概念,探索不同类型数据表示之间的转换方法,并聚焦于二进制与十六进制转换技巧的基础知识。

首先,我们将分析为什么二进制在计算机中占据主导地位,以及十六进制如何成为二进制的一种便捷替代表示法。了解这些基础知识将有助于我们更高效地处理数据,并为深入理解后续章节打下坚实的基础。在此过程中,我们将涉及到一些核心问题:数据是如何在计算机中被存储和处理的?二进制和十六进制转换在实际应用中扮演着怎样的角色?

随后,我们将详细探讨二进制和十六进制表示法的基本概念、构成以及它们之间的转换方法。这些内容对于理解和掌握数据在计算机系统中流动的方式至关重要。

在进入更深入的章节之前,确保我们已经掌握以下概念:

- 二进制表示法的基础知识和应用。

- 十六进制表示法的优势和应用场景。

- 二进制与十六进制数据之间的转换技术。

# 2. 深入理解二进制系统

## 2.1 二进制的基本原理与构成

### 2.1.1 二进制数字系统的特点

二进制数字系统是计算机科学的基础,它以2为基数,仅使用两个数码:0和1。这种数字系统与人类日常使用的十进制系统不同,它的特点包括:

1. **简化性**:二进制的运算规则远比十进制简单,因为只有两个数码,加法和乘法运算可以仅通过考虑0和1的情况来完成。

2. **逻辑性**:二进制与数字逻辑电路紧密相关,为计算机硬件设计提供了基础。

3. **可靠性**:电子设备通过电压的高低来表示二进制的1和0,这种物理表达方式容易区分,降低了信息传递的错误率。

### 2.1.2 二进制数的表示方法

在计算机科学中,二进制数的表示方法遵循固定的规则,每个位置上的数值称为“位”(bit),代表2的幂次方。例如,二进制数`1011`可以表示为:

```

1 * 2^3 + 0 * 2^2 + 1 * 2^1 + 1 * 2^0 = 8 + 0 + 2 + 1 = 11

```

这说明在二进制中,位的权值从右向左依次增加,最右边的位权值为2的0次方。

### 2.1.3 二进制的位运算

二进制的位运算包括四种基本操作:

1. **与运算(AND)**:两个位都为1时结果为1,否则为0。

2. **或运算(OR)**:两个位中至少有一个为1时结果为1,都为0时结果为0。

3. **非运算(NOT)**:通常表示为一个位的取反操作。

4. **异或运算(XOR)**:两个位不同时结果为1,相同时结果为0。

这些位运算在计算机的算术逻辑单元(ALU)中是基本操作,对于数据处理和硬件控制都至关重要。

## 2.2 十六进制的概念与优势

### 2.2.1 十六进制数系统的构成

十六进制数系统是一种逢十六进一的计数系统,使用的数码是0到9加上A到F,其中A到F代表十进制的10到15。它之所以在计算机科学中广泛应用,是因为:

1. **紧凑性**:一个十六进制的数字可以表示四位二进制数,极大地简化了数据的表示。

2. **易于识别**:十六进制数字的表示更加简洁,便于开发者阅读和处理。

3. **内存地址**:在很多架构中,内存地址和数据经常使用十六进制表示,便于硬件和软件的接口。

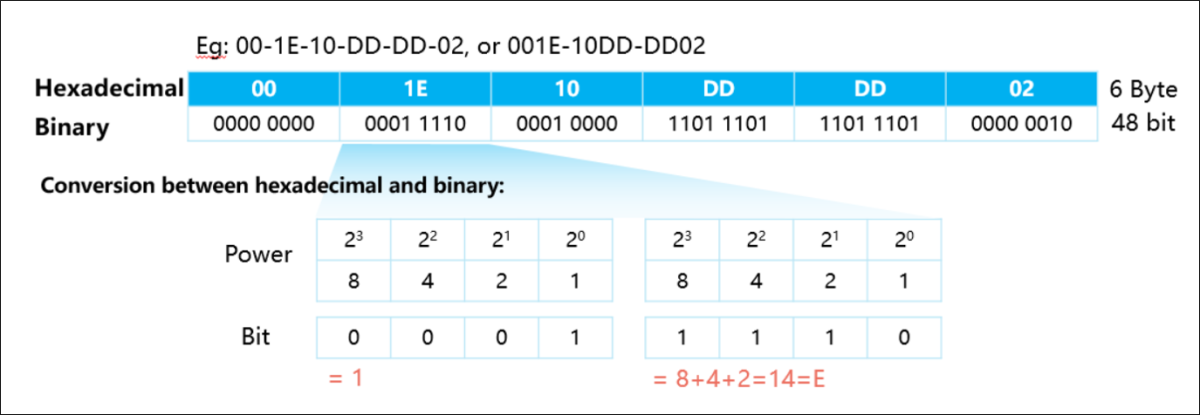

### 2.2.2 二进制与十六进制的相互转换

要将二进制数转换为十六进制数,可以将二进制数从右到左每四位一组进行分割,然后将每组转换为对应的十六进制数字。同样,十六进制到二进制的转换则相反,将每个十六进制数字转换为四位二进制数。

### 2.2.3 十六进制的应用场景分析

在计算机系统中,十六进制广泛应用于以下领域:

1. **内存表示**:内存地址和数据常以十六进制形式显示,便于快速识别。

2. **文件编辑**:在查看和编辑二进制文件时,十六进制提供了一个方便的视图。

3. **调试工具**:十六进制常用于编程调试,方便程序员定位问题。

4. **通信协议**:在一些网络通信协议中,数据的十六进制表示是标准格式。

### 2.2.4 转换程序的优化与错误处理

在实际编写转换程序时,需要注意的优化和错误处理包括:

- **错误检查**:在输入不是有效的二进制或十六进制时,程序应该能够检测错误并提供清晰的反馈。

- **性能优化**:在转换大量数据时,应该考虑算法的效率,减少不必要的计算。

- **用户体验**:提供友好的用户界面,帮助用户快速完成转换操作。

### 2.2.5 实际案例演练

例如,将二进制数`***`转换为十六进制:

```

二进制: ***

十六进制: B 7

```

因此,二进制数`***`转换为十六进制是`B7`。

### 2.2.6 编写自定义转换程序

编写自定义转换程序可以帮助深入理解二进制和十六进制之间的关系。以下是使用Python语言编写的转换函数示例:

```python

def binary_to_hex(binary_str):

# 将二进制字符串转换为整数,然后转换为十六进制字符串并去掉前缀'0x'

return hex(int(binary_str, 2))[2:].upper()

def hex_to_binary(hex_str):

# 将十六进制字符串转换为整数,然后转换为二进制字符串并去掉前缀'0b'

return bin(int(hex_str, 16))[2:]

# 示例使用

binary_number = '***'

hex_number = binary_to_hex(binary_number) # 输出: 'B7'

binary_from_hex = hex_to_binary(hex_number) # 输出: '***'

```

通过编写和使用这样的程序,不仅可以加深对二进制和十六进制之间转换逻辑的理解,还能提高处理这类问题的编程技能。

通过本章节的介绍,我们理解了二进制和十六进制的原理及其在计算机科学中的基础性作用。在后续章节中,我们将进一步探讨这些概念在实际中的应用,以及它们在高级计算机科学领域中的关键角色。

# 3. 二进制与十六进制的转换技巧

### 3.1 手动转换的方法与实践

#### 3.1.1 理解转换的原理

手动转换二进制与十六进制是一个基本但重要的技能,它可以帮助我们更好地理解计算机内部数据的表示方式。转换的原理基于数学的进位制。二进制是基数为2的数制,每位二进制数可以表示0或1,而十六进制是基数为16的数制,每位可以表示0到F(在十进制中为0到15)。由于2的4次方等于16,一个十六进制的数字可以精确地表示为4位二进制数。因此,转换通常涉及将每个十六进制数位替换为对应的4位二进制数,反之亦然。

#### 3.1.2 分组与权重的应用

为了简化手动转换过程,我们可以采用分组与权重的方法。在将二进制转换为十六进制时,我们从二进制数的最低位(右边)开始,每4位一组进行分组。如果最高位的组不足4位,则在前面补0至4位。然后,将每组二进制数转换成对应的十六进制数。在将十六进制转换为二进制时,过程是相反的:每个十六进制数位转换成相应的4位二进制数。

#### 3.1.3 实际案例演练

假设我们要将二进制数 `***` 转换为十六进制数。我们首先进行分组:

```

分组:***

补0: ***

```

接着,将每组转换成对应的十六进制数:

- `0010` -> 2

- `1101` -> D

- `1111` -> F

所以,`***` 二进制数对应的十六进制数是 `2DF`。

### 3.2 利用编程工具进行转换

#### 3.2.1 常用编程语言中的转换函数

大多数编程语言都提供了内置函数来处理二进制和十六进制之间的转换。例如,在Python中,可以使用内置函数`bin()`和`hex()`来完成转换,或者使用格式化字符串`'{:b}'`和`'{:x}'`。在JavaScript中,则可以使用`parseInt()`函数或`Number`对象的`toString()`方法来进行转换。

```python

# Python示例

binary_num = '***'

hex_num = hex(int(binary_num, 2))

print(hex_num) # 输出: 0x2df

```

#### 3.2.2 编写自定义转换程序

对于不提供内置转换函数的编程语言,或者为了加深理解,我们可以编写自己的转换程序。以下是一个简单的Python函数,用于将二进制字符串转换为十六进制:

```python

def binary_to_hex(binary_string):

binary_int = int(binary_string, 2)

hex_string = hex(binary_int)[2:] # 移除前缀 '0x'

return hex_string.upper()

binary_num = '***'

print(binary_to_hex(binary_num)) # 输出: '2DF'

```

#### 3.2.3 转换程序的优化与错误处理

在编写转换程序时,要考虑到各种边界情况和异常处理。例如,输入的二进制字符串可能包含非二进制字符,或者在转换为十六进制时长度超过了限制。以下是优化后的函数,它添加了输入验证和适当的错误处理:

```python

def binary_to_hex_optimized(binary_string):

if not all(bit in '01' for bit in binary_string):

raise ValueError("输入包含非二进制字符。")

try:

binary_int = int(binary_string, 2)

hex_string = hex(binary_int)[2:].upper()

except ValueError:

raise ValueError("二进制字符串无法转换为整数。")

return hex_string

binary_num = '***'

try:

print(binary_to_hex_optimized(binary_num)) # 输出: '2DF'

except ValueError as e:

print(e)

```

在以上示例中,我们首先检查了输入的字符串是否只包含二进制数字(0或1),然后尝试将其转换为整数,并捕获可能出现的转换错误。如果一切正常,我们将整数转换为十六进制字符串,并移除十六进制数前缀`'0x'`,最后将结果转换为大写形式返回。

通过这些方法,我们可以有效地实现二进制与十六进制之间的转换,并处理可能出现的异常情况,确保程序的健壮性。

# 4. 二进制与十六进制在计算机科学中的应用

## 4.1 计算机内存和存储

### 4.1.1 内存地址与数据的二进制表示

在计算机内存中,每一个存储位置都可以用一个唯一的地址来标识,这些地址在底层实际上是用二进制来表示的。由于二进制简洁且适合电子电路的实现,它成为了内存地址表示的不二之选。内存地址的二进制表示简化了硬件设计,因为它减少了必须处理的状态数量,从硬件的角度来看,二进制状态的“开”或“关”比多状态值更容易实现和检测。

内存地址的二进制表示也直接影响了数据的存储。每条数据通常以字节为单位存储,每个字节由8个比特组成,而比特就是二进制数字系统中的基本单位。例如,一个32位的内存地址可以表示为32位的二进制数,范围从***到***。在实际的硬件实现中,这些二进制位通常由一系列触发器或静态随机存取存储器(SRAM)单元来存储。

### 4.1.2 文件存储中的十六进制编码

在文件存储中,数据以字节序列的形式保存在硬盘或其他存储介质上。由于存储设备是二进制的,直接存储和读取二进制数据是非常高效的。然而,人们往往需要一种更易于理解的方式来查看和处理这些二进制数据,这时十六进制编码就派上了用场。

十六进制编码提供了一种紧凑的表示方式,它可以将每四个二进制位组合成一个十六进制数字。例如,二进制的***可以表示为十六进制的DB。这使得大段的二进制数据可以更容易地以十六进制的形式读取和编辑,比如在调试程序或进行数据恢复时。许多文件编辑器和十六进制编辑器都允许用户在十六进制和原始二进制数据之间进行切换。

### 4.1.3 实际案例演练

假设我们需要在文件中定位特定的数据,比如一个游戏的作弊码。这些数据可能以二进制形式分散在文件中,但用十六进制表示时更容易找到。通过十六进制编辑器,我们可以快速浏览文件内容,查找表示作弊码的特定十六进制序列。

使用十六进制编辑器的步骤如下:

1. 打开十六进制编辑器(如Hex Workshop或HxD)。

2. 选择要编辑的文件。

3. 查看文件内容的十六进制表示。

4. 使用查找功能搜索特定的十六进制序列。

5. 当定位到该序列时,确认它是否为目标数据。

## 4.2 计算机网络与通信

### 4.2.1 网络数据包的二进制与十六进制表示

在计算机网络中,所有传输的数据都是以二进制形式打包的,这些数据包包含控制信息和实际数据内容。数据包头通常包含许多关于如何处理数据包的信息,如源地址、目的地址、传输协议类型等,这些信息都是以二进制形式存在的。网络工程师在调试时会查看这些二进制数据包,这通常通过网络嗅探器(如Wireshark)完成。

使用Wireshark查看二进制数据包的步骤如下:

1. 安装并打开Wireshark。

2. 选择要监控的网络接口。

3. 开始捕获数据包。

4. 查看捕获的数据包列表,挑选感兴趣的包进行详细分析。

5. 在数据包的详细信息视图中,可以查看到以十六进制和ASCII两种格式的数据。

### 4.2.2 编码转换在通信协议中的作用

在通信协议中,编码转换有助于确保数据的正确传输和解释。例如,在Internet Protocol (IP)中,端口号等信息以二进制形式存在,而在传输层协议如TCP和UDP中,端口号用于区分不同的数据流。在一些应用场景中,十六进制数可能用作辅助手段,以便于工程师进行调试和问题诊断。

编码转换在通信协议中的一个实际应用是将IP地址从点分十进制转换为二进制形式,因为在网络硬件层面,IP地址必须以二进制形式处理。点分十进制地址是为了人类可读性而设计的,而计算机网络设备则需要使用二进制来处理这些地址。

## 4.3 加密与安全性

### 4.3.1 密码学中的二进制与十六进制编码

在密码学中,二进制和十六进制编码被广泛用于加密算法的内部实现。许多加密算法,如AES(高级加密标准),直接在二进制数据上操作。十六进制在此处作为一个中间表示形式,允许开发者和安全分析师更容易地查看和调试加密过程中的数据。

例如,在加密过程中,一个十六进制的密钥可能看起来像这样:4D6F***C6C6572。密钥本身是二进制数据,但使用十六进制可以更直观地管理。十六进制表示方式在密钥交换和管理、算法调试等环节中具有关键作用。

### 4.3.2 加密算法的二进制实现

加密算法的二进制实现涉及到复杂的数学运算,这些运算被直接映射到计算机的机器码指令中。这确保了加密和解密过程在硬件级别上的高效执行。例如,一个加密函数可能使用一系列的位运算,如异或(XOR)、与(AND)、或(OR)以及非(NOT)等来处理数据。

加密算法在二进制层面的实现通常涉及底层语言,如C或汇编语言,因为这些语言提供了更接近硬件的控制能力。在这些语言中,开发者可以使用位移、位字段和其他低级操作来精确地构建算法。代码块的例子可能包括:

```c

uint8_t xor_encrypt(uint8_t data, uint8_t key) {

return data ^ key;

}

```

在这个例子中,`xor_encrypt`函数使用异或操作符来对数据和密钥进行加密。异或操作是一个典型的位运算,它在加密算法中非常重要。每行代码后面应有详细解释说明。

### 4.3.3 实际应用案例

在现代安全系统中,二进制与十六进制编码在加密算法的应用非常广泛。例如,一个实际的应用场景可能是数字签名,它保证了数据的完整性和发送者的身份验证。数字签名的生成和验证涉及到复杂的加密算法,而这些算法都需要在二进制层面上精确执行。

数字签名生成步骤示例:

1. 选择一个散列函数(如SHA-256)来生成数据的哈希值。

2. 使用私钥对该散列值进行加密生成签名。

3. 将签名附加到原始数据上进行传输。

该过程中,二进制编码用于表示加密密钥和散列值,而十六进制编码则用于在用户界面上显示这些值,方便开发者进行调试和问题解决。

在第四章的每个小节中,都涉及了二进制和十六进制的实际应用,从内存存储到网络通信,再到加密和安全性领域。这些应用案例展示了二进制和十六进制编码在计算机科学中不可替代的角色,同时也揭示了它们在各种IT相关任务中的实际操作和分析技巧。

# 5. 二进制与十六进制的实际案例分析

## 5.1 二进制与十六进制在编程中的应用

### 5.1.1 编程语言中的二进制与十六进制处理

在编程实践中,二进制和十六进制是频繁出现的。尤其是在底层语言如C或C++中,处理二进制数据和十六进制格式是一种常见的需求。例如,处理文件I/O时,经常需要对数据进行二进制读写操作。许多高级语言如Python提供了内置的库来帮助处理这些转换。

以Python为例,`bin()` 和 `hex()` 函数可以将整数转换为二进制和十六进制字符串。逆操作可以使用 `int()` 函数实现,指定转换的基数。在C++中,使用位操作符如 `<<` (左移)和 `>>` (右移)可以实现二进制数据的处理。而 `std::stringstream` 和 `std::hex`、`std::dec` 可以用于十六进制的输入输出操作。

### 5.1.2 案例分析:编程实战中的转换应用

假设我们有以下场景:一个需要将十进制数字转换为十六进制字符串并打印的简单C++程序:

```cpp

#include <iostream>

#include <bitset>

#include <sstream>

std::string decToHex(int decimal) {

std::stringstream ss;

ss << std::hex << decimal;

return ss.str();

}

int main() {

int number = 123456;

std::cout << "The decimal number " << number;

std::cout << " as a hexadecimal string is " << decToHex(number) << std::endl;

return 0;

}

```

在这个例子中,我们定义了一个函数 `decToHex`,它接受一个整数,使用 `std::stringstream` 和 `std::hex` 将其转换为十六进制字符串。在 `main` 函数中,我们调用 `decToHex` 并打印结果。

**代码逻辑解读:**

1. 包含头文件 `<iostream>`、`<bitset>` 和 `<sstream>`。

2. 定义函数 `decToHex`,它接受一个 `int` 类型的参数。

3. 在函数内部,创建了一个 `std::stringstream` 类型的变量 `ss`。

4. 将 `ss` 的格式化标志设置为十六进制,这是通过 `std::hex` 实现的。

5. 把十进制整数 `decimal` 输入到 `ss` 中。

6. 将 `ss` 中的流内容转换为字符串并返回。

7. 在 `main` 函数中,声明了一个整数变量 `number` 并赋予了一个十进制值。

8. 打印原始十进制数值。

9. 调用 `decToHex` 函数,并将返回的十六进制字符串打印出来。

## 5.2 二进制与十六进制在硬件领域的运用

### 5.2.1 硬件设计中的二进制逻辑

硬件设计中,二进制逻辑是最基本的构建块。现代电子系统设计,无论是微处理器、数字逻辑电路还是存储器设备,都依赖于二进制逻辑的精确实现。二进制逻辑门如AND、OR、NOT等,是构成复杂硬件设备的基本单元。在FPGA和ASIC设计中,逻辑门通过硬件描述语言如VHDL或Verilog实现。

下面是一个简单的Verilog代码示例,实现了一个基本的二进制逻辑门:

```verilog

module binary_logic_gate(

input wire a,

input wire b,

output wire y

);

assign y = a & b; // AND Gate

endmodule

```

**代码逻辑解读:**

1. 定义了一个名为 `binary_logic_gate` 的模块。

2. 定义了两个输入信号 `a` 和 `b`,以及一个输出信号 `y`。

3. 使用 `assign` 语句来赋值输出信号 `y`。

4. 输出 `y` 被设置为输入 `a` 和 `b` 的AND逻辑结果,即当 `a` 和 `b` 都为1时,输出为1。

### 5.2.2 案例研究:十六进制在硬件调试中的作用

在硬件调试中,十六进制格式通常用于表示内存地址和存储内容。调试人员会使用十六进制查看器来分析和修改设备的内存和寄存器状态。十六进制形式非常紧凑,便于在视觉上快速识别和比较数据。

以一个简易的十六进制查看器为例,它可能在硬件调试工具中读取内存地址的内容,并显示为十六进制字符串。

```c

#include <stdio.h>

#include <stdlib.h>

void readAndDisplayMemoryContent(unsigned long address) {

// 假设函数readMemoryContent读取指定地址的内容并返回

unsigned char* buffer = readMemoryContent(address);

printf("Content at address 0x%lX:\n", address);

for (int i = 0; i < 16; ++i) {

printf("%02X ", buffer[i]); // 输出为十六进制格式

if ((i+1) % 8 == 0) printf("\n"); // 每行打印8个字节

}

printf("\n");

free(buffer); // 释放分配的内存

}

int main() {

unsigned long address = 0x00FF0000; // 假定的内存地址

readAndDisplayMemoryContent(address);

return 0;

}

```

**代码逻辑解读:**

1. 包含 `<stdio.h>` 和 `<stdlib.h>` 头文件。

2. 定义函数 `readAndDisplayMemoryContent`,接受一个无符号长整型参数 `address`。

3. 函数内部声明了一个指向 `unsigned char` 的指针 `buffer`,用于存储读取的数据。

4. 调用 `readMemoryContent` 函数读取内存地址的内容。

5. 打印内存地址。

6. 使用循环遍历读取的内存内容,并格式化输出为十六进制字符串。

7. 如果输出8个字节,则换行。

8. 释放 `buffer` 指向的内存,防止内存泄漏。

9. 在 `main` 函数中,定义一个示例地址,并调用 `readAndDisplayMemoryContent` 显示其内容。

## 结语

第五章通过实际案例,展示了二进制与十六进制在编程和硬件领域中的实际应用。从基础的编程转换到复杂的硬件设计,这些数学基础概念在底层处理和高级编程中都发挥着重要的作用。这些概念的应用不仅限于理论,更在于能够解决实际问题。通过这些案例的学习和分析,可以加深对二进制与十六进制的理解,更好地将理论知识转化为实用技能。

# 6. 二进制与十六进制未来展望与挑战

在数字化时代,二进制与十六进制作为基础数据表示形式,它们不仅渗透到计算机科学的每一个角落,而且随着技术的发展,它们的角色和应用也在不断地演变和扩展。这一章节将深入探讨二进制与十六进制在新技术中的角色,以及未来可能面临的挑战和发展趋势。

## 6.1 二进制与十六进制在新技术中的角色

### 6.1.1 量子计算中的二进制表示

量子计算是利用量子位(qubits)进行信息的编码和处理。尽管量子计算机采用的原理与经典计算机有本质的不同,但二进制表示在其中依然扮演着重要角色。量子位的状态可以用0和1来表示,但在量子计算中,量子位可以同时处于0和1的叠加状态,这允许量子计算机并行处理大量计算任务。具体到二进制表示,量子计算机中的量子门(Quantum Gates)通过对量子位进行逻辑运算,可以实现复杂的变换,这些变换在数学上可以用矩阵运算来表示,而这些矩阵运算又与二进制数的操作密不可分。

### 6.1.2 机器学习与数据科学中的应用

在机器学习和数据科学领域,二进制和十六进制也发挥着不可忽视的作用。例如,许多机器学习模型的数据输入和输出在计算机内部是以二进制形式表示的。而在神经网络中,权重和激活函数的计算也涉及到大量的二进制运算。十六进制在数据科学中尤其有用,因为很多数据分析工具和库都使用十六进制来优化性能和存储效率。例如,NumPy库中的数组元素经常以十六进制形式显示,以便于开发者快速识别和处理数据。

## 6.2 面临的挑战与发展趋势

### 6.2.1 当前二进制与十六进制面临的挑战

尽管二进制和十六进制是数字技术的基石,但随着新技术的出现,它们也面临一些挑战。例如,在量子计算中,传统的二进制表示可能不足以充分描述量子位的全部潜能,需要开发新的数学工具和概念来适应量子计算的特性。在数据存储方面,随着数据量的爆炸性增长,存储设备的密度和速度都需要提升,而二进制和十六进制的存储表示方法可能需要优化以适应这些变化。

### 6.2.2 未来发展趋势与预测

未来的趋势可能会指向二进制与十六进制的进一步整合与优化。例如,计算机架构可能进一步优化以更高效地处理二进制数据,而新的算法可能被开发出来以更好地利用十六进制表示数据的特性。随着量子计算和机器学习技术的发展,我们可能会看到更多的交叉学科应用,这些技术的发展将推动二进制和十六进制表示方法的不断演进。

在未来,二进制与十六进制将继续扮演核心角色,并可能随着新兴技术的融合而产生新的应用和挑战。理解这些基本概念如何适应新的技术环境,对于每一个IT行业从业者来说,都是一个持续学习和适应的过程。

0

0