迁移学习的模型训练:超参数优化、正则化与迁移学习策略,训练高性能模型

发布时间: 2024-07-21 05:11:55 阅读量: 77 订阅数: 36

深度学习神经网络训练问题解决和经验指南

# 1. 迁移学习简介

迁移学习是一种机器学习技术,它利用在特定任务上训练过的模型来解决新的但相关的任务。通过利用先前学到的知识,迁移学习可以显着提高新任务的学习速度和性能。

迁移学习的原理是基于这样的假设:不同任务之间通常存在共性,即使它们在表面上看起来不同。通过将先前任务中学到的知识转移到新任务,模型可以快速适应新任务,而无需从头开始学习。

迁移学习的优势包括:

- **提高学习速度:**迁移学习可以利用先前学到的知识,从而减少新任务的训练时间。

- **提高性能:**迁移学习可以利用先前任务中学到的特征表示,从而提高新任务的性能。

- **减少数据需求:**迁移学习可以减少新任务所需的训练数据量,这对于数据稀缺的任务尤其有用。

# 2. 超参数优化在迁移学习中的应用

### 2.1 超参数优化的概念和方法

**概念:**

超参数优化是指在给定模型结构和训练数据集的情况下,寻找一组最优的超参数,以最大化模型的性能。超参数是模型训练过程中的可调参数,与模型的结构无关,例如学习率、批次大小、正则化系数等。

**方法:**

超参数优化通常使用迭代搜索算法进行,包括:

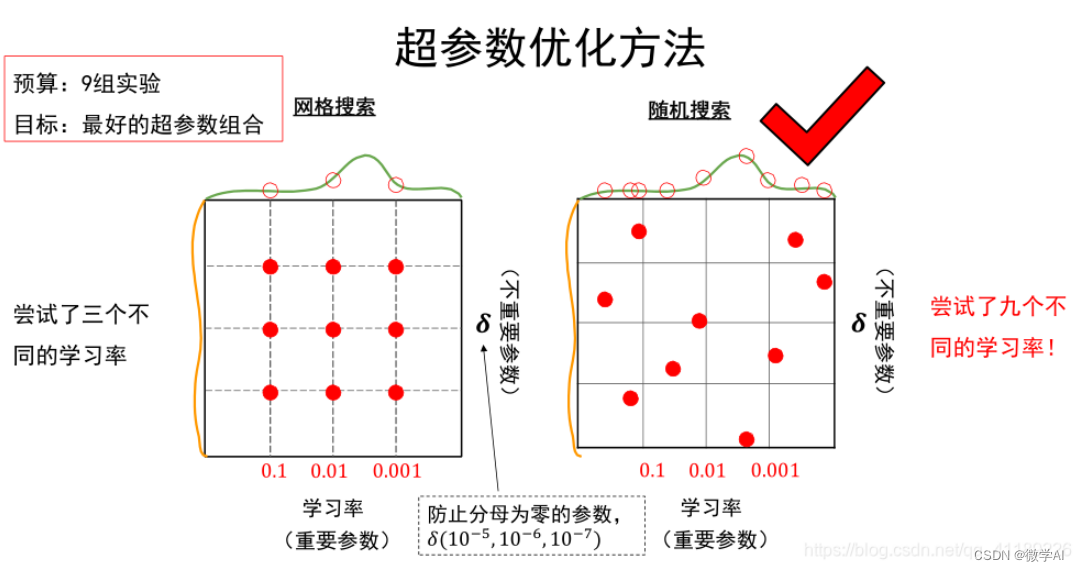

- **网格搜索:**系统地遍历超参数空间,评估每个超参数组合的性能。

- **随机搜索:**在超参数空间中随机采样,评估性能并逐步收敛到最优值。

- **贝叶斯优化:**利用贝叶斯推理,根据已评估的超参数组合,预测未评估组合的性能,并优先评估最有希望的组合。

### 2.2 超参数优化在迁移学习中的重要性

在迁移学习中,超参数优化至关重要,因为它可以:

- **提高模型性能:**找到最优超参数可以最大化迁移学习模型在目标任务上的准确性和泛化能力。

- **减少过拟合:**适当的超参数可以防止模型在源任务上过拟合,从而提高在目标任务上的泛化能力。

- **加速训练过程:**优化超参数可以减少训练时间,因为更优的超参数可以使模型更快地收敛。

### 2.3 常见的超参数优化算法

**网格搜索:**

```python

# 定义超参数空间

param_grid = {

'learning_rate': [0.01, 0.001, 0.0001],

'batch_size': [16, 32, 64],

'dropout': [0.2, 0.4, 0.6]

}

# 遍历超参数空间并评估性能

for params in param_grid:

model = train_model(params)

evaluate_model(model)

```

**随机搜索:**

```python

# 定义超参数空间

param_bounds = {

'learning_rate': (0.001, 0.01),

'batch_size': (16, 64),

'dropout': (0.2, 0.6)

}

# 随机采样超参数并评估性能

for _ in range(100):

params = {k: random.uniform(*v) for k, v in param_bounds.items()}

mod

```

0

0