【Keras模型调优专家课】:超参数调整与模型正则化的深度解析(性能提升不传之秘)

发布时间: 2024-09-30 10:09:04 阅读量: 46 订阅数: 37

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. Keras模型调优概述

在机器学习和深度学习领域中,模型调优是提高模型性能的关键步骤。对于使用Keras框架进行开发的工程师而言,调优既是一个必须掌握的技能,也是一个富有挑战的任务。调优的目标通常是为了在保证模型泛化能力的前提下,最大化其预测准确性和性能。在深度神经网络中,调优可以涉及多个层面,从简单的超参数调整到复杂的模型结构修改,再到正则化技术的使用。本文将从这些方面展开,深入探讨如何通过不同的策略和技巧,在Keras中对模型进行调优。

在接下来的章节中,我们将详细了解超参数的基本概念,探讨它们如何影响模型的性能,并介绍常用的超参数调整方法。此外,我们将介绍模型正则化技术,它能有效防止过拟合,提高模型的泛化能力。最后,我们还将深入探讨自动化超参数优化工具和一些高级调优技巧,并通过案例研究来加深理解。通过本文的学习,读者应能够系统地掌握Keras模型调优的方法和技巧,从而在实际项目中提升模型性能。

# 2. 超参数调整的基础知识

在深度学习领域,模型的性能往往受到超参数设置的影响。超参数的调整可以看作是机器学习过程中的“艺术”部分,因为它涉及到经验和直觉,同时也有着系统性的方法可以遵循。了解超参数调整的基础知识是实现高效和有效模型调优的第一步。

## 2.1 超参数的概念与重要性

### 2.1.1 什么是超参数

在机器学习和深度学习模型中,超参数是那些在训练之前设置好的参数,它们不是通过模型训练得到的,而是需要人为指定的。这与模型参数(如神经网络中的权重和偏置)形成对比,后者是在训练过程中通过优化算法得到的。超参数可以影响模型的训练过程和性能,例如学习率、批次大小、神经网络的层数和每层的单元数等。

### 2.1.2 超参数与模型性能的关系

超参数的选择直接关系到模型的性能。一个不恰当的超参数设置可能导致模型难以收敛,或者在训练集上过拟合而在测试集上泛化能力差。理解每个超参数的作用及其对模型性能的潜在影响,是进行有效模型调整的基础。

## 2.2 常见超参数的介绍

### 2.2.1 学习率的选择

学习率是深度学习中最重要的超参数之一。它控制着在梯度下降过程中权重更新的幅度。学习率太高可能会导致训练过程不稳定,甚至发散;学习率太低则会导致模型收敛速度过慢,甚至陷入局部最小值。

为了找到一个合适的学习率,我们可以采取以下策略:

1. 使用预先设定的学习率来训练模型,并观察损失函数是否下降。

2. 使用学习率范围测试,逐步减小学习率,并记录验证集上的性能。

```python

# 示例代码:学习率范围测试

initial_lr = 0.1

decay_rate = 0.96

decay_steps = 100

lr_schedule = tf.keras.optimizers.schedules.ExponentialDecay(

initial_lr,

decay_steps=decay_steps,

decay_rate=decay_rate,

staircase=True)

***pile(loss='sparse_categorical_crossentropy',

optimizer=tf.keras.optimizers.Adam(learning_rate=lr_schedule),

metrics=['accuracy'])

# 训练并监控学习率对模型性能的影响

history = model.fit(train_data, train_labels, epochs=20)

```

### 2.2.2 网络层数与单元数

神经网络的层数和每层的单元数直接影响模型的容量,即模型拟合复杂数据的能力。更深的网络能够学习更复杂的函数,但也更容易过拟合,并且需要更多的数据和计算资源。

选择网络层数和单元数时,通常要遵循以下原则:

1. 从较浅的网络开始,逐步增加深度,直到验证集上的性能不再提升。

2. 观察训练集和测试集上的性能差异,以判断是否存在过拟合。

### 2.2.3 批量大小的调整

批量大小指的是在每次权重更新时使用多少训练样本。较大的批量可以提高内存利用率和计算效率,但过大的批量可能导致模型泛化性能下降。找到合适的批量大小对于优化训练速度和模型性能至关重要。

在调整批量大小时,可以:

1. 从较小的批量开始,逐步增加。

2. 使用学习率调度策略,使学习率随着批量大小的增加而调整。

## 2.3 超参数调整的方法论

### 2.3.1 网格搜索

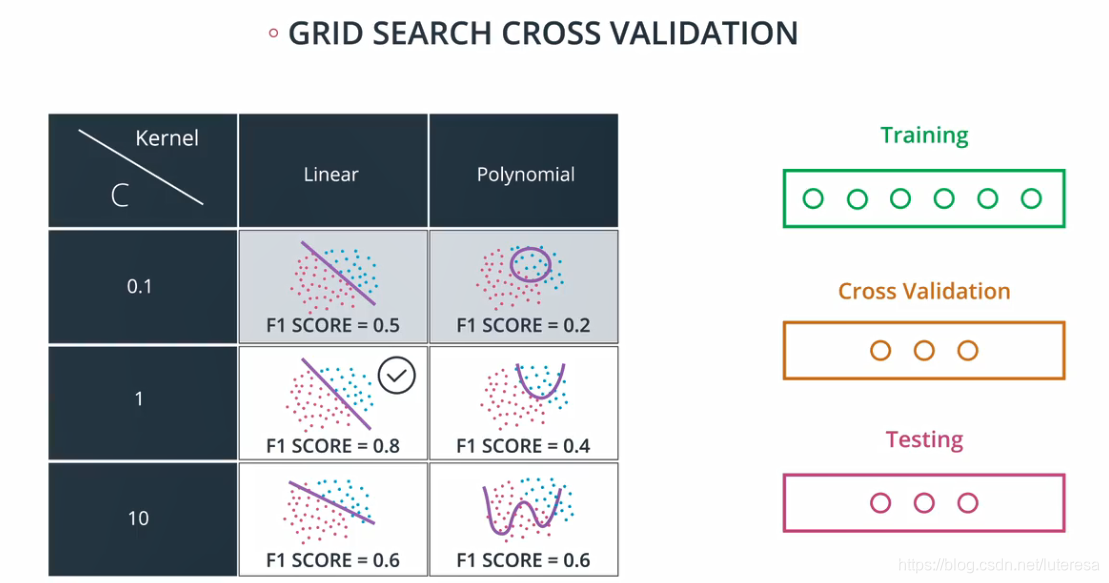

网格搜索是最简单的超参数调整方法,通过遍历预定义的参数集中的所有组合来确定最佳的参数组合。尽管这种方法简单直观,但当超参数空间较大时,计算成本非常高。

### 2.3.2 随机搜索

与网格搜索不同,随机搜索是在一个超参数空间中随机选择参数组合。实验证明,随机搜索在有限的搜索次数下,能够找到更好的参数组合,因为它能够探索更大的参数空间。

### 2.3.3 贝叶斯优化

贝叶斯优化是一种更加高效的超参数调整方法。它使用贝叶斯推理来构建一个概率模型,用以预测给定超参数组合的性能,并据此选择下一个超参数组合进行测试。这种方法能够根据已有的试验结果调整搜索策略,从而更快地收敛到最佳参数组合。

以上介绍了超参数的概念、重要性和常见的调整方法。理解这些基础知识是进一步深入超参数优化的前提。在下一章节中,我们将深入探讨模型正则化技术,以解决过拟合问题,并进一步提升模型性能。

# 3. 模型正则化技术

## 3.1 正则化的理论基础

### 3.1.1 过拟合与正则化的概念

在机器学习中,过拟合是模型在训练数据上表现良好,但在未知数据上表现较差的现象。正则化是解决过拟合问题的一种重要技术,通过向模型的目标函数中添加额外的惩罚项来限制模型的复杂度,从而提高模型的泛化能力。

### 3.1.2 常用的正则化方法

正则化方法通常分为L1正则化和L2正则化两大类,它们通过不同的方式对模型的权重施加约束。

- **L1正则化**:通过向损失函数中添加权重的绝对值总和作为惩罚项,使得模型倾向于产生稀疏的权重矩阵,有助于特征选择。

- **L2正则化**:则是在损失函数中添加权重的平方和作为惩罚项,使得模型权重不会太大,有助于防止模型过分依赖某一个特征。

在Keras中,可以通过在模型层的参数中设置`kernel_regularizer`属性来应用这两种正则化方法。

## 3.2 实践中的正则化应用

### 3.2.1 L1和L2正则化在Keras中的实现

在Keras中,正则化通常作为层的一部分,这样可以很简便地应用到整个模型中。例如,若要对一个全连接层应用L2正

0

0