【Keras自然语言处理应用】:文本分类与序列模型的深度学习解决方案(语言处理新技术)

发布时间: 2024-09-30 11:00:51 阅读量: 35 订阅数: 21

自然语言处理毕业项目学习资料.pdf

# 1. Keras自然语言处理简介

Keras作为高级神经网络API,可运行在TensorFlow、CNTK或Theano之上,以其易用性、模块化及兼容性在深度学习领域广受欢迎。自然语言处理(NLP)是人工智能领域的一个重要分支,涉及语言、计算机以及人工智能三个学科,是利用计算机对自然语言进行处理与分析的技术。

在本章中,我们将简要介绍Keras在NLP中的应用概况,以及其对实现自然语言理解相关任务(如文本分类、情感分析、机器翻译等)的支持。Keras为构建NLP模型提供了灵活而强大的工具,包括易于构建复杂模型的API,以及多种适合NLP的预处理工具和层结构。我们将探讨Keras如何简化NLP任务中的关键步骤,包括文本数据的预处理、模型的构建与训练以及结果的解释。

通过本章内容,读者将对Keras在NLP领域内的应用有一个全面而深入的理解,为后续章节的深入学习和实战应用打下坚实的基础。

# 2. Keras中的文本预处理技术

## 2.1 文本数据的清洗与标准化

### 2.1.1 分词处理

分词是将文本分割为更小的单元,通常是单词或字符的过程。在英语中,分词相对简单,通常可以按照空格和标点符号进行分割。然而,在中文中,由于没有明显的单词边界,分词变得更加复杂,需要依赖专门的分词算法。

在Keras中,可以使用内置的方法或第三方库如jieba进行分词。以下是使用jieba进行中文分词的示例代码:

```python

import jieba

text = "自然语言处理是计算机科学、人工智能和语言学领域中一个跨学科的课题。"

# 分词处理

words = jieba.lcut(text)

print(words)

```

### 2.1.2 去除停用词和标点符号

停用词是指那些在文本中频繁出现,但对于理解文本含义贡献不大的词语,例如英文中的“the”、“is”等,中文中的“的”、“在”等。它们可以增加词汇的多样性,但通常对于分析任务并不重要。因此,在进行文本预处理时,常常会移除这些停用词。

同时,标点符号和特殊字符也不携带太多语义信息,且可能会影响后续的处理,因此也常常被移除。下面的代码示例展示了如何在Python中去除停用词和标点符号:

```python

import re

# 假设我们有如下的停用词表

stopwords = set(["的", "是", "在"])

# 移除标点符号和停用词

filtered_words = [word for word in words if word not in stopwords and not re.match(r'[^\u4e00-\u9fff]', word)]

print(filtered_words)

```

## 2.2 文本向量化方法

### 2.2.1 词袋模型

词袋模型(Bag of Words, BoW)是一种将文本转换为数值向量的表示方法。它忽略了词的顺序,只关注词的频率,从而把文本数据转换为易于机器处理的格式。

在Keras中,我们通常使用`CountVectorizer`来进行BoW表示:

```python

from sklearn.feature_extraction.text import CountVectorizer

# 示例数据集

corpus = [

'这是第一个文本',

'这是第二个文本',

'这里是第三个文本'

]

# 创建词袋模型

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(corpus)

# 查看转换后的向量

print(vectorizer.get_feature_names_out())

print(X.toarray())

```

### 2.2.2 TF-IDF模型

TF-IDF(Term Frequency-Inverse Document Frequency)是一种常用于信息检索和文本挖掘的加权技术。TF-IDF模型不仅考虑了词语在文档中的频率,还考虑了词语在所有文档中的重要性。

在Keras中没有直接实现TF-IDF的模块,但我们可以使用`TfidfVectorizer`来实现:

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例数据集

corpus = [

'文本处理是重要的',

'文本分析也是重要的',

'处理和分析文本'

]

# 创建TF-IDF模型

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(corpus)

print(vectorizer.get_feature_names_out())

print(X.toarray())

```

### 2.2.3 Word2Vec和GloVe词嵌入

词嵌入(Word Embeddings)是一种表示技术,它可以将词语转换为稠密的向量。Word2Vec是一种流行的词嵌入模型,它通过预测上下文中的词或被预测的词来学习词的向量表示。GloVe(Global Vectors)是另一种生成词嵌入的方法,它通过利用全局词频统计信息来学习词向量。

在Keras中,我们可以使用预训练的Word2Vec或GloVe模型来获得词向量表示。以下是使用Word2Vec的示例:

```python

import gensim.downloader as api

# 加载预训练的Word2Vec模型

word2vec_model = api.load('word2vec-google-news-300')

# 词嵌入的查找

word_vector = word2vec_model['文本']

print(word_vector.shape) # 词向量的维度是300

```

## 2.3 文本数据的增强技术

### 2.3.1 数据增强方法概述

数据增强是指通过某种方法人工地增加训练数据集的大小和多样性。在文本处理中,数据增强可以包括诸如同义词替换、句子重排、回译(将句子翻译成另一种语言然后再翻译回来)等多种方法。这些技术可以用来增加模型的泛化能力,特别是在标注数据有限的情况下。

### 2.3.2 实际应用案例分析

让我们通过一个简单的例子来展示如何使用回译来进行数据增强:

```python

from googletrans import Translator

# 初始化翻译器

translator = Translator()

def translate_text(text, dest_language='en'):

return translator.translate(text, dest=dest_language).text

# 示例文本

original_text = "我喜欢自然语言处理"

# 回译增强

translated_text = translate_text(original_text, dest_language='zh-cn')

enhanced_texts = [original_text, translated_text]

for text in enhanced_texts:

print(text)

```

通过上述方法,我们得到了两个文本变体:原始文本和经过回译增强的文本。在实际应用中,可以根据需要将这些增强后的文本用于训练模型,以提高模型的鲁棒性和准确性。

接下来的章节将会继续深入探讨Keras在实现文本分类模型中的应用,包括多层感知器、循环神经网络、卷积神经网络等多种模型的构建与评估。

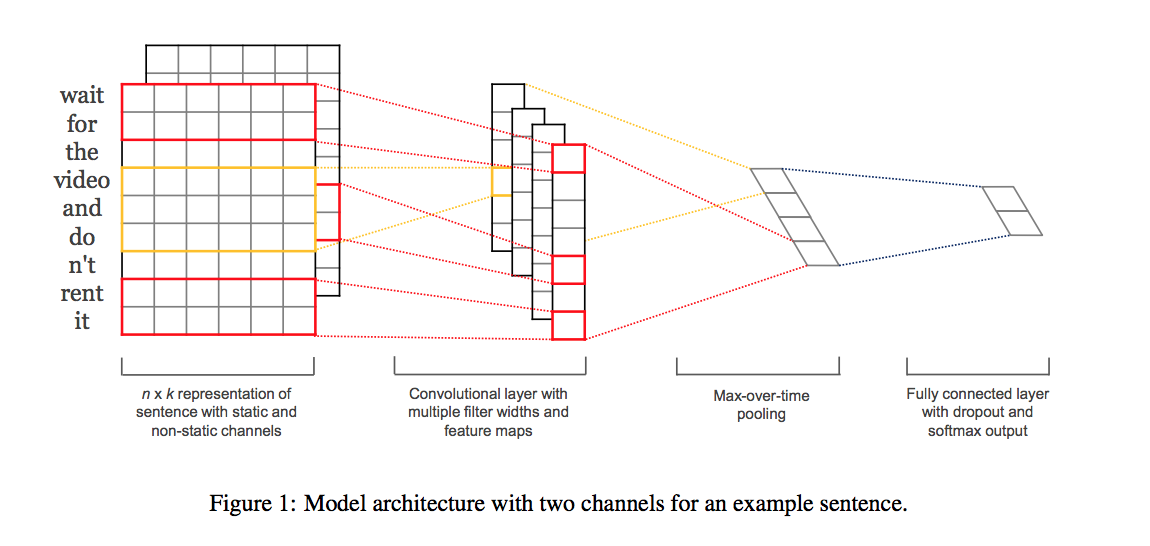

# 3. Keras实现文本分类模型

文本分类是自然语言处理中的基础任务之一,它将文本数据分配到一个或多个类别中。在Keras中实现文本分类模型,可以使用多种神经网络架构,如多层感知器(MLP)、循环神经网络(RNN),以及卷积神经网络(CNN)。本章将详细介绍如何利用Keras框架构建这些模型,并对它们进行训练和评估。

## 3.1 基于MLP的文本分类

### 3.1.1 搭建多层感知器模型

多层感知器(MLP)是一种基础的神经网络结构,特别适合处理具有固定大小输入特征向量的数据。在文本分类任务中,输入的文本首先需要被转换为数值特征向量。接着,MLP可以被用来学习这些特征与文本类别之间的非线性关系。

```python

from keras.models import Sequential

from keras.layers import Dense, Dropout, Embedding, Flatten

from keras.datasets import imdb

# 载入数据集并设置

max_features = 20000 # 词汇表大小

maxlen = 100 # 每个样本的最大词数

(x_train, y_train), (x_test, y_test) = imdb.load_data(num_words=max_features)

# 将输入数据转换为固定大小

x_train = sequence.pad_sequences(x_train, maxlen=maxlen)

x_test = sequence.pad_sequences(x_test, maxlen=maxlen)

# 构建模型

model = Sequential()

model.add(Embedding(max_features, 128))

model.add(Flatten())

model.add(Dense(1, activation='sigmoid'))

# 编译模型

***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 输出模型概况

model.summary()

```

在这段代码中,我们首先载入了IMDB数据集,并限制了词汇表大小为20,000。然后,我们使用`sequence.pad_sequences`将所有评论填充至相同的长度。接着,我们构建了一个简单的MLP模型,其中包含一个嵌入层、一个展平层(Flatten)和一个具有sigmoid激活函数的Dense层。模型使用binary_crossentropy作为损失函数,并以adam优化器进行编译。这样的模型非常适合二分类任务。

### 3.1.2 模型训练与评估

在搭建好模型之后,我们需要对其进行训练和评估,以验证模型在新数据上的表现。

```python

# 训练模型

model.fit(x_train, y_train, batch_size=32, epochs=10, validation_split=0.2)

# 评估模型

score, acc = model.evaluate(x_test, y_test, batch_size=32)

print('Test score:', score)

print('Test accuracy:', acc)

```

上述代码将模型在训练数据上进行10轮的训练,并使用80%的训练数据和20%的验证数据。训练结束后,我们使用测试数据集评估模型的性能,打印出测试集上的损失值和准确率。

## 3.2 使用循环神经网络进行分类

### 3.2.1 循环神经网络(RNN)基础

RNN是一种对序列数据建模的强大工具,其在文本分类任务中能够处理不同长度的输入序列。RNN能够记住先前的输入,并在后续步骤中使用这些信息。长短期记忆网络(LSTM)和门控循环单元(GRU)是RNN的变体,它们通过特殊的门控机制解决了传统RNN难以学习长期依赖的问题。

### 3.2.2 LSTM与GRU在文本分类中的应用

下面的代码示例展示了如何使用LSTM和GRU层在IMDB评论数据集上进行情感分类。

```python

from keras.layers import LSTM, GRU

# LSTM模型

model_lstm = Sequential()

model_lstm.add(Embedding(max_features, 128))

model_lstm.add(LSTM(64))

model_lstm.add(Dense(1, activation='sigmoid'))

model_***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# GRU模型

model_gru = Sequential()

model_gru.add(Embedding(max_features, 128))

model_gru.add(GRU(64))

model_gru.add(Dense(1, activation='sigmoid'))

model_***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训

```

0

0