迁移学习的常见错误:过拟合、欠拟合与负迁移,避坑指南

发布时间: 2024-07-21 05:04:18 阅读量: 132 订阅数: 29

# 1. 迁移学习简介

迁移学习是一种机器学习技术,它利用从一个任务中学到的知识来解决另一个相关但不同的任务。这种方法可以显著缩短训练时间,提高模型性能。

迁移学习的原理是,不同的任务通常共享一些底层的特征或模式。通过将从一个任务中学到的知识转移到另一个任务,我们可以利用这些共享的特征,从而快速有效地解决新任务。

迁移学习的优势包括:

* 减少训练时间:通过利用预训练模型,可以避免从头开始训练模型,从而节省大量时间。

* 提高模型性能:预训练模型通常已经学习到了丰富的特征,可以帮助新任务的模型更快地收敛并获得更好的性能。

* 应对小数据问题:当新任务的数据量较小或难以获取时,迁移学习可以利用预训练模型的知识来弥补数据不足的问题。

# 2. 迁移学习中的常见错误

迁移学习虽然是一种强大的技术,但它也存在一些常见的错误,这些错误可能会影响模型的性能。本章节将探讨迁移学习中常见的错误,并提供解决这些错误的建议。

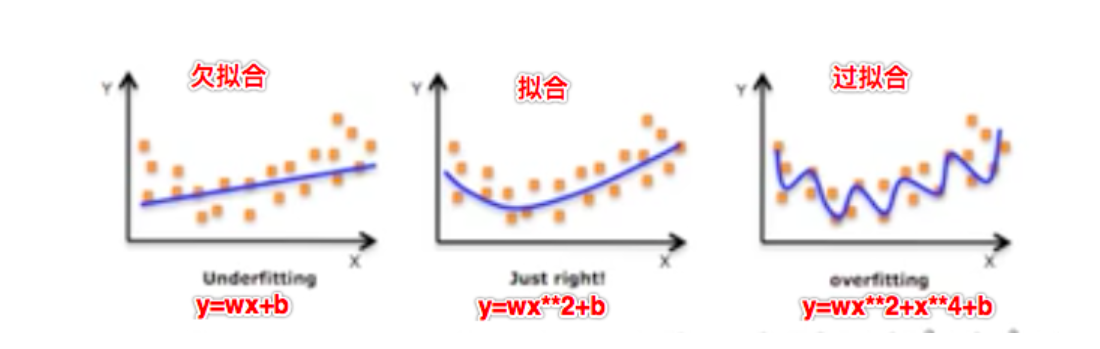

### 2.1 过拟合

**2.1.1 过拟合的成因**

过拟合是指模型在训练集上表现良好,但在测试集上表现不佳的情况。这通常是由于模型过度拟合了训练数据的噪声和异常值,导致它无法泛化到新数据。过拟合的常见原因包括:

- **模型过于复杂:**模型具有过多的参数或层,导致它能够记忆训练数据中的所有细节。

- **训练数据不足:**训练数据太小或不具有代表性,导致模型无法学习数据的真实分布。

- **正则化不足:**正则化技术(如 L1/L2 正则化和 dropout)有助于防止模型过度拟合,但如果使用不足,模型仍然可能出现过拟合。

**2.1.2 过拟合的解决方法**

解决过拟合的常见方法包括:

- **简化模型:**减少模型的参数数量或层数,使其更简单。

- **增加训练数据:**收集更多的数据,或使用数据增强技术来增加训练数据的多样性。

- **应用正则化:**使用正则化技术,如 L1/L2 正则化或 dropout,来惩罚模型的复杂性。

- **使用早期停止:**在训练过程中,在模型在验证集上开始过拟合时停止训练。

### 2.2 欠拟合

**2.2.1 欠拟合的成因**

欠拟合是指模型在训练集和测试集上都表现不佳的情况。这通常是由于模型过于简单,无法捕捉数据的复杂性。欠拟合的常见原因包括:

- **模型过于简单:**模型具有太少的参数或层,导致它无法学习数据的复杂模式。

- **训练数据不足:**训练数据太小或不具有代表性,导致模型无法学习数据的真实分布。

- **正则化过度:**正则化技术过于激进,导致模型无法学习数据的有用特征。

**2.2.2 欠拟合的解决方法**

解决欠拟合的常见方法包括:

- **复杂化模型:**增加模型的参数数量或层数,使其更复杂。

- **增加训练数据:**收集更多的数据,或使用数据增强技术来增加训练数据的多样性。

- **减少正则化:**减少正则化技术的强度,以允许模型学习数据的更复杂特征。

- **使用学习率调度:**调整学习率,在训练过程中逐渐减小,以帮助模型收敛到更好的局部最小值。

### 2.3 负迁移

**2.3.1 负迁移的成因**

负迁移是指迁移学习模型在目标任务上的性能比从头训练的模型更差的情况。这通常是由于源任务和目标任务之间的差异导致模型学习了对目标任务有害的特征。负迁移的常见原因包括:

- **源任务和目标任务之间的差异太大:**源任务和目标任务之间的差异越大,负迁移的风险就越大。

- **源模型过于复杂:**源模型过于复杂,导致它学习了源任务的特定细节,这些细节对目标任务没有帮助。

- **目标数据不足:**目标数据太少或不具有代表性,导致模型无法克服负迁移的影响。

**2.3.2 负迁移的解决方法**

解决负迁移的常见方法包括:

- **选择相似的源任务:**选择与目标任务尽可能相似的源任务,以减少负迁移的风险。

- **使用简单的源模型:**使用一个简单的源模型,它只学习源任务的通用特征,而不是特定的细节。

- **增加目标数据:**收集更多的数据,或使用数据增强技术来增加目标数据的多样性。

- **使用渐进式迁移:**逐步迁移模型,从源任务到与目标任务更相似的中间任务,再到目标任务。

# 3. 避免迁移学习中常见错误的实践

### 3.1 数据预处理

#### 3.1.1 数据清洗和特征工程

**数据清洗**

数据清洗是迁移学习数据预处理的关键步骤,它涉及识别和删除不完整、不一致和异常的数据点。这对于防止模型过拟合和欠拟合至关重要。常用的数据清洗技术包括:

- **缺失值处理:**使用插补方法(如均值、中位数或众数)填充缺失值,或删除包含大量缺失值的样本。

- **异常值检测:**识别并删除与数据集中其他样本明显不同的异常值,因为它们可能导致模型偏差。

- **数据类型转换:**将数据转换为适当的数据类型,例如将文本特征转换为类别变量,或将数值特征转换为连续变量。

**特征工程**

特征工程是创建新的特征或转换现有特征的过程,以提高模型的性能。在迁移学习中,特征工程对于以下方面至关重要:

- **特征选择:**识别与目标变量最相关的特征,并删除冗余或不相关的特征。

- **特征缩放:**将特征值缩放至相同范围,以防止某些特征在训练过程中对模型产生过大影响。

- **特征编码:**将类别变量编码为数值形式,以便模型可以理解和处理它们。

#### 3.1.2 数据增强和正则化

**数据增强**

数据增强是一种技术,通过对现有数据进行转换和修改来创建新的数据样本。这有助于增加训练数据集的大小,防止模型过拟合。常用的数据增强技术包括:

- **旋转、翻转和裁剪:**对图像数据进行旋转、翻转和裁剪,以创建新的视图。

- **添加噪声和失真:**向数据中添加随机噪声和失真,以模拟现实世界中的数据变化。

- **合成数据:**使用生成模型创建新数据样本,以补充现有数据集。

**正则化**

正则化是一种技术,通过向损失函数添加惩罚项来防止模型过拟合。

0

0