模型过拟合与欠拟合评估:识别与预防的策略指南

1. 模型过拟合与欠拟合概述

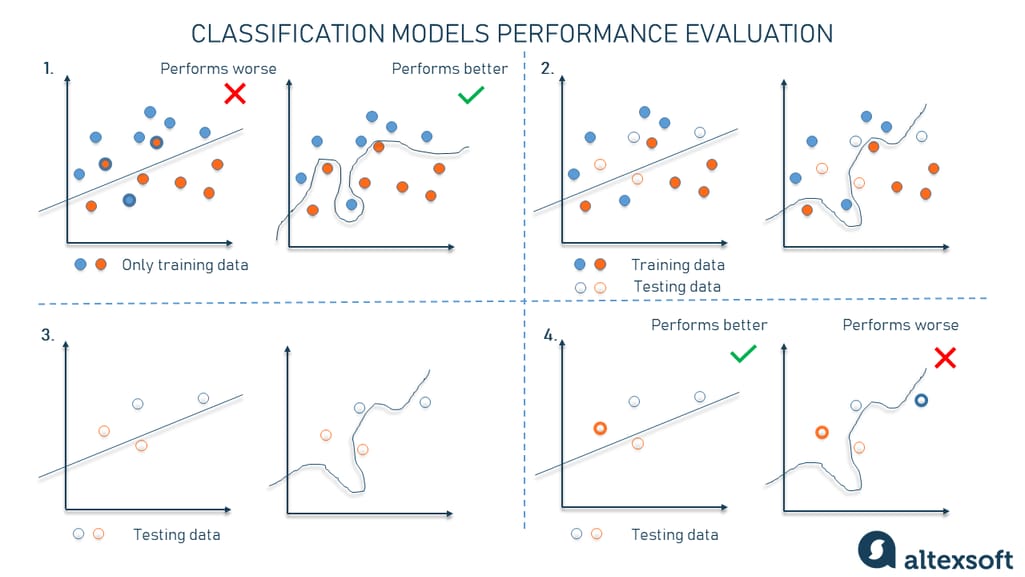

在机器学习领域,构建准确且泛化能力强的模型是所有数据科学家的目标。然而,在训练模型时,我们经常会遇到两个主要问题:过拟合(overfitting)与欠拟合(underfitting)。这两种情况都会导致模型在未见过的数据上的表现大打折扣。

1.1 过拟合与欠拟合的定义

- 过拟合是指模型在训练数据上表现得非常好,能够捕捉到数据中的噪声和异常值,但在新数据上的表现却显著下降。

- 欠拟合则是指模型过于简单,无法捕捉数据的基本趋势,从而在训练和测试数据上都表现不佳。

理解这两种情况对于设计出能够正确预测未知数据的模型至关重要。下一章节,我们将详细介绍模型拟合的基本原理,以帮助读者建立坚实的理论基础。

2. 理论基础与关键概念

2.1 模型拟合的基本原理

2.1.1 训练误差与泛化误差

在机器学习领域中,模型拟合的核心思想是通过数据来学习输入与输出之间的映射关系。训练误差(Training Error)指的是模型在训练数据集上的预测误差,而泛化误差(Generalization Error)则是模型在未见过的新数据上的预测误差。理想情况下,我们希望模型不仅能很好地拟合训练数据(即训练误差小),还能泛化到新数据(即泛化误差小)。

在实际操作中,我们很难直接计算泛化误差,因为这需要我们访问无限量的未见数据。因此,我们通常采用交叉验证等方法来评估模型的泛化能力。

2.1.2 过拟合与欠拟合的定义

过拟合(Overfitting)发生在模型过于复杂,以至于它不仅捕获了数据中的潜在规律,还将噪声和数据集中的非系统性因素也一并学习了进去。结果是,模型在训练集上表现很好,但在新的数据集上表现不佳。欠拟合(Underfitting)则是模型过于简单,无法捕捉数据的基本结构,从而在训练集和测试集上都表现不好。

辨识过拟合和欠拟合的关键在于观察模型在不同数据集上的性能表现差异。对于过拟合,可以通过增加数据量、简化模型结构、使用正则化技术等方法进行预防和纠正。而解决欠拟合则通常需要引入更多特征、使用更复杂的模型结构或改进算法来实现。

2.2 评估模型性能的指标

2.2.1 准确率、召回率与F1分数

准确率(Accuracy)是分类问题中最直观的性能指标,指的是模型正确预测的样本数占总样本数的比例。然而,在数据分布不均匀的场景下,准确率可能不是最佳选择。召回率(Recall)衡量的是模型正确识别出正类样本的能力,而精确率(Precision)度量的是模型预测为正类的样本中有多少是真正的正类。F1分数是精确率和召回率的调和平均,是一种综合考虑二者平衡的指标。

在二分类问题中,这些指标的计算公式如下:

\text{Accuracy} = \frac{TP + TN}{TP + TN + FP + FN}

\text{Recall} = \frac{TP}{TP + FN}

\text{Precision} = \frac{TP}{TP + FP}

F1 = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}}

其中,TP(True Positives)表示模型正确预测为正的样本数,FP(False Positives)表示模型错误预测为正的样本数,TN(True Negatives)表示模型正确预测为负的样本数,FN(False Negatives)表示模型错误预测为负的样本数。

2.2.2 ROC曲线与AUC值

ROC曲线(Receiver Operating Characteristic curve)是一个以真正率(True Positive Rate, TPR)为纵轴,假正率(False Positive Rate, FPR)为横轴的图形。TPR是召回率的另一个称呼,FPR计算公式为FP / (FP + TN)。ROC曲线通过变化不同的阈值来评估模型性能,它能展示模型在不同决策阈值下的分类性能。

AUC值(Area Under the Curve)是ROC曲线下的面积,其值在0.5和1之间。AUC值越高,表示模型的分类性能越好。AUC值提供了一个简洁的单一值来评价模型的整体性能,因此在二分类问题中被广泛使用。

2.2.3 损失函数的作用

损失函数(Loss Function)衡量的是模型预测值与真实值之间的差异,用于训练过程中指导模型参数的调整。常见的损失函数包括均方误差(MSE, Mean Squared Error)用于回归问题,交叉熵(Cross-Entropy)用于分类问题。

对于神经网络而言,损失函数是优化算法调整权重和偏置的主要依据。损失函数的选取对模型训练过程和最终性能都有显著影响。例如,当模型陷入局部最优时,可能需要更换或调整损失函数来获得更好的性能。

2.3 理论模型复杂度与数据量关系

2.3.1 复杂度与拟合能力

模型的复杂度通常由模型结构、参数数量、特征维度等因素决定。理论上,模型的复杂度越高,其拟合训练数据的能力越强。然而,当模型复杂度过高时,容易产生过拟合现象,导致泛化能力下降。因此,选择一个适当的模型复杂度是机器学习中的一个关键问题。

从贝叶斯统计的角度来看,模型复杂度应当与可用数据量相匹配。在有限的数据条件下,过度复杂的模型可能导致不稳定的学习结果,即过拟合。

2.3.2 数据量对模型性能的影响

数据量的多少直接影响到模型的学习能力和泛化能力。理论上,更多的数据可以帮助模型更好地理解数据的分布,减少过拟合的风险。然而,数据量的增加并非总是带来性能的线性提升,因为数据质量和预处理过程同样重要。

在处理数据时,还需要考虑到数据的代表性,即数据集是否能够覆盖所有潜在的模式和变量。如果数据集未能全面地反映问题的所有方面,模型可能仍然会面临欠拟合的风险,即使有大量数据也无法得到良好的泛化能力。

上图是一个简化的流程图,它概括了从数据收集到模型部署的整个过程,以及数据量和模型复杂度如何影响这一过程。数据量的增加可以促进模型性能的提升,但同时也可能需要对模型复杂度进行相应的调整,以确保过拟合不会发生。

通过以上章节的分析,我们构建了理解模型拟合基本原理的框架,并对评估模型性能的核心指标进行了详细探讨。在下一章中,我们将深入了解如何识别和预防模型过拟合的问题,以及如何处理欠拟合的情况,从而为模型优化和改进提供有效的策略和方法。

3. 模型过拟合的识别与预防策略

过拟合的识别方法

训练集与验证集性能差异

在深度学习和机器学习中,模型训练的首要目标是确保它能在新的、未见过的数据上表现良好。然而,当模型过度复杂时,它可能会在训练数据上表现得过于优异,导致模型在训练集上的性能远高于验证集,这种现象称为过拟合。

过拟合通常意味着模型学习到了训练数据中的噪声和异常值,而没有捕捉到数据背后的本质规律。为了识别过拟合,我们通常比较模型在训练集和验证集上的性能。如果在训练集上的性能显著优于验证集,我们可以初步判断模型出现了过拟合。

验证集通常是从训练集数据中划分出来的一部分,不是模型训练过程中的一部分,因此,它能够模拟未见过的数据。以下是一个使用Python中的scikit-learn库来演示如何使用验证集进行模型性能评估的简单示例代码块: