支持向量机模型评估:核函数与超参数调优全攻略

1. 支持向量机模型简介

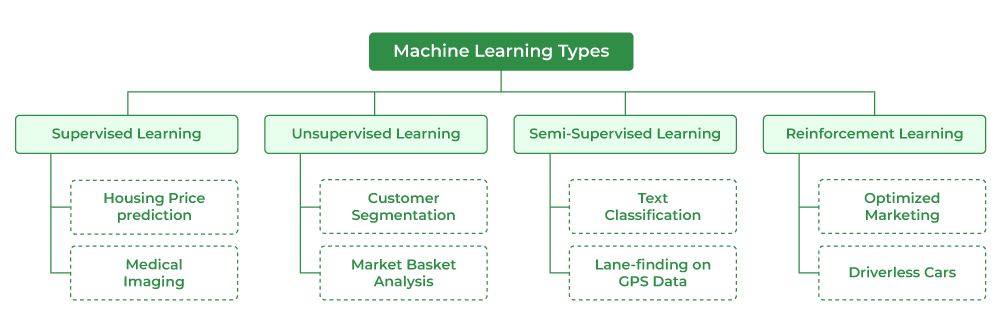

支持向量机(SVM)是一种在数据挖掘和统计学习领域广泛应用的监督学习模型,它在高维空间中通过寻找最佳超平面来实现分类和回归任务。SVM模型的核心思想是最大化分类边界,即找到一个分类超平面,它能够将不同类别的样本尽可能正确地分开,同时使得两类之间的间隔(边距)最大化。支持向量机具有良好的泛化能力,特别适合解决高维数据分类问题,比如文本分类、图像识别等。

1.1 SVM的数学原理和分类策略

SVM通过求解一个二次规划问题来确定最佳的分类超平面。在处理线性不可分的数据时,引入松弛变量和惩罚参数,允许部分数据点违反边距约束,从而提高模型的鲁棒性。此外,引入核技巧,SVM能够在高维空间中处理非线性问题,这是通过将原始特征空间映射到更高维度的特征空间实现的,其中一些核函数如线性核、多项式核、径向基函数(RBF)核等在实际应用中表现突出。

1.2 SVM的应用场景

SVM在金融、生物信息学、计算机视觉等多个领域中有着广泛的应用。例如,它可以用来进行股票价格预测、疾病预测、面部识别等任务。由于SVM在处理小样本问题时表现出色,特别适用于数据量较少但需要高准确度的场合。然而,SVM的计算效率通常不如决策树等其他模型,特别是在特征维度很高时,这限制了它在大规模数据集上的应用。

2. 核函数的选择与应用

2.1 核函数理论基础

2.1.1 核函数的概念和作用

核函数在支持向量机(SVM)中扮演着至关重要的角色,它允许我们将数据映射到更高维的空间中,以便在新的特征空间中更容易地找到最优超平面。这种技术称为“核技巧”。本质上,核函数可以看作是一种计算两个向量在高维空间中内积的快捷方式,而无需显式地执行高维空间的转换,这大大简化了计算过程。

在数学上,如果存在一个从输入空间到特征空间的非线性映射 φ(x),则对于任意的两个输入向量 x 和 z,核函数 K(x, z) 可以表示为:

K(x, z) = φ(x) · φ(z)

核函数的选择直接影响到模型的性能和泛化能力。理想情况下,核函数应该能够捕捉数据中的复杂关系,同时避免过度拟合和计算成本过高。

2.1.2 常见核函数的数学表达和特点

有几种常见的核函数,它们各自有不同的数学表达和特点:

-

线性核函数:K(x, z) = x · z

- 线性核函数简单直观,适用于线性可分的数据集。其计算复杂度低,但无法捕捉数据中的非线性关系。

-

多项式核函数:K(x, z) = (γx · z + r)^d,其中 γ > 0 是缩放参数,d 是多项式的度数。

- 多项式核函数可以提供更复杂的决策边界,但是当多项式度数 d 较高时,参数数量会增加,模型可能会过拟合。

-

径向基函数(RBF)核:K(x, z) = exp(-γ||x - z||^2),其中 γ > 0 是核宽度参数。

- RBF核,也称为高斯核,能够处理数据的无限维特征空间,具有很强的非线性映射能力。选择合适的 γ 参数对于模型性能至关重要。

-

Sigmoid核:K(x, z) = tanh(γx · z + r),其中 γ 和 r 是核函数参数。

- Sigmoid核函数的行为类似于神经网络中的sigmoid激活函数。但是,它的使用并不普遍,因为缺乏良好的数学性质,如正定性。

每种核函数都有其适用场景,通常需要结合具体问题通过实验来确定最佳选择。

2.2 核函数在SVM中的应用实例

2.2.1 线性核函数的使用场景与限制

线性核函数的SVM模型在处理线性可分的数据时效率很高。例如,在文本分类任务中,如果可以将文本转化为词频向量,并且问题呈现线性可分的特点,线性核就是一个很好的选择。它的主要优点是计算速度快,模型简单,易于理解和实现。然而,线性核无法有效处理非线性问题,这限制了它的应用范围。

在线性核的SVM模型中,优化的目标是找到一个超平面,使得各类别的样本距离该平面的边缘最大化,从而保证分类间隔最大化。然而,在现实世界的应用中,很多数据集并不是线性可分的。例如,在手写数字识别任务中,由于笔迹的多样性和数字之间的形状相似性,线性核往往不能提供理想的分类效果。

2.2.2 非线性核函数的选择与实际案例分析

非线性核函数如多项式核、RBF核能够在原始特征空间不可分的情况下,在高维特征空间中找到可分的数据。在选择非线性核函数时,需要考虑以下因素:

- 数据的特征分布:如果数据自然形成某种圆形或球形分布,则RBF核通常是一个较好的选择。

- 数据的规模:RBF核的参数 γ 对计算复杂度和过拟合有显著影响,对于大规模数据集需要谨慎选择。

- 超参数的调整:不同的核函数有着不同的参数设置,如RBF的 γ 参数和多项式核的度数参数,这些都需要通过验证集进行调整。

在实际应用中,以手写数字识别为例,RBF核的SVM模型可以有效地处理数字图像的非线性特征。例如,在MNIST数据集上,通过使用RBF核函数,SVM可以达到98%以上的准确率。不过,RBF核函数中 γ 参数的选择对模型性能有很大影响,最佳值通常通过交叉验证来获得。

2.3 核函数参数的优化策略

2.3.1 参数搜索方法概述

核函数的参数,如RBF核的 γ 参数和多项式核的度数参数,对于模型的性能至关重要。参数优化的目的是在模型复杂度和泛化能力之间找到平衡点。

- 网格搜索(Grid Search):这是一种最简单的参数优化方法,它通过遍历所有可能的参数组合,使用交叉验证来评估每一组参数的性能,最后选择最优的一组。网格搜索的一个缺点是计算成本高,尤其是参数空间较大时。

- 随机搜索(Random Search):与网格搜索不同,随机搜索在指定的参数空间中随机选择参数组合。研究表明,在参数空间较大或参数之间相互独立时,随机搜索能够以更低的计算成本获得与网格搜索相近的性能。

- 贝叶斯优化(Bayesian Optimization):贝叶斯优化是一种更高级的参数优化方法,它通过建立一个参数到性能的代理模型(如高斯过程),然后使用该模型来指导搜索最优参数的方向。贝叶斯优化能够在较少的迭代次数内找到接近最优的参数。

2.3.2 实验设计与结果分析

为了展示参数优化的效果,我们可以设计一个简单的实验。假设我们使用RBF核的SVM进行手写数字识别,我们选择 γ 参数作为优化的目标。实验流程如下:

- 定义参数搜索范围:例如 γ ∈ {0.01, 0.1, 1, 10, 100}。

- 使用网格搜索方法,在验证集上评估每一组参数的性能。

- 记录每一组参数对应的模型准确率,并选择准确率最高的参数组合作为最优参数。

实验结果可能显示,当 γ = 10 时,模型的准确率最高。通过对比不同参数组合下模型的表现,可以分析 γ 参数如何影响模型的泛化能力。例如,当 γ 过大时,可能会导致模型过于复杂,从而在测试集上出现过拟合现象;而当 γ 过小时,模型可能过于简单,无法捕捉数据的复杂性,从而在验证集上表现欠佳。

通过这样的实验,我们不仅可以选择出最佳的核函数参数,还可以对模型的泛化能力有一个深入的理解。这种优化策略对于提高模型在实际应用中的表现至关重要。

3. 超参数调优技术

超参数是机器学习模型的外部参数,它们不像模型内部参数那样通过训练得到,而是需要在模型训练之前进行设置。超参数的选择对模型的性能有着决定性的影响。调优超参数是一个挑战性的过程,因为超参数空间往往是高维的,且调优过程可能会消耗大量的计算资源。本章节我们将深入探讨超参数的重要性、常见的调优方法以及实战技巧。

3.1 超参数的重要性与挑战

3.1.1 超参数的定义和影响

超参数是定义在学习算法之外的参数,它们控制着学习过程的各个方面,例如模型的复杂度、收敛速度和稳定性。在支持向量机(SVM)模型中,超参数如正则化参数C、核函数的参数等,对模型的决策边界有着显著影响。合适的超参数设置能够避免模型过拟合或欠拟合,提高模型在未知数据上的泛化能力。