交叉验证:提升模型评估准确性的终极武器

数据分析中的交叉验证:提升模型泛化能力的利器

1. 交叉验证的概念与重要性

在数据科学和机器学习领域,模型的泛化能力是衡量其性能的一个核心指标。交叉验证(Cross-Validation)是一种评估模型泛化能力的统计方法,它在有限数据集的条件下,通过分组重复训练和评估模型来获得更稳定和准确的模型性能评估。

交叉验证的概念不仅简单易懂,而且在提高模型预测准确性方面发挥了至关重要的作用。通过交叉验证,数据科学家能够更全面地利用有限的数据,减少模型因数据划分不同而导致的性能波动,有效避免过拟合,确保模型具备良好的泛化能力。在实际应用中,交叉验证能够为模型的选择和调整提供科学依据,是优化机器学习工作流程不可或缺的环节。

2. 交叉验证的理论基础

交叉验证是一种统计分析方法,旨在评估模型对未知数据的泛化能力。本章将深入探讨交叉验证的理论基础,包括其数学原理、防止过拟合的机制以及不同类型交叉验证的适用场景。

2.1 交叉验证的数学原理

2.1.1 模型评估指标的定义

在探讨交叉验证之前,首先要理解模型评估指标的定义。模型评估通常涉及以下几个关键指标:

- 准确率(Accuracy):正确分类样本的比例。

- 召回率(Recall):正确识别为正类的样本比例。

- 精确率(Precision):识别为正类中实际为正类的比例。

- F1分数(F1 Score):精确率和召回率的调和平均值。

这些指标帮助我们从不同角度衡量模型性能,并在交叉验证中对比不同模型或模型配置的优劣。

2.1.2 抽样与样本分布

交叉验证涉及到从有限的数据集中构造多个不同的训练/测试集。理想情况下,每个训练集和测试集都应该能够代表整体数据的分布,即每个集合中的样本都应该涵盖整个特征空间。为了实现这一目标,通常采用随机抽样或分层抽样等技术。随机抽样保证了数据的随机性,而分层抽样则在随机抽样的基础上进一步确保每个集合中各类别的比例与原始数据集保持一致。

2.2 交叉验证与过拟合

2.2.1 过拟合的危害及表现

过拟合是机器学习中的一个普遍问题,指的是模型对训练数据的拟合程度过高,以至于无法在未知数据上保持同样好的性能。过拟合的表现通常是模型在训练集上具有很高的性能,而在独立测试集上性能急剧下降。

2.2.2 交叉验证防止过拟合的机制

交叉验证的机制通过划分数据集为多个小的数据集,强迫模型在不同的训练集上学习并验证,从而减少过拟合的风险。每次验证都是在数据集的不同部分上进行,使得模型必须适应不同的数据变化,这有助于提升模型对未知数据的泛化能力。

2.3 交叉验证的类型与选择

2.3.1 留一法交叉验证(L-O-O)

留一法交叉验证是交叉验证的一种形式,其中每个样本依次作为测试集,其余所有样本作为训练集。这种方法可以保证每个样本都得到测试,但计算代价巨大,尤其对于大数据集来说,实现起来非常耗时。

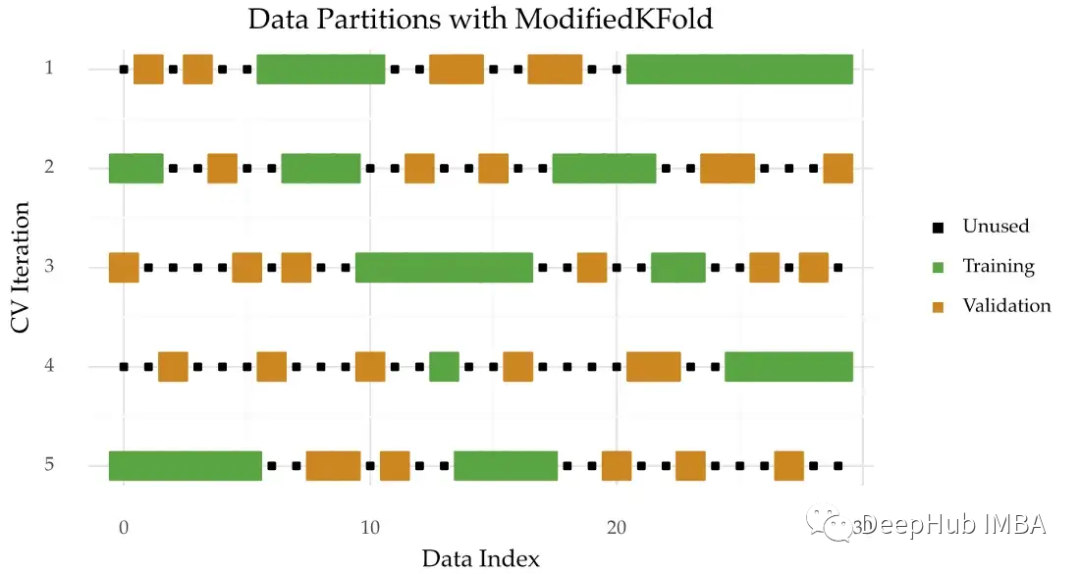

2.3.2 K折交叉验证

K折交叉验证是通过将数据集分成K个大小相等的子集,然后使用其中的K-1个子集作为训练集,剩下的一个子集作为测试集。这个过程重复K次,每次选择不同的训练集和测试集。K折交叉验证是一种平衡了计算成本和模型评估准确性的方法。

2.3.3 分层K折交叉验证

在分类问题中,分层K折交叉验证是一种特殊形式的K折交叉验证,它确保了每个折叠中的类别比例与原始数据集相同。这对于处理不平衡数据集尤为重要,可以提高评估的公平性和准确性。

以下是K折交叉验证流程的Mermaid流程图:

在下一章节中,我们将探索交叉验证的实践技巧,包括如何实现交叉验证的代码框架以及在实际操作中可能遇到的一些问题和解决方案。

3. 交叉验证的实践技巧

在理解交叉验证的理论基础后,实际操作中的实践技巧同样关键。有效的实践技巧不仅可以提高模型的泛化能力,还可以优化开发周期,提升计算效率。

3.1 实现交叉验证的代码框架

3.1.1 通用代码模式

在多数编程语言和机器学习库中,实现交叉验证的基本思路是将数据集分为训练集和测试集,然后对模型进行多次训练和评估。下面是一个通用的交叉验证代码模式:

- from sklearn.model_selection import cross_val_score

- from sklearn.ensemble import RandomForestClassifier

- from sklearn.datasets import load_iris

- # 加载数据

- iris = load_iris()

- X = iris.data

- y = iris.target

- # 初始化分类器

- clf = RandomForestClassifier()

- # 交叉验证

- scores = cross_val_score(clf, X, y, cv=5) # cv参数定义了K折交叉验证的折数

- # 输出结果

- print("Accuracy scores for each fold are:", scores)

- print("Average accuracy is:", scores.mean())

3.1.2 代码结构的优化

随着数据集的增大或者模型复杂度的提升,计算资源可能成为限制因素。优化代码结构是提高效率的关键。比如,可以使用joblib库来并行化计算过程:

- from joblib import Parallel, delayed

- from sklearn.model_selection import KFold

- from sklearn.metrics import accuracy_score

- import numpy as np

- def compute_score(model, X, y, train, test):

- model.fit(X[train], y[train])

- y_pred = model.predict(X[test])

- return accuracy_score(y[test], y_pred)

- X, y = load_iris(return_X_y=True)

- model = RandomForestClassifier()

- k_fold = KFold(n_splits=5)

- results = Parallel(n_jobs=-1)(delayed(compute_score)(model, X, y, train, test)

- for train, test in k_fold.split(X))

- print(results)

这段代码中,我们使用了joblib的Parallel和delayed来并行计算每次交叉验证的准确度,n_jobs=-1参数让程序使用所有可用的CPU核心。

3.2 交叉验证中常见问题分析

3.2.1 数据不平衡问题

数据不平衡是指不同类别的样本数量差异显著。这种情况下,交叉验证可能会导致某些类别的样本在训练集中被频繁使用,而在其他折中被忽略。解决方案包括:

- 重采样技术,如过采样少数类或者欠采样多数类。

- 使用分层采样确保每类样本在训练集和测试集中的分布接近原始数据集的分布。

3.2.2 计算资源与时间效率

交叉验证是一个计算密集型的任务,尤其是当模型训练复杂或者数据集很大时。提高效率的方法包括:

- 利用并行计算和分布式处理。

- 对模型的参数进行先验筛选,以减少交叉验证的总次数。

3.3 交叉验证参数调优

3.3.1 超参数优化方法

在交叉验证中进行超参数调优可以增强模型的泛化能力。一种常用的方法是网格搜索(Grid Search):

- from sklearn.model_selection import GridSearchCV

- param_grid = {

- 'n_estimators': [10, 50, 100, 200],

- 'max_depth': [None, 10, 20, 30]

- }

- grid_search = GridSearchCV(estimator=clf, param_grid=param_grid, cv=5)

- grid_search.fit(X, y)

- print("Best parameters found: ", grid_search.best_params_)

3.3.2 自动化网格搜索与交叉验证

为了进一