迁移学习与多任务学习:2大协同效应与4个实践案例

发布时间: 2024-09-06 06:08:51 阅读量: 74 订阅数: 66

自然语言处理领域中大规模多任务迁移学习与ExT5模型的研究

# 1. 迁移学习与多任务学习概述

## 1.1 人工智能的发展与挑战

人工智能技术持续进步,已经广泛应用于数据挖掘、语音识别、图像分析等多个领域。然而,现有技术面临数据集限制、模型泛化能力不足以及计算资源要求高的问题。

## 1.2 迁移学习与多任务学习的出现

为解决这些问题,迁移学习和多任务学习应运而生。它们通过在不同任务间共享知识,减少对大规模标注数据的依赖,提高模型的泛化能力,降低计算成本。

## 1.3 本章内容预告

本章将介绍迁移学习与多任务学习的基本概念、关键技术和实践应用。让读者对这两个领域有一个全面的认识,并为深入学习后续章节打下坚实的基础。

# 2. ```

# 第二章:迁移学习的理论基础与实践策略

在第二章中,我们将深入探讨迁移学习的理论基础,并详细解读实践策略。本章分为三个主要部分,首先将介绍迁移学习的基本概念,其次会探讨迁移学习的关键技术,最后通过实践案例分析,理解迁移学习在不同领域的应用情况。

## 2.1 迁移学习的基本概念

### 2.1.1 从传统机器学习到迁移学习

在深入讨论迁移学习之前,我们先来回顾一下传统机器学习方法。传统机器学习依赖于大量的标记数据进行训练,当面对具有不同分布的新任务时,模型往往需要从头开始学习,这导致了效率低下和资源浪费的问题。

迁移学习的出现正是为了解决这一难题。它的核心思想是利用一个任务上学习到的知识,来帮助另一个任务的学习。这可以是同一个领域的不同任务,也可以是完全不同领域的任务。通过迁移学习,可以将源任务中的知识迁移到目标任务中,减少目标任务所需的训练数据量,并加速模型的收敛速度。

### 2.1.2 迁移学习的主要类型

迁移学习主要有以下几种类型:

- **实例迁移(Instance-based Transfer)**:直接迁移源任务的训练样本到目标任务,作为额外的训练数据。

- **特征迁移(Feature-representation Transfer)**:迁移源任务中学到的特征表示,如自动编码器或预训练的深度网络。

- **模型迁移(Model-based Transfer)**:迁移源任务中学到的模型参数,例如迁移神经网络模型的权重。

- **关系迁移(Relation-based Transfer)**:在关系型数据上迁移知识,例如使用知识图谱等。

- **正则化迁移(Regularization-based Transfer)**:在模型训练过程中加入正则项,强制模型学习与源任务相似的特征或结构。

## 2.2 迁移学习的关键技术

### 2.2.1 特征提取与迁移

特征提取与迁移是迁移学习中最基本的技术之一。其核心目标是提取出源任务中对目标任务仍然有用的知识。这通常通过预训练一个深度网络在源任务上,然后在目标任务上对模型进行微调来实现。例如,在计算机视觉领域,预训练的卷积神经网络(CNN)在ImageNet数据集上学习的特征可以迁移到其他图像分类任务中。

### 2.2.2 适应性调整方法

适应性调整方法的目的是使迁移后的模型更好地适应新任务。这包括使用少量目标任务数据进行微调(fine-tuning),或者调整模型结构以适应目标任务的特定需求。微调通常涉及到调整网络的最后几层,以学习更符合目标任务的特征表示。这种方法允许模型在保留已有知识的同时,快速适应新任务。

### 2.2.3 算法选择与比较

在众多迁移学习算法中,选择合适的算法对于获得最优性能至关重要。常见的算法包括基于领域适应的方法(如最大均值差异MMDS),基于模型适应的方法(如迁移组件分析TCA),以及基于元学习的方法(如模型无关的元学习MAML)。不同算法的性能依赖于特定的任务和数据集,因此选择算法时需要考虑任务的特性和数据的分布。

## 2.3 迁移学习的实践案例分析

### 2.3.1 图像识别中的迁移学习应用

在图像识别领域,迁移学习的应用非常广泛。以卷积神经网络(CNN)为例,预训练模型如VGG、ResNet等在大型数据集如ImageNet上学习到的特征可以迁移到其他图像识别任务中。例如,在医疗影像分析中,由于专业标注数据的稀缺,可以采用迁移学习技术,使用在大规模自然图像数据集上预训练的网络来识别CT或MRI图像中的病变区域。

### 2.3.2 自然语言处理的迁移策略

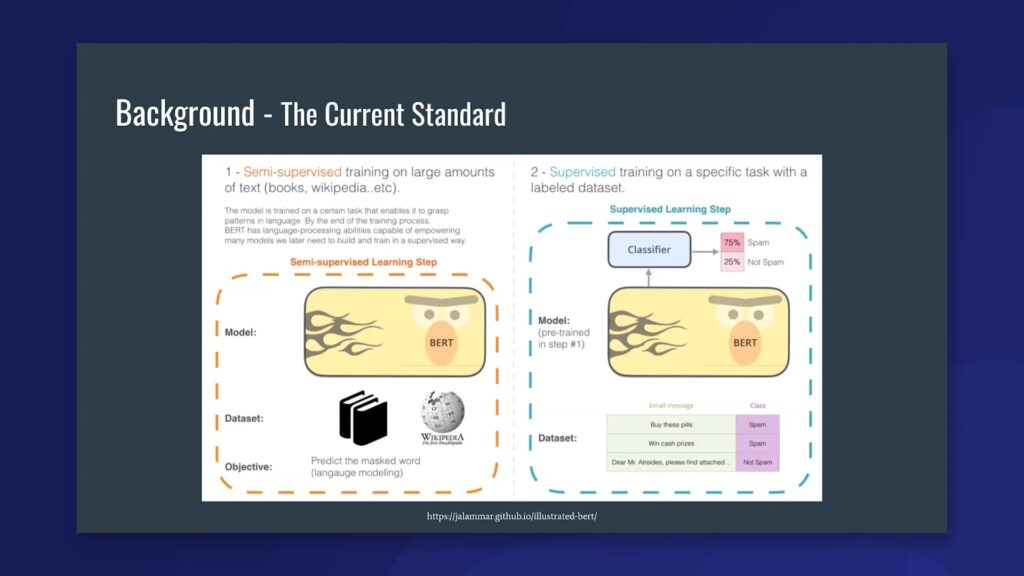

自然语言处理(NLP)领域的任务同样可以从迁移学习中受益。例如,在情感分析任务中,可以从大型通用语言模型(如BERT、GPT等)迁移预训练的知识,然后在特定领域如酒店评论或社交媒体帖子上进行微调。通过迁移学习,我们可以大大减少对大量标注数据的依赖,并显著提高模型在特定任务上的表现。

```

通过以上章节,我们对迁移学习的理论基础和实践策略有了一个清晰的认识。在下一章中

0

0