迁移学习在边缘计算中的应用:2个关键原因与实践指南

发布时间: 2024-09-06 06:02:22 阅读量: 270 订阅数: 62

# 1. 迁移学习与边缘计算概述

在当今的IT行业中,数据的处理和分析是推动技术创新的关键动力。随着计算需求的日益增长,传统的云计算模型在数据传输、延迟和隐私保护等方面面临挑战。在此背景下,迁移学习和边缘计算的结合应运而生,成为解决这些问题的一种有效方式。边缘计算将数据处理和分析任务分散到网络的边缘,即将计算资源靠近数据源的位置进行,以减少延迟、提高效率并加强数据隐私保护。而迁移学习则是一种让计算机系统通过已有的知识学习新任务的技术,它能够减少对大量标注数据的依赖,并加快模型的训练速度。

## 1.1 边缘计算的定义和重要性

边缘计算通过在数据源附近进行数据处理,能够有效减少数据传输的时间和带宽使用,这在实时应用中尤为重要。例如,在自动驾驶汽车中,边缘计算可以实时处理来自车辆传感器的数据,做出快速决策,避免了将数据发送到云服务器并等待响应的过程,大大提高了反应速度和安全性。

## 1.2 迁移学习的基本原理和优势

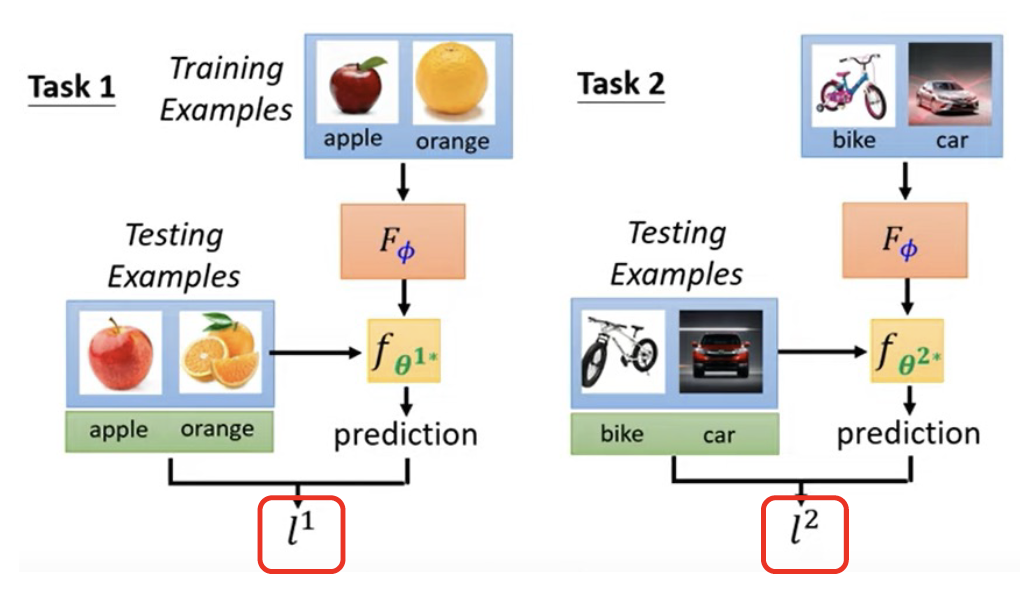

迁移学习允许算法将一个领域中学到的知识应用到另一个相关领域,从而加速学习过程并改善在新领域中的性能。它对于数据稀缺或获取成本高昂的场景尤其有价值。例如,一个在大规模图像识别任务中训练好的深度学习模型可以迁移到特定行业的图像识别任务中,通过微调模型参数,可以在没有大量标注数据的情况下达到较好的识别效果。这不仅节省了数据收集和标注的成本,还缩短了模型开发的周期。

接下来的章节中,我们将详细探讨迁移学习在边缘计算中的关键优势、理论基础以及它们在实践中的应用案例。

# 2. 迁移学习在边缘计算中的关键优势

### 2.1 数据隐私与安全的提升

在信息技术飞速发展的今天,数据隐私和安全问题日益凸显。边缘计算由于其在数据处理模式上的特殊性,天然具有保护用户数据隐私和安全的优势。

#### 2.1.1 边缘计算数据处理模式

边缘计算依赖于在数据源附近进行数据处理,而不需要将数据传输到云中心。这种模式在处理敏感数据时特别有用。举一个简单的例子,智能家庭系统可以使用边缘计算来处理家庭网络内的数据,避免将数据发送到外部服务器,从而在很大程度上减少了数据泄露的风险。

```mermaid

graph LR

A[用户数据] -->|本地处理| B[边缘设备]

B -->|结果反馈| A

A -->|需要进一步处理| C[云端服务器]

C -->|更新模型| B

```

在上述的场景中,家庭中的智能设备(例如:智能音箱、摄像头等)在处理数据时可以保留信息在本地进行计算,仅在特定情况下(比如需要更复杂的处理能力时)才与云端服务器通信。

#### 2.1.2 迁移学习的隐私保护机制

迁移学习允许从一个任务学习的知识被迁移到另一个任务上,同时不需要直接共享原始数据。通过迁移学习,可以将训练好的模型部署到边缘设备上,让设备拥有智能分析的能力,而不必担心原始数据的隐私问题。

```markdown

| 模型部署方法 | 描述 |

|-------------------|------------------------------------------|

| 完整模型部署 | 将整个训练好的模型部署到边缘设备上,适用于数据量较小的情况。 |

| 特征提取模型部署 | 只在边缘设备部署特征提取部分,适用于需要本地实时处理的场景。 |

| 增量学习模型部署 | 在边缘设备上进行模型的进一步训练,以适应本地数据变化。 |

```

### 2.2 资源效率与实时性的优化

在边缘计算中,资源效率和实时性是两个重要的考量因素。而迁移学习为这两方面提供了显著的优化。

#### 2.2.1 边缘设备的计算资源限制

边缘设备,如智能手机、嵌入式系统等,通常具有有限的计算资源。在这些设备上运行复杂的深度学习模型往往不可行。然而,通过迁移学习,可以将大型深度学习模型简化,以适应边缘设备的资源限制。

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

# 定义一个轻量级的深度学习模型

class LightweightModel(nn.Module):

def __init__(self):

super(LightweightModel, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(16, 8, kernel_size=3, padding=1)

self.fc1 = nn.Linear(8*32*32, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = F.relu(self.conv1(x))

x = F.max_pool2d(x, 2)

x = F.relu(self.conv2(x))

x = F.max_pool2d(x, 2)

x = x.view(-1, 8*32*32)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

```

#### 2.2.2 迁移学习模型压缩与加速

模型压缩是通过减少模型的大小或复杂度来优化模型的过程,这样模型就能更快地在边缘设备上运行。一个典型的例子是使用知识蒸馏方法,它涉及一个大型的、知识丰富的模型(教师模型)去训练一个更小、更轻量级的模型(学生模型)。

```python

# 假设我们有一个预训练的大型模型 teacher_model

# 以及一个我们希望压缩的模型 student_model

# 定义损失函数

def loss_fn_kd(outputs, labels, teacher_outputs, alpha=0.5, temperature=5.0):

"""

Knowledge distillation loss function.

:param outputs: student model output

:param labels: one-hot encoded labels

:param teacher_outputs: teacher model output

:param alpha: weight for soft targets

:param temperature: temperature parameter for soft targets

:return: loss value

"""

hard_loss = F.cross_entropy(outputs, labels)

soft_loss = F.kl_div(F.log_softmax(outputs/temperature, dim=1),

F.softmax(teacher_outputs/temperature, dim=1),

reduction='batchmean') * (temperature * temperature)

return hard_loss + alpha * soft_loss

# 训练学生模型

for epoch in range(num_epochs):

# 假设 inputs 和 true_labels 是从数据集中获取的

outputs = student_model(inputs)

teacher_outputs = teacher_model(inputs)

loss = loss_fn_kd(outputs, true_labels, teacher_outputs)

# 然后根据损失值进行梯度下降...

```

通过这种方法,不仅可以减少模型的参数数量,还能提高模型的运行速度,使其更适用于边缘设备上。

# 3. 迁移学习理论基础

迁移学习的核心目标是在不同但相关领域之间迁移知识,从而减少新任务的学习成本和提高学习效率。为了实现这一目标,研究者们开发了多种策略和算法,这些理论基础构成了迁移学习的核心,并在实践中不断进化。

## 3.1 迁移学习的核心概念

在深入讨论具体的迁移学习算法和应用之前,首先需要明确迁移学习领域内的几个核心概念。

### 3.1.1 域适应与模型迁移

在迁移学习中,域的概念代表了不同的数据分布。源域通常包含大量的标注数据,而目标域数据量较少,且标注成本较高。域适应关注如何减少源域与目标域之间的分布差异,从而将从源域学到的知识应用到目标域。这是通过模型迁移实现的,模型迁移的目标是让模型能够在目标域上展现出良好的性能,即使它在目标域上的训练数据有限。

### 3.1.2 迁移学习的主要策略

迁移学习策略主要分为三类:

- **单源单目标**:这种策略指的是从单一源域迁移到单一目标域,是最常见的迁移学习场

0

0