训练轮次过多或过少的后果:深度学习模型最佳Epochs的急迫寻找

发布时间: 2024-11-25 11:46:01 阅读量: 115 订阅数: 32

PyTorch Lightning:简化深度学习训练的革命

# 1. 深度学习模型的Epochs简介

## 1.1 Epochs的基本概念

在深度学习领域,Epochs通常指的是整个训练数据集(training dataset)被输入到神经网络中进行一次完整的训练过程。这意味着每个Epoch都会经历前向传播和反向传播,更新模型的权重和偏置。Epochs数量的选择对模型的训练和性能有着重要影响。太少的Epoch可能导致模型未能充分学习数据中的模式(underfitting),而过多的Epoch可能导致模型在训练数据上过度学习,从而无法良好地泛化到未见数据上(overfitting)。

## 1.2 Epochs在模型训练中的作用

Epochs是控制模型训练深度的关键参数之一。一个高效的训练过程需要确保模型能够在学习到数据特征的同时避免过拟合。为了达到这一平衡,数据科学家通常会在多个Epochs上迭代模型,观察训练和验证集上的性能变化。实践中,通常结合验证集的性能来确定合适的Epochs值,以达到模型性能的最优。

## 1.3 调整Epochs的策略

调整Epochs需要考虑到数据集的大小、模型的复杂度以及计算资源的限制。一般来说,较小的数据集或更复杂的模型可能需要更多的Epochs来保证模型收敛。在实际操作中,可以通过设置一个合理的Epochs上限,配合早停(early stopping)等技术,来避免过拟合,并提高模型训练的效率。接下来的章节将深入探讨模型训练的理论基础,为更好地理解和应用Epochs提供坚实的基础。

# 2. 理论基础:模型训练与过拟合

## 2.1 模型训练的理论框架

### 2.1.1 损失函数和优化器的选择

在深度学习模型训练中,损失函数(Loss Function)和优化器(Optimizer)是两个核心概念。损失函数衡量的是模型预测值与实际值之间的差异,而优化器负责调整模型的权重参数以最小化损失函数。损失函数的选择依赖于特定问题的类型,例如回归问题常使用均方误差(MSE),分类问题则可能使用交叉熵损失(Cross-Entropy)。

在选择优化器时,常用的有SGD(随机梯度下降)、Adam、RMSprop等。不同的优化器有着不同的学习速度和稳定性。SGD简单但可能需要精心调整学习率,而Adam则在很多情况下能够自动适应学习率,使训练过程更快收敛。

代码示例:

```python

from keras import optimizers

# 创建一个简单的模型

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(input_size,)))

model.add(Dense(num_classes, activation='softmax'))

# 编译模型,使用交叉熵损失和Adam优化器

model.compile(loss='categorical_crossentropy',

optimizer=optimizers.Adam(),

metrics=['accuracy'])

```

### 2.1.2 模型泛化能力的理论基础

泛化能力指的是模型对未见过数据的处理能力。在理论上,模型应具有良好的泛化能力,即在训练集上学习规律,在测试集上正确预测。模型的泛化能力与模型复杂度、数据分布、以及训练集的大小密切相关。过于复杂的模型容易在训练集上过拟合,即学习到训练数据中的噪声而非真实规律。

为了提高模型泛化能力,可采取数据增强、正则化、减少模型复杂度等策略。数据增强通过对训练数据进行各种变换,增加模型的鲁棒性。正则化通过向损失函数添加惩罚项,如L1或L2惩罚项,防止模型复杂度过高。

## 2.2 过拟合现象的识别与理解

### 2.2.1 过拟合的定义和表现

过拟合(Overfitting)是指模型过于复杂,以至于在训练集上表现良好,而在测试集上性能大幅下降的现象。其表现形式可以是训练集上的准确度非常高,测试集上的准确度远低于训练集,或者训练误差持续下降但验证误差不再改善。

### 2.2.2 过拟合的常见原因分析

过拟合的原因多种多样,主要包括:

- 训练数据不足:模型无法从有限的样本中学习到普遍规律。

- 模型复杂度过高:模型参数过多,能够拟合训练数据中的噪声。

- 训练时间过长:在训练过程中,模型可能最终学习到的是训练数据的特异性而非普遍性。

- 数据预处理不充分:数据噪声或未被适当归一化可能引起过拟合。

## 2.3 防止过拟合的策略

### 2.3.1 数据增强技术

数据增强通过一系列变化手段增加训练数据的多样性,常见的增强技术包括旋转、缩放、裁剪、颜色调整等。数据增强有助于模型捕捉到数据的内在特性,从而减少过拟合。

### 2.3.2 正则化方法

正则化通过在损失函数中添加惩罚项来限制模型的复杂度,常用的方法有L1正则化(Lasso)和L2正则化(Ridge)。L1惩罚会导致模型参数稀疏化,而L2则倾向于将参数值控制在较小范围内。

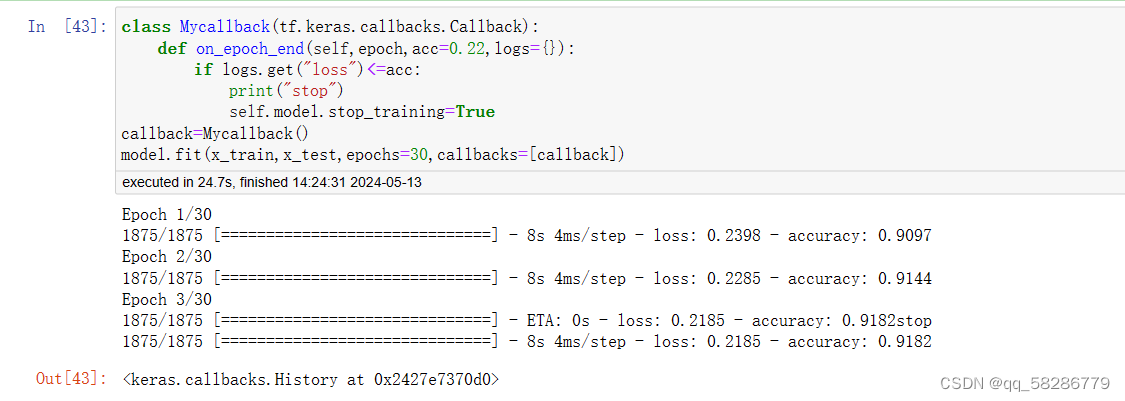

### 2.3.3 早停策略

早停(Early Stopping)策略通过监控模型在验证集上的表现来决定训练终止的时机。具体做法是保存在验证集上性能最佳的模型参数,一旦验证性能不再提升,训练即停止。这有助于防止过拟合,同时减少计算资源消耗。

在下一章节,我们将继续探讨如何通过实验设计来寻找最佳的Epochs,以优化模型训练过程。

# 3. 实验设计:寻找最佳Epochs

实验设计是模型优化中不可或缺的一环,尤其在确定最佳Epochs时显得尤为重要。这一章节将详细探讨如何通过实验设计寻找最佳的Epochs,确保模型在训练过程中既不过拟合也不欠拟合。本章将涵盖从实验设计步骤和方法到监控指标和评价方法,最后通过案例研究对不同模型的Epochs进行对比分析。

## 实验设计的步骤和方法

### 设定实验的参数空间

在开始实验之前,设定一个明确的参数空间是至关重要的。这一参数空间应包括不同的Epochs值,以及其他可能影响模型性能的超参数,例如学习率、批量大小和优化器类型。例如,在深度学习中,我们可以设定一个基于经验的Epochs范围,如10至100,并在这一范围内进行等比或等差数列的数值实验。

```python

# 示例:使用Python进行参数空间的定义

import numpy as np

# 设定Epochs的参数空间,假设我们从10开始,到100结束,增长率为2

epochs_space = np.arange(10, 101, 2)

# 除了Epochs之外,可能还需要定义其他超参数空间

learning_rates = [0.001, 0.01, 0.1]

batch_sizes = [16, 32, 64]

```

### 使用交叉验证确保结果的可靠性

交叉验证是一种强大的模型评估技术,它能够减少模型因训练集和测试集划分不同而产生的偏差。对于Epochs的确定,通常采用k折交叉验证,即把数据集划分为k个子集,轮流将其中k-1个子集作为训练数据,剩下的一个子集作为验证数据。这样可以确保每个子集都有机会作为验证数据,减少偶然性的影响。

```python

# 示例:使用k折交叉验证

from sklearn.model_selection import KFold

# 假设我们有4折交叉验证

kf = KFold(n_splits=4, shuffle=True, random_state=1)

# 对每个Epochs进行交叉验证

for epoch in epochs_space:

for train_index, val_index in kf.split(X, y):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 这里将进行模型的训练和验证

# ...

```

## 监控指标和评价方法

### 训练和验证误差的跟踪

在模型训练过程中,监控训练和验证误差至关重要。训练误差能够告诉我们在训练数据上的性能,而验证误差则能够反映模型在未见数据上的泛化能力。通过比较这两者的趋势,我们可以判断模型是否出现过拟合或欠拟合现象。

```python

# 示例:跟踪训练和验证误差

import matplotlib.pyplot as plt

# 假设train_losses和val_losses是从模型训练过程中收集到的误差值

train_losses = [...]

val_losses = [...]

# 绘制训练和验证误差的曲线

plt.plot(train_losses, label='Training Loss')

plt.plot(val_losses, label='Validation Loss')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

plt.show()

```

### 性能指标的选择与应用

在确定最佳Epochs时,选择合适的性能指标至关重要。对于分类问题,准确率、精确度、召回率和F1分数是常用的指标。对于回归问题,则可能需要使用均方误差(MSE)或平均绝对误差(MAE)。选择这些指标时,应考虑业务需求和模型的应用场景。

```python

# 示例:计算并应用性能指标

from sklearn.metrics import accuracy_score, f1_score

# 假设y_true是真实标签,y_pred是模型预测的标签

y_true = [...]

y_pred = [...]

# 计算准确率和F1分数

accuracy = accuracy_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

# 打印性能指标

print(f"Accuracy: {accuracy}")

print(f"F1 Score: {f1}")

```

## 案例研究:不同模型的Epochs对比

### 线性模型的Epochs分析

线性模型(如线性回归、逻辑回归)通常不需要太多个Epochs就能收敛。由于其结构相对简单,过拟合风险较低。但是,选择合适的Epochs仍然可以提高模型的性能,尤其是在数据量较大时。

```mermaid

graph TD;

A[开始] --> B[设定线性模型参数]

B --> C[训练模型]

C --> D[评估模型性能]

D --> E[确定最佳Epochs]

E --> F[结束]

```

### 深度神经网络模型的Epochs分析

深度神经网络由于其复杂的结构,通常需要更多的Epochs来充分训练。然而,过大的Epochs值可能导致过拟合,特别是在数据量有限的情况下。因此,深度学习中寻找最佳Epochs的过程往往伴随着正则化技术和早停策略的使用。

```python

# 示例:深度神经网络训练与Epochs的确定

from keras.models import Sequential

from keras.layers import Dense

from keras.callbacks import EarlyStopping

# 创建一个简单的深度神经网络模型

model = Sequential([

Dense(64, activation='relu', input_shape=(input_size,)),

Dense(1, activation='sigmoid')

])

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 使用EarlyStopping来防止过拟合

early_stopping = EarlyStopping(monitor='val_loss', patience=5)

# 训练模型,同时记录Epochs

history = model.fit(X_train, y_train, epochs=100, validation_data=(X_val, y_val), callbacks=[early_stopping], verbose=0)

# 绘制训练过程中的误差曲线

plt.plot(history.history['loss'], label='Training Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Epochs vs. Loss')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.show()

```

在本章节中,我们详细介绍了实验设计在寻找最佳Epochs中的重要性,并通过具体示例展示了如何在实践中应用这些方法。下一章节,我们将深入探讨如何利用Epochs与其他超参数之间的关系来进一步优化模型。

# 4. 模型调优:基于Epochs的超参数优化

## 4.1 Epochs与其他超参数的关系

### 4.1.1 Epochs与学习率的交互影响

在深度学习中,学习率和Epochs是两个关键的超参数,它们共同影响着模型的收敛速度和最终性能。学习率决定了模型在参数空间中每一步移动的大小,而Epochs则是模型完成一次完整的数据集遍历次数。

在训练过程中,过高的学习率可能导致模型参数更新过于激进,从而无法收敛到最优解;反之,学习率过低,则会导致收敛速度过慢,需要更多的Epochs来达到良好的性能。因此,找到合适的学习率和Epochs之间的平衡是模型调优的重要环节。

一般来说,当学习率较高时,模型可能需要较少的Epochs来近似找到最优解,但在高学习率下容易震荡,甚至发散;而较低的学习率则意味着需要更多的Epochs来精细调整参数,达到更好的模型性能。

### 4.1.2 Epochs与批量大小的协同调整

批量大小(batch size)也是影响模型训练的重要超参数之一。Epochs与批量大小之间存在一定的交互关系,合理地选择它们对优化模型性能至关重要。

当批量大小较小时,每次权重更新会根据较少的数据进行,这会引入更多的随机性,模拟更多次的梯度估计,有助于模型跳出局部最优解,但同时也增加了训练时间,可能需要更多的Epochs来收敛。而较大的批量大小可以加快每次权重更新的速度,减少训练时间,但过大的批量大小可能会使模型在收敛时停留在局部最优解。

### 4.1.3 超参数协同调整的策略

调整超参数时,我们可以采取以下策略来协同优化Epochs、学习率和批量大小:

1. **初步探索**:在小数据集上初步测试不同的学习率和批量大小组合,记录各组合的收敛情况和最终性能。

2. **增加Epochs**:在初步探索的基础上,选择表现较好的超参数组合,增加Epochs次数,细致地观察模型性能的变化。

3. **微调学习率和批量大小**:基于前两步的结果,调整学习率和批量大小的数值,再进行细致的搜索。

4. **使用学习率调度器**:在训练过程中动态调整学习率,如学习率衰减策略或学习率预热。

5. **并行实验**:使用多GPU并行计算能力,同时运行多个超参数组合实验,缩短整体的调优时间。

通过上述策略,我们可以在模型训练中找到一个有效的Epochs值,同时保持其他超参数的协同优化。

## 4.2 自动化工具和方法

### 4.2.1 超参数优化算法简介

超参数优化(Hyperparameter Optimization)是指选择和调整机器学习模型的超参数,以获得最佳性能的过程。超参数优化算法主要包括以下几种:

- **网格搜索(Grid Search)**:是一种穷举搜索方法,通过定义参数的范围和步长,遍历所有的参数组合,并评估每一种组合的模型性能。

- **随机搜索(Random Search)**:与网格搜索类似,但它是随机选择参数的组合进行实验,可以更快地找到较好的参数组合,尤其是当参数空间非常大时。

- **贝叶斯优化(Bayesian Optimization)**:利用贝叶斯方法构建一个性能估计模型,并使用这个模型来指导搜索过程,选择最有希望的参数组合进行实验。

### 4.2.2 使用网格搜索和随机搜索进行优化

#### 网格搜索

网格搜索通常通过遍历一个预定义的参数网格来进行模型训练。例如,如果我们有两个超参数:学习率`lr`和批量大小`batch_size`,我们可以定义一个网格:

```python

param_grid = {

'lr': [0.01, 0.001, 0.0001],

'batch_size': [16, 32, 64]

}

```

然后,我们可以使用`GridSearchCV`方法(在scikit-learn中)来进行网格搜索:

```python

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

svm = SVC()

clf = GridSearchCV(svm, param_grid, cv=5)

clf.fit(X_train, y_train)

```

#### 随机搜索

随机搜索则是从定义好的分布中随机选择参数值进行实验。例如:

```python

from sklearn.model_selection import RandomizedSearchCV

svm = SVC()

param_dist = {

'lr': [0.01, 0.001, 0.0001],

'batch_size': [16, 32, 64]

}

clf = RandomizedSearchCV(svm, param_distributions=param_dist, n_iter=10, cv=5)

clf.fit(X_train, y_train)

```

### 4.2.3 高级优化技术:贝叶斯优化方法

贝叶斯优化方法相比于网格搜索和随机搜索,更加高效。它使用贝叶斯推断来构建目标函数的近似模型,并结合这些信息来选择下一次迭代中最有希望的参数。

```python

from hyperopt import fmin, tpe, hp, STATUS_OK, Trials

space = {

'lr': hp.loguniform('lr', -6, -3),

'batch_size': hp.choice('batch_size', [16, 32, 64])

}

def objective(params):

params = {'lr': 10 ** params['lr'], 'batch_size': params['batch_size']}

model = train_model(params)

loss = evaluate_model(model)

return {'loss': loss, 'status': STATUS_OK}

trials = Trials()

best = fmin(fn=objective,

space=space,

algo=tpe.suggest,

max_evals=100,

trials=trials)

```

贝叶斯优化方法能够有效地平衡探索和利用,避免了在不重要的参数区域进行过多的搜索,并且能够更快地找到性能良好的参数组合。

### 4.2.4 超参数优化策略的选择

选择合适的超参数优化策略取决于具体的应用场景和资源限制:

- **资源受限**:如果计算资源有限,可以使用随机搜索,因为它通常能够在较少的试验次数内找到不错的参数组合。

- **参数空间小**:如果参数空间不大,网格搜索可以保证找到全局最优解。

- **需要高效调优**:当需要更高效的调优策略时,贝叶斯优化是一个很好的选择。

在实际应用中,我们还可以结合多种方法,如先使用随机搜索缩小搜索范围,然后用贝叶斯优化进行精细调优。此外,考虑到不同的深度学习框架和库,如TensorFlow、PyTorch或Keras,它们提供的API和工具能够帮助我们更好地实现超参数的自动优化。

# 5. 实践应用:深度学习模型训练的实战技巧

## 5.1 数据集准备和预处理

在深度学习项目中,数据集的准备和预处理是至关重要的步骤。模型的性能在很大程度上取决于输入数据的质量。本节将重点介绍数据集的划分与标准化,以及特征选择和数据增强的方法。

### 5.1.1 数据集的划分与标准化

划分数据集是将原始数据分为训练集、验证集和测试集的过程。这是为了确保模型在未见数据上的泛化能力。通常,按照70%训练、15%验证、15%测试的比例来划分数据。在划分之前,要确保数据是随机的,以避免可能的数据偏差。

数据标准化是指将数据按比例缩放,使之落入一个小的特定区间,通常是对特征值做归一化或标准化。归一化是将特征值缩放到[0, 1]区间,而标准化则是缩放到均值为0,标准差为1的分布。

```python

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# 假设data是特征矩阵,labels是对应的标签

data_train, data_temp, labels_train, labels_temp = train_test_split(data, labels, test_size=0.3, random_state=42)

data_val, data_test, labels_val, labels_test = train_test_split(data_temp, labels_temp, test_size=0.5, random_state=42)

# 使用StandardScaler进行标准化

scaler = StandardScaler()

data_train = scaler.fit_transform(data_train)

data_val = scaler.transform(data_val)

data_test = scaler.transform(data_test)

```

### 5.1.2 特征选择和数据增强

特征选择是减少数据维度的技术,它有助于提高模型的训练速度和预测准确率。常用的特征选择技术包括单变量特征选择、递归特征消除等。

数据增强是通过增加数据集的多样性和复杂性来防止模型过拟合的技术。对于图像数据,常见的数据增强包括旋转、缩放、裁剪、颜色变换等。

```python

# 以图像数据为例展示数据增强

from tensorflow.keras.preprocessing.image import ImageDataGenerator

datagen = ImageDataGenerator(

rotation_range=40,

width_shift_range=0.2,

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest')

```

## 5.2 模型训练的高级技巧

### 5.2.1 梯度爆炸与消失的预防

梯度爆炸和梯度消失是训练深度神经网络时常见的问题。梯度爆炸通常可以通过梯度裁剪(梯度规范化)解决,而梯度消失则可以通过使用ReLU或其变种激活函数缓解。

```python

# 使用Keras中的Lambda层进行梯度裁剪

from tensorflow.keras import backend as K

from tensorflow.keras.layers import Lambda

def clip_valueLayer(value=1.0):

def clip_value(x):

return K.clip(x, -value, value)

return Lambda(clip_value)

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(input_size,)))

model.add(clip_valueLayer(value=1.0))

model.add(Dense(num_classes, activation='softmax'))

```

### 5.2.2 使用预训练模型和迁移学习

预训练模型和迁移学习是利用已有的深度学习模型作为起点来训练新的模型。这在数据量较少时特别有用,可以显著加快训练速度并提高模型性能。

```python

from tensorflow.keras.applications import VGG16

from tensorflow.keras.models import Model

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

# 构建新的模型,仅训练顶部的几层

x = base_model.output

x = Flatten()(x)

x = Dense(256, activation='relu')(x)

predictions = Dense(num_classes, activation='softmax')(x)

model = Model(inputs=base_model.input, outputs=predictions)

# 冻结预训练模型的所有层

for layer in base_model.layers:

layer.trainable = False

# 训练模型

model.compile(optimizer='adam', loss='categorical_crossentropy')

model.fit(train_data, train_labels, epochs=10, validation_data=(validation_data, validation_labels))

```

## 5.3 模型验证和测试

### 5.3.1 使用验证集进行中间检查

在模型训练过程中,使用验证集进行模型的中间检查是非常重要的。验证集可以用来监控模型在未见数据上的表现,从而调整超参数或提前停止训练以防止过拟合。

```python

# 使用回调函数实现早停策略

early_stopping = EarlyStopping(monitor='val_loss', patience=3, verbose=1, restore_best_weights=True)

model.fit(train_data, train_labels, epochs=100, validation_data=(validation_data, validation_labels), callbacks=[early_stopping])

```

### 5.3.2 测试集上的最终评估

模型经过训练和验证后,最终需要在独立的测试集上进行评估。这一步骤是确认模型泛化能力的关键环节,用于报告模型在生产环境中的预期性能。

```python

# 在测试集上评估模型

loss, accuracy = model.evaluate(test_data, test_labels)

print(f"Test loss: {loss}")

print(f"Test accuracy: {accuracy}")

```

以上是深度学习模型训练中的一些实战技巧。通过合理的数据预处理和模型训练技巧,我们可以有效地提升模型的性能和泛化能力。

# 6. 深入探索:Epochs在特定应用中的研究

## 6.1 在计算机视觉中的应用

在计算机视觉领域,Epochs这一概念对模型性能的影响尤为重要,因为视觉任务往往需要大量的数据和复杂的模型结构来获得高精度的识别和分类结果。

### 6.1.1 Epochs对图像分类任务的影响

在图像分类任务中,Epochs的多少直接决定了模型训练的充分程度。过多或过少都可能导致性能不佳。例如,一个较低的Epochs值可能导致模型未能充分学习数据的特征,而过高的Epochs值可能导致模型记忆训练数据的噪声,即过拟合。因此,寻找合适的Epochs值是实现良好泛化能力的关键。通常,通过观察验证集的性能来决定最佳的Epochs数。

```python

# 伪代码示例:根据验证集性能调整Epochs

for epoch in range(100): # 假设最多训练100个Epochs

model.train_on_batch(batch) # 在一个batch上进行训练

val_loss, val_acc = model.evaluate_on_validation_set() # 在验证集上进行评估

if val_acc不再提升: # 如果准确率不再提升

break # 停止训练

```

### 6.1.2 Epochs在目标检测和分割中的应用

在目标检测和分割等任务中,Epochs对于模型的收敛速度和最终性能同样有显著影响。目标检测模型如Faster R-CNN或YOLO需要大量迭代来精细定位图像中的对象,并准确地分割出对象的轮廓。此时,监控损失函数的下降以及IoU(交并比)指标,可以指导我们找到最合适的Epochs值。

## 6.2 在自然语言处理中的应用

自然语言处理(NLP)任务,如文本分类、机器翻译、问答系统等,亦受到Epochs选择的重要影响。

### 6.2.1 Epochs在文本分类任务中的角色

文本分类任务需要模型学习大量文本数据的表征,并对它们进行类别预测。使用深度学习模型如BERT或LSTM时,Epochs的选择将直接影响模型对文本特征的提取能力。通常,NLP模型需要更多的Epochs来进行训练,因为文本数据的序列性和复杂性。

### 6.2.2 Epochs对序列模型如RNN和Transformer的影响

RNN和Transformer模型在处理文本时需要维护上下文信息,这通常需要更多的迭代次数来收敛。在这些模型中,过少的Epochs可能导致模型无法捕捉到长距离依赖关系,而过多则可能导致训练时间过长,且容易过拟合。

## 6.3 跨学科视角下的Epochs研究

Epochs的研究不仅是技术问题,还涉及到跨学科的知识。

### 6.3.1 结合心理学理论对Epochs进行认知

心理学理论表明,学习过程包含识别、巩固和记忆等阶段。在深度学习中,Epochs的设定需考虑这些阶段对模型训练的启示。例如,一个过短的训练周期可能导致模型未能充分“记忆”数据模式,而过长的训练周期则可能导致“学习疲劳”。

### 6.3.2 从经济学角度探讨模型训练的ROI

从经济学角度出发,模型训练的ROI(投资回报率)是评估模型训练成本和性能提升的重要指标。Epochs的设定需权衡计算资源成本和模型性能提升的收益,过高的Epochs值可能导致ROI下降。因此,如何选择合适的Epochs以优化ROI是一个值得深入探讨的话题。

```mermaid

graph LR

A[开始训练模型] --> B[确定初始Epochs]

B --> C[监控验证集性能]

C -->|性能提升| D[增加Epochs]

C -->|性能不再提升| E[评估ROI]

D --> C

E --> F[确定最佳Epochs]

F --> G[模型部署]

```

通过上述章节的内容,我们可以看到Epochs在深度学习模型中的重要性,以及如何在不同应用中根据具体情况调整Epochs。在实际应用中,还需要结合具体任务的需求和计算资源,通过实验确定最佳的Epochs值。

0

0