Epochs与学习率的协同调整策略

发布时间: 2024-11-25 12:03:51 阅读量: 27 订阅数: 32

基于TensorFlow的LSTM情感分析模型的设计和实现.zip

# 1. 深度学习训练基础与关键概念

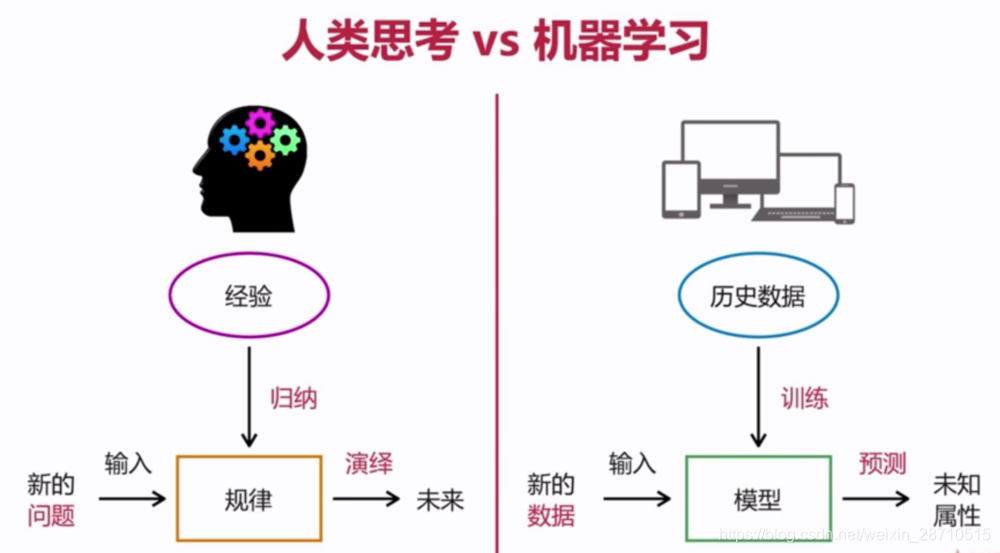

深度学习作为人工智能的一个分支,其训练过程是理解和应用各种技术与算法的核心。在这一章中,我们将从基础概念入手,奠定深度学习模型训练的理论基础。首先,将介绍神经网络的基本组成单元—神经元,及其如何相互连接形成网络结构。随后,会探讨前向传播与反向传播算法,这些是训练过程中不可或缺的环节,用于更新网络权重以最小化损失函数。最后,针对深度学习中常见的激活函数、损失函数等关键概念进行详细阐释。这一章将为读者提供进入深度学习世界的坚实基础。

# 2. 理解Epochs与学习率的理论基础

### Epochs在模型训练中的作用

#### Epochs的定义与重要性

Epochs(迭代次数)是指完整遍历整个训练数据集一次的过程。在深度学习的训练过程中,模型通过不断地学习输入数据以更新其内部参数,而一个Epoch即完成了一次这个过程。每个Epoch通常包括前向传播、损失计算和反向传播三个主要步骤。理解Epochs的重要性在于,它影响模型的收敛速度和最终的性能。

在实践中,Epochs的选择取决于训练数据集的大小以及模型的复杂度。对于小数据集,可能只需要几个Epochs,而大数据集则可能需要数十到数百的Epochs。过少的Epochs可能导致模型未能充分学习数据中的特征,而过多的Epochs可能导致过拟合,即模型过度依赖于训练数据,泛化能力下降。

#### 不同数据集大小与Epochs的关系

数据集的大小直接影响到训练所需的最佳Epochs数量。数据集较小的情况下,模型可能会很快学习到所有的数据特征,因此需要较少的Epochs即可达到稳定状态。而在大型数据集上,因为模型需要从更多的数据中学习,所以往往需要更多的Epochs。

### 学习率的基本原理

#### 学习率对训练速度的影响

学习率(Learning Rate, LR)决定了在梯度下降优化算法中参数更新的步长。如果学习率设置得太小,训练过程会非常缓慢,模型收敛至最优解的速度会非常慢。相反,如果学习率设置得过大,可能会导致训练过程不稳定,甚至出现发散的情况。因此,选择合适的学习率对于确保模型能够高效且稳定地训练至关重要。

#### 学习率与模型性能的关系

学习率不仅影响训练速度,还直接影响模型的性能。理想情况下,学习率应该足够大以便快速收敛,同时也要足够小以避免过度震荡导致的性能下降。学习率过低可能导致模型陷入局部最优解,而过高则可能无法收敛。因此,在训练过程中通常需要仔细选择和调整学习率。

### 学习率调整策略

#### 固定学习率的优缺点

固定学习率是最简单直接的学习率调整策略,即在整个训练过程中使用相同的固定值。其优点是算法实现简单,计算效率高。然而,其缺点也非常明显,因为它无法适应训练过程中的动态变化。随着训练的进行,损失函数可能会进入一个平坦区域,这时固定的学习率可能会太小,导致训练停滞不前;而在陡峭的区域,过大的学习率又可能导致模型参数波动过大,影响模型收敛。

#### 动态学习率调整方法概述

动态学习率调整方法试图解决固定学习率的局限性。这些方法在训练过程中根据某些准则自动调整学习率。常用的方法包括学习率衰减(学习率随着时间逐渐减小)、学习率预热(学习率在训练开始时较小,逐渐增大到一个稳定值)等。动态学习率调整可以帮助模型更好地适应训练过程中可能出现的不同阶段,从而提高最终的模型性能。

```python

# 示例:在PyTorch中使用学习率预热技术

scheduler = torch.optim.lr_scheduler.CyclicLR(optimizer, base_lr=0.001, max_lr=0.1, step_size_up=2000)

for epoch in range(num_epochs):

for batch in data:

# 训练模型

optimizer.zero_grad()

outputs = model(batch)

loss = criterion(outputs, batch.targets)

loss.backward()

optimizer.step()

# 更新学习率

scheduler.step()

```

在上述代码示例中,我们使用了PyTorch的`CyclicLR`学习率调整器,它会在指定的`base_lr`和`max_lr`之间周期性地调整学习率。`step_size_up`参数定义了学习率增长阶段的步数。通过学习率的动态调整,我们可以期望模型能够在训练初期避免大的振荡,而后期则能够更快速地收敛。

在本章节中,我们深入理解了Epochs和学习率这两个深度学习中的关键概念,并探讨了它们对模型训练的影响。接下来,我们将进入更进一步的实践方法章节,探讨如何在实际训练中进行Epochs和学习率的协同调整。

# 3. Epochs与学习率协同调整的实践方法

## 3.1 实战案例:自定义Epochs循环

### 3.1.1 编写自适应数据量的Epochs循环

自适应数据量的Epochs循环能够保证模型训练的高效性和充分性。在编写自定义的Epochs循环时,需要考虑到数据集的大小和复杂度,以及模型的收敛速度。以下是一个伪代码示例,用以说明如何实现一个自适应数据量的Epochs循环:

```python

import torch

def train_model(model, data_loader, num_epochs):

for epoch in range(num_epochs):

for batch in data_loader:

inputs, targets = batch

optimizer.zero_grad()

outputs = model(inputs)

loss = loss_function(outputs, targets)

loss.backward()

optimizer.step()

print(f'Epoch {epoch}/{num_epochs} completed')

# 这里可以添加监控和检查点保存的代码

return model

```

在实际应用中,我们可以使用更高级的API,例如PyTorch的`DataLoader`,来管理数据加载的迭代器,并结合`for`循环来实现更复杂的自定义循环。

### 3.1.2 Epochs循环中的性能监控技巧

性能监控是模型训练过程中的关键环节,能够帮助我们实时了解模型的训练状态和性能表现。以下是一些监控技巧:

- **训练损失和准确率**:记录每个epoch结束时的训练损失和准确率,监控是否逐渐下降或趋于稳定。

- **验证集表现**:定期在验证集上评估模型表现,监控过拟合情况。

- **学习率**:监控学习率的变化,确保在训练过程中能够适时调整学习率。

```python

# 伪代码监控逻辑

for epoch in range(num_epochs):

model.train()

for inputs, targets in data_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = loss_function(outputs, targets)

loss

```

0

0