Epochs对模型泛化能力的影响深入探讨

发布时间: 2024-11-25 11:54:14 阅读量: 19 订阅数: 32

建立深度学习模型对汽车油耗预测

# 1. 模型泛化能力的理论基础

在深度学习和机器学习领域,模型的泛化能力是指模型在未见过的数据上的表现能力。理解并提高模型的泛化能力是构建可靠系统的基石。泛化能力的强弱直接决定了一个模型能否在实际场景中得到成功的应用。

## 理论基础概述

泛化能力的理论基础涉及统计学习理论中的偏差-方差权衡(Bias-Variance Tradeoff)原理。偏差高表示模型倾向于简单化,无法捕捉数据的复杂性;方差高则表明模型对训练数据的细微变化过于敏感,容易过拟合。良好的模型应当在这两者之间取得一个平衡,以达到最优的泛化能力。

## 泛化能力与模型复杂度

模型的复杂度与泛化能力之间存在紧密的联系。模型过于简单会忽略重要特征,导致欠拟合;反之,模型过于复杂会记住噪声,引发过拟合。优化模型复杂度以增强泛化能力,是训练深度学习模型时必须考虑的问题。正确设置Epochs是达成这一目标的重要步骤之一。

# 2. Epochs在深度学习中的作用

### 2.1 Epochs概念解析

#### 2.1.1 Epochs定义及计算方法

Epochs,或者称为“迭代次数”,是深度学习中一个核心概念,代表数据集通过神经网络的次数。在训练过程中,每一个数据样本至少被处理一次,称为一个Epoch。对于每个Epoch,参数(权重)更新一次。Epochs的计算方法取决于数据集的大小(N)和批次大小(batch size)。

```

计算Epochs的公式:Epochs = Total number of training samples / (batch size * number of batches)

```

其中,Total number of training samples是训练集中样本的总数,batch size是每次向网络输入的样本数,number of batches是每个Epoch中批次的数量,它由公式number of batches = Total number of training samples / batch size计算得出。

#### 2.1.2 Epochs与模型训练的关联

在深度学习模型训练中,Epochs的选取直接影响模型的学习效果和训练时间。一方面,足够的Epochs可以保证模型充分学习训练数据集中的特征;另一方面,过高的Epochs可能导致模型陷入过拟合。因此,如何选择合适的Epochs,成为了模型训练的一个关键问题。

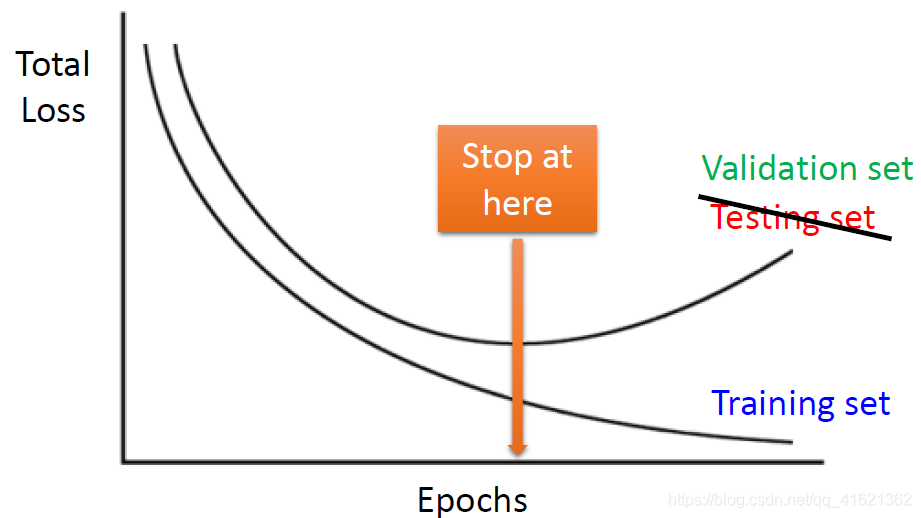

在实践中,一个通用的策略是先设置一个较高的Epochs值,然后观察模型在验证集上的表现。如果发现模型在验证集上的表现开始恶化,可以采取提前停止(early stopping)策略。

### 2.2 Epochs与模型过拟合的关系

#### 2.2.1 过拟合的成因与特征

过拟合是指模型在训练数据上表现良好,但是在未见过的数据(测试数据)上表现不佳的现象。其成因通常与模型复杂度、训练数据量不足或者训练时间过长有关。过拟合的特征包括但不限于:模型在训练集上的损失值显著低于测试集,训练集上的准确率远高于测试集。

#### 2.2.2 Epochs对过拟合的影响机制

Epochs的数量与过拟合现象有直接的联系。若Epochs过高,模型将有机会记住训练数据中的噪声和细节,这将导致模型泛化能力下降。另一方面,如果Epochs过低,模型可能没有足够的时间学习训练数据中的有效特征。

为了避免过拟合,一种常用的方法是早期停止法,即在验证集的性能不再提升时停止训练。同时,可以使用正则化技术,例如L1、L2正则化或者Dropout等,来减少过拟合。

### 2.3 Epochs与模型欠拟合的关系

#### 2.3.1 欠拟合的成因与特征

与过拟合相反,欠拟合指的是模型在训练集和测试集上都表现不佳。其成因通常与模型太过简单、训练时间不足或者输入特征不够相关。欠拟合的特征包括:模型在训练集和测试集上的损失值都较高,准确率较低。

#### 2.3.2 Epochs对欠拟合的影响机制

Epochs的数量对于欠拟合同样有重要的影响。若Epochs太低,模型可能没有足够的时间学习到数据中的有用特征,导致欠拟合。为了防止欠拟合,可以通过增加Epochs数量来延长训练时间,直到模型在训练集上的性能达到一个满意的水平。

然而,并非所有的欠拟合问题都可以通过增加Epochs来解决。有时可能需要对模型结构进行调整,比如增加网络层的深度或宽度,或者引入更多的特征工程。

通过上述分析,Epochs在深度学习模型训练中的重要性得以凸显。正确地理解和应用Epochs,对于提升模型的泛化能力至关重要。下一章将深入探讨如何根据实际情况调整Epochs,以及这种调整对于不同数据集的影响。

# 3. Epochs调整策略与实践

## 3.1 动态调整Epochs的策略

### 3.1.1 早期停止法(Early Stopping)

在深度学习中,早期停止法是一种避免过拟合的技术。通过监控验证集上的性能来决定何时停止训练。以下是早期停止法的一个实例,包括代码块和逻辑分析:

```python

from keras.callbacks import EarlyStopping

# 配置早期停止回调

early_stopping = EarlyStopping(monitor='val_loss', patience=5, verbose=1)

# 训练模型,传入early_stopping作为回调函数

model.fit(x_train, y_train, epochs=100, validation_data=(x_val, y_val), callbacks=[early_stopping])

```

在这个代码示例中,`EarlyStopping` 的 `monitor` 参数用于指定要在验证集上跟踪的性能指标(通常是损失函数的值)。如果在指定的 `patience` 轮数(即5个epoch)内,性能指标没有显著改善(这里是减少),训练就会提前终止。`verbose` 参数设为1意味着会在控制台打印出进度信息。

这种方法可以有效防止模型在训练数据上学习得过于“精细”,从而导致在新数据上的泛化能力下降。早期停止法的关键在于找到合适的 `patience` 值,过大则可能导致过拟合,过小则可能未充分训练模型。

### 3.1.2 学习率衰减策略

学习率衰减是另一种流行的动态调整Epochs的策略。学习率衰减有助于模型在训练的早期快速学习,随后逐渐减小学习率以精细调整参数,避免在训练后期过大幅度地调整模型参数。以下是实现学习率衰减的示例代码:

```python

from keras.callbacks import LearningRateScheduler

def scheduler(epoch, lr):

if epoch < 10:

return lr

else:

return lr * tf.math.exp(-0.1)

lr_decay = LearningRateScheduler(scheduler)

model.fit(x_

```

0

0