编译原理深度解读:掌握语义分析与中间代码生成的核心原理

发布时间: 2024-12-17 20:27:14 阅读量: 6 订阅数: 7

编译原理思维导图.zip

参考资源链接:[《编译原理》第三版 陈火旺 课后习题答案详解](https://wenku.csdn.net/doc/5zv4rf8r76?spm=1055.2635.3001.10343)

# 1. 编译原理概述与编译流程

编译原理是计算机科学领域中研究如何将一种高级语言转化为计算机能理解的低级机器语言或中间代码的科学。本章将介绍编译的整个过程,从源代码到最终可执行文件的转变,让读者能够对编译原理有一个整体的认识。

## 1.1 编译过程的基本概念

编译过程大致分为以下几个阶段:词法分析、语法分析、语义分析、中间代码生成、代码优化和目标代码生成。每个阶段都至关重要,它们按照一定的顺序执行,将源代码逐步转换为机器可以执行的形式。

## 1.2 编译器的结构组成

编译器主要由编译器前端和编译器后端构成。前端负责分析源代码并生成中间代码,而后端则将这些中间代码转换成特定机器的机器代码。每个阶段都依赖于之前阶段的输出,从而保证整个编译流程的顺利进行。

## 1.3 编译流程详解

编译流程可以详细描述如下:

- **词法分析**:将源代码的字符序列转换为标记(Token)序列。

- **语法分析**:根据语言的语法规则,将标记序列组织成语法树。

- **语义分析**:检查语法树中的语义错误,并进行必要的语义转换。

- **中间代码生成**:生成中间表示形式,这是比源代码更接近机器代码的代码形式。

- **代码优化**:提高中间代码的效率,而不改变其基本功能。

- **目标代码生成**:将优化后的中间代码转换成特定机器语言代码。

- **链接**:将生成的目标代码与库代码链接,形成可执行文件。

理解以上编译流程的每个环节对于深入学习编译原理至关重要,后续章节将对这些环节进行更深入的探讨。

# 2. 词法分析的理论与实践

## 2.1 词法分析的基本概念

词法分析是编译器前端的一个重要组成部分,它的主要任务是读入源程序的字符序列,将其组织成有意义的词素序列,并对这些词素序列进行分类。在这一小节中,我们将深入探讨词法单元和词法规则,并解释正则表达式和有限自动机在构建词法分析器过程中的应用。

### 2.1.1 词法单元和词法规则

词法单元(Lexeme),是源程序中可以识别的最小语法单位,比如关键字、标识符、常数、运算符等。词法规则(Lexical Rules)是对词法单元形式的定义,它们规定了构成词法单元的字符序列以及其结构,通常使用正则表达式来描述。例如,一个标识符可能被定义为以字母开头,后接任意数量的字母或数字的序列。

### 2.1.2 正则表达式和有限自动机

正则表达式是描述文本模式的一种方式,被广泛用于定义词法单元的结构。正则表达式描述的模式可以通过有限自动机(Finite Automata,FA)来实现,有限自动机分为确定有限自动机(DFA)和非确定有限自动机(NFA),它们在构建词法分析器时有不同的应用。

正则表达式和有限自动机之间存在着紧密的关系,很多词法分析器的生成工具,比如flex,就是基于NFA到DFA的转换来构造词法分析器的。

## 2.2 词法分析器的构建与应用

### 2.2.1 手动构建词法分析器

手动构建词法分析器需要开发者明确词法单元的正则表达式定义,并使用这些定义来编写代码。这个过程通常涉及到编写一个循环,不断读取输入,按照正则表达式规则匹配词素,并为每个匹配到的词素生成一个词法单元(Token),然后将这些Token传递给语法分析器。

手动构建的一个典型例子是使用状态机来匹配源代码中的各种词法单元。状态机的状态转换依赖于输入字符以及当前状态,通过遍历状态图来识别特定的Token。

### 2.2.2 词法分析器自动生成工具

尽管手动构建词法分析器在理解其工作原理上十分有用,但在实际应用中往往采用自动生成工具来创建词法分析器,如flex和lex。这些工具能够根据用户提供的正则表达式定义,自动产生相应的C语言源码,这样大大简化了编译器开发者的任务。

生成的词法分析器通常会包含一个主函数,负责初始化和启动整个分析过程,以及一个核心的词法分析函数,负责读取输入字符并产生Token。

### 2.2.3 词法分析器的优化技巧

构建高效的词法分析器需要一系列优化技巧。例如,可以采用优化后的正则表达式来减少不必要的状态转移,或者对状态机进行简化。在使用自动生成工具时,一些工具提供了额外的优化选项,如消除冗余的条件判断和合并状态等。

优化的另一个方向是减少对输入字符的回溯次数,即当词法分析器读入一个字符后,尽可能地往前看一些字符,以减少因错误匹配而不得不退回重读的可能性。这通常通过预读(look-ahead)或懒惰评估(lazy evaluation)技术实现。

为了减少对内存的占用,可以通过共享相同的前缀部分来压缩状态机,这可以通过转换为最小DFA来实现。同样重要的是,词法分析器的错误处理机制也应当被优化,以便它能够在遇到无法识别的字符序列时,尽可能提供有用的错误信息。

```c

// 一个简单的手动构建的词法分析器函数原型示例

Token lex_analyzer(char *input) {

while (*input) {

// 使用正则表达式匹配词法单元

if (match_keyword(input)) {

return KEYWORD;

} else if (match_identifier(input)) {

return IDENTIFIER;

} else if (match_number(input)) {

return NUMBER;

} else {

// 非预期字符的处理

handle_error(input);

}

}

}

```

代码逻辑分析:

上述代码展示了一个简化的词法分析器函数原型。函数`lex_analyzer`接收一个字符指针`input`指向源代码字符串。通过一个循环,逐个字符地检查输入,并使用不同的匹配函数(如`match_keyword`,`match_identifier`,`match_number`)检查是否匹配特定的词法单元。如果匹配到关键字、标识符或数字,则返回相应的Token。如果遇到不匹配的情况,则调用`handle_error`函数来处理错误。

参数说明:

- `input`:一个指向当前正在分析的源代码字符串的指针。

- `match_keyword`、`match_identifier`、`match_number`:这些函数分别用于匹配关键字、标识符和数字等词法单元。

- `KEYWORD`、`IDENTIFIER`、`NUMBER`:这些是枚举或宏定义,表示词法单元的类型。

- `handle_error`:一个用于处理未识别字符的错误处理函数。

该代码逻辑是编写词法分析器的一个基础,实际开发中会有更多的细节,比如对输入的预读处理和状态机的设计来优化性能。

通过本小节的讨论,我们可以看到构建一个高效、准确的词法分析器需要细致的规划和优化。从理论的深入学习,到实际应用的逐步展开,每一个环节都对编译器的性能有着直接的影响。随着我们对编译原理的深入探讨,后续章节将探索如何将这些词法单元进一步解析成语法结构,以及在编译器前端设计中的其它关键要素。

# 3. 语法分析的核心技术

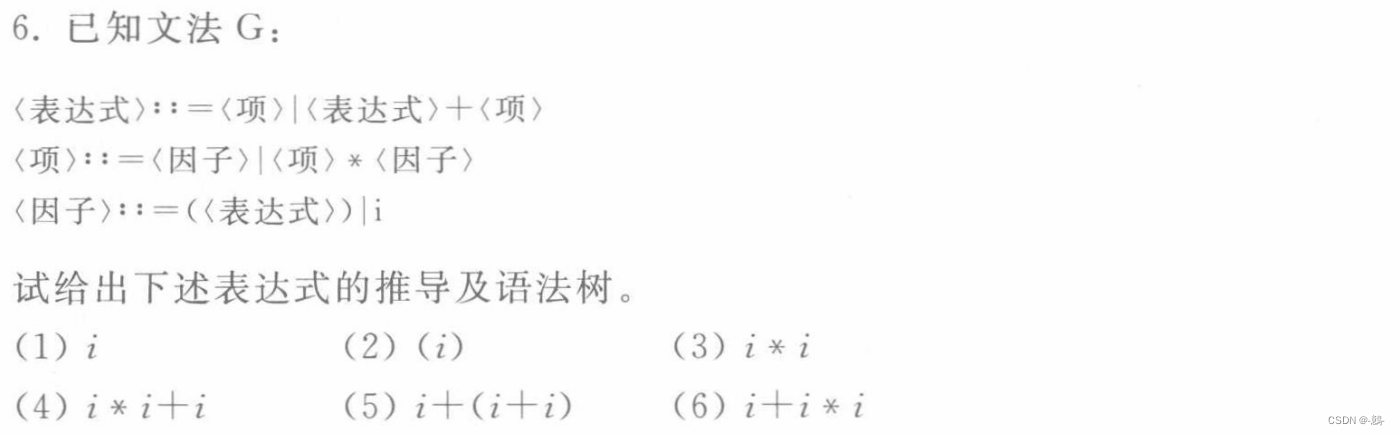

## 3.1 上下文无关文法和语法树

### 3.1.1 语法结构与文法表示

上下文无关文法(Context-Free Grammar,CFG)是形式语言理论中描述语法结构的一种形式系统。它由一组产生式规则(Production Rules)组成,这些规则描述了语言中的语法结构如何由其他语法结构组合而成。在编译器设计中,CFG用于定义程序设计语言的语法结构。

产生式规则通常表示为 `A → α` 的形式,其中 `A` 是一个非终结符,`α` 是终结符和非终结符的序列(可以为空)。CFG的一个典型例子是四则运算的文法:

```

E → E + T | E - T | T

T → T * F | T / F | F

F → ( E ) | id

``

```

0

0