MySQL数据库优化之道:从索引优化到查询调优

发布时间: 2024-05-23 19:02:15 阅读量: 67 订阅数: 29

# 1. MySQL数据库优化概述

MySQL数据库优化是指通过一系列手段和技术,提升数据库性能和效率,以满足不断增长的业务需求。本章将介绍MySQL数据库优化的基本概念、优化目标和优化方法,为后续章节的深入探讨奠定基础。

### 1.1 优化目标

MySQL数据库优化旨在实现以下目标:

- 提升查询速度,减少响应时间

- 优化存储空间,提高数据利用率

- 增强数据库稳定性,确保数据安全

- 降低运维成本,提高数据库效率

### 1.2 优化方法

MySQL数据库优化主要从以下几个方面入手:

- 索引优化:创建和管理适当的索引,加速数据查询

- 查询调优:优化查询语句,减少不必要的资源消耗

- 数据库架构优化:合理设计数据库架构,提升数据访问效率

- 数据库监控和运维:实时监控数据库状态,及时发现和解决问题

# 2. 索引优化

### 2.1 索引的基本原理和类型

**索引原理**

索引是一种数据结构,它将表中的数据按特定顺序组织起来,以便快速查找。索引类似于书籍中的目录,它包含指向表中实际数据的指针。当查询数据时,数据库引擎会使用索引来快速定位所需的数据,避免扫描整个表。

**索引类型**

MySQL支持多种索引类型,每种类型都有其特定的用途:

- **B-Tree索引:**最常用的索引类型,它将数据组织成平衡树结构,具有快速查找和范围查询的优点。

- **哈希索引:**使用哈希函数将数据映射到索引中,提供极快的等值查询,但不能用于范围查询。

- **全文索引:**用于对文本数据进行快速搜索,支持全文搜索和模糊查询。

- **空间索引:**用于对空间数据进行快速查询,支持基于地理位置的查询。

### 2.2 索引的创建和管理

**创建索引**

可以使用`CREATE INDEX`语句创建索引。语法如下:

```sql

CREATE INDEX index_name ON table_name (column_name);

```

例如,创建`customers`表上的`last_name`列的索引:

```sql

CREATE INDEX last_name_index ON customers (last_name);

```

**管理索引**

可以使用以下命令管理索引:

- `SHOW INDEXES FROM table_name;`:显示表中的所有索引。

- `ALTER TABLE table_name ADD INDEX index_name (column_name);`:添加索引。

- `ALTER TABLE table_name DROP INDEX index_name;`:删除索引。

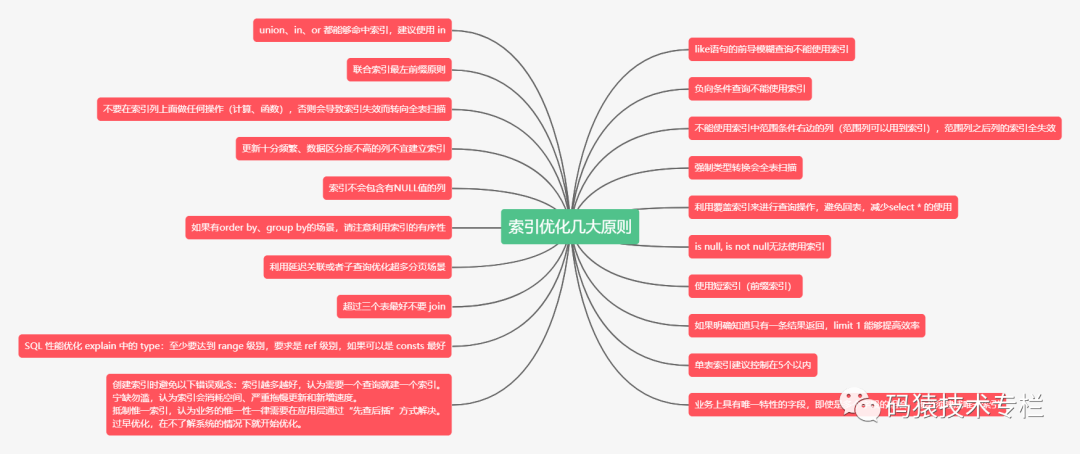

### 2.3 索引优化策略

**选择正确的索引类型**

根据查询模式选择合适的索引类型至关重要。对于等值查询,哈希索引是最佳选择。对于范围查询,B-Tree索引更合适。

**创建复合索引**

复合索引包含多个列,可以提高对多个列进行查询的性能。例如,如果经常查询`customers`表中的`last_name`和`first_name`列,则可以创建以下复合索引:

```sql

CREATE INDEX last_name_first_name_index ON customers (last_name, first_name);

```

**避免过度索引**

创建过多的索引会降低插入和更新数据的性能。只有在需要时才创建索引。

**定期维护索引**

随着数据量的增加,索引可能会变得碎片化,影响查询性能。定期重建或优化索引以保持其效率。

**使用索引监控工具**

使用诸如`mysqltuner`或`pt-index-usage`之类的工具来监控索引使用情况并识别需要改进的索引。

# 3. 查询调优**

### 3.1 查询优化原则和方法

**查询优化原则**

* **减少不必要的表扫描:**使用索引来避免全表扫描。

* **优化连接和子查询:**使用 JOIN 语句代替子查询,并优化连接顺序。

* **使用适当的索引:**为经常查询的列创建索引,并选择最优的索引类型。

* **避免不必要的排序和分组:**如果可能,使用索引来排序和分组,而不是在结果集中进行。

* **使用缓存:**使用查询缓存和连接池来减少查询执行时间。

**查询优化方法**

* **分析慢查询日志:**识别执行缓慢的查询并进行优化。

* **使用 EXPLAIN 命令:**分析查询执行计划,找出性能瓶颈。

* **使用索引提示:**强制 MySQL 使用特定索引,即使它不是最优索引。

* **重写查询:**使用不同的查询语法或算法来提高性能。

* **优化数据库架构:**调整表结构、索引和分区,以提高查询效率。

### 3.2 慢查询分析和优化

**慢查询分析**

* **慢查询日志:**记录执行时间超过特定阈值的查询。

* **EXPLAIN 命令:**提供查询执行计划和性能指标。

* **性能分析工具:**如 MySQL Performance Schema 和 pt-query-digest,提供更深入的性能分析。

**慢查询优化**

* **优化索引:**创建索引或优化现有索引以加快查询速度。

* **重写查询:**使用更有效的查询语法或算法。

* **调整数据库架构:**优化表结构、分区和连接,以提高查询效率。

* **使用缓存:**启用查询缓存和连接池以减少查询执行时间。

* **优化硬件:**升级服务器硬件以提高处理能力和内存容量。

### 3.3 查询缓存和连接池优化

**查询缓存**

* **原理:**将最近执行的查询及其结果存储在内存中,以加快后续查询速度。

* **优点:**对于经常执行的简单查询,可以显著提高性能。

* **缺点:**对于更新频繁的数据或复杂查询,可能会导致不一致性。

**连接池**

* **原理:**预先创建并维护一组数据库连接,以减少连接建立和关闭的开销。

* **优点:**提高并发查询的性能,减少服务器负载。

* **缺点:**需要管理连接池大小和超时设置,以避免资源耗尽或连接泄漏。

**优化策略**

* **调整查询缓存大小:**根据实际查询模式和服务器资源调整查询缓存大小。

* **禁用查询缓存:**对于更新频繁的数据或复杂查询,禁用查询缓存以避免不一致性。

* **优化连接池设置:**调整连接池大小、超时设置和连接回收策略,以提高性能和稳定性。

# 4. 数据库架构优化

数据库架构优化是提升数据库性能和可扩展性的关键。本章节将深入探讨数据库分库分表策略、数据冗余和一致性控制、数据库复制和高可用性等优化技术。

### 4.1 数据库分库分表策略

数据库分库分表是指将一个大型数据库拆分成多个较小的数据库或表,以提高性能和可扩展性。分库分表策略主要有以下几种:

**垂直分库分表**

垂直分库分表将数据库中的表按照业务逻辑或数据类型进行拆分。例如,将订单表拆分为订单头表和订单明细表,将用户表拆分为用户信息表和用户地址表。

**水平分库分表**

水平分库分表将数据库中的表按照数据范围进行拆分。例如,将用户表按照用户 ID 范围拆分成多个子表,每个子表存储一定范围内的用户数据。

**混合分库分表**

混合分库分表结合了垂直分库分表和水平分库分表,将数据库中的表按照业务逻辑和数据范围进行拆分。

**分库分表策略选择**

选择分库分表策略需要考虑以下因素:

- 数据量和增长速度

- 查询模式和访问模式

- 业务逻辑和数据关联关系

- 可扩展性和容灾需求

### 4.2 数据冗余和一致性控制

数据冗余是指在多个数据库或表中存储相同的数据。数据冗余可以提高查询性能,但也会带来数据一致性问题。

**数据冗余控制**

数据冗余控制主要有以下几种方法:

- **主键约束**:通过设置主键约束,确保数据在多个表中唯一。

- **外键约束**:通过设置外键约束,确保数据在多个表之间存在关联关系。

- **触发器**:通过创建触发器,在数据发生变化时自动更新相关表中的数据。

**数据一致性保障**

数据一致性保障主要有以下几种方法:

- **事务机制**:通过使用事务机制,确保数据在多个操作中保持一致性。

- **两阶段提交**:在分布式系统中,使用两阶段提交协议确保数据在多个数据库中一致性提交。

- **最终一致性**:在某些情况下,可以牺牲强一致性,采用最终一致性模型,允许数据在一段时间内存在不一致,但最终会达到一致状态。

### 4.3 数据库复制和高可用性

数据库复制是指将主数据库的数据同步到一个或多个从数据库。数据库复制可以提高数据库的可读性和高可用性。

**数据库复制类型**

数据库复制主要有以下几种类型:

- **同步复制**:主数据库上的数据变更会实时同步到从数据库。

- **异步复制**:主数据库上的数据变更会以一定延迟同步到从数据库。

- **半同步复制**:主数据库上的数据变更会先同步到一个中继节点,然后再同步到从数据库。

**高可用性架构**

数据库复制可以构建高可用性架构,主要有以下几种方式:

- **主从复制**:主数据库负责写操作,从数据库负责读操作。

- **读写分离**:主数据库负责写操作,从数据库负责读操作,通过负载均衡器将读写请求分发到不同的数据库。

- **多主复制**:多个主数据库之间进行复制,每个主数据库都可以进行写操作。

**数据库复制和高可用性选择**

选择数据库复制和高可用性架构需要考虑以下因素:

- 数据一致性要求

- 可用性要求

- 性能要求

- 成本和复杂性

# 5. 数据库监控和运维

### 5.1 数据库监控指标和工具

数据库监控是确保数据库稳定运行和性能优化的关键。通过监控数据库的关键指标,可以及时发现和解决潜在问题,避免数据库故障或性能下降。常见的数据库监控指标包括:

- **连接数:**当前连接到数据库的客户端数量。过高的连接数可能导致数据库资源耗尽,影响性能。

- **查询次数:**每秒执行的查询数量。高查询次数可能表明数据库负载过高,需要优化查询或扩展数据库容量。

- **查询时间:**执行查询的平均时间。查询时间过长可能表明查询效率低下,需要优化查询或索引。

- **慢查询率:**执行时间超过指定阈值的查询所占的比例。慢查询率过高表明存在需要优化的低效查询。

- **内存使用率:**数据库使用的内存量。过高的内存使用率可能导致数据库性能下降或崩溃。

- **磁盘 I/O:**数据库读写磁盘的次数和数据量。高磁盘 I/O 可能表明存在性能瓶颈,需要优化查询或扩展存储容量。

常用的数据库监控工具包括:

- **MySQL Enterprise Monitor:**MySQL 官方提供的商业监控工具,提供全面的数据库监控和管理功能。

- **Percona Monitoring and Management:**开源的数据库监控和管理工具,支持 MySQL、MariaDB 和 PostgreSQL 等数据库。

- **Zabbix:**开源的监控系统,可以监控各种指标,包括数据库指标。

- **Nagios:**开源的监控系统,可以监控各种指标,包括数据库指标。

### 5.2 数据库备份和恢复策略

数据库备份是保护数据库数据免遭丢失或损坏的重要措施。备份策略应根据数据库的重要性、数据量和恢复时间目标(RTO)进行制定。常见的备份类型包括:

- **全量备份:**备份数据库中的所有数据。

- **增量备份:**备份自上次全量备份或增量备份以来更改的数据。

- **差异备份:**备份自上次全量备份以来更改的数据,但不包括增量备份中已备份的数据。

恢复策略应定义在发生数据库故障或数据丢失时如何恢复数据库。恢复策略应包括以下步骤:

- **确定故障类型:**确定导致数据库故障或数据丢失的原因。

- **选择恢复方法:**根据故障类型和备份策略选择适当的恢复方法。

- **恢复数据库:**使用备份数据恢复数据库。

- **验证恢复:**验证恢复后的数据库是否完整且可用。

### 5.3 数据库安全和权限管理

数据库安全至关重要,可以防止未经授权的访问、数据泄露和恶意攻击。数据库安全措施包括:

- **用户权限管理:**授予用户适当的权限,以限制对数据库数据的访问。

- **密码管理:**使用强密码并定期更改密码,以防止未经授权的访问。

- **数据加密:**对敏感数据进行加密,以防止未经授权的访问。

- **防火墙:**配置防火墙以限制对数据库服务器的访问。

- **入侵检测系统:**部署入侵检测系统以检测和阻止恶意攻击。

权限管理是数据库安全的重要组成部分。权限管理应根据以下原则进行:

- **最小权限原则:**只授予用户执行其工作所需的最低权限。

- **分离职责原则:**将不同的权限分配给不同的用户,以防止单一用户拥有过多的权限。

- **定期审核:**定期审核用户权限,以确保权限分配仍然适当。

# 6.1 常见性能问题分析和解决

MySQL数据库在实际应用中,经常会遇到各种各样的性能问题,影响系统的正常运行和用户体验。常见的问题包括:

- **慢查询:**查询执行时间过长,导致系统响应缓慢。

- **高负载:**数据库并发请求过多,导致系统资源紧张。

- **死锁:**多个事务同时持有对方的资源,导致相互等待。

- **锁冲突:**多个事务同时更新同一行数据,导致锁等待。

- **数据碎片:**随着数据量的增加,数据分布不均匀,导致查询效率下降。

针对这些问题,可以采取以下分析和解决措施:

**慢查询分析和优化:**

- 使用 `EXPLAIN` 命令分析查询执行计划,找出执行效率低下的步骤。

- 检查索引的使用情况,确保查询使用了合适的索引。

- 优化查询语句,避免不必要的子查询和连接。

**高负载优化:**

- 优化数据库架构,采用分库分表策略。

- 增加数据库服务器的硬件资源,如CPU、内存。

- 使用连接池管理数据库连接,减少连接创建和销毁的开销。

**死锁处理:**

- 设置合理的锁等待超时时间,防止死锁发生。

- 使用锁优化技术,如间隙锁和行锁。

- 优化事务处理逻辑,避免死锁的产生。

**锁冲突优化:**

- 优化索引的使用,确保更新操作使用合适的索引。

- 使用乐观锁或悲观锁控制并发更新。

- 调整事务隔离级别,降低锁冲突的概率。

**数据碎片优化:**

- 定期对数据进行优化,如重建索引、整理表空间。

- 使用分区表或分片技术,将数据均匀分布到多个物理存储单元。

- 优化数据插入和更新策略,避免数据碎片的产生。

0

0