【激活函数紧急指南】:如何快速解决梯度问题

发布时间: 2024-09-05 13:44:42 阅读量: 45 订阅数: 45

# 1. 深度学习中的梯度问题概述

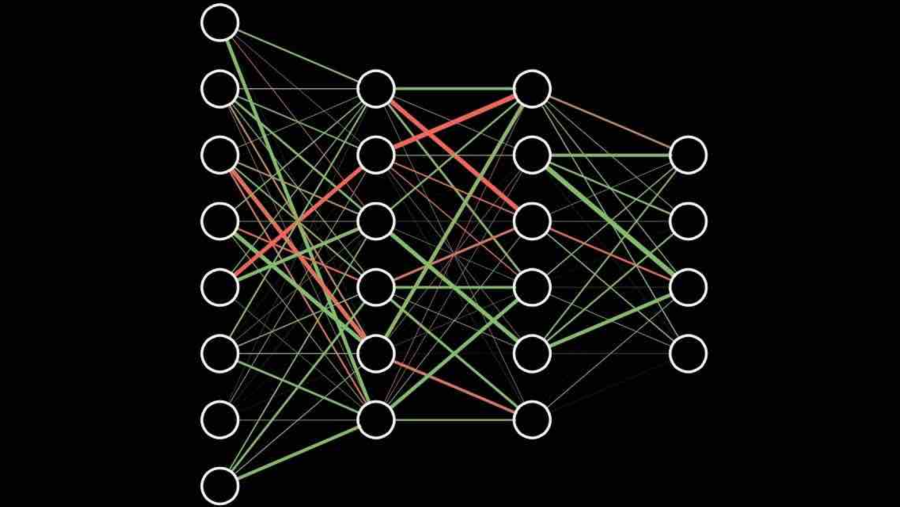

在深度学习模型训练中,梯度问题一直是研究者和工程师们关注的焦点。梯度可以被视为模型参数变化的敏感度,它直接决定了模型优化的方向和效率。如果梯度过小,模型的权重更新将会非常缓慢,导致训练过程非常耗时;反之,如果梯度过大,模型可能会出现震荡,甚至发散,无法收敛到一个好的解。因此,理解并有效地处理梯度问题,是提高深度学习性能的关键步骤。

本章我们将概述深度学习中的梯度问题,为后续章节详细探讨梯度消失和梯度爆炸、激活函数的选择及优化策略打下基础。我们会从梯度的基本概念出发,逐步深入到梯度问题的成因和影响,为读者提供一个梯度问题全貌的认识。通过本章内容的学习,读者将能够更好地理解深度学习模型在训练过程中可能遇到的问题,并对后续的优化措施有初步的了解和期待。

# 2. 理解梯度消失与梯度爆炸

## 2.1 梯度消失的概念与影响

梯度消失问题是指在深度神经网络中,随着层数的增加,前向传播时梯度逐渐变小,导致靠近输入层的权重更新极其缓慢,甚至几乎不更新。这种情况会严重影响模型的学习效率和性能。

### 2.1.1 梯度消失的数学解释

在反向传播算法中,梯度是通过链式法则逐层传递的。给定一个三层的神经网络,假设每层的权重矩阵分别为W1、W2和W3,激活函数为f,损失函数为L。梯度消失通常发生在深层网络中,特别是在使用饱和激活函数(如Sigmoid)时,当激活函数的导数非常接近于0时,多个导数连乘的结果会非常小,从而导致梯度消失。

具体来说,如果每一层的激活函数导数都是小于1的小数,那么随着层数的增加,梯度的传播会呈现指数级的衰减。数学上,如果每一层的导数平均为α,那么n层后的梯度将会是α^n倍,当n很大时,α^n接近于0。

### 2.1.2 实际案例分析:梯度消失的危害

梯度消失的一个典型例子是训练深层神经网络时的困难。在使用传统的Sigmoid或Tanh激活函数时,模型可能会在学习过程中遇到性能停滞不前的问题。由于梯度太小,网络权重几乎无法更新,从而使得模型无法有效学习到数据的复杂特征。

以一个深度为20层的RNN为例,如果使用Sigmoid激活函数,那么在反向传播时,由于Sigmoid函数的导数最大值为0.25,那么20层之后的梯度会是(0.25)^20 ≈ 1.75e-12,这个值已经非常接近于0,导致梯度信息几乎完全丢失。

## 2.2 梯度爆炸的原理与后果

梯度爆炸与梯度消失相反,是指在训练过程中,梯度值不断增大,导致权重更新幅度过大,甚至超出数值范围,造成训练过程不稳定。

### 2.2.1 梯度爆炸的成因分析

梯度爆炸通常发生在模型参数初始化过大时,或者在反向传播过程中,梯度连乘导致的累积放大效应。与梯度消失类似,如果每一层的激活函数导数都是大于1的数,那么随着层数的增加,梯度的传播会呈现指数级的放大。

以一个深度为5层的全连接网络为例,如果每一层的权重矩阵初始化过大,且激活函数的导数都大于1,那么5层之后的梯度将会是导数的5次方,这会导致梯度迅速增加,从而发生爆炸。

### 2.2.2 梯度爆炸的解决策略

解决梯度爆炸的一个常见策略是采用更合适的权重初始化方法,如He初始化或者Xavier初始化,这些方法根据网络层数调整权重的尺度,可以有效缓解梯度爆炸的问题。

另一个策略是使用梯度剪切(Gradient Clipping),即在参数更新前检查梯度值,并将其限制在一定的阈值范围内,以防止梯度过大导致参数更新幅度过大。此外,使用正则化技术如L2正则化也可以一定程度上减轻梯度爆炸的问题。

```python

# 示例:使用梯度剪切的策略

import torch

# 假设有一个模型参数张量

model_params = torch.randn(10, 1, requires_grad=True)

# 反向传播计算梯度

loss = model_params.sum() # 损失函数

loss.backward() # 反向传播

# 梯度剪切处理

torch.nn.utils.clip_grad_norm_(model_params, max_norm=1.0)

```

在上述代码块中,首先计算了模型参数的总和作为损失函数,并通过`.backward()`方法反向传播计算梯度。之后使用`clip_grad_norm_`函数对梯度进行了剪切,限制了梯度的总范数不超过1。

## 2.3 激活函数与梯度问题的关系

激活函数在神经网络中起到了非线性映射的作用,它决定了梯度在反向传播过程中的流动方式。不同的激活函数对梯度流动的影响不同,因此它们与梯度消失和梯度爆炸问题密切相关。

### 2.3.1 激活函数在神经网络中的作用

激活函数是在神经元之间传递信息的非线性函数。它通常被应用在卷积层、全连接层之后,用于引入非线性因素,从而让神经网络能够学习复杂的函数映射。

激活函数通常包括Sigmoid、Tanh、ReLU及其变体等。不同的激活函数对模型的性能和梯度流动有着不同的影响。

### 2.3.2 激活函数如何影响梯度流动

不同的激活函数有不同的导数,其导数大小和特性会直接影响梯度的流动和模型的训练效率。

- Sigmoid函数在两端的导数接近于0,容易导致梯度消失。

- ReLU函数在正区间的导数为1,在负区间的导数为0,可以缓解梯度消失的问题,但也存在“死亡ReLU”问题,即某些神经元可能永久不被激活,导致梯度无法传递。

- Leaky ReLU和ELU等变体试图解决ReLU的“死亡”问题,提供了负区间的小的正导数,以保持一定的梯度流动。

```python

# 示例:比较不同激活函数对梯度的影响

import torch

import torch.nn.functional as F

# 创建一个简单的全连接层

layer = torch.nn.Linear(10, 1)

# 输入数据

x = torch.randn(1, 10)

# 应用不同的激活函数

output_sigmoid = F.sigmoid(layer(x))

output_tanh = F.tanh(layer(x))

output_relu = F.relu(layer(x))

```

通过上述代码,我们创建了一个全连接层,并将其输出分别应用了Sigmoid、Tanh和ReLU激活函数。通过实际网络训练,我们可以观察到不同激活函数对梯度流动的不同影响。

梯度消失和梯度爆炸是深度学习模型训练中经常遇到的问题,它们直接关系到模型的收敛速度和性能。通过对激活函数的合理选择和参数初始化的优化,可以有效

0

0