【如何有效利用注意力机制提高模型泛化能力?】: 探讨如何有效利用注意力机制提高模型的泛化能力

发布时间: 2024-04-20 12:28:23 阅读量: 124 订阅数: 130

# 1. 引言

在深度学习领域,注意力机制一直是一个备受关注的话题。通过引入注意力机制,模型可以在处理任务时选择性地关注输入的不同部分,从而提高模型性能和泛化能力。本文将深入探讨注意力机制的原理、在深度学习中的应用场景,以及如何利用注意力机制来提升模型的泛化能力。同时,也将展望注意力机制在未来的发展方向,帮助读者更好地理解和应用这一重要的技术。

# 2. 注意力机制简介

注意力机制在深度学习领域扮演着至关重要的角色,能够帮助模型集中注意力在相关的部分,从而提升模型性能。在这一章节中,我们将深入探讨注意力机制的基本概念和原理。

### 2.1 什么是注意力机制

在深度学习中,注意力机制是一种模仿人类注意力思维方式的方法,其核心思想是根据输入的不同部分赋予不同的注意权重,实现对输入信息的有针对性处理。通过注意力机制,模型可以有效地学习到输入数据中的关键信息,提升表现力和泛化能力。

### 2.2 注意力机制的原理

在这一部分,我们将深入了解注意力机制的原理,包括自注意力机制、多头注意力机制以及注意力权重计算的方法。

#### 2.2.1 自注意力机制

自注意力机制是指模型学习将输入序列中各个元素之间的关系进行建模的能力。通过自注意力机制,模型可以根据序列中不同元素之间的相互作用来调整自身的表示,从而更好地捕捉序列中的长距离依赖关系。

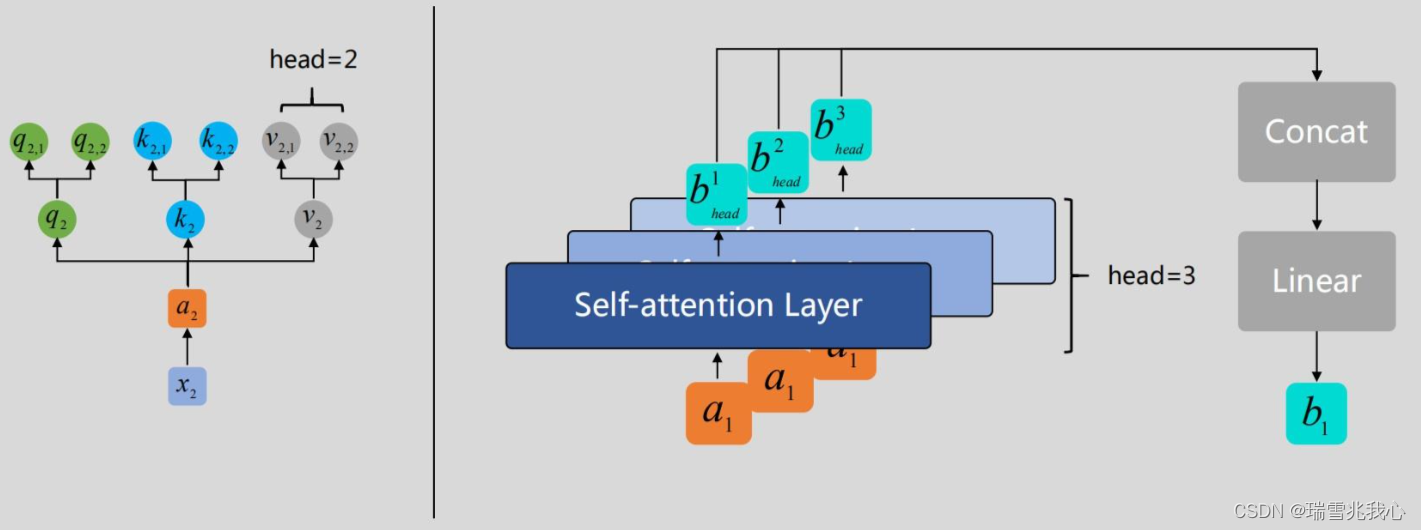

#### 2.2.2 多头注意力机制

多头注意力机制通过引入多组不同的注意力权重计算,使得模型可以并行学习多种不同的注意力表示。每个注意力头都可以关注序列中不同的部分,从而增加模型的表达能力。

#### 2.2.3 注意力权重计算

注意力权重计算是注意力机制中的关键步骤,用于计算每个输入元素的注意力权重。通常采用缩放点积注意力机制进行权重计算,通过计算查询、键和值之间的关联程度,得出每个输入元素的注意力权重。

通过本章节的介绍,读者可以对注意力机制的基本原理有个清晰的认识,了解不同类型的注意力机制以及注意力权重计算方法,为后续章节的深入探讨奠定基础。

# 3. 注意力机制在深度学习中的应用

注意力机制作为一种重要的机制在深度学习领域中得到了广泛的应用,可以有效提升模型对输入数据的处理能力。在本章中,我们将深入探讨注意力机制在自然语言处理和计算机视觉领域的具体应用。

### 3.1 注意力机制在自然语言处理中的应用

自然语言处理是人工智能领域的一个重要分支,而注意力机制的引入为自然语言处理任务带来了新的思路和方法。下面我们将分别介绍在自然语言处理中两个经典的模型:Seq2Seq 模型和 Transformer 模型是如何应用注意力机制的。

#### 3.1.1 Seq2Seq模型

Seq2Seq模型,即Encoder-Decoder模型,是一种经典的序列到序列的模型结构,广泛应用于机器翻译、对话生成等任务。在Seq2Seq模型中,注意力机制被用来捕捉输入序列中不同位置的重要信息,从而提高模型对序列的理解能力。

以下是Seq2Seq模型中注意力机制的应用示例代码(使用Python语言的PyTorch框架):

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class Attention(nn.Module):

def __init__(self, hidden_size):

super(Attention, self).__init__()

self.hidden_size = hidden_size

self.attn = nn.Linear(self.hidden_size * 2, hidden_size)

self.v = nn.Parameter(torch.rand(hidden_size))

def forward(self, encoder_outputs, decoder_hidden):

seq_len = len(encoder_outputs)

attn_energies = torch.zeros(seq_len)

for i in range(seq_len):

attn_energies[i] = self.score(decoder_hidden, encoder_outputs[i])

return F.softmax(attn_energies, dim=0).unsqueeze(0)

def score(self, decoder_hidden, encoder_output):

energy = self.attn(torch.cat((decoder_hidden, encoder_output), 1))

energy = torch.matmul(self.v, energy)

return energy

```

注意:以上代码为Seq2Seq模型中的简化注意力机制实现,通过计算解码器隐藏状态和编码器输出的加权和,实现了位置权重的计算。

#### 3.1.2 Transformer模型

T

0

0