【整合多种注意力机制模块的复合模型设计与实现方法详解】: 详细介绍整合多种注意力机制模块的复合模型的设计与实现方法

发布时间: 2024-04-20 12:34:02 阅读量: 139 订阅数: 93

# 1. 注意力机制模块概述

在深度学习领域,注意力机制作为一种关键的技术,被广泛运用于各种模型中,以提升模型性能和精度。注意力机制的设计灵感来源于人类的视觉注意力,其核心思想是模拟人类在处理信息时所具有的关注重点和优先级,使得模型能够专注于重要的部分。通过对输入的不同部分赋予不同的注意权重,模型可以有针对性地处理信息,实现更加精准的学习和推断。在本章中,我们将从基本原理出发,逐步深入探讨注意力机制的各个方面,为后续单一和复合注意力模块的设计奠定基础。

# 2. 单一注意力机制模块设计

## 2.1 理解注意力机制的原理

### 2.1.1 什么是注意力机制

在深度学习领域,注意力机制是一种机制,可以让模型在处理输入数据时,能够有选择性地关注某些部分,从而提高模型的表现和性能。通过赋予不同部分不同的权重,模型可以动态地决定哪些信息更加重要。

### 2.1.2 注意力权重计算方法

注意力权重计算方法是指在给定输入数据的情况下,模型如何计算出不同部分的注意力权重。通常采用softmax函数对原始分数进行归一化,以确保各部分的注意力权重之和为1。

### 2.1.3 注意力集中机制

注意力集中机制是指模型如何利用计算得到的注意力权重,将不同部分的信息加权求和,得到最终的表示。这种注意力集中可以有效地捕捉输入数据中的关键信息,并在模型中进行有效传递。

## 2.2 实现注意力机制模块

### 2.2.1 自注意力网络

自注意力网络是一种基于注意力机制的模型,可以同时计算输入序列中各个位置之间的关联性,并据此调整不同位置的表示。通过自注意力机制,模型可以更好地捕捉长距离依赖关系。

```python

# 自注意力机制代码示例

import torch

import torch.nn.functional as F

class SelfAttention(nn.Module):

def __init__(self, input_dim, hidden_dim):

super(SelfAttention, self).__init__()

self.W_Q = nn.Linear(input_dim, hidden_dim)

self.W_K = nn.Linear(input_dim, hidden_dim)

self.W_V = nn.Linear(input_dim, hidden_dim)

def forward(self, x):

Q = self.W_Q(x)

K = self.W_K(x)

V = self.W_V(x)

attn_weights = F.softmax(Q @ K.T, dim=-1)

output = attn_weights @ V

return output

```

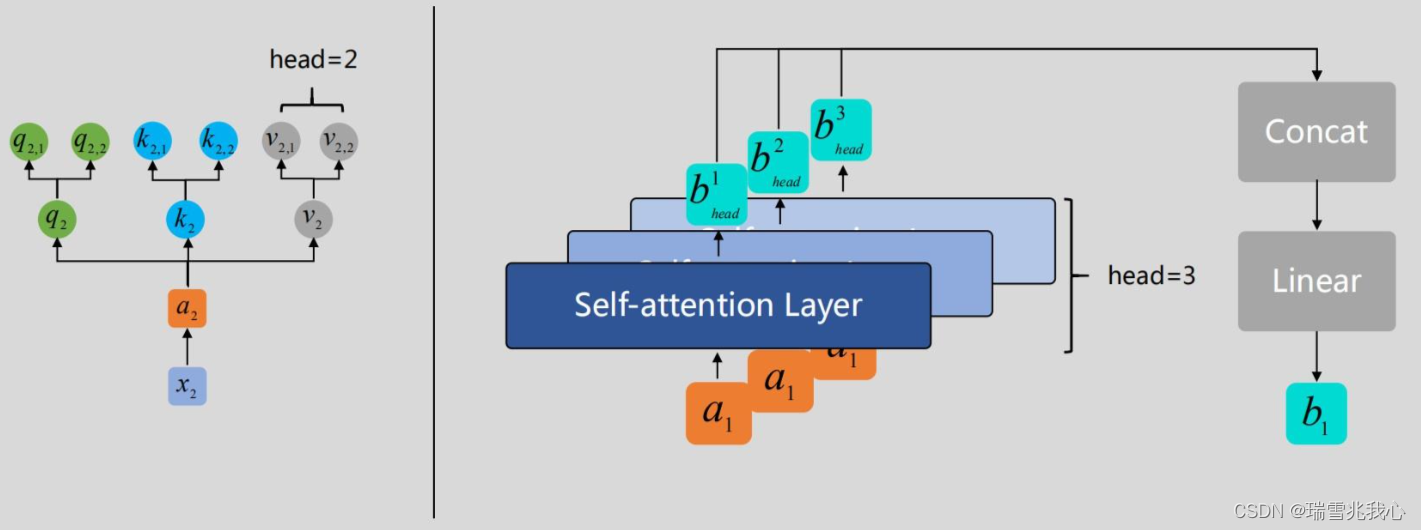

### 2.2.2 多头注意力机制

多头注意力机制通过将注意力权重的计算过程分为多个头部进行,并行计算,最后将各头部的输出拼接在一起,从而允许模型在不同子空间中学习注意力。

### 2.2.3 注意力汇聚层

注意力汇聚层是一个重要的组件,用于将不同部分获得的注意力权重信息整合在一起,以得到最终的表示。这一层通常包含线性变换和激活函数,以进一步处理注意力信息。

以上是关于单一注意力机制模块设计的详细解析,从注意力机制的原理到不同实现方式的介绍,希望可以帮助您深入理解注意力机制的应用和作用。

# 3. 多种注意力机制模块整合

### 3.1 不同注意力机制模块特点分析

在深度学习领域,注意力机制在提升模型性能和泛化能力方面发挥着重要作用。不同类型的注意力机制模块具有各自的特点,下面将对自注意力模块和多头注意力模块进行比较,并探讨不同的注意力权重计算方式以及多种注意力机制的优势互补性。

#### 3.1.1 自注意力模块 VS 多头注意力模块

自注意力模块是一种将输入序列中各个元素之间的相互关系进行建模的注意力机制。通过学习每个元素对其他元素的贡献,实现了序列内部全局依赖的建模。相比之下,多头注意力模块引入了多个注意力头,每个头均可学习不同的特征表示,从而提升了模型对不同关注点的表达能力。

#### 3.1.2 不同的注意力权重计算方式比较

在注意力机制中,注意力权重的计算方式至关重要。常见的计算方式包括点积注意力、加性注意力等。点积注意力通过计算查询和键之间的内积来得到注意力权重,而加性注意力则引入学习到的权重参数。不同的计算方式适用于不同的场景和模型结构,在实践中需要根据具体情况进行选择。

#### 3.1.3 多种注意力机制的优势互补

综合利用多种不同的注意力机制能够在一定程度上弥补各自的不足,形成优势互补的效果。例如,自注意力模块能够捕捉全局长距离依赖,而多头注意力模块在处理多个关注点上更为灵活,两者结合可以提升模型的整体性能。

### 3.2 设计复合注意力机制模块

针对不同的任务和需求,可以设计出复合的注意力机制模块,从而充分发挥各种机制的优势。下面将介绍并行连接不同注意力机制、串行堆叠多种注意力模块以及融合多种注意力机制的方法。

#### 3.2.1 并行连接不同注意力机制

通过在模型中并行连接不同的注意力机制模块,可以让模型同时学习和利用多种特征表示。例如,可以将自注意力模块和多头注意力模块并行连接,使模型能够在不同层次和维度上学习特征表示,并提高泛化能

0

0