【注意力机制基础概念解析与应用场景分析】: 深入解析注意力机制的基础概念及应用场景

发布时间: 2024-04-20 11:43:48 阅读量: 124 订阅数: 111

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. 理解注意力机制基础概念

在深度学习领域,注意力机制是一种重要的技术,用来模拟人类的"注意力"行为,使得模型能够在处理输入数据时有选择性地关注其中的一部分内容,提高模型的性能和效率。通过理解注意力机制的基础概念,我们可以更好地掌握其工作原理,进而应用于各种任务中。注意力机制的核心思想是根据输入的不同部分赋予不同的权重,从而使模型能够聚焦在关键信息上,提升任务表现。

# 2. 注意力机制原理与模型

### 2.1 了解注意力机制原理

注意力机制是一种模仿人类注意力思维方式的机制,能够赋予模型更好的处理能力和适应性。在深度学习领域中,注意力机制被广泛应用于各种模型中,提升了模型的性能和效果。

#### 2.1.1 什么是注意力机制

注意力机制是指模型在处理输入数据时,对不同部分的关注程度不同,更加注重重要的信息,忽略无关紧要的部分。它通过学习得到每个输入部分的权重,然后根据权重对输入进行加权求和,从而达到集中注意力处理数据的效果。

#### 2.1.2 注意力权重计算方法

在注意力机制中,计算注意力权重是关键的环节。常见的计算方法包括点积注意力、加性注意力和缩放点积注意力。其中,点积注意力计算简单高效,加性注意力能够处理更复杂的关系,缩放点积注意力在点积注意力的基础上引入了缩放系数以提升稳定性。

```python

# 点积注意力权重计算方法

def dot_product_attention(query, key, value):

scores = torch.matmul(query, key.T)

weights = F.softmax(scores, dim=-1)

output = torch.matmul(weights, value)

return output

```

#### 2.1.3 注意力集中度分析

注意力集中度是指模型在处理输入数据时对不同部分的聚焦程度。通过分析注意力集中度,可以了解模型在处理数据时的侧重点和关注点,帮助深入理解模型的工作机制以及优化模型的性能。

### 2.2 注意力机制模型

注意力机制模型是基于注意力机制构建的各种深度学习模型,其中包括自注意力模型、非自注意力模型和深度学习中的注意力模型。

#### 2.2.1 自注意力模型

自注意力模型是一种能够同时考虑输入序列中各个位置之间关系的模型,例如 Transformer 模型就是基于自注意力机制构建的。它通过计算每个位置与其他位置的相关性,从而获取全局信息进行处理。

```python

# 自注意力计算

multihead_self_attention = nn.MultiheadAttention(embed_dim, num_heads)

self_attn_output, _ = multihead_self_attention(embeddings, embeddings, embeddings)

```

#### 2.2.2 非自注意力模型

非自注意力模型是指在处理数据时,除了考虑输入序列内部的关系外,还引入了外部信息或者上下文信息的模型。通过结合内部信息和外部信息,非自注意力模型可以更好地处理复杂的任务。

#### 2.2.3 深度学习中的注意力模型

在深度学习领域中,注意力机制被广泛应用于各种模型中,包括自然语言处理、计算机视觉、推荐系统等领域。利用注意力机制,模型可以更好地提取重要信息,提升模型的泛化能力和效果。

以上是关于注意力机制原理与模型的详细介绍,下一节将深入探讨注意力机制在自然语言处理中的应用。

# 3. 注意力机制在自然语言处理中的应用

自然语言处理(Natural Language Processing,NLP)领域是深度学习中应用最广泛的领域之一,而注意力机制在NLP中的应用更是引起了广泛关注。本章将探讨注意力机制在自然语言处理中的具体应用场景,包括文本分类与情感分析,以及机器翻译与语义理解。

### 3.1 文本分类与情感分析

在文本分类和情感分析任务中,注意力机制被广泛应用,可以帮助模型更好地理解文本的重要信息。

#### 3.1.1 文本序列注意力模型

文本序列注意力模型是一种能够对文本序列中不同位置信息赋予不同权重的模型。通过对输入文本的每个词或片段计算注意力权重,并将这些权重应用于最终的文本表示,模型可以更加关注重要的部分,从而提高文本分类和情感分析的准确性。

下面是一个简单的文本序列注意力模型示例代码:

```python

# 定义注意力权重计算函数

def compute_attention_weight(input_text):

# 计算每个词的注意力权重

attention_weights = softmax(some_function(input_text))

return attention_weights

# 应用注意力权重到文本表示

def apply_attention(input_text, attention_weights):

# 将注意力权重应用到文本表示

final_text_representation = sum([a * x for a, x in zip(attention_weights, input_text)])

return final_text_representation

```

#### 3.1.2 情感分类中的注意力机制

在情感分类任务中,注意力机制可以帮助模型识别文本中表达情感的关键词或短语,从而更精准地判断文本的情感倾向。通过引入注意力机制,模型可以自动学习文本中不同部分的重要性,从而提升情感分类的性能。

### 3.2 机器翻译与语义理解

机器翻译和语义理解是自然语言处理中另外两个重要领域,注意力机制在这两个领域中也扮演着重要角色。

#### 3.2.1 注意力机制在机器翻译中的应用

在机器翻译任务中,传统的统计翻译模型存在“词对齐”问题,而注意力机制的引入有效解决了这一问题。通过引入注意力机制,模型可以在翻译的过程中动态地关注输入句子的不同部分,从而实现更加准确的翻译。

下表展示了一个简单的多头注意力模型在机器翻译中的应用:

| 单词 | 注意力权重1 | 注意力权重2 | 注意力权重3 |

|-----|------------|------------|------------|

| I | 0.6 | 0.2 | 0.2 |

| love| 0.3 | 0.5 | 0.2 |

| you | 0.1 | 0.1 | 0.8 |

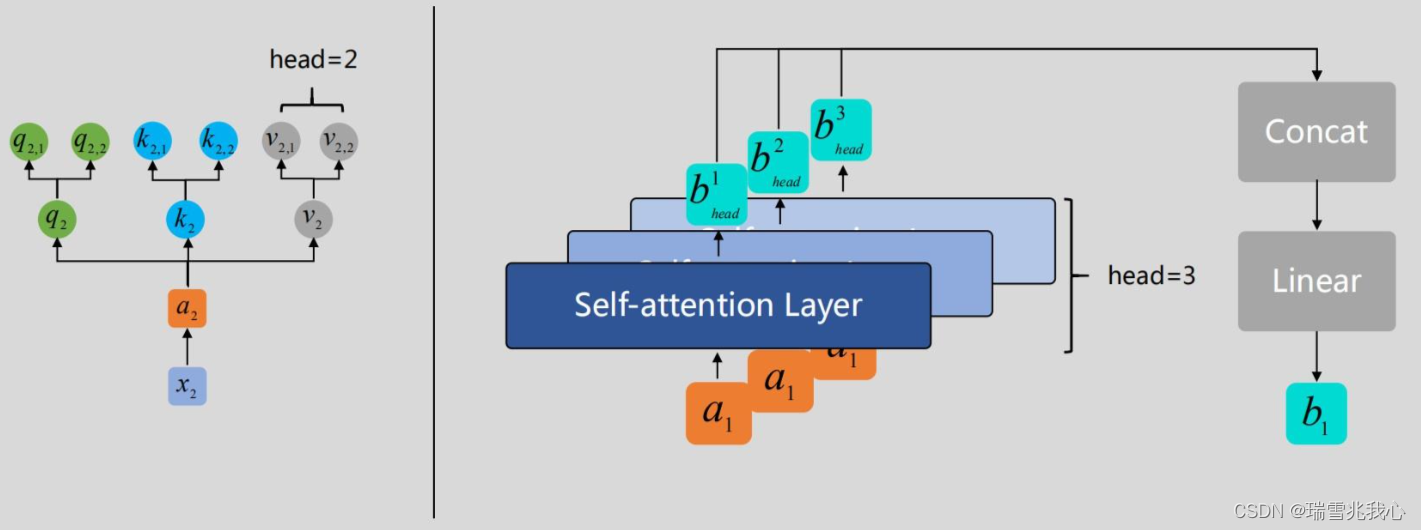

#### 3.2.2 多头注意力模型解析

多头注意力模型通过同时学习多组注意力权重,可以捕捉文本中不同层次的信息,提高模型对文本的理解能力。每个注意力头都可以关注不同方面的信息,最终将多头注意力的结果融合在一起,得到更全面的文本表示。

通过本章节的介绍,我们对注意力机制在自然语言处理领域的应用有了更深入的理解,同时也展示了注意力机制如何提升模型在文本分类、情感分析、机器翻译和语义理解等任务中的性能。

# 4. 注意力机制在计算机视觉中的应用

计算机视觉是人工智能领域中一个极具挑战性的领域,而注意力机制在计算机视觉任务中的应用则起到了至关重要的作用。本章将深入探讨注意力机制在图像分类与目标检测、视觉问答与图像生成等方面的应用。

### 4.1 图像分类与目标检测

在图像分类和目标检测任务中,注意力机制可以帮助模型更好地理解图像内容,提高准确性和性能。

#### 4.1.1 卷积神经网络中的注意力机制

在卷积神经网络(CNN)中引入注意力机制,可以使模型有能力对输入图像的不同区域给予不同的重视度。这种重视度能够帮助模型集中注意力在关键区域,提高分类和检测的准确性。

下面是一个简单的示例代码,在一个卷积神经网络模型中实现注意力机制:

```python

# 定义注意力机制模块

class Attention(nn.Module):

def __init__(self, in_channels):

super(Attention, self).__init__()

self.conv = nn.Conv2d(in_channels, 1, kernel_size=1)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

attention_w = self.sigmoid(self.conv(x))

out = x * attention_w

return out

# 在CNN中应用注意力机制

class CNNWithAttention(nn.Module):

def __init__(self):

super(CNNWithAttention, self).__init__()

self.features = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=3, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=2, stride=2)

)

self.attention = Attention(64)

def forward(self, x):

x = self.features(x)

x = self.attention(x)

return x

# 创建模型实例

model = CNNWithAttention()

```

在上面的代码中,`Attention`模块实现了简单的注意力机制,而`CNNWithAttention`模型则在卷积层后引入了注意力模块。

#### 4.1.2 图像分类中的注意力机制应用

在图像分类任务中,注意力机制有助于模型聚焦于图像的重要区域,提高准确性。通过注意力机制,模型可以动态选择感兴趣的区域进行分类,而不是盲目地对整张图像进行处理。

### 4.2 视觉问答与图像生成

视觉问答和图像生成任务是计算机视觉中的热门任务,而注意力机制在这些任务中扮演着重要角色。

#### 4.2.1 视觉问答任务中的注意力机制

在视觉问答任务中,模型需要同时理解图像内容和问题,然后给出准确的答案。注意力机制可以帮助模型动态地调整对图像和问题的关注程度,从而提高问答的准确性。

#### 4.2.2 图像生成模型中的多层次注意力分析

图像生成模型中的多层次注意力分析,可以使模型学会逐步关注图像的不同部分,有助于生成更加逼真和多样化的图像内容。多头注意力机制在图像生成任务中发挥了重要作用,帮助模型从不同角度理解图像语境。

通过以上章节对注意力机制在计算机视觉领域的应用的讨论,我们可以看到注意力机制在图像分类、目标检测、视觉问答和图像生成等任务中的重要性和有效性。随着深度学习技术的不断发展,注意力机制将在计算机视觉领域发挥越来越重要的作用。

# 5. 注意力机制未来发展趋势与挑战

在过去几年里,注意力机制在自然语言处理和计算机视觉领域得到了广泛的应用和研究,取得了显著的成果。然而,随着人工智能领域的不断发展和变革,注意力机制也面临着一些未来的发展趋势和挑战。本章将探讨注意力机制的未来发展方向以及可能面临的挑战。

### 5.1 自适应注意力机制

当前的注意力机制大多是基于固定的权重计算方法,即在模型训练过程中学习得到的注意力权重是固定不变的。在未来,一种更加灵活和智能的自适应注意力机制成为了研究的热点。这种注意力机制可以根据不同输入的情况动态地调整注意力的权重,从而更好地适应不同的任务和场景。

自适应注意力机制的实现需要进一步探索新的计算方法和模型结构,以实现更加智能和灵活的注意力机制。该技术可以大大提高模型的泛化能力和适应性,使得模型在不同任务和领域中表现更加稳定和出色。

### 5.2 多模态融合的注意力机制

随着多模态数据在人工智能领域中的广泛应用,将注意力机制扩展到多模态数据的融合成为了一个重要的研究方向。多模态融合的注意力机制可以同时关注不同数据模态之间的关联性,从而更好地实现跨模态信息的交互与融合。

未来,多模态注意力机制将成为研究的热点之一,需要进一步研究如何有效地融合文本、图像、视频等多种数据模态,并且设计相应的注意力机制实现跨模态信息的获取和利用。

### 5.3 隐私保护与公平性

随着人工智能在社会各个领域的广泛应用,注意力机制也面临着隐私保护和公平性的挑战。当前的注意力机制模型普遍需要大量的数据进行训练和调优,而这些数据可能涉及到个人隐私信息,存在潜在的泄露风险。

未来的注意力机制研究需要更加关注隐私保护和公平性这两个重要问题,提出相应的算法和模型来保障用户数据的隐私安全,并且确保模型的决策过程是公平且可解释的。

### 5.4 增强学习中的注意力机制

随着增强学习在复杂决策任务中的成功应用,将注意力机制与增强学习相结合也成为了一个潜在的趋势。通过引入注意力机制,增强学习模型可以更加智能地选择关键的状态或动作,从而提高模型的学习效率和性能。

未来的研究将重点关注如何在增强学习中有效地引入注意力机制,设计相应的模型和算法实现智能的决策,使得模型能够在复杂环境中做出更加准确和高效的决策。

以上是关于注意力机制未来发展趋势与挑战的一些探讨,随着人工智能领域的不断发展,注意力机制将持续发挥重要作用,并且迎来更多的创新与突破。

0

0