【机器学习模型评估指南】:掌握交叉验证与性能度量,Python中的应用

发布时间: 2024-08-31 07:42:56 阅读量: 156 订阅数: 54

应用机器学习:应用机器学习入门的分步指南

# 1. 机器学习模型评估基础

## 1.1 模型评估的必要性

在构建机器学习模型时,评估模型性能是至关重要的一步。模型评估可以量化地表示模型的泛化能力,即模型对未见数据的预测能力。正确评估模型是确保模型在实际应用中能够有效工作的基础。评估结果可以帮助我们了解模型的优势和弱点,以便做出相应的调整,包括选择不同的算法、调整模型参数、或是进一步优化数据处理流程。

## 1.2 评估标准与方法

评估模型性能的标准和方法多种多样,根据任务的不同(如分类、回归、聚类等)和数据类型的不同(如结构化数据、图像、文本等),评估指标和方法也会有所不同。例如,在分类任务中常用的评估指标包括准确率、精确率、召回率和F1分数,而在回归任务中,均方误差(MSE)和决定系数(R²)则更为常见。正确选择评估方法和标准,能够帮助我们更客观地评价模型的性能,指导模型的优化。

## 1.3 评估流程

模型评估流程通常包括以下几个步骤:

1. **数据集划分**:将数据集划分为训练集和测试集,以独立评估模型性能。

2. **模型训练**:在训练集上训练模型。

3. **性能评估**:在测试集上应用模型,根据选定的评估标准计算性能指标。

4. **模型调整**:根据评估结果调整模型参数或结构。

5. **迭代优化**:重复上述步骤,直到获得满意的结果。

在模型评估的整个流程中,数据集的划分尤其重要,因为不同的划分可能会导致不同的评估结果。因此,采用交叉验证等技术可以减少划分带来的随机性,提高评估的稳定性和准确性。

# 2. 交叉验证的理论与方法

## 2.1 交叉验证的概念和重要性

### 2.1.1 什么是交叉验证

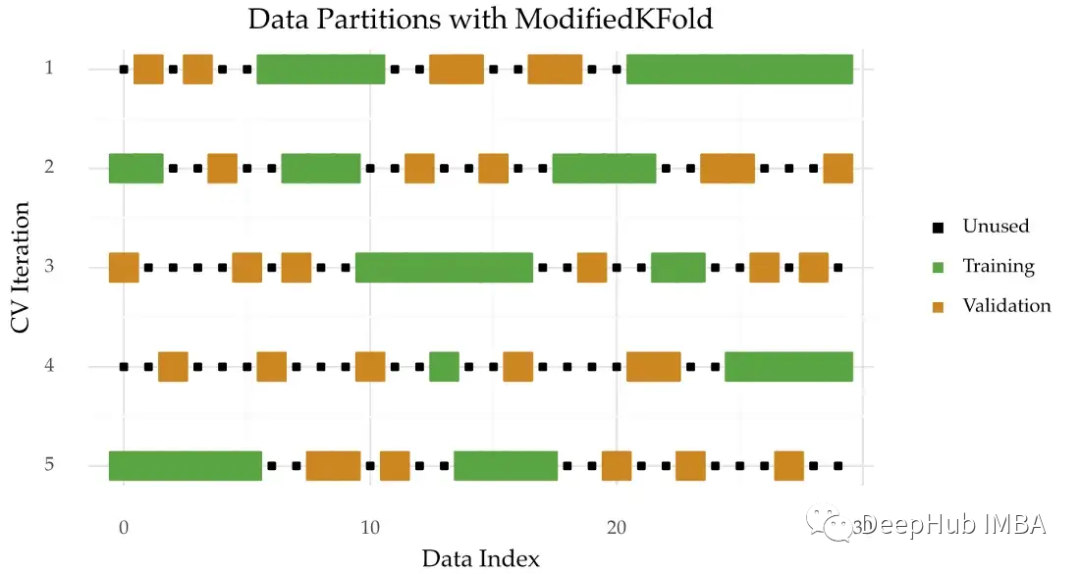

交叉验证(Cross-Validation)是一种评估统计分析模型性能的方法,它通过将数据集分成几个小的子集来进行模型训练和验证。在交叉验证中,模型在不同的数据子集上进行多次训练和验证,以此来减少模型评估中的随机性。交叉验证的常见类型之一是K折交叉验证(K-Fold Cross-Validation),它将原始数据集分成K个大小相等的子集。在每次迭代中,选择其中的一个子集作为测试集,其余的K-1个子集用于训练模型。模型在所有K次迭代中得到的性能评估结果的平均值,被认为是该模型的性能指标。

### 2.1.2 为什么需要交叉验证

在模型构建过程中,我们面临的一个主要问题是模型可能对特定的数据集过拟合,尤其是当训练集的规模有限时。为了验证模型的泛化能力,我们需要一种方法来评估模型在未见过的数据上的表现。交叉验证解决了这一问题,它通过多次使用不同的数据子集进行模型训练和测试,从而模拟了模型在新数据上的表现。此外,交叉验证还可以提供对模型性能的更可靠的估计,因为它结合了多种数据分割方式的结果,减少了因数据划分不同而引起的性能估计方差。

## 2.2 常用的交叉验证技术

### 2.2.1 K折交叉验证

K折交叉验证是交叉验证中最为常用的一种形式,它将原始数据集分成K个不重叠的子集。这K个子集被随机打乱后,依次作为测试集,而其余的K-1个子集作为训练集。模型在K次训练和验证过程中得到的性能评估结果,最后会被平均。选择合适的K值对于评估过程来说非常重要,常用的K值有5或10,但在实际应用中,K值的选择需要根据数据集的大小来确定。

### 2.2.2 留一交叉验证(LOO)

留一交叉验证(Leave-One-Out Cross-Validation,简称LOO)是K折交叉验证的一种特例,其中K值等于数据集中的样本总数。在这种验证方法中,每次模型都使用除当前样本外的所有数据进行训练,并对这个样本进行预测。这种方法的一个主要优点是它使用了所有的数据样本作为测试集,因此可以得到较为稳定的性能估计。然而,LOO的计算成本非常高,因为模型需要进行与数据集样本数相同次数的训练过程。

### 2.2.3 时间序列交叉验证

时间序列交叉验证特别适用于时间序列数据,因为它考虑了数据点之间可能存在的时序关系。在这种交叉验证方法中,数据被划分为多个时间段。模型首先在一个时间段上进行训练,然后在一个随后的时间段上进行测试。这种方法的关键是保证数据点的顺序不被打破,这样可以有效地评估模型对于时间序列数据的预测能力。时间序列交叉验证对于金融分析、气象预测等领域尤为关键。

## 2.3 交叉验证的实践技巧

### 2.3.1 避免数据泄露

交叉验证中的一个常见问题是数据泄露,即训练集中的信息无意中被用在了模型测试阶段。为了避免数据泄露,必须确保每次训练模型时所使用的数据集严格独立于测试数据集。这意味着在训练集和测试集的划分过程中,任何与测试数据相关的特征或统计信息都不应影响到模型的训练。例如,在K折交叉验证中,需要在每次划分数据集之前进行特征缩放或归一化,以防止测试集的特征统计信息泄漏到训练集中。

### 2.3.2 选择合适的交叉验证策略

选择交叉验证策略时,需要考虑数据集的规模和类型。对于大型数据集,K折交叉验证可能是最佳选择。而对于小型数据集,可能需要选择留一交叉验证或更小的K值。此外,如果数据具有强烈的时序特征,那么时间序列交叉验证是不可或缺的。在实际操作中,可以尝试不同的交叉验证策略,并对结果进行比较,以便选择最适合当前问题和数据的策略。

### 2.3.3 交叉验证的性能评估指标

交叉验证的主要目的是得到一个可靠的性能评估指标。常见的性能评估指标包括准确率、精确率、召回率和F1分数等。在选择评估指标时,需要结合具体问题的业务背景和需求。例如,在某些情况下,精确率可能比召回率更重要;而在其他情况下,可能需要一个综合指标,如F1分数,来平衡两者之间的权衡。因此,在执行交叉验证时,应预先确定所关注的性能评估指标,并在多次交叉验证过程中进行统计分析,以获得稳定的性能评估结果。

```python

# 示例代码:使用scikit-learn进行K折交叉验证

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import load_iris

# 加载iris数据集

iris = load_iris()

X = iris.data

y = iris.target

# 初始化逻辑回归模型

logreg = LogisticRegression(max_iter=10000)

# 使用K折交叉验证,K取5

scores = cross_val_score(logreg, X, y, cv=5)

# 输出每次交叉验证的准确率

print(scores)

```

在上述代码中,我们首先导入了交叉验证相关的模块和逻辑回归模型。然后加载了iris数据集,并对逻辑回归模型使用5折交叉验证方法进行了性能评估。代码执行后输出了每次交叉验证的准确率,从而可以对模型性能进行判断。

由于在交叉验证的实践技巧中提到的避免数据泄露的问题,我们应当确保在每次划分数据集之前进行特征缩放或归一化,代码示例如下:

```python

from sklearn.preprocessing import StandardScaler

# 初始化标准化方法

scaler = StandardScaler()

# 对数据集进行标准化处理

X_scaled = scaler.fit_transform(X)

# 重新运行带有特征缩放的交叉验证过程

scores_scaled = cross_val_score(logreg, X_scaled, y, cv=5)

print(scores_scaled)

```

在上述代码中,我们对数据集X进行了标准化处理,并使用相同的逻辑回归模型和交叉验证方法重新进行性能评估。这样可以确保特征缩放在整个交叉验证过程中都发挥作用,从而有效避免数据泄露问题。

通过本章节的介绍,我们对交叉验证的理论与方法有了更深入的了解。下一章节我们将探讨性能度量的关键指标,这些指标是评估机器学习模型性能的核心工具。

# 3. 性能度量的关键指标

## 3.1 分类任务的性能度量

分类问题是机器学习中最常见的一类问题,对于分类任务,其性能的度量标准也是多样化的。以下是几种在分类任务中常见的性能评估指标:

### 3.1.1 准确率、精确率和召回率

准确率(Accuracy)是分类问题中最直观的指标,它表示的是被正确分类的样本数占总样本数的比例。计算公式为:

```

准确率 = (正确预测的正样本数 + 正确预测的负样本数) / 总样本数

```

尽管准确率是一个普遍适用的指标,但在某些情况下它可能会产生误导。例如,在不平衡的数据集中,即使模型简单地将所有样本预测为多数类,其准确率也可能非常高。为了解决这一问题,我们引入精确率(Precision)和召回率(Recall)两个指标。

精确率关注的是模型预测为正类的样本中有多少是真正的正类,召回率则关注的是真正的正类有多少被模型正确预测出来。计算公式分别为:

```

精确率 = 真正例 / (真正例 + 假正例)

召回率 = 真正例 / (真正例 + 假负例)

```

### 3.1.2 F1分数和混淆矩阵

F1分数是精确率和召回率的调和平均值,它试图平衡二者之间的关系,是对于正类的一个综合性能指标。计算公式为:

```

F1 = 2 * (精确率 * 召回率) / (精确率 + 召回率)

```

在多类别分类中,通常使用混淆矩阵来展示模型性能。混淆矩阵是一个表格,其行表示实际类别,列表示预测类别。其元素a到d分别表示:

- a:真正例(True Positive, TP)

- b:假正例(False Positive, FP)

- c:假负例(False Negative, FN)

- d:真负例(True Negative, TN)

0

0