定时任务自动化:Dask在数据处理工作流中的应用

发布时间: 2024-09-29 23:14:26 阅读量: 62 订阅数: 27

Python中的分布式数据处理技术与实践

# 1. Dask概述及定时任务自动化背景

在当今快节奏的数据驱动业务环境中,数据的实时处理和定时任务的自动化已经成为提高效率和响应速度的关键。Dask作为一个灵活的并行计算库,为Python用户提供了一种处理大规模数据集的高效方法。Dask的定时任务自动化不仅可以增强数据处理流程的可靠性,还可以提高资源使用率,优化整体工作流。本章节将深入探讨Dask的设计理念,以及定时任务自动化的背景和意义,为进一步深入探讨Dask在数据处理中的应用打下坚实的基础。

# 2. Dask基础与定时任务设计

### 2.1 Dask的架构与核心组件

#### 2.1.1 Dask的基本概念与组件介绍

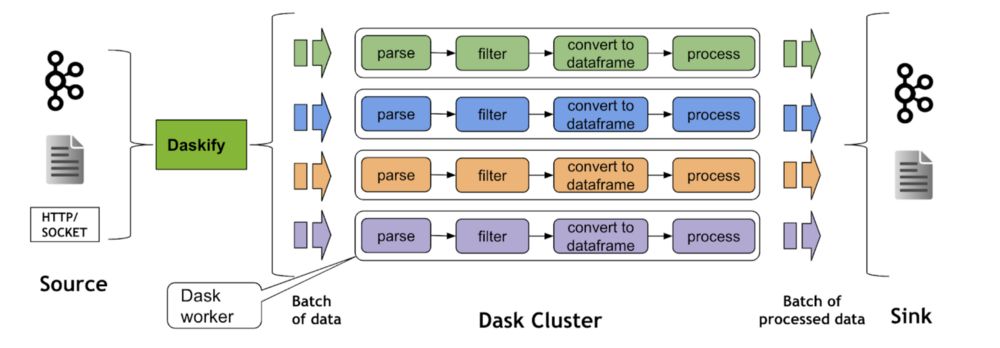

Dask是一个灵活的并行计算库,设计用于轻松扩展Numpy、Pandas和Scikit-Learn等常见Python库的计算能力。它能够处理大型数据集并利用多核处理器提高计算速度。Dask核心包含以下几个组件:

- **Dask DataFrame**:模仿Pandas DataFrame,适合于表格数据。

- **Dask Array**:模仿Numpy数组,适用于数值计算。

- **Dask Bag**:处理非结构化数据和Python对象。

- **Dask Delayed**:用于延迟执行函数,构建复杂的任务图。

Dask通过构建一个任务图,记录了任务之间的依赖关系,然后优化执行计划,并且可以利用本地或分布式资源并行执行。

#### 2.1.2 Dask的任务调度机制

Dask的任务调度机制由两个主要部分组成:任务图和调度器。

- **任务图(Task Graph)**:Dask使用有向无环图(DAG)来表示计算任务及其依赖性。每个节点代表一个任务,每条边代表任务之间的依赖关系。

- **调度器(Scheduler)**:调度器负责计算任务的执行。Dask提供了多种调度器:单一进程调度器、多进程调度器以及分布式调度器。分布式调度器能够在集群上运行Dask,将任务分配到不同的工作节点上执行。

Dask调度器有两种模式:即时执行(即时模式)和延迟执行(惰性模式)。即时模式适用于简单快速的任务,而延迟模式则更灵活,适用于复杂的计算任务。

### 2.2 定时任务的基本理论

#### 2.2.1 定时任务的定义和应用场景

定时任务是一种在指定时间或周期性运行的程序,也称为计划任务或Cron任务。它们在自动化执行任务方面非常有用,例如备份文件、更新数据、运行报告等。

- **应用场景**:

- **数据备份**:定期备份数据库或文件系统。

- **数据分析**:周期性地运行分析脚本,为决策提供支持。

- **系统监控**:定时检查系统性能或日志文件。

- **内容更新**:定时更新网站或移动应用内容。

#### 2.2.2 定时任务调度策略

在Dask中实现定时任务时,需要决定任务执行的调度策略:

- **固定频率**:比如每天、每周、每月等固定时间执行任务。

- **固定间隔**:例如每隔1小时执行一次任务。

- **基于事件**:任务在特定事件发生时执行,如数据到达或某个条件满足。

- **基于条件**:只有当特定条件满足时,任务才会执行。

选择哪种调度策略取决于任务的需求和环境约束。

### 2.3 设计高效定时任务的工作流

#### 2.3.1 任务流的建立与管理

设计一个高效的工作流,首先需要考虑如何建立和管理任务流:

- **定义任务依赖**:明确任务之间的依赖关系,确保执行顺序正确。

- **任务粒度控制**:合理划分任务,避免过大或过小的粒度。

- **资源利用平衡**:确保任务在可用资源中均匀分配。

在Dask中,可以通过Dask Delayed装饰器来延迟函数的执行,并构建任务之间的依赖关系。

#### 2.3.2 工作流的监控与日志记录

监控和日志记录对于定时任务的成功执行至关重要:

- **任务监控**:实时监控任务状态,如执行时间、成功或失败的次数。

- **日志系统**:记录执行过程中的关键信息,有助于问题诊断和性能分析。

- **警报机制**:在任务失败时能够及时通知相关人员。

Dask允许集成第三方日志库,如Python的内置`logging`模块,以及各种专门的监控系统。

在构建高效定时任务的工作流时,应当确保清晰定义任务的依赖关系,合理管理资源,并通过日志监控来优化任务的执行和响应异常情况。Dask作为并行计算工具,通过灵活的任务图和调度器,为实现这些目标提供了强大的支持。

现在,您已经了解了Dask的基础知识以及如何设计一个定时任务的工作流。在下一章节中,我们将进一步探讨Dask在数据处理中的实际应用案例,以及如何通过定时任务来优化这些处理流程。

# 3. Dask在数据处理中的应用实例

Dask是Python中一个强大的并行计算库,它允许用户轻松扩展计算到多台机器,无需改变现有的代码库。本章节将通过具体实例深入探讨Dask在数据处理中的应用,特别是针对数据预处理与清洗、并行计算与性能优化以及定时任务的数据处理实践。

## 3.1 数据预处理与清洗

在数据处理过程中,数据预处理与清洗是不可或缺的步骤。它们确保了分析的质量,并为后续的数据分析和挖掘工作打下了坚实的基础。Dask通过并行计算,大大加速了这些工作流。

### 3.1.1 数据加载与格式转换

在大数据时代,数据的加载和格式转换是数据处理的第一步。Dask能够处理比内存大得多的数据集,并允许用户以并行化的方式读取数据,这一点在处理大规模数据时尤其重要。

```python

import dask.dataframe as dd

from dask.diagnostics import ProgressBar

# 假设有一个大规模的CSV文件需要读取

csv_file = 'large_dataset.csv'

# 使用Dask读取CSV文件,避免内存溢出

ddf = dd.read_csv(csv_file)

# 执行并行计算

with ProgressBar():

result = ***pute()

# 结果是一个Pandas DataFrame对象

```

上述代码段展示了如何使用Dask读取一个大规模CSV文件。代码中的`read_csv`函数是一个懒加载函数,它并不会立即加载数据,而是构建一个Dask DataFrame对象,该对象表示一个计算图。在调用`compute`方法时,Dask将计算图转换成具体的任务,并行执行。

### 3.1.2 数据清洗与异常值处理

数据清洗通常包括处理缺失值、异常值,以及规范化数据格式等。使用Dask进行这些操作同样可以实现并行计算。

```python

# 处理缺失值

ddf_cleaned = ddf.fillna(0)

# 删除包含异常值的行

ddf_cleaned = ddf_cleaned[ddf_cleaned['column'] < 1000]

# 规范化数据格式

ddf_cleaned['date'] = ddf_cleaned['date'].apply(lambda x: dask.delayed(normalize_date)(x))

def normalize_date(date_str):

# 一个将日期字符串转换为统一格式的函数

pass

```

在上述代码中,`fillna`、条件过滤以及`apply`方法被用来处理缺失值、异常值和数据格式规范化。这里使用了Dask的延迟计算(delayed)功能,将每个处理步骤转换为可以异步执行的任务。

## 3.2 并行计算与性能

0

0