HDFS压缩技术:存储与传输成本的节约之道

发布时间: 2024-10-28 20:27:47 阅读量: 45 订阅数: 44

# 1. HDFS压缩技术概述

在大数据生态系统中,Hadoop分布式文件系统(HDFS)作为核心组件之一,承担着存储海量数据的任务。随着数据量的爆炸式增长,存储成本和网络带宽成为必须面对的挑战。HDFS压缩技术应运而生,它通过减少存储空间占用和加快数据传输速度,有效缓解了这些问题。本章将简要介绍HDFS压缩技术的背景、意义及应用场景,为后续章节中深入探讨压缩技术的原理、实践应用和挑战提供一个总体框架。

# 2. HDFS压缩的理论基础

## 2.1 HDFS压缩技术的原理

### 2.1.1 数据压缩的概念

数据压缩是通过算法减少数据冗余,以降低存储空间和提高传输效率的技术。在HDFS中,数据压缩可减少磁盘空间的占用,并降低网络传输带宽的使用。压缩的原理是将重复的数据序列利用更短的表示形式替代,从而达到压缩的目的。例如,如果一段文本中频繁出现同一个词,那么可以使用一个更短的代码代替这个词,而这个代码与词的映射关系会被记录下来,在数据被读取时进行解压缩。

### 2.1.2 压缩算法的分类和特点

压缩算法可以分为无损压缩和有损压缩两大类。无损压缩可以在不丢失任何信息的前提下还原原始数据,而有损压缩则以牺牲部分数据质量为代价,换取更高的压缩率。在HDFS中,通常使用无损压缩算法,以确保数据的完整性。

无损压缩算法又可以分为以下几类:

- 字典编码方法,例如LZ77和LZ78,它们通过查找重复的字符串并将它们替换为短代码实现压缩。

- 统计编码方法,如霍夫曼编码和算术编码,它们根据字符出现的概率分配不同长度的编码。

- 基于模型的方法,如预测器和自适应算法,它们利用数据的模式来预测接下来可能出现的数据,然后只存储预测误差。

每种压缩算法有其特点,选择合适的算法会直接影响到压缩率、压缩速度、解压缩速度以及对计算资源的需求。

## 2.2 压缩格式的选择标准

### 2.2.1 压缩率与压缩速度的权衡

压缩率是压缩数据与原始数据大小的比例,是衡量压缩效果的重要指标。高压缩率可以大幅减少存储空间需求,但同时可能会带来压缩速度的降低。压缩速度是指压缩算法处理数据的效率,与硬件资源和算法复杂度相关。在选择压缩格式时,需要根据实际业务需求,权衡压缩率和压缩速度,以达到最佳存储成本与性能平衡。

### 2.2.2 压缩与解压缩的性能影响

除了压缩速度,解压缩速度同样重要,因为数据最终需要被还原成原始形式以供处理和分析。一个良好的压缩算法应当能够提供快速的压缩和解压缩速度。解压缩性能会直接影响到数据访问的延迟,特别是对实时性要求高的业务场景。因此,评估压缩格式时,要综合考虑压缩与解压缩的综合性能。

### 2.2.3 压缩格式与HDFS兼容性分析

Hadoop生态系统的兼容性是选择压缩格式的重要因素。不同的压缩算法对硬件资源的要求也各不相同,例如Snappy在快速压缩方面表现出色,但压缩率相对较低;而Gzip则在高压缩率方面有更好的表现,但压缩和解压缩速度较慢。选择压缩格式时,需要考虑到HDFS集群的配置、Hadoop版本的兼容性以及存储和计算资源的可用性。

## 2.3 HDFS中压缩的优势与挑战

### 2.3.1 存储空间的有效节约

采用压缩技术可以有效节约存储空间。在存储成本持续上升的今天,这一点尤为重要。特别是在大数据存储场景中,数据量呈指数级增长,压缩技术能够大幅度减少存储设备的采购成本和运维费用。例如,在一个数据仓库场景下,使用Gzip压缩可能实现高达60%-80%的压缩率,显著降低存储成本。

### 2.3.2 网络传输的加速

除了节省存储空间,压缩技术还可以加速数据在网络中的传输。对于分布式存储系统,数据通常需要在多个节点之间频繁传输,网络带宽成为一个瓶颈。压缩数据可以减少传输的数据量,缩短传输时间,提高整体系统的运行效率。

### 2.3.3 压缩技术带来的潜在问题

虽然压缩技术有诸多优势,但也存在潜在问题。首先,压缩和解压缩过程需要额外的计算资源,这可能会对集群性能造成影响。其次,错误的压缩格式选择可能会导致I/O性能下降,尤其是在压缩率和压缩速度之间需要做出权衡。此外,一些压缩算法可能会增加系统的复杂度,对运维人员提出更高的技能要求。

在实际应用中,开发者和运维人员需要仔细评估以上因素,并结合业务特点,选择最合适的压缩技术解决方案。

# 3. HDFS压缩技术的实践应用

## 3.1 压缩技术在HDFS中的配置与管理

### 3.1.1 配置HDFS支持压缩格式

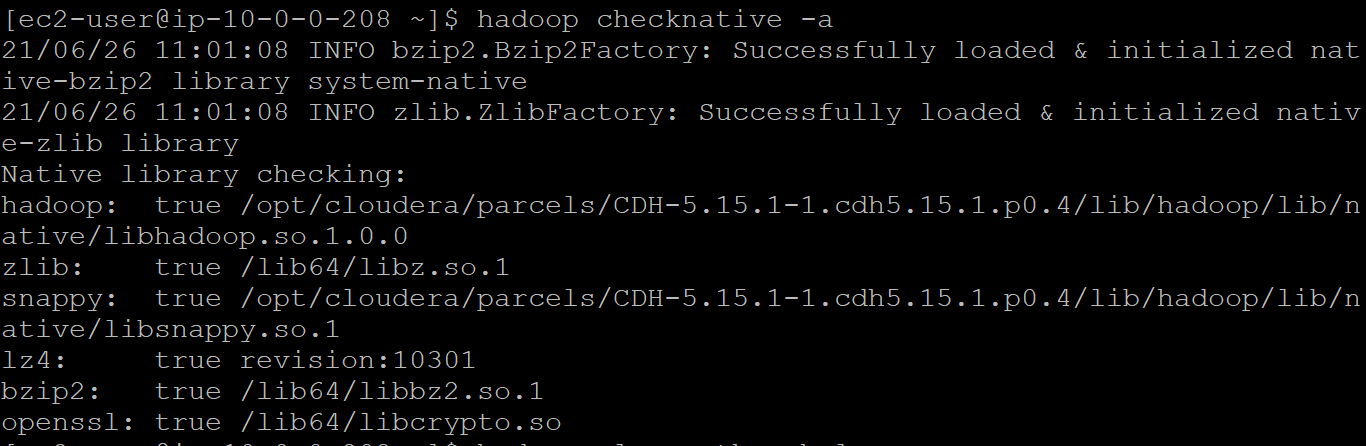

在Hadoop生态系统中,为了实现数据的高效存储和传输,配置HDFS以支持不同的压缩格式是至关重要的。Hadoop默认支持多种压缩编解码器,如Gzip、Bzip2、LZ4和Snappy等。要启用HDFS的压缩支持,通常需要在Hadoop的配置文件`hadoop-site.xml`中设置`***pression.codecs`属性,如下所示:

```xml

<configuration>

<property>

<name>***pression.codecs</name>

<value>

***press.DefaultCodec,

***press.GzipCodec,

```

0

0