超参数调优的黄金法则:有效找到最佳参数的6个步骤

发布时间: 2024-09-02 05:56:09 阅读量: 96 订阅数: 87

sldemo_enginewc_12bstudent_电机’_PID参数电机_PID调节实验_电机PID_sldemo_engi

# 1. 超参数调优简介

超参数调优是机器学习模型调优中的一个关键步骤,它对最终模型的性能有着显著的影响。简单来说,超参数是在学习过程开始之前设定的参数,它们控制着学习算法的行为,并且通常不是通过训练数据直接学习得到的。在本章中,我们将初步介绍超参数调优的概念,并探索它在机器学习工作流程中的位置和重要性。

超参数是机器学习模型结构和训练过程中的配置选项,例如学习率、网络层数、批量大小等。这些参数不是从训练数据中直接学习得到的,而是需要我们根据模型性能反馈手动或使用某种策略进行调整。良好的超参数设置能够显著提升模型的性能,而拙劣的设置则可能导致模型欠拟合或过拟合,影响模型的泛化能力。

超参数调优的目的是找到一组最优的参数配置,以使得在未知数据上的预测性能达到最佳。为了实现这一目标,我们将在后续章节中探讨各种调优方法,并在实践中学习如何应用这些方法。因此,第一章为整个超参数调优旅程打下了基础,我们从了解它是什么,为什么重要开始。在接下来的章节中,我们将深入探索超参数调优的理论基础、实践技巧、工具和框架,以及真实案例研究。

# 2. 理论基础

## 2.1 超参数与模型性能的关系

### 2.1.1 何为超参数及其重要性

超参数是机器学习模型的外部参数,不同于模型训练过程中的参数(权重和偏置),它们不能通过训练直接从数据中学习得到。它们必须在训练过程之前手动设定,而超参数的选择对模型的性能有着直接且显著的影响。超参数的调整可以视作模型性能的“调节器”,它决定了模型的复杂度,影响模型是否能够捕捉到数据的真实分布,以及能否避免过拟合或欠拟合的问题。

超参数的重要性体现在以下几个方面:

1. **控制模型复杂度**:超参数如神经网络中的层数和每层的节点数、决策树的深度等,直接控制模型复杂度。合适的复杂度能够帮助模型更好地泛化到新的数据上。

2. **影响训练过程**:学习率、批大小等参数影响模型的学习速度和稳定性。比如,一个过大的学习率可能导致模型无法收敛,而过小则会使训练过程异常缓慢。

3. **提高模型泛化能力**:例如,正则化项的系数、集成学习中的基学习器数量等超参数,有助于提高模型在未知数据上的表现,防止过拟合。

### 2.1.2 超参数对模型训练的影响

超参数设置不恰当可能会导致以下问题:

1. **过拟合**:如果模型过于复杂,它可能会学习到训练数据中的噪声,从而在新的、未见过的数据上表现不佳。

2. **欠拟合**:一个过于简单的模型可能不能捕捉数据的底层结构,即使在训练集上也不会有好的表现。

3. **收敛速度**:某些超参数(如学习率)能够影响模型学习的效率,不同的设定可能导致训练过程中模型收敛到最优解的速度差异巨大。

为了最大程度地提升模型性能,就必须理解和掌握这些超参数如何影响模型的行为,并在实践中进行细致的调整。而这就需要对超参数调优的方法论有所了解。

## 2.2 超参数调优的常见方法论

### 2.2.1 手动调优

手动调优是最基础也是最直观的超参数调整方法,它涉及以下几个步骤:

1. **随机搜寻**:在参数空间中随机选择不同的超参数组合,观察不同设置对模型性能的影响。

2. **基于经验**:结合以往的经验和直觉,手动选择一组超参数,然后进行测试。

3. **调整与迭代**:根据模型性能的反馈调整超参数,反复迭代直至找到较为满意的性能。

尽管这种方法直观且不需要额外的工具,但它通常耗时且效率低下,特别是当超参数的维度较高时。

### 2.2.2 自动调优

自动化超参数调优的目的是提高效率,减少手动干预。常见的自动化方法包括:

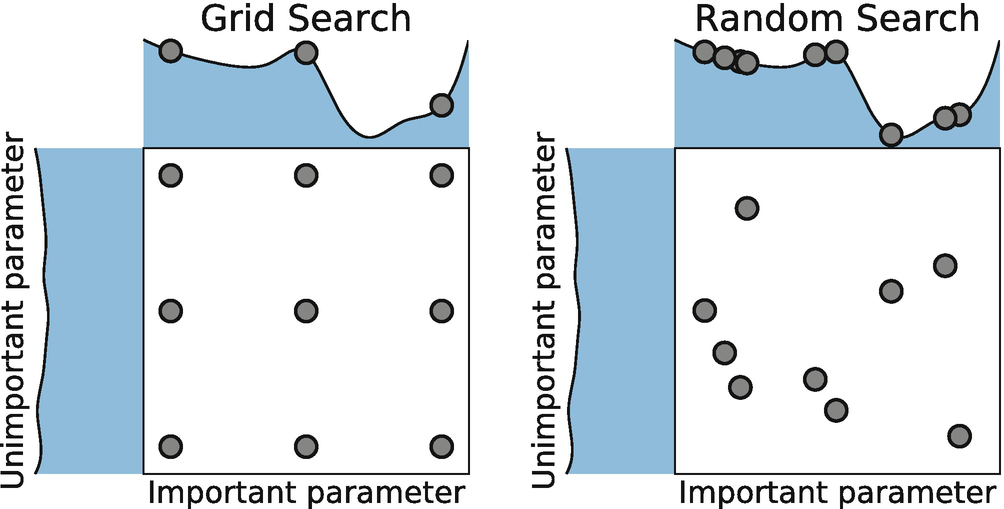

1. **网格搜索**:系统地遍历一组定义好的超参数组合,并基于某种性能指标评估每一种组合。

2. **随机搜索**:在超参数空间内随机选择组合进行评估,通常比网格搜索更高效。

3. **基于模型的搜索**:使用一个替代模型(如贝叶斯模型)来预测哪些超参数组合可能会有较好的性能,然后专注于这些区域。

### 2.2.3 基于算法的调优技术

更高级的调优技术使用算法来指导搜索过程,这些算法能够基于先前的评估结果智能地选择超参数,以下是一些应用广泛的算法:

1. **贝叶斯优化**:使用贝叶斯模型来建立超参数与模型性能之间的概率模型,进而指导搜索最佳的超参数组合。

2. **进化算法**:模拟自然选择的过程,通过选择、交叉、变异等操作产生新的超参数组合,进而找到最优解。

3. **强化学习**:通过强化学习来优化超参数,智能体学习在超参数空间中的策略,以最大化模型的验证集性能。

自动调优方法能够大大节省时间,并通常能找到更好的超参数组合,但它们也可能需要更多的计算资源和调优技巧。在下一章节中,我们将深入探讨网格搜索、随机搜索和贝叶斯优化等实践技巧。

# 3. 实践技巧

## 3.1 基于网格搜索的超参数调优

### 3.1.1 网格搜索的原理

网格搜索是最传统也是最直观的超参数调优方法。它的基本思想是预先定义一个超参数的值的集合(形成一个网格),然后通过穷举的方式尝试所有可能的组合,找出最优的超参数配置。这种方法的计算成本通常很高,因为它需要穷举所有可能的参数组合,但在参数空间较小且模型训练较快时,网格搜索是有效的。

### 3.1.2 网格搜索的实践指南

在实际操作中,网格搜索可以通过`GridSearchCV`函数在Scikit-learn中实现。下面是一个例子:

```python

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 定义模型

rf = RandomForestClassifier()

# 定义超参数网格

param_grid = {

'n_estimators': [50, 100, 200],

'max_depth': [None, 10, 20, 30],

'min_samples_split': [2, 5, 10]

}

# 创建GridSearchCV对象

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5, n_jobs=-1)

# 进行网格搜索

grid_search.fit(X, y)

# 输出最佳参数

print('Best parameters:', grid_search.best_params_)

```

在这个例子中,我们使用了`GridSearchCV`,其中指定了模型、参数网格、交叉验证的折数(`cv`)和用于并行计算的CPU数(`n_jobs=-1`表示使用所有可用核心)。

执行逻辑说明:上述代码中`GridSearchCV`会训练`n_estimators` * `m

0

0