MATLAB超参数调优法则:找到最佳配置的不二法门

发布时间: 2024-08-30 20:35:38 阅读量: 37 订阅数: 49

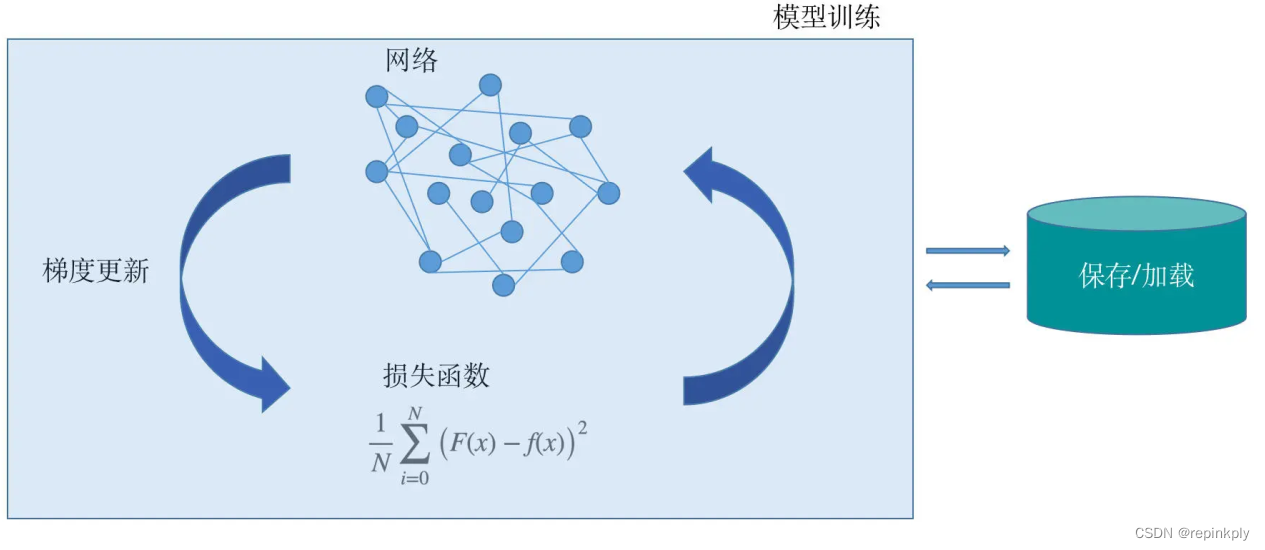

# 1. MATLAB超参数调优概述

在机器学习与深度学习领域,超参数调优扮演着至关重要的角色。超参数是控制学习过程的外部配置,而非模型内部学习得到的参数。正确设置这些参数,对于模型的性能和泛化能力具有决定性影响。MATLAB作为一个强大的数学计算和仿真平台,提供了多种内置工具以及广泛的函数库,让研究者和开发者能快速有效地进行超参数调优。通过本章,我们将对MATLAB超参数调优的基础进行概述,并为后续章节中更深入的理论与实践探讨奠定基础。

# 2. 超参数调优的理论基础

在上一章中,我们对MATLAB超参数调优进行了概览,并引入了这一领域的重要性。本章将深入探讨超参数调优的理论基础,帮助读者理解不同调优技术的工作原理,以及如何在模型训练过程中选择和应用这些技术。

## 2.1 超参数调优的基本概念

### 2.1.1 定义与重要性

超参数调优是机器学习领域一个重要的子话题,它涉及选择能够产生最佳学习算法配置的过程。超参数不同于模型参数,后者是在训练过程中通过算法学习得到的,而超参数则是在学习开始之前设定的。超参数通常控制着学习过程的诸如学习速率、迭代次数、正则化项强度等因素。

超参数的正确设定对模型的最终性能有着决定性的影响。如果超参数设定不当,可能会导致模型无法收敛、过拟合或欠拟合。因此,超参数调优是一个确保模型泛化能力的关键步骤。

### 2.1.2 常见超参数类型

在不同的学习算法中,超参数的类型多样,以下是一些在机器学习中最常见的超参数类型:

- 学习率:在梯度下降算法中,学习率决定了每次迭代中参数更新的步伐大小。

- 迭代次数:训练算法运行的次数,控制了模型训练的时长。

- 正则化系数:控制模型复杂度和避免过拟合的参数,如L1、L2正则项系数。

- 隐层节点数:在神经网络中,隐层的节点数将直接影响模型的表达能力。

- 核函数及核函数参数:在支持向量机等核方法中,核函数的选择和其参数的设定对模型性能至关重要。

## 2.2 调优技术的分类与原理

### 2.2.1 网格搜索与随机搜索

网格搜索是一种简单直观的超参数优化方法。它通过构建一个参数的候选值网格,并在所有可能的参数组合上进行交叉验证来选择最佳的超参数。网格搜索的主要缺点是计算成本高,特别是当搜索空间很大时。

随机搜索则是另一种选择,它通过随机选择一定数量的参数组合进行评估。随机搜索相对于网格搜索的一个主要优势在于,它不需要遍历整个参数空间,可以更高效地探索参数空间,尤其在参数空间很大时。

### 2.2.2 贝叶斯优化方法

贝叶斯优化是一种更高效的参数搜索方法,它通过建立一个关于目标函数的概率模型,并利用该模型来指导搜索过程。贝叶斯优化通常包括以下几个步骤:

- **建立先验分布**:根据先验知识或经验选择一个合适的概率模型作为先验。

- **选择采集函数**:采集函数用于确定下一步尝试的参数,常用的是期望改进(EI)。

- **更新模型**:根据新的评估结果更新概率模型。

- **优化采集函数**:使用优化算法来找到最优的采集函数值对应的参数。

贝叶斯优化方法在处理高维参数空间时表现尤为出色,因为它能够更智能地在参数空间中探索。

### 2.2.3 遗传算法与进化策略

遗传算法(GA)和进化策略(ES)是启发式搜索算法,它们模拟自然选择和遗传机制。在超参数调优中,这些算法通过定义适应度函数来评估参数组合的性能,然后通过选择、交叉、变异等操作迭代产生新一代的参数组合。

这些算法的主要优点是能够高效地在复杂和多峰的参数空间中找到较好的解,而不需要关于目标函数的先验知识。然而,这些算法的计算成本相对较高,需要更多的迭代次数才能收敛到好的解。

## 2.3 调优过程中的模型评估

### 2.3.1 交叉验证与保留验证集

在超参数调优过程中,正确评估模型性能至关重要。常用的评估方法包括交叉验证和保留验证集。

交叉验证是通过将数据集分成K个部分,轮流将其中一部分作为测试集,其余作为训练集的验证方法。这种方法能够减少模型性能估计的方差,使得评估结果更加可靠。

保留验证集方法则是将数据集分成两个部分:训练集和测试集。模型在训练集上进行训练,在验证集上进行评估,这种方法较为简单直接。

### 2.3.2 性能指标的选择与应用

在选择超参数时,我们还需要选择合适的性能指标来评估模型。这些指标包括但不限于:

- 准确率:分类问题中最常用的指标之一。

- 召回率和精确度:在处理不平衡数据集时更加重要。

- F1分数:精确度和召回率的调和平均数,对不平衡数据集敏感。

- ROC曲线下面积(AUC):评估分类器的性能,尤其是当正负类的分布不均衡时。

选择合适的性能指标可以帮助我们更准确地反映模型在特定问题上的表现。

我们已经了解了超参数调优的基本概念和分类原理,以及在调优过程中如何评估模型。这些理论知识将为在MATLAB中实际应用超参数调优打下坚实的基础。在下一章中,我们将详细讨论在MATLAB中如何使用内置工具和编程实践进行超参数调优。

# 3. MATLAB中的超参数调优工具与实践

## 3.1 使用MATLAB内置函数进行调优

### 3.1.1 hyperparameters Optimization工具箱简介

MATLAB提供了一个名为hyperparameters Optimization的工具箱,它专门用于自动化和加速超参数优化的过程。该工具箱提供了一系列的函数和类,使得用户能够通过简单的接口,实现复杂的优化算法。它内置了多种优化方法,比如网格搜索、随机搜索和贝叶斯优化方法,用户可以根据问题的特定需求选择合适的优化策略。

除了内置策略外,hyperparameters Optimization工具箱还允许用户定义自己的优化目标和约束条件,从而实现自定义的搜索策略。此外,该工具箱集成了MATLAB的高性能计算资源,这使得在大型数据集和复杂模型上的超参数调优变得更为高效和可行。

### 3.1.2 函数参数的设定与实例演示

在此,我们以一个简单的机器学习模型为例,展示如何使用hyperparameters Optimization工具箱进行超参数调优。假设我们使用MATLAB内置的`fitcsvm`函数进行支持向量机(SVM)模型的训练,目标是找到最佳的核函数类型和正则化参数C。

以下是使用`bayesopt`函数进行贝叶斯优化的一个简单示例:

```matlab

% 定义模型参数范围

vars = [

optimizableVariable('KernelScale', [1e-3, 1e3], 'Type', 'log'),

optimizableVariable('BoxConstraint', [1e-3, 1e3], 'Type', 'log')

];

% 定义优化目标

objective = @(x) kfoldLoss(fitcsvm(X, Y, 'KernelFunction', x.KernelScale, ...

'BoxConstraint', x.BoxConstraint, 'KFold', 5));

% 进行贝叶斯优化

results = bayesopt(objective, vars, 'IsObjectiveDeterministic', false, ...

'NumSeedPoints', 0, 'AcquisitionFunctionName', 'expected-improvement-plus');

% 输出最佳参数组合

bestX = results.XAtMinObjective;

bestObjective = results.MinObjective;

disp(['最佳核函数缩放系数: ', num2str(bestX.KernelScale)]);

disp(['最佳Box约束值: ', num2str(bestX.BoxConstraint)]);

disp(['模型的交叉验证损失: ',

```

0

0