超参数调优的艺术:精确控制AI算法性能的技巧

发布时间: 2024-09-01 20:20:02 阅读量: 115 订阅数: 73

# 1. 超参数调优基础与重要性

在深度学习和机器学习领域,超参数是那些在学习算法的训练过程之前需要预先设置好的参数,它们不同于模型参数,后者是通过学习过程中的数据自动优化得出的。超参数调优是机器学习模型开发中的一个重要环节,它直接影响到模型的性能表现。

## 超参数调优的目的与价值

超参数的设定通常需要依赖于经验或反复的实验,其目的是为了找到能最大化模型性能的参数组合。一个合适的超参数配置可以显著提升模型的准确率、减少过拟合的风险并加速收敛过程。因此,超参数调优是提升AI系统表现的关键步骤,对于资深数据科学家和机器学习工程师而言,掌握这一技巧尤为重要。

## 超参数调优流程

超参数调优通常包括如下步骤:确定超参数空间、选择优化算法、执行搜索并评估模型性能、记录和分析结果。此外,优化策略如网格搜索、随机搜索和贝叶斯优化是常见的调优方法。理解并应用这些策略,是实现超参数调优的基础。

接下来的章节,我们将详细探讨理论基础、实践技巧、高级策略和未来方向,帮助读者全面提升对超参数调优的理解和应用能力。

# 2. 理论基础:了解AI算法中的超参数

### 2.1 超参数与模型性能的关系

#### 2.1.1 什么是超参数

在机器学习和深度学习模型中,超参数是那些在模型训练之前就需要设定好的参数,它们控制学习过程的各个方面,并且不是通过训练数据直接学习得到的。超参数与模型参数是相对的概念:模型参数(如神经网络中的权重和偏置)是在训练过程中自动学习得到的,而超参数则需要研究人员根据经验或通过一些搜索技术来调整。

典型的超参数包括学习率、批处理大小(batch size)、神经网络层数、激活函数的选择、优化器类型等。这些超参数的存在是为了控制训练过程和模型结构,以适应不同数据集的特点和解决问题的需求。

#### 2.1.2 超参数对模型性能的影响

超参数直接影响到模型的学习能力、泛化能力以及计算效率。以下为几个关键点,它们展示了超参数如何影响模型性能:

- **学习率(Learning Rate)**:学习率控制着在梯度下降过程中模型参数更新的速度。如果学习率太低,模型可能需要更多的时间来收敛,甚至可能陷入局部最小值。如果学习率太高,则可能导致训练过程不收敛。

- **批处理大小(Batch Size)**:在进行梯度下降时,批处理大小决定了每次更新参数时用于计算梯度的数据点数量。较小的批处理大小通常可以提供更稳定且准确的梯度估计,但计算成本高。较大的批处理大小计算速度更快,但可能导致模型泛化能力下降。

- **网络架构(Network Architecture)**:神经网络的层数和每层的神经元数量影响模型的容量和复杂性。更复杂的模型能够捕捉更复杂的数据关系,但也更容易过拟合,并且需要更多的数据和计算资源。

- **正则化参数(Regularization Parameters)**:例如L1和L2正则化项中的系数,它们防止模型过度拟合训练数据,通过惩罚复杂模型来提高模型的泛化能力。

理解超参数与模型性能之间的关系对于提高模型性能至关重要。调整这些超参数有助于找到最优的模型配置,从而在特定任务上实现最佳性能。

### 2.2 常见AI算法的超参数概览

#### 2.2.1 神经网络超参数

神经网络中的超参数非常多样,其中一些关键的超参数包括:

- **层数(Number of Layers)和每层的神经元数(Neurons per Layer)**:决定网络的深度和宽度。更深的网络可以表示更复杂的函数,但也会增加计算复杂度和训练时间。

- **激活函数(Activation Functions)**:常见的激活函数包括ReLU、Sigmoid、Tanh等。选择合适的激活函数对于提高模型的非线性能力和训练效率至关重要。

- **权重初始化方法(Weight Initialization Methods)**:权重初始化方法影响着模型训练的起始点和收敛速度。不同的初始化方法适用于不同类型的网络结构和优化器。

#### 2.2.2 梯度下降算法超参数

梯度下降算法中的一些关键超参数包括:

- **学习率(Learning Rate)**:决定了梯度下降的步长大小。学习率太大可能导致模型无法收敛;学习率太小则可能导致训练速度过慢。

- **动量(Momentum)和自适应学习率算法(如Adam、RMSprop)**:这些算法在更新权重时考虑了之前的梯度信息,有助于加速收敛并避免陷入局部最小值。

#### 2.2.3 树模型超参数

树模型的超参数包括但不限于:

- **树的深度(Tree Depth)**:控制着树模型能够达到的最大深度。深度越大,模型越复杂,可能会导致过拟合。

- **叶子节点最小样本数(Minimum Samples for Split)**:一个节点必须具有的最小样本数,用以确定何时进行分裂。这个参数有助于控制树模型的复杂度。

了解这些超参数是提高AI算法性能的基础。合理选择和调整超参数,可以显著提高模型的效率和预测准确性。

#### 2.3 超参数优化方法论

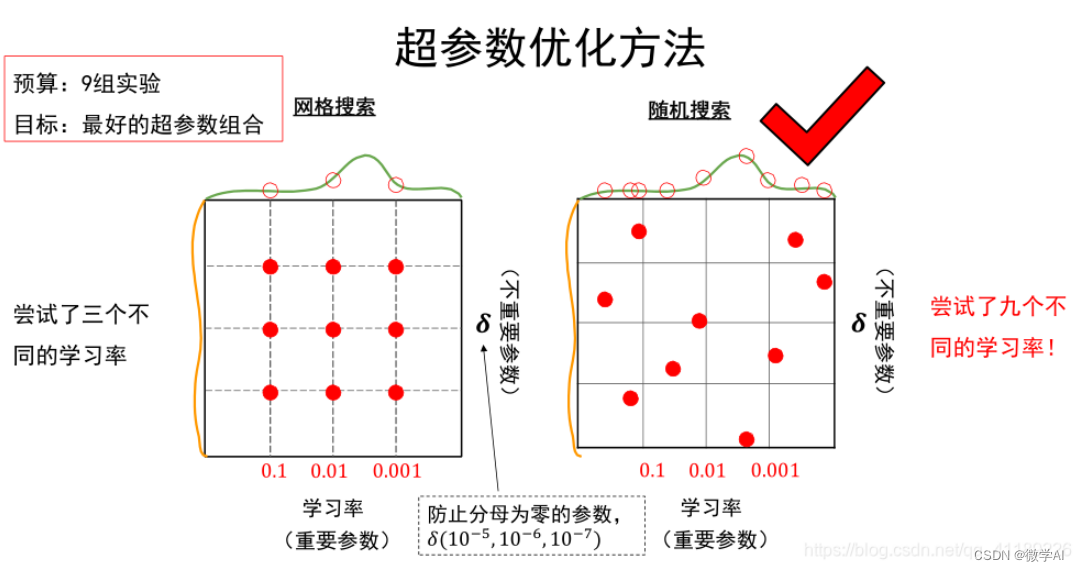

##### 2.3.1 网格搜索与随机搜索

- **网格搜索(Grid Search)**:它尝试在超参数的所有可能组合中进行搜索,是一种穷举式搜索方法。虽然网格搜索能够覆盖所有可能的超参数组合,但它效率低下,特别是在超参数空间很大的情况下。

- **随机搜索(Random Search)**:与网格搜索不同,随机搜索在预定义的超参数空间中随机选择组合进行搜索。研究表明,随机搜索在效率和效果上往往优于网格搜索,特别是在面对高维超参数空间时。

##### 2.3.2 贝叶斯优化方法

贝叶斯优化是一种基于概率模型的优化方法,它构建了一个概率模型来表示目标函数,并基于此模型来选择下一步的搜索点。它通常比网格搜索和随机搜索更高效,因为它可以智能地在可能的最优区域集中搜索。

##### 2.3.3 基于进化算法的优化

进化算法通过模拟自然选择的过程来优化问题。这种方法将超参数的组合看作是种群中的个体,通过选择、交叉和变异来生成新的超参数组合。基于进化算法的优化通常适用于处理高维和复杂的超参数空间。

通过深入了解这些优化方法,研究人员可以更有效地对超参数进行调优,提升模型性能。然而,选择哪种优化方法取决于具体任务的需求、计算资源的可用性以及超参数空间的特性。

# 3. 实践技巧:超参数调优的工具与应用

## 3.1 超参数调优工具介绍

在这一部分,我们将深入研究用于超参数调优的主流工具,了解它们在实际操作中的应用。将重点探讨Scikit-learn、TensorFlow、Keras以及专业超参数优化库如Hyperopt和Optuna。

### 3.1.1 Scikit-learn中的超参数优化工具

Scikit-learn库提供了非常方便的工具来实现超参数优化。其中最著名的当属`GridSearchCV`和`RandomizedSearchCV`。

#### 示例代码块 - GridSearchCV的使用

```python

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 定义模型

rf = RandomForestClassifier()

# 设置搜索参数

param_grid = {

'n_estimators': [50, 100, 200],

'max_depth': [None, 5, 10, 20],

}

# 实例化GridSearchCV

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5)

# 执行搜索

grid_search.fit(X, y)

# 输出最佳参数

print("Best parameters found: ", grid_search.best_params_)

```

**代码逻辑解读**:该代码展示了如何使用`GridSearchCV`对随机森林分类器的两个超参数进行网格搜索。`cv=5`表示使用5折交叉验证。搜索结束后,通过`grid_search.best_params_`获取最佳参数组合。

### 3.1.2 TensorFlow与Keras的调优工具

TensorFlow及其高级API Keras,提供了高级的工具来处理超参数调优问题。通过`tf.keras.wrappers.scikit_learn`模块,可以将Keras模型与Scikit-learn的搜索工具结合起来。

#### 示例代码块 - 使用Keras与Scikit-learn进行超参数优化

```python

import tensorflow as tf

from tensorflow import keras

from sklearn.model_selection import RandomizedSearchCV

# 构建Keras模型

model = keras.Sequential([

keras.layers.Dense(64, activation='relu', input_shape=(100,)),

keras.layers.Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 将Keras模型包装为scikit-learn接口

keras_wrapped_model = tf.keras.wrappers.scikit_learn.KerasClassifier(build_fn=model.build, verbose=0)

# 设置超参数的可能值范围

param_dist = {

'epochs': [10, 20, 30],

'batch_size': [32, 64, 128]

}

# 实例化RandomizedSearchCV

random_search = RandomizedSearchCV(keras_wrapped_model, param_distributions=param_dist, n_iter=3, cv=3)

# 执行搜索

random_search.fit(X, y)

# 输出最佳参数

print("Best parameters found: ", random_search.best_params_)

```

**代码逻辑解读**:代码定义了一个简单的Keras模型,并用`RandomizedSearchCV`进行超参数优化。`n_iter=3`表示随机搜索将尝试3组超参数。最终输出了找到的最佳参数。

### 3.1.3 专业超参数优化库使用案例

在专业场景中,超参数优化库如Hyperopt或Optuna能够提供更高级的优化策略和更好的搜索效率。

#### 示例代码块 - Hyperopt优化随机森林参数

```python

from hyperopt import hp, fmin, tpe, Trials, STATUS_OK, space_eval

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import cross_val_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 定义目标函数

def objective(params):

rf = RandomForestClassifier(**params)

acc = cross_val_score(rf, X, y, cv=5, scoring='accuracy').mean()

return {'loss': -acc, 'status': STATUS_OK}

# 定义参数空间

space = {

'n_estimators': hp.choice('n_estimators', [50, 100, 200]),

'max_features': hp.choice('max_features', [None, 'auto', 'sqrt']),

}

# 运行优化

tr

```

0

0