边缘计算中的AI算法性能:关键考量与优化策略

发布时间: 2024-09-01 19:44:37 阅读量: 246 订阅数: 98

# 1. 边缘计算与AI算法概述

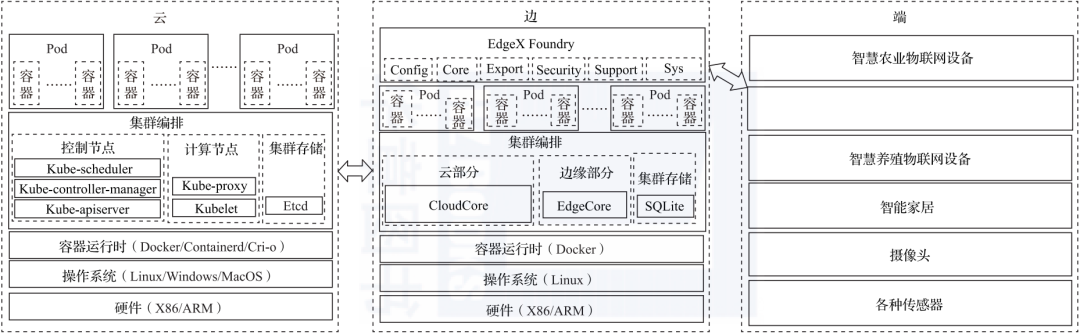

随着物联网设备的普及和网络技术的发展,边缘计算作为一项新兴技术正迅速崛起,它使得数据处理更接近数据源头,有效地缓解了中心云的压力,提升了响应速度。AI算法,尤其是机器学习和深度学习模型,在边缘计算环境中扮演着重要角色,它们能够帮助设备做出智能决策,实现数据的实时分析与处理。

边缘计算环境下的AI算法与传统的中心云AI算法有所不同。这些算法需要在资源受限的设备上运行,如传感器和IoT设备,它们往往具有较低的计算能力和存储空间。因此,如何设计轻量级且高效的AI模型成为了一个挑战。同时,由于数据隐私和安全性的需求,数据处理需要在本地完成,这也对AI算法提出了新的要求。

在接下来的章节中,我们将深入探讨边缘计算中AI算法的性能考量、优化策略、实践案例以及面临的未来挑战和展望,逐步揭开边缘AI的神秘面纱。

# 2. 边缘计算中AI算法的性能考量

边缘计算中AI算法的性能考量是一个多维度的问题,它不仅涉及到AI模型的效能,还包括了硬件资源的限制、网络环境的影响以及数据隐私与安全性等关键因素。在本章节中,我们将深入探讨这些方面,确保读者能够获得全面的了解和深入的洞见。

## 2.1 硬件资源限制与算法优化

### 2.1.1 边缘设备的硬件特征

边缘设备作为数据处理的第一线,其硬件配置往往面临着诸多限制。例如,与传统的数据中心相比,边缘设备通常拥有更低的计算能力、更少的内存空间和较慢的存储速度。这些限制对AI算法的设计与优化提出了更高的要求。

在设计AI算法时,首先需要明确边缘设备的硬件特征,包括CPU/GPU计算能力、可用内存大小以及网络接口的速度等。接下来,根据这些硬件特征,可以选择合适的数据类型和算法结构,以确保算法在有限资源下仍能高效运行。

### 2.1.2 AI算法在边缘设备上的资源消耗

AI算法在边缘设备上的资源消耗主要表现在计算资源、内存资源和存储资源三个方面。深度学习模型,尤其是大型神经网络,对计算资源的需求极高,而边缘设备由于其设计目的和应用场景限制,往往无法提供足够的计算资源来支持这些复杂模型的训练或推理过程。

内存资源消耗方面,复杂的AI模型需要大量的中间数据缓存,这对边缘设备有限的内存是一个严峻的挑战。此外,存储资源的限制可能影响到模型的持久化和数据的长期保存,因此必须权衡模型大小与性能之间的关系。

针对这些资源限制,算法开发者必须采取一系列的优化策略,如模型压缩、知识蒸馏等,来确保算法能在边缘设备上顺利运行。

## 2.2 网络环境对AI算法性能的影响

### 2.2.1 网络带宽与延迟

网络带宽和延迟对于边缘计算中的AI算法性能有直接影响。在边缘计算中,由于数据需要在网络中传输,带宽成为了限制数据传输速率的一个重要因素。特别是当AI算法需要实时处理数据时,网络延迟会直接影响算法的响应时间和效率。

优化措施包括在设计AI模型时考虑数据压缩,减少网络传输的数据量;同时,采用合适的通信协议和策略来确保网络传输的效率和可靠性。

### 2.2.2 数据传输与AI模型同步策略

在边缘计算环境中,AI模型常常需要在边缘设备和中心服务器之间进行同步,这意味着大量数据的传输。如何在保证数据同步的同时,避免造成网络拥塞和降低系统响应时间,成为了需要深入探讨的问题。

这里可以采用模型增量更新技术,只同步模型参数的增量而非整个模型,大大减少数据传输量。同时,还可以通过设计智能调度算法,根据网络状况动态调整数据同步策略,以达到最优的性能。

## 2.3 数据隐私与安全性考量

### 2.3.1 数据隐私保护技术

随着边缘计算的发展,数据隐私保护成为了不得不面对的一个重要问题。在AI算法中处理敏感数据时,需要采取一系列措施以保护个人隐私不被泄露。

一种常见的做法是数据匿名化,即在数据收集之前去除所有个人可识别信息。此外,差分隐私技术也在逐渐兴起,通过添加一定量的噪声来保护数据集中的个体信息不被泄露。在边缘设备上实现数据隐私保护技术,需要结合硬件和软件两方面的资源,以达到既保护隐私又不牺牲太多性能的目的。

### 2.3.2 安全性提升措施及其对AI算法的影响

安全性提升措施不仅保护了数据隐私,还确保了系统的整体安全。例如,在数据传输过程中采用端到端加密,可以有效防止数据在传输过程中被截取和篡改。

在AI算法中应用安全性措施,可能会增加额外的计算负担和延迟,对性能造成一定影响。因此,在设计AI算法时,需要在安全性和性能之间寻找平衡点。例如,可以对敏感数据进行加密存储,在需要处理时再进行解密,以减轻对实时处理性能的影响。

通过以上的分析和讨论,我们可以看到边缘计算中AI算法的性能考量是一个系统性的问题,它要求我们不仅要有深入的技术理解,还必须具备解决实际问题的综合能力。接下来的章节将探讨在这些限制和影响因素下,如何通过各种策略来优化AI算法的性能。

# 3. 边缘计算中的AI算法优化策略

## 3.1 轻量化AI模型设计

随着边缘计算设备的多样性和处理能力的提升,AI算法在边缘设备上的应用变得越来越重要。然而,边缘设备受限于计算资源和功耗等因素,对AI模型的设计提出了新的挑战。轻量化AI模型设计旨在减少模型的复杂度,同时保持模型的性能和准确性。

### 3.1.1 模型压缩技术

模型压缩技术是通过各种方法降低模型的参数量和计算复杂度,主要包括参数剪枝、量化和编码技术。在模型剪枝过程中,可以移除掉对最终输出影响较小的参数,降低模型的存储和运算需求。量化则将浮点数的参数转换为低精度的整数,减少了模型大小并加速计算过程。编码技术则是在保持模型性能的同时进一步压缩模型大小。

```python

import torch

import torch.nn.utils.prune as prune

# 定义一个简单的神经网络模型

class SimpleModel(torch.nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc = torch.nn.Linear(10, 10)

def forward(self, x):

x = self.fc(x)

return x

# 创建模型实例

model = SimpleModel()

# 应用剪枝技术,移除掉10%的权重

prune.l1_unstructured(model.fc, name='weight', amount=0.1)

# 打印当前模型的剪枝情况

for name, module in model.named_modules():

if isinstance(module, torch.nn.Linear):

print(f'Module: {name}, Sparsity: {100 * float(torch.sum(module.weight == 0)) / float(module.weight.nelement())}%')

```

### 3.1.2 知识蒸馏方法

知识蒸馏是一种训练小模型来模仿大模型行为的技术。它通过让小模型学习大模型的软标签(soft labels)来优化,而不是传统硬标签(hard labels)。软标签包含了大模型对于每个类别的概率分布,这有助于小模型捕捉大模型的细微差异,实现性能的保留。

```python

import torch.nn as nn

import torch.optim as optim

# 假设大模型和小模型都已经定义完成

large_model = ... # 已经训练好的大型模型

small_model = ... # 待训练的小型模型

# 定义蒸馏损失函数

def distillation_loss(student_logits, teacher_logits, labels, temperature=1.0):

soft_labels = nn.functional.softmax(teacher_logits / temperature, dim=1)

soft_loss = nn.functional.cross_entropy(student_logits / temperature, soft_labels)

hard_loss = nn.functional.cross_entropy(student_logits, labels)

return soft_loss * temperature + hard_loss

# 训练小模型时使用蒸馏损失

optimizer = optim.Adam(small_model.parameters())

for data, target in data_loader:

optimizer.zero_grad()

large_logits = large_model(data)

small_logits = small_model(data)

loss = distillation_loss(small_logits, large_logits, target)

loss.backward()

optimizer.step()

```

## 3.2 边缘计算框架与工具

为了使AI算法更好地适应边缘计算环境,需要选择合适边缘计算框架与工具。这些框架和工具为边缘设备上AI模型的训练、部署和运行提供了便利。

### 3.2.1 边缘计算框架选型

当前市面上存在多种边缘计算框架,包括但不限于TensorFlow Lite、PyTorch Mobile和ONNX Runtime。这些框架为不同的AI模型和硬件平台提供支持,并优化了模型的执行速度和资源消耗。

### 3.2.2 开发工具与环境优化

开发人员可以利用各种调试和分析工具来优化AI模型在边缘设备上的性能,如使用TensorBoard进行可视化监控、使用BERT可视化工具分析模型结构等。此外

0

0