内存管理在AI算法性能优化中的角色:提升效率的秘诀

发布时间: 2024-09-01 20:12:23 阅读量: 186 订阅数: 73

# 1. 内存管理的基础概念与重要性

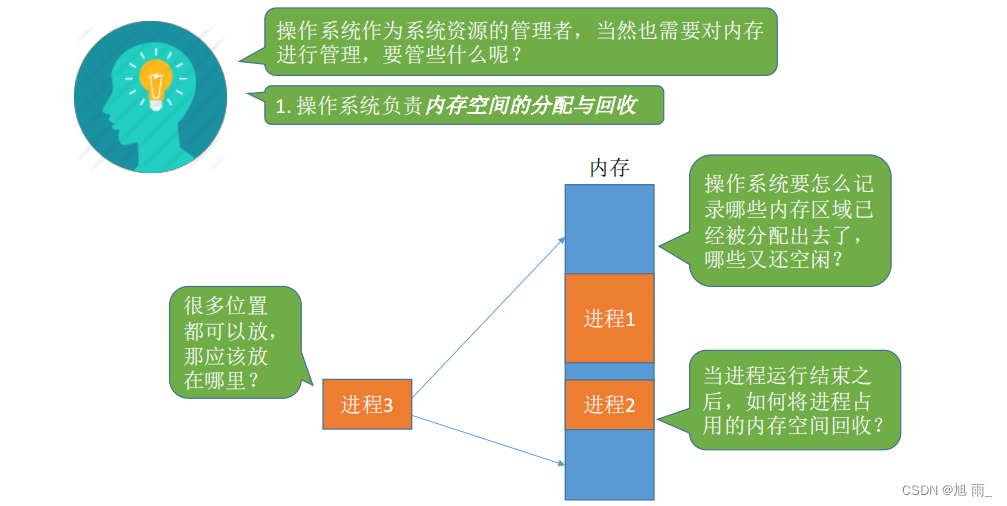

## 1.1 内存管理的定义

内存管理是操作系统中管理计算机内存的分配、回收以及访问控制的一组方法和协议。它确保了多个进程能够高效、安全地共享有限的内存资源。良好的内存管理不仅关系到程序的性能和稳定性,也直接关联到整个系统的运行效率。

## 1.2 内存管理的重要性

内存管理对现代计算机系统至关重要,原因如下:

- **资源隔离和保护**:通过内存管理,每个运行的程序或进程拥有自己的虚拟地址空间,防止相互干扰。

- **资源优化分配**:内存管理可以高效地利用有限的内存资源,通过算法优化内存的分配与回收。

- **防止内存泄漏**:一个良好的内存管理系统能够及时发现并处理内存泄漏问题,避免资源消耗殆尽导致程序崩溃。

## 1.3 内存管理与性能

内存管理的效率直接影响程序的执行速度和系统稳定性。例如,合理的内存分配策略可以减少内存碎片,提高缓存利用率,进而提升程序性能。此外,内存管理不当会导致频繁的页面置换、内存泄漏和死锁等问题,严重时甚至导致系统崩溃。

随着AI算法对计算和内存资源需求的日益增长,内存管理成为影响AI应用性能的重要因素。优化内存管理机制对于确保AI算法的高效运行至关重要。

# 2. 内存管理的理论基础

内存管理作为操作系统的核心功能之一,影响着计算机的性能和效率。理解内存管理的理论基础对于软件开发者和系统架构师来说至关重要。本章将从内存管理的硬件基础开始,逐渐过渡到软件机制,最后探讨内存管理与AI算法的关系。

## 2.1 内存管理的硬件基础

### 2.1.1 CPU缓存和内存层次结构

现代计算机系统中,CPU缓存扮演着至关重要的角色。缓存是一种高速存储设备,用于存放CPU频繁访问的数据,以减少处理器访问主内存的延迟。内存层次结构是缓存机制中的核心概念,它通常包括L1、L2和L3三级缓存,以及主存(RAM)。

- **L1缓存**:位于CPU内部,速度最快,但容量最小,通常用于存储最频繁访问的数据和指令。

- **L2缓存**:速度和容量均位于L1和L3之间,作用是减少L1缓存的缺页率,提高CPU的处理能力。

- **L3缓存**:容量较大,位于CPU内部或作为共享缓存在多核处理器之间,用于减少主存访问。

理解这些缓存层次对于开发高性能应用程序尤为重要,因为它们直接关系到数据访问速度和系统性能。

### 2.1.2 内存访问模式和缓存局部性

缓存局部性原则指导我们如何编写能够更好地利用缓存的代码。它主要包含两类:

- **时间局部性**:如果一个数据项被访问,那么在不久的将来它很可能再次被访问。

- **空间局部性**:如果一个数据项被访问,那么与它地址相近的数据项在未来不久很可能被访问。

以下是一个简单的代码片段,展示了利用时间局部性的例子:

```c

int sum = 0;

for (int i = 0; i < 1000; i++) {

sum += array[i];

}

```

在这个例子中,变量`sum`在每次循环迭代中都被重复使用,因此它的值被缓存在L1缓存中。如果数组`array`的元素也被缓存在L1或L2缓存中,那么对这些元素的访问就会非常快速。

## 2.2 内存管理的软件机制

### 2.2.1 分页和段式内存管理

内存管理软件机制的两个主要部分是分页和分段。这两种技术用于将物理内存分割成小块,并将这些小块分配给正在运行的程序。

- **分页**:将物理内存和虚拟内存都分割成固定大小的块,称为页。每个进程都有自己的页表,用于映射虚拟页到物理页。分页机制可以有效防止一个进程的错误操作影响到其他进程,从而提高内存的保护性和利用率。

- **分段**:将内存分为不同大小的段,每个段有一个基地址和长度。程序通过段名访问内存,操作系统负责段的管理和保护。分段可以更好地反映程序的数据结构,例如代码段、数据段等。

### 2.2.2 内存分配策略和算法

内存分配策略指的是操作系统如何决定分配内存的方式。常见的内存分配策略有:

- **首次适应**:在内存中查找第一个足够大的空闲区域分配给进程。

- **最佳适应**:在所有足够大的空闲区域中找到最小的一个分配给进程。

- **最差适应**:选择最大的空闲区域进行内存分配。

这些策略各有优缺点,首次适应和最佳适应较为简单,容易实现,但可能导致内存碎片化。最差适应试图最小化剩余空闲区的大小,但也可能增加未来分配的复杂度。

### 2.2.3 垃圾回收与内存泄漏检测

内存泄漏是内存管理中的一个重要问题,指的是程序未能释放不再使用的内存,导致内存逐渐耗尽。垃圾回收是解决内存泄漏的一种自动化机制,通常用于高级语言如Java、Python等。

- **垃圾回收**:程序运行时自动发现并回收不再使用的内存。

- **内存泄漏检测**:通过工具或特定代码逻辑发现程序中未能释放的内存。

例如,Python中使用`gc`模块来进行垃圾回收和检测内存泄漏。

```python

import gc

gc.set_debug(gc.DEBUG_LEAK)

# 创建一些对象

a = [i for i in range(10000)]

b = {'key': 'value'}

# 引导垃圾回收器

gc.collect()

# 输出被回收的对象信息

for obj in gc.garbage:

print(obj)

```

## 2.3 内存管理与AI算法的关系

### 2.3.1 内存访问模式在AI算法中的应用

在AI算法中,特别是深度学习领域,内存访问模式对算法性能有着显著的影响。例如,在卷积神经网络(CNN)中,由于卷积操作的权重共享特性,能够利用空间局部性原则,通过缓存来加速计算。优化内存访问模式,如通过数据预处理和内存映射技术,可以有效提升AI算法的性能。

### 2.3.2 内存管理对AI算法性能的影响

良好的内存管理能够确保AI算法高效运行,特别是在处理大规模数据集时。例如,使用内存池可以减少内存分配和回收的开销,使算法能够更好地利用GPU内存,从而提升性能。此外,避免内存泄漏,确保长期运行的AI服务稳定可靠,也是内存管理必须考虑的重要因素。

```c++

// 内存池示例代码片段

class MemoryPool {

public:

void* allocate(size_t size) {

// 从内存池中分配内存

}

void deallocate(void* ptr) {

// 将内存归还给内存池

}

private:

std::vector<char> buffer; // 内存池的缓冲区

};

```

在上面的代码片段中,`MemoryPool`类提供了一种简单的内存池实现,能够有效地管理内存分配,减少内存碎片,提升性能。

# 3. 内存管理在AI算法中的实践

## 3.1 内存优化技术在深度学习框架中的应用

深度学习框架如TensorFlow和PyTorch等为AI算法提供了丰富的内存管理工具和优化机制,但开发者往往需要深入理解这些机制,才能更好地利用它们进行内存优化。本节将探讨这些框架中内存优化技术的实际应用。

### 3.1.1 TensorFlow和PyTorch内存优化案例

TensorFlow和PyTorch是AI领域中广泛使用的两个深度学习框架,它们提供了许多内存优化的策略。以下是一些具体的案例:

**TensorFlow:**

- **计算图优化**:TensorFlow利用静态计算图来优化内存使用。通过图优化技术(如常数折叠、公共子表达式消除等),减少冗余计算和内存占用。

- **资源分配器(Resource Allocators)**:TensorFlow允许自定义资源分配器,例如使用特定内存池管理器来优化GPU内存使用。

**PyTorch:**

- **自动内存管理**:PyTorch使用Python的垃圾回收机制结合引用计数来管理内存。开发者可以使用`torch.no_grad()`和`.detach()`来避免不必要的内存占用。

- **量化和稀疏性**:PyTorch引入了量化和稀疏性支持,以减少模型大小和提高内存使用效率。

**代码示例:**

```python

import tensorflow as tf

from tensorflow.python.client import device_lib

# 检查可用设备

print(device_lib.list_local_devices())

# 使用GPU进行操作的示例

with tf.device('/gpu:0'):

a = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0], shape=[2, 3], name='a')

b = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0], shape=[3, 2], name='b')

c = tf.matmul(a, b)

# ... 执行操作 ...

# 使用PyTorch进行自动梯度计算的示例

import torch

# 定义操作

a = torch.randn(3, requires_grad=True)

b = torch.randn(3, 3)

c = torch.matmul(a, b)

# 反向传播

c.backward()

```

在上述代码中,TensorFlow通过`tf.device`来指定操作使用的硬件设备,而PyTorch的自动梯度计算帮助管理内存占用。这些框架提供的工具让内存优化更为方便。

### 3.1.2 动态内存分配和静态内存分配的权衡

动态内存分配和静态内存分配是内存管理中两种常见的分配策略。选择适合的策略对于AI算法的性能有着直接的影响。

**动态内存分配**:

- 允许在运行时分配和释放内存。

- 提高了灵活性,但也可能引入碎片化问题和运行时开销。

**静态内存分配**:

- 在程序启动时确定内存分配策略。

- 通常用于内存使用可预测的场景,可以降低碎片化和运行时开销。

深度学习框架通常混合使用这两种策略来平衡灵活性和性能。例如,在TensorFlow中,可以通过TensorFlow的Session机制来控制资源分配。

**代码示例:**

```python

import tensorflow as tf

# 创建一个变量,使用静态内存分配

weights = tf.Variable(tf.random.normal([784, 200]), name='weights')

bias = tf.Variable(tf.zeros([200]), name='bias')

# 创建一个占位符,动态分配内存给输入数据

input = tf.placeholder(tf.float32, shape=[None, 784], name='input')

# 线性计算的前向传播

output = tf.matmul(input, weights) + bias

```

在本示例中,`weights`和`bias`使用静态内存分配,它们在整个程序中都存在。而`input`则会根据传入的数据动态分配内存。适当选择动态和静态内存分配策略,有助于提高AI算法的效率。

通过本节的介绍,可以了解深度学习框架在内存优化方面的多种策略,以及如何在具体实践中根据框架的特点进行选择和应用。

## 3.2 内存管理与数据加载策略

在AI算法中,数据是核心的输入资源。如何高效地管理内存以加载和处理这些数据,是实现高性能AI算法的关键。

### 3.2.1 数据预处理和内存映射技术

数据预处理是机器学习和深度学习中不可或缺的一步。利用内存映射技术可以减少内存的直接使用,同时保持快速的数据访问速度。

**数据预处理:**

- 包括归一化、缩放、归一化等操作。

- 这些操作往往在内存中执行,需要

0

0