AI系统稳定性保障:性能监控与日志分析的黄金法则

发布时间: 2024-09-01 19:54:26 阅读量: 177 订阅数: 80

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. AI系统稳定性保障概述

## 1.1 AI系统稳定性的重要性

AI系统稳定性是确保服务连续性和效率的关键因素。在数据密集型和计算密集型的任务中,系统的稳定运行直接影响到业务成果和用户体验。一个不稳定的AI系统可能会导致数据丢失、服务质量下降,甚至商业损失。

## 1.2 稳定性保障的几个方面

保障AI系统的稳定性需要从多方面入手。首先,需要了解系统在不同负载和条件下的行为,以预测和避免潜在的瓶颈和故障。其次,系统的设计必须能够快速地恢复和自我修复,以适应硬件故障或软件缺陷。另外,优化监控流程和日志分析可以提早发现问题,并对故障进行预警。

## 1.3 AI系统稳定性面临的挑战

在实际操作中,AI系统稳定性面临诸多挑战。例如,随着模型复杂度和数据量的增加,确保实时决策的准确性变得更为困难。同时,系统需要适应多样化的用户需求,处理不规则的流量高峰和低谷。这些因素共同作用于系统,增加保持系统稳定性的难度。在接下来的章节中,我们将详细探讨如何通过性能监控和日志分析来应对这些挑战。

# 2. AI系统性能监控理论与实践

## 2.1 性能监控的理论基础

### 2.1.1 监控指标的选取与分析

AI系统的性能监控是一个多维度的过程,涵盖了从硬件资源的利用率到算法运行效率的各个方面。选择正确的监控指标对于性能分析至关重要。在实践中,以下是一些核心监控指标的例子:

- CPU使用率:CPU资源是计算能力的主要衡量标准,高CPU使用率可能表明模型计算繁重或效率低下。

- 内存消耗:AI系统运行时需要足够的内存来存储数据和中间变量。

- GPU利用率:尤其在深度学习中,GPU的使用状况直接关系到模型训练和推理的速度。

- 网络I/O:数据传输速度对分布式AI系统的性能有很大影响。

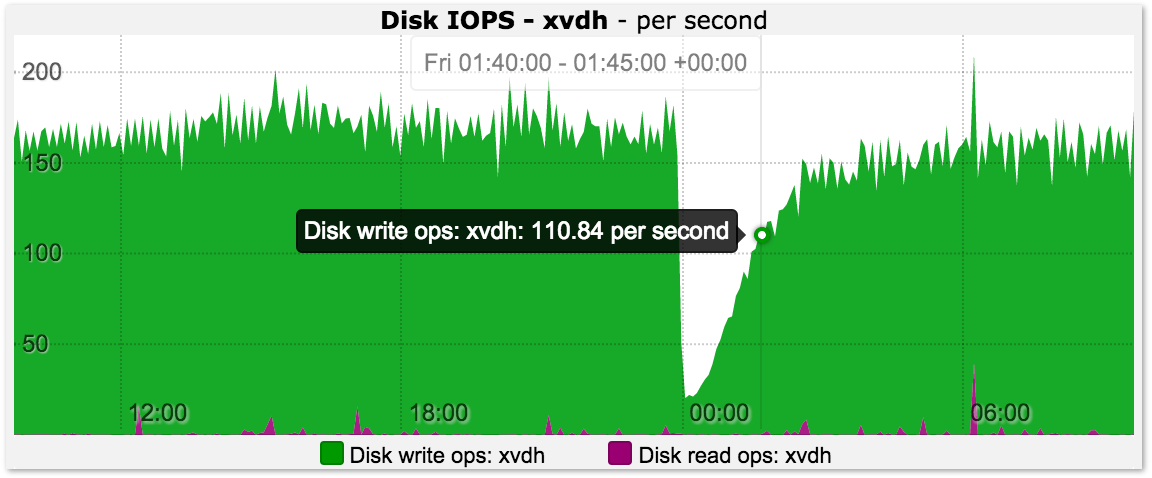

- 磁盘I/O:频繁的磁盘读写操作可能成为性能瓶颈。

监控指标的选取通常需要考虑以下几个方面:

- **系统特性**:不同的AI应用可能需要不同侧重点的监控指标。

- **性能目标**:需要根据性能优化的目标来确定监控指标。

- **资源限制**:实际环境中资源可能有限,监控指标需要围绕这些限制进行选取。

对选定的监控指标进行深入分析,可以帮助我们识别系统瓶颈和潜在的性能问题,为后续的系统优化提供依据。

### 2.1.2 监控工具的选择与配置

性能监控工具的选择需要考虑以下几个因素:

- **功能覆盖**:监控工具是否能覆盖所有需要监控的关键指标。

- **易用性**:工具是否易于配置和使用,是否提供友好的用户界面。

- **集成性**:工具是否能与现有的系统和工具链无缝集成。

- **扩展性**:监控系统是否可以随着业务规模的增长而扩展。

流行的AI系统监控工具有:

- Prometheus:一个开源的监控解决方案,它提供了时间序列数据的收集和查询功能。

- Grafana:一个开源的指标分析和可视化平台,常与Prometheus结合使用。

- ELK Stack(Elasticsearch, Logstash, Kibana):适合于日志数据的收集、存储和可视化。

在选择监控工具之后,需要进行一系列配置工作,包括但不限于:

- 设置监控目标和抓取频率。

- 配置告警规则,以及时响应性能问题。

- 设计和实现数据可视化,使得性能数据一目了然。

配置监控工具时,确保监控数据的准确性和实时性至关重要,同时要保持系统的低负载,避免监控本身对被监控系统产生负面影响。

## 2.2 实时性能监控技术

### 2.2.1 实时数据采集方法

实时数据采集是性能监控中不可或缺的一环。对于AI系统而言,实时采集数据意味着能够在毫秒级别获取系统的性能指标。这通常需要通过以下几种方法来实现:

- **系统调用**:在Linux等操作系统中,可以使用系统调用直接从内核获取性能数据。

- **API调用**:许多现代AI框架和库提供API来获取运行时信息。

- **代理和探针**:部署专用的监控代理或探针来收集实时性能数据。

这些方法各有优劣,系统调用和API调用一般对系统性能影响较小,但可能需要在应用层进行开发;代理和探针提供了更高的灵活性和可配置性,但可能会引入额外的资源开销。

下面的代码块是一个使用Python `psutil` 库从系统调用中采集CPU和内存使用率的简单示例:

```python

import psutil

def collect_metrics():

cpu_usage = psutil.cpu_percent(interval=1)

memory = psutil.virtual_memory()

return {

'cpu_usage': cpu_usage,

'memory_total': memory.total,

'memory_used': memory.used,

'memory_free': memory.free,

}

metrics = collect_metrics()

print(metrics)

```

该代码段从系统层面获取CPU和内存使用数据,`cpu_percent` 函数通过`interval=1`参数设置为1秒间隔内采集一次CPU使用率。

### 2.2.2 实时监控系统的架构设计

实时监控系统的架构设计需要解决几个关键问题:

- **高可用性**:监控系统需要具备高可用性,保证在任何情况下都能可靠地采集和处理数据。

- **扩展性**:随着AI系统的规模扩大,监控系统需要能够水平扩展以处理增长的数据量。

- **实时性与准确性**:在保证数据实时性的同时,还需要确保数据的准确性,避免因为数据采集或处理的延迟导致的误判。

一个实时监控系统的典型架构如图2.2所示:

```mermaid

graph LR

A[AI应用] -->|性能数据| B[数据采集代理]

B --> C[消息队列]

C --> D[数据处理引擎]

D --> E[存储系统]

E -->|查询接口| F[可视化界面]

```

图2.2 实时监控系统架构示意图

在这个架构中,数据采集代理负责实时采集性能数据,并发送到消息队列。消息队列作为缓冲,确保了数据的稳定传输。数据处理引擎负责接收消息队列中的数据,进行必要的处理和分析,然后将结果存储到数据库中。最终,用户可以通过可视化界面查询这些数据,并据此作出决策。

## 2.3 性能监控数据的可视化和告警

### 2.3.1 数据可视化技术的应用

数据可视化是将监控数据以图形化的方式展示出来,使得非技术背景的利益相关者也能理解系统的性能状况。应用数据可视化技术主要包括:

- **图表和图形**:折线图、柱状图、饼图、散点图等,用于展示性能趋势和比较。

- **仪表盘**:集成了多种图表的仪表盘,可以提供系统性能的实时概览。

- **热图和地图**:用于显示资源热点和分布情况,对于地理位置分散的系统特别有用。

数据可视化工具的选择应基于易用性、可定制性和集成能力。像Grafana这样的工具支持多种数据源和丰富的图表类型,能够创建动态的仪表盘。

图2.3展示了Grafana的一个仪表盘示例:

```mermaid

graph TB

subgraph Dashboard

cpu[CPU Usage]

mem[Memory Usage]

net[Network Usage]

end

```

图2.3 Grafana仪表盘示例

在上图中,我们可以看到一个包含CPU使用率、内存使用率和网络使用率图表的仪表盘。这样的设计使得监控数据一目了然。

### 2.3.2 告警机制的构建与优化

告警机制是性能监控中的一个重要部分,目的是在发生性能问题时能够及时通知到相关负责人。告警机制的构建通常包括以下几个步骤:

- **阈值设置**:设定合理的阈值,当监控指标超过这个阈值时触发告警。

- **告警渠道**:确定告警通知的渠道,如电子邮件、短信、企业通讯工具等。

- **告警策略**:对于不同级别的告警,采用不同的处理策略和优先级。

图2.4展示了告警机制的工作流程图:

```mermaid

graph LR

A[监控指标超出阈值] --> B{判断告警级

```

0

0