神经网络过拟合问题分析与解决策略,让模型更真实

发布时间: 2024-08-18 02:11:57 阅读量: 55 订阅数: 23

# 1. 神经网络过拟合问题的概述**

神经网络过拟合是指模型在训练数据集上表现良好,但在新的未见过的数据上表现不佳的现象。这会导致模型泛化能力差,无法有效处理实际问题。

过拟合产生的原因主要有:

* **模型复杂度过高:**模型参数过多,导致模型对训练数据拟合过度,无法捕捉数据的内在规律。

* **训练数据不足:**训练数据量太少,无法充分代表数据的真实分布,导致模型学习到的特征不全面,泛化能力差。

# 2. 过拟合问题的理论分析

### 2.1 过拟合产生的原因

过拟合问题产生的原因主要有以下几个方面:

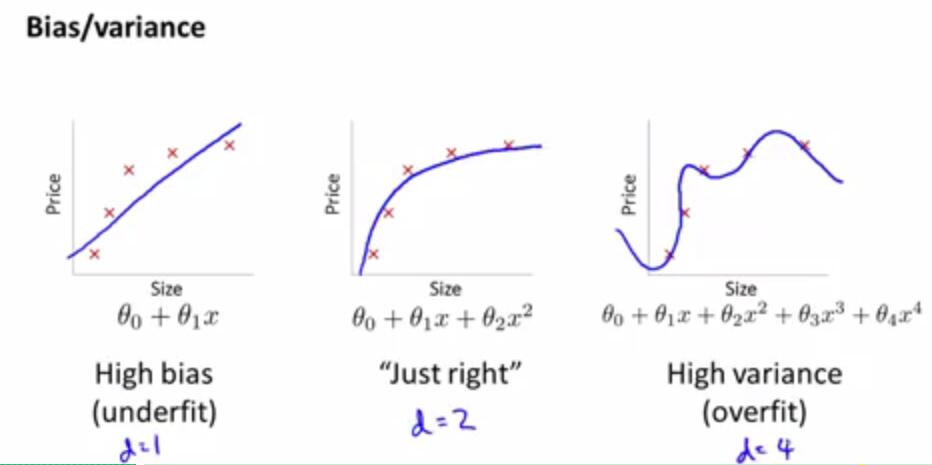

#### 2.1.1 模型复杂度过高

当神经网络模型过于复杂时,它可能能够很好地拟合训练数据中的噪声和异常值。这会导致模型在训练集上表现良好,但在新的、未见过的数据上表现不佳。

#### 2.1.2 训练数据不足

如果训练数据不足,神经网络模型可能无法充分学习数据的分布。这会导致模型在训练集上表现良好,但在新的、未见过的数据上表现不佳。

#### 2.1.3 数据分布不均匀

如果训练数据分布不均匀,神经网络模型可能无法学习数据的真实分布。这会导致模型在训练集上表现良好,但在新的、未见过的数据上表现不佳。

### 2.2 过拟合的评价指标

#### 2.2.1 训练集和测试集的误差对比

训练集和测试集的误差对比是评估过拟合的最简单方法之一。如果训练集的误差远小于测试集的误差,则可能存在过拟合问题。

#### 2.2.2 正则化项的引入

正则化项可以添加到神经网络模型的损失函数中,以防止模型过拟合。正则化项惩罚模型的复杂度,从而鼓励模型学习数据的真实分布。

### 2.3 过拟合的数学解释

#### 2.3.1 泛化误差和经验误差

泛化误差是指神经网络模型在新的、未见过的数据上的误差。经验误差是指神经网络模型在训练集上的误差。过拟合问题发生在泛化误差远大于经验误差时。

#### 2.3.2 奥卡姆剃刀原理

奥卡姆剃刀原理是一个哲学原则,它指出,在解释现象时,应该选择最简单的假设。在神经网络模型中,奥卡姆剃刀原理意味着应该选择最简单的模型,能够解释数据而不出现过拟合。

# 3. 过拟合问题的解决策略

### 3.1 数据增强

#### 3.1.1 数据扩充

数据扩充是一种通过对现有数据进行变换来生成新数据的方法。常见的变换包括:

- **翻转:**水平或垂直翻转图像。

- **旋转:**以一定角度旋转图像。

- **裁剪:**从图像中随机裁剪出不同大小和形状的区域。

- **缩放:**将图像缩小或放大。

```python

import cv2

# 读取图像

image = cv2.imread("image.jpg")

# 水平翻转

flipped_image = cv2.flip(image, 1)

# 旋转 45 度

rotated_image = cv2.rotate(image, cv2.ROTATE_90_CLOCKWISE)

# 裁剪

cropped_image = image[100:200, 100:200]

# 缩放

scaled_image = cv2.resize(image, (200, 200))

```

#### 3.1.2 数据合成

数据合成是一种生成完全新数据的技术。常见的合成方法包括:

- **生成对抗网络 (GAN):**生成与真实数据类似的新数据。

- **变分自编码器 (VAE):**从潜在分布中生成新数据。

- **合成少数类样本:**对于不平衡数据集,生成少数类样本以平衡数据分布。

```python

import tensorflow as tf

# 使用 GAN 生成图像

generator = tf.keras.models.loa

```

0

0