【类别变量编码进阶】:深度学习中嵌入式编码(Embeddings)的应用

发布时间: 2024-11-20 05:36:17 阅读量: 5 订阅数: 7

# 1. 深度学习中嵌入式编码基础

## 1.1 嵌入式编码概念引入

嵌入式编码(Embedding Encoding)是深度学习领域的一种技术,用于将高维空间的复杂数据转换为低维空间的连续向量表示。这种编码能够揭示数据内部的结构和特征,广泛应用于自然语言处理(NLP)、图像识别等多个领域。理解嵌入式编码的基础,对于深入探索深度学习至关重要。

## 1.2 嵌入式编码的种类与作用

在深度学习中,主要有三种类型的嵌入式编码:词嵌入、图像嵌入和行为嵌入。词嵌入用于处理自然语言中的单词或短语,图像嵌入用于图像识别任务,而行为嵌入则常用于推荐系统中。通过学习这些低维向量,模型可以捕捉到数据的本质特征,从而提高各类任务的性能。

## 1.3 嵌入式编码技术的挑战与发展

尽管嵌入式编码带来了诸多优势,但同时也面临诸如维度灾难、数据稀疏性以及计算资源要求高的挑战。未来的研究和实践将集中在优化算法效率、提升模型泛化能力以及探索与多模态数据融合的可能性。

```mermaid

graph LR

A[深度学习] -->|数据表示| B(嵌入式编码)

B --> C[词嵌入]

B --> D[图像嵌入]

B --> E[行为嵌入]

```

在下文中,我们将详细探讨嵌入式编码的数学原理、编码技术及其在深度学习中的应用,同时分析优化方法和未来可能的发展趋势。

# 2. 理论基础与编码技术

## 2.1 嵌入式编码的数学原理

### 2.1.1 线性代数在嵌入式编码中的应用

在深度学习的背景下,线性代数是构建和理解嵌入式编码的基础数学工具。矩阵运算、向量空间、特征值和特征向量等概念在嵌入式编码中发挥着关键作用。它们不仅帮助我们构建高效的数据表示,还用于神经网络中权重矩阵的初始化、更新和操作。

#### 矩阵运算在嵌入式编码的应用

矩阵乘法是嵌入式编码中最为常见的运算之一,它能够捕捉变量之间的线性关系。例如,在语言模型中,一个词嵌入可以看作是一个矩阵,它将一个词映射到一个向量空间中的点。当我们进行词嵌入的矩阵运算时,实际上是在处理一种从词到向量的转换过程。

```python

# Python 代码演示矩阵乘法

import numpy as np

# 假设有两个矩阵A和B

A = np.array([[1, 2], [3, 4]])

B = np.array([[5, 6], [7, 8]])

# 计算矩阵乘法

result = np.dot(A, B)

print(result)

```

在上述代码中,我们使用NumPy库来执行矩阵乘法操作。矩阵乘法的结果`result`是`A`和`B`的点积,这是构建嵌入式编码矩阵操作的基础。

### 2.1.2 降维技术与嵌入式编码的关系

降维技术在嵌入式编码中非常关键,特别是在处理高维数据时。通过降维,我们可以压缩信息,去除冗余,从而使得模型更加简洁并减少计算开销。降维技术的一个经典例子是主成分分析(PCA),它可以将数据投影到一个较低维度的空间中,这个空间保留了数据最重要的特征。

#### PCA降维在嵌入式编码中的实践

通过PCA降维,我们能够将高维数据投影到少数几个主成分上,这在嵌入式编码中能够帮助我们发现数据的重要结构。例如,在处理图像数据时,通过PCA降维,我们可以去除冗余的像素信息,只保留最重要的特征,这对于数据存储和处理速度都有极大的优化。

```python

# Python 代码演示使用PCA进行降维

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X = iris.data

# 初始化PCA对象,设定降维目标为2维

pca = PCA(n_components=2)

# 执行PCA降维

X_r = pca.fit_transform(X)

# 打印降维后的数据

print(X_r)

```

在该代码示例中,我们使用了scikit-learn库中的PCA类来将Iris数据集从原始维度降到2维。这不仅简化了数据,还可能帮助我们更直观地可视化数据的分布。

## 2.2 嵌入式编码技术概述

### 2.2.1 词嵌入与语义空间

词嵌入是自然语言处理领域的一种技术,它通过将词语转换为向量的方式,在一个连续向量空间中捕捉词语之间的语义关系。在这个向量空间中,语义上相似的词会被映射到距离相近的点上。

#### 词嵌入的实现与应用

词嵌入技术如Word2Vec、GloVe等已被广泛应用于文本分类、情感分析等NLP任务中。通过词嵌入,模型能够理解和处理语言的复杂性,甚至捕捉到词义的微妙差别。

```python

# Python 代码演示使用GloVe进行词嵌入

from glove import GloVe

# 加载预训练的GloVe模型

glove = GloVe(name='6B', dim=100)

# 获取某个词的词向量

word_vector = glove.word_vector('king')

# 打印词向量

print(word_vector)

```

上述代码展示了如何使用GloVe模型获取单词"king"的词向量表示。这种表示方法能够捕捉到"king"一词的语义信息,并与其他相关的词(如"queen", "monarch"等)在语义空间中保持相似性。

### 2.2.2 嵌入式编码在深度学习中的角色

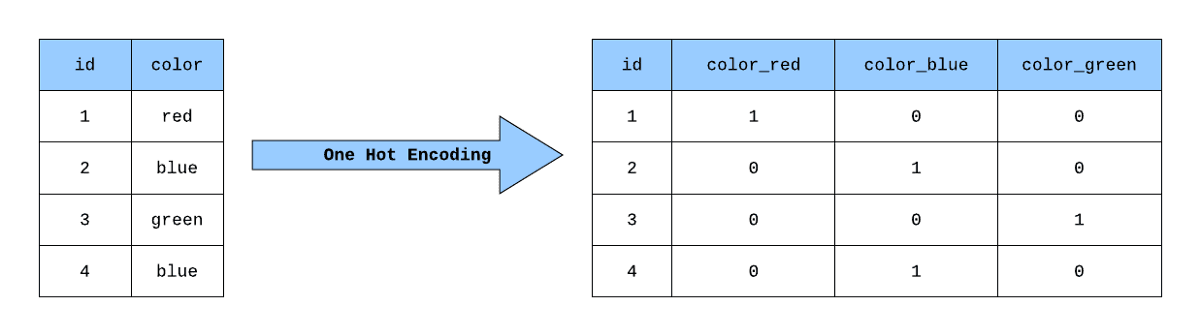

在深度学习中,嵌入式编码提供了一种强大的机制来表示数据。它可以将类别型、有序型或无序型的数据转换为连续的数值型表示,从而使得深度神经网络能够处理和学习这些数据的复杂模式。

#### 嵌入式编码在深度学习中的实现

在深度学习模型中,嵌入层(Embedding layer)通常用来处理类别型数据,如文本中的单词或图像中的对象类别。嵌入层将这些类别编码为连续的、密集的向量,并且模型可以通过学习这些向量来捕获输入数据的内在模式。

```python

# Python 代码演示在神经网络中使用Embedding层

from keras.models import Sequential

from keras.layers import Embedding, Flatten, Dense

# 定义模型结构

model = Sequential()

model.add(Embedding(input_dim=1000, output_dim=64, input_length=10))

model.add(Flatten())

model.add(Dense(10, activation='softmax'))

# 打印模型概要

model.summary()

```

在该代码片段中,我们构建了一个简单的神经网络,其中包含一个Embedding层,用于将输入数据的类别型索引转换为64维的密集向量。Flatten层和Dense层则用于进一步处理这些向量,实现分类任务。这种结构广泛应用于自然语言处理和计算机视觉任务中。

## 2.3 实现嵌入式编码的算法

### 2.3.1 神经网络中的嵌入式层

在深度学习模型中,嵌入式层是一个特殊的神经网络层,它负责将离散的类别型特征转换为连续的向量表示。这个过程通常通过学习得到,而不是手动设计的,这样可以更好地捕捉数据之间的复杂关系。

#### 嵌入式层的训练过程

嵌入式层的训练过程涉及到调整嵌入向量以最小化模型的损失函数。这一过程通常是在模型训练的反向传播过程中完成的。训练数据的每一个类别型特征都会被转换为一个向量,这个向量随着模型的训练逐步调整,以便更好地反映输入数据的语义信息。

```python

# Python 代码演示嵌入式层的训练过程

import numpy as np

from keras.layers import Input, Embedding, Flatten

from keras.models import Model

# 假设我们有一个简单的网络结构

input_layer = Input(shape=(None,))

embedding_layer = Embedding(input_dim=100, output_dim=32)(input_layer)

flattened_layer = Flatten()(embedding_layer)

# 假设我们有一个损失函数和优化器

loss_function = 'categorical_crossentropy'

optimizer = 'adam'

# 构建模型并编译

model = Model(inputs=input_layer, outputs=flattened_layer)

model.compile(loss=loss_function, optimizer=optimizer)

# 假设有一些训练数据

x_train = np.random.randint(100,

```

0

0