【数据预处理的最佳实践】:类别变量编码前的数据清洗步骤

发布时间: 2024-11-20 05:56:55 阅读量: 4 订阅数: 6

# 1. 数据预处理概述

在当今的数据驱动时代,数据预处理是机器学习与数据分析的基石。数据预处理不仅涉及数据清洗,还包括数据变换、数据归约等步骤,它确保了从原始数据到分析结果的每一步都建立在坚实的基础之上。

## 数据预处理的必要性

数据预处理是保障后续分析准确性的重要环节。原始数据通常包含噪声、异常值、不一致性等问题,这些问题如果不加以处理,将直接影响分析结果的有效性和准确性。

## 数据预处理的目标

预处理的目标是将原始数据转化为适用于分析的形式。这一过程可能包括去除无关或冗余的特征,处理缺失值,以及纠正数据中的错误等。正确的预处理可以为数据科学家提供更为清晰、准确的数据视图,为模型训练提供更优质的输入。

# 2. 数据清洗的基础

## 2.1 数据清洗的目的和重要性

### 2.1.1 理解数据清洗的概念

数据清洗是数据预处理的一个关键步骤,其目的在于移除数据集中的噪声和不一致的数据,提高数据的准确性和一致性。在数据分析和机器学习的背景下,良好的数据清洗可以显著改善模型的性能,因为模型的准确性在很大程度上依赖于输入数据的质量。

数据清洗包含但不限于以下几个方面:

- **识别和处理缺失值**:数据集中常见的问题,它们可能影响统计分析和机器学习模型的训练。

- **检测和处理异常值**:这些值可能是由于错误或异常情况产生的,对模型的预测能力有负面影响。

- **纠正不一致性**:确保数据在各个系统或文件中表示一致,这对于数据分析和报告至关重要。

### 2.1.2 数据清洗对于数据质量的影响

数据清洗对数据质量的影响是深远的。高质量的数据可以:

- 提高分析的可信度。

- 增强预测模型的准确性和可靠性。

- 为决策提供坚实的数据支持。

- 降低维护数据系统的成本。

- 减少错误决策的风险。

## 2.2 数据清洗的常用方法

### 2.2.1 缺失值处理

缺失值是数据集中常见的问题,其处理方法包括:

- **删除**:简单直接,适用于缺失值不多的情况。

- **填充**:用特定的值或基于其他数据的统计信息(均值、中位数、众数等)填充。

- **预测模型**:利用其他变量建立预测模型来估算缺失值。

以下是一个使用Python填充缺失值的示例代码:

```python

import pandas as pd

import numpy as np

# 创建示例数据

data = pd.DataFrame({

'A': [1, 2, np.nan, 4],

'B': [5, np.nan, np.nan, 8],

'C': [9, 10, 11, 12]

})

# 使用均值填充缺失值

data_filled = data.fillna(data.mean())

print(data_filled)

```

在这段代码中,`fillna`函数用于填充DataFrame中的缺失值,我们选择使用列的均值作为填充值。

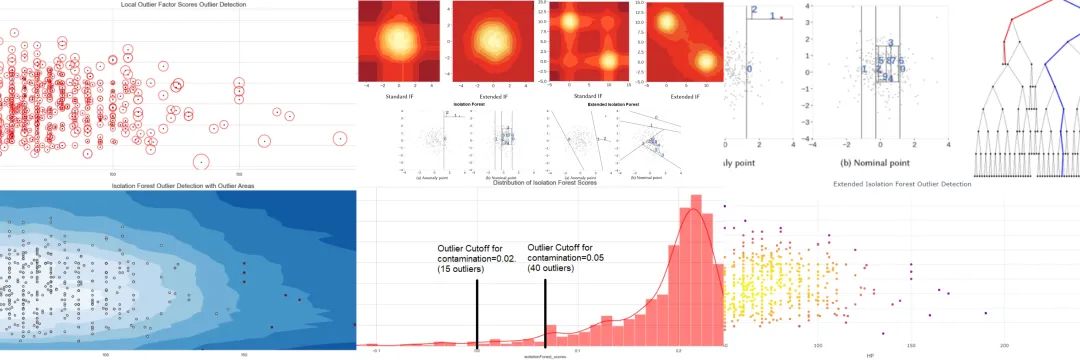

### 2.2.2 异常值检测与处理

异常值是指那些与数据集中其他数据明显不同的数据点。处理异常值的策略包括:

- **删除**:如果确定某个值确实是异常值,可以将其删除。

- **保留并注释**:有时候,异常值可能是非常有价值的数据点,应当保留并进行详细解释。

- **修改**:基于数据集的上下文,有时可能将异常值修改为合理值。

检测异常值的一种常用方法是使用箱形图的四分位数范围(IQR):

```python

Q1 = data.quantile(0.25)

Q3 = data.quantile(0.75)

IQR = Q3 - Q1

# 标记异常值

outliers = data[(data < (Q1 - 1.5 * IQR)) | (data > (Q3 + 1.5 * IQR))]

```

在这段代码中,`quantile`函数计算了数据集的四分位数,并进一步计算了四分位数范围(IQR)。任何低于Q1 - 1.5 * IQR或高于Q3 + 1.5 * IQR的数据点都被认为是异常值。

## 2.3 数据清洗的工具和技术

### 2.3.1 使用数据清洗工具

市场上存在许多数据清洗的工具,比如:

- Excel/Google Sheets

- OpenRefine

- Trifacta Wrangler

- DataWrangler

选择合适的工具取决于数据集的大小、复杂性和个人技术熟练度。

### 2.3.2 编程语言在数据清洗中的应用

Python和R是进行数据清洗的流行编程语言,因为它们有强大的库支持。在Python中,Pandas库是数据清洗的标准工具。

一个典型的Pandas数据清洗流程可能包括:

- 读取数据(`read_csv`, `read_excel`)

- 数据探索(`head`, `info`, `describe`)

- 数据处理(处理缺失值、转换数据类型等)

- 数据转换(排序、分组、透视等)

- 数据验证(确保数据的准确性和一致性)

Pandas为数据清洗提供了强大的语法糖(syntactic sugar),让数据科学家能够高效地处理数据集。

在本章节中,我们介绍了数据清洗的基础知识,包括数据清洗的目的和重要性、常用方法、工具和技术。在下一章节中,我们将深入探讨类别变量编码前的数据清洗实践。

# 3. 类别变量编码前的数据清洗实践

## 3.1 理解类别变量及其编码的必要性

### 3.1.1 类别变量的定义与特点

类别变量,也被称为定性变量,是数据集中常见的数据类型之一。与数值变量不同,类别变量取值通常代表一种分类或属性,如性别、职业或产品类型等。类别变量通常分为无序(名义变量)和有序(序数变量)两大类。无序类别变量的值之间没有大小、先后或优劣之分,而有序类别变量的值之间则有明确的排序关系。

类别变量的特点在于其值是离散的,并且不带有数学意义上的“大小”关系,即不能进行像数值变量那样的算术运算。这使得在数据处理和分析中,类别变量需要通过特定的方法转换为计算机可以理解的数值形式,以适应诸如机器学习等数据驱动的算法。

### 3.1.2 类别编码的目的与方法

类别编码是将类别变量转换为数值变量的过程,这是为了让计算机能够对这些数据进行有效的处理和分析。类别编码的目的主要有以下几点:

- **算法兼容性**:大多数机器学习算法需要数值型输入,类别变量需要编码后才能被算法接受。

- **数据分析**:在进行数据分析时,编码后的数值型数据更便于执行统计测

0

0