【深度学习数据预处理攻略】:数据清洗不再是问题

发布时间: 2024-09-03 09:41:11 阅读量: 102 订阅数: 56

# 1. 深度学习数据预处理概述

在当今数据驱动的深度学习研究和应用领域,高质量的数据预处理是确保模型准确性的关键。数据预处理包括了数据清洗、标准化、转换、增强等多个步骤,其目的是将原始数据转化为适合机器学习模型处理的形式。这一过程不仅关系到数据的质量,也直接影响到模型的训练效率和预测准确性。通过本章节,我们将对数据预处理的目的、重要性进行概述,并引入后续章节中将要详细探讨的理论与实践知识。

# 2. 理论基础与数据预处理的重要性

## 2.1 数据预处理的概念框架

### 2.1.1 数据预处理的目标和意义

数据预处理是深度学习中一个关键的步骤,其主要目标是将原始数据转化为适用于学习算法的格式,从而提高学习效率和模型性能。数据预处理的意义在于其能够减少数据中的噪声,修正错误,填充缺失值,统一数据格式,以及增加数据的丰富性。这些处理不仅提升了数据质量,而且为后续的数据分析、模型训练与评估奠定了坚实的基础。

在数据科学项目中,数据预处理通常占据整个工作流程的较大比例。根据相关统计,数据科学家大约需要花费60%-80%的时间在数据的清洗、整理和预处理上。这是因为,未经处理的数据往往存在着各种各样的问题,这些问题可能会对最终模型的准确性和可靠性产生负面影响。

### 2.1.2 数据预处理在深度学习中的角色

在深度学习领域,由于模型的复杂性和对数据质量的高要求,数据预处理的角色尤为突出。深度学习模型通常需要大量的训练数据,同时这些数据必须是高质量的。预处理步骤可以确保数据满足模型的需求,比如平衡数据分布、处理类别不平衡问题、提升数据的一致性等。

预处理不仅是数据科学和机器学习中的一个步骤,它还能够帮助研究者和工程师发现数据中的潜在规律,为特征工程和模型构建提供有价值的洞察。例如,通过对数据的初步分析,可以揭示数据中某些特征之间的关联性,这些关联性在预处理后将更加清晰,从而为模型的构建提供有力的支持。

## 2.2 数据预处理的类型与方法

### 2.2.1 数据清洗的基本步骤

数据清洗是预处理的一个核心组成部分,其基本步骤通常包括以下几个方面:

- **识别并处理缺失值**:缺失值是数据集中常见的一种问题,处理方法可以是删除含有缺失值的样本,或者用某些统计方法(如平均值、中位数或众数)进行填充。

- **纠正错误和不一致**:数据集中可能存在错误的数据项,需要根据上下文信息进行校正或删除。

- **处理异常值**:异常值可能是数据录入错误或其它非标准情况的结果,可以通过统计方法识别并适当处理。

- **标准化和归一化数据**:通过标准化或归一化处理,使得数据在一个统一的尺度上,便于后续的模型训练和比较。

- **合并和重构数据集**:可能需要从多个来源整合数据,并进行适当的重构以满足分析的需求。

### 2.2.2 数据标准化和归一化

数据标准化和归一化是数据预处理中常用的技术,它们的主要目的是消除不同特征间的量纲影响,使得模型能够更加公平地处理每一个特征。

- **标准化(Standardization)**:即Z-score标准化,它通过减去均值并除以标准差将数据转化为标准正态分布,使得其均值为0,标准差为1。公式如下:

```markdown

X_standardized = (X - X_mean) / X_std

```

其中,X是原始数据,X_mean是数据均值,X_std是数据的标准差。

- **归一化(Normalization)**:通常将数据缩放到一个固定范围,如[0, 1]。使用最小-最大标准化的方法,可以按如下方式进行计算:

```markdown

X_normalized = (X - X_min) / (X_max - X_min)

```

其中,X是原始数据,X_min和X_max分别是数据集中的最小值和最大值。

### 2.2.3 数据增强和转换技术

数据增强是通过对已有的训练样本进行转换,生成新的训练样本的方法。其主要目的是增加模型训练数据的多样性,提高模型泛化能力,尤其在图像、声音等模态数据中十分常见。

常见的图像数据增强技术包括旋转、缩放、裁剪、水平或垂直翻转等。在声音数据中,可采用速度变化、噪声添加等技术进行增强。对于文本数据,数据增强可以包括同义词替换、句子重排等方法。这些技术有助于模拟现实世界中的数据多样性,从而改善模型的表现。

## 2.3 面对挑战的应对策略

### 2.3.1 缺失数据的处理方法

处理缺失数据是数据清洗中一个常见的任务,以下是几种常用的处理方法:

- **删除含有缺失值的样本或特征**:当数据集较大,且缺失值数量较少时,可以考虑删除这部分数据。

- **填充缺失值**:可以使用均值、中位数、众数等统计方法填充缺失值,也可以使用模型预测的方法来填充。

### 2.3.2 异常值的检测与处理

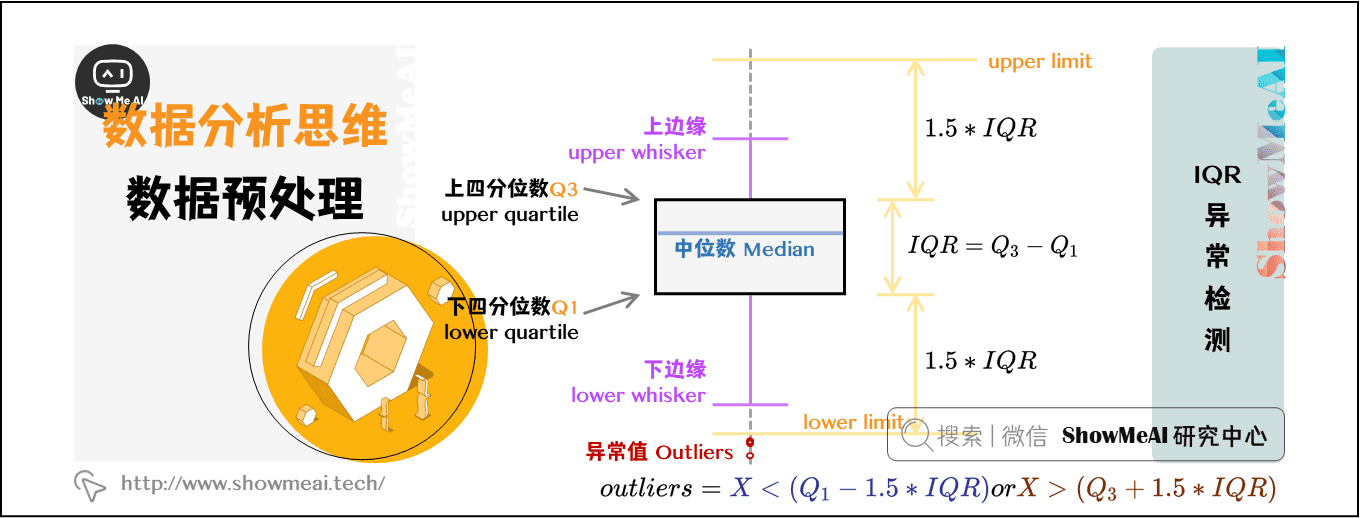

异常值通常指的是那些偏离整体数据分布的值。异常值检测的方法有很多,比较常见的有:

- **基于统计的方法**:例如使用标准差、IQR(四分位距)等来检测异常值。

- **基于聚类的方法**:异常值可能不属于任何数据簇,通过聚类分析可以帮助识别这些点。

处理异常值可以采取删除、修正或者使用特殊的处理方法,比如将异常值替换为中位数或众数等。

### 2.3.3 类别不平衡问题的解决策略

类别不平衡是指在分类问题中,不同类别的样本数量相差悬殊。这会导致模型对多数类具有更好的预测能力,而忽视少数类。解决策略可以包括:

- **重采样技术**:包括过采样少数类和欠采样多数类。过采样可以通过复制少数类样本来增加其数量,而欠采样则通过删除多数类样本来减少其数量。

- **合成少数类过采样技术(SMOTE)**:这是一种生成新的少数类样本的技术,通过在少数类样本间插值来生成新的样本。

| 策略 | 描述 | 优点 | 缺点 |

|-----------------------|-------------------------------------------------------------|-----------------------------------|--------------------------------------|

| 过采样 | 通过复制少数类样本来增加其数量。 | 模型不会丢失少数类信息。 | 可能会导致过拟合。 |

| 欠采样 | 通过删除多数类样本来减少其数量。 | 减少计算量,降低过拟合风险。 | 可能丢失重要信息。 |

| SMOTE | 通过在少数类样本人工合成新样本。 | 增加了数据多样性。 | 合成样本可能与实际数据有偏差。 |

| 代价敏感学习(Cost-sensitive Learning) | 对不同类别的错误分类设置不同的权重或代价。 | 更加关注少数类。 | 计算代价较高,参数调节复杂。 |

# 3. 数据清洗实践指南

在深度学习项目中,数据清洗占据了极其重要的位置。一个高质量的数据集能够显著提高模型训练的效率和预测的准确性。本章将深入探讨数据清洗的关键方面,从数据质量评估到应用实际的数据清洗技术,再到数据清洗工具和库的介绍。

## 3.1 数据质量的评估

### 3.1.1 数据集的基本统计分析

为了确保数据的质量,首先要进行的是基本的统计分析。这包括了解数据集中每个特征的分布、中心趋势(如均值、中位数)以及离散程度(如方差、标准差)。这些指标能够提供数据集总体质量的初步印象,并可能揭示某些特征潜在的数据问题。

以Python中的Pandas库为例,可以轻松地进行基本统计分析:

```python

import pandas as pd

# 假设df是包含数据集的DataFrame

basic_stats = df.describe()

print(basic_stats)

```

上述代码会输出每个数值特征的计数、均值、标准差、最小值、四分位数和最大值。这对初步评估数据集很有帮助。

### 3.1.2 识别数据集中的错误和不一致

数据集中可能包含错误的值或不一致的数据点。例如,年龄数据中可能出现负数,或者日期格式不一致,甚至有些数据点的属性值与其他数据点明显不同。使用可视化工具如直方图和箱线图,可以快速识别出数据中的异常点。

借助Seaborn库可视化数据分布情况:

```python

import seaborn as sns

import matplotlib.pyplot as plt

# 使用Seaborn绘制特征的直方图和箱线图

sns.histplot(df['age'], kde=True)

sns.boxplot(x=df['age'])

plt.show()

```

在箱线图中,异常值通常表现为远离主体部分的数据点。这些点需要进一步检查和处理。

## 3.2 实用的数据清洗技术

### 3.2.1 缺失值的插补技术

缺失值是数据集中的常见问题,可能由于数据录入错误或传感器故障等原因造成。处理缺失值的方法包括删除含有缺失值的记录、填充(如用均值、中位数或众数填充)或者使用更复杂的插补技术(如基于模型的插补)。

使用Pandas处理缺失值的一个例子:

```python

# 假设age列中存在缺失值,使用均值填充

df['age'].fillna(df['age'].mean(), inplace=True)

```

### 3.2.2 异常值的识别与清洗

异常值可能表示为数据点远离数据集的主

0

0