【深度学习循环神经网络对比】:RNN与LSTM的应用场景分析

发布时间: 2024-09-03 10:10:41 阅读量: 165 订阅数: 59

深度学习利用循环神经网络预测股价走势

# 1. 循环神经网络(RNN)基础理论

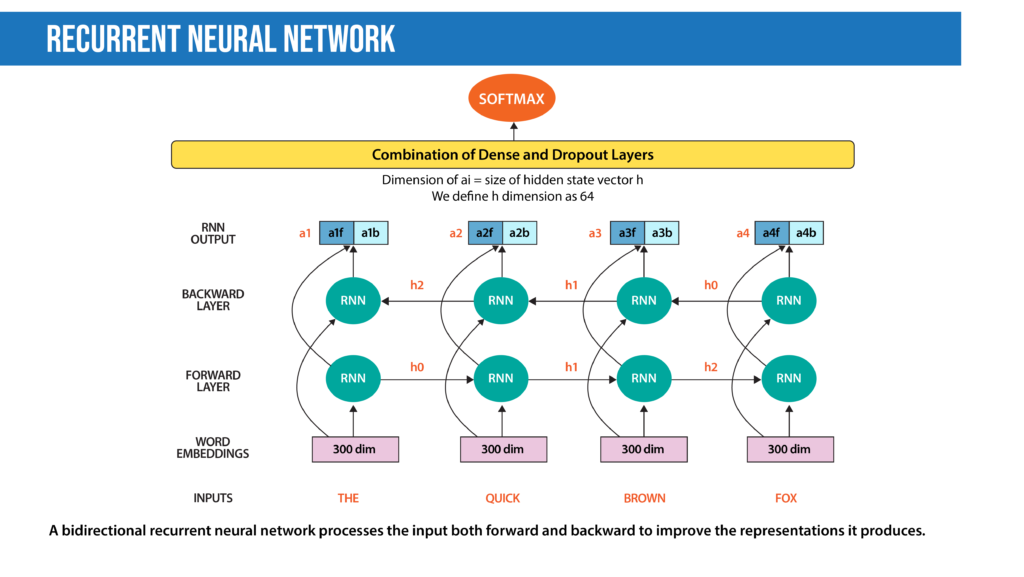

在探索人工智能与机器学习领域的深度与潜力时,循环神经网络(Recurrent Neural Network,RNN)占据了举足轻重的地位。RNN作为一种特殊的神经网络,特别适合处理序列数据,因其内部结构设计能够利用历史信息,对时序数据进行建模。与传统的前馈神经网络不同,RNN拥有自我循环的结构,能够存储之前的信息并影响后续的输出。这种能力使其在处理如语音识别、自然语言处理和时间序列分析等任务时显得尤为出色。然而,RNN也存在一些固有的问题,如长期依赖问题,这一挑战将引导我们过渡到其派生结构,即长短期记忆网络(Long Short-Term Memory,LSTM),这是下一章讨论的重点。

# 2. 长短期记忆网络(LSTM)的理论与优势

## 2.1 LSTM核心架构解析

长短期记忆网络(LSTM)是一种特殊的循环神经网络(RNN),其结构专门设计用来解决传统RNN在处理长期依赖问题时出现的梯度消失或梯度爆炸的问题。LSTM通过引入三个门结构(遗忘门、输入门和输出门)和一个内部状态来控制信息的流动,从而有效地保留长期依赖信息并避免不需要的信息干扰。

### 2.1.1 遗忘门、输入门和输出门

遗忘门负责决定从细胞状态中丢弃什么信息。它查看前一个隐藏状态和当前输入,并输出一个介于0到1之间的数字给每个数字,0代表完全忘记,1代表完全保留。

输入门负责决定更新细胞状态的什么值。首先,通过一个sigmoid函数决定哪些值将被更新,然后通过tanh函数创建一个新候选值向量,这个向量将会被添加到状态中。

输出门控制从隐藏状态输出的信息。首先,通过sigmoid函数决定需要输出的值,然后把隐藏状态通过tanh处理后,与sigmoid层输出的值相乘,得到最终的输出。

### 2.1.2 内部状态

LSTM的内部状态,或称为细胞状态,是其结构中的一个关键部分。这个状态像一条传送带一样贯穿整个单元,只有经过精心挑选的信息才能被修改。这种状态的存在使LSTM可以在序列中保留和传递信息,有时长达数百个时间步。

### 2.1.3 LSTM网络架构示例代码

以下是一个使用Keras库构建LSTM层的简单代码示例:

```python

from keras.models import Sequential

from keras.layers import LSTM, Dense

model = Sequential()

model.add(LSTM(50, activation='relu', input_shape=(timesteps, input_dim)))

model.add(Dense(1, activation='sigmoid'))

***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

```

在这个例子中,我们首先创建了一个序列模型,然后添加了一个LSTM层,该层有50个神经元并且使用了ReLU激活函数。输入数据的形状是`(timesteps, input_dim)`,这表明输入数据是时间序列数据。最后,我们添加了一个全连接层来输出预测结果。

## 2.2 LSTM相较于RNN的优势

LSTM网络相较于传统RNN的最大优势在于其能够捕捉长期依赖关系。RNN在处理长序列数据时,由于梯度消失和梯度爆炸问题,导致其难以捕捉长期依赖。LSTM通过门控机制有效地解决了这一问题。

### 2.2.1 长期依赖问题的解决

在RNN中,由于梯度在传播过程中呈指数级衰减或增长,导致模型很难学习到序列中相隔较远的数据点之间的关联。而LSTM通过门控单元可以将相关的信息保留下来,即使是在长序列中,它也可以将重要信息传递到未来的步骤。

### 2.2.2 门控机制的作用

LSTM的门控机制是通过遗忘门、输入门和输出门的组合来实现的。遗忘门决定了哪些信息应当从细胞状态中删除,输入门决定了哪些新信息应当被添加到细胞状态中,输出门决定了在每个时间步骤中应当输出什么样的信息。这样的设计让LSTM能够有效地控制信息流,避免了不必要的信息干扰,增强了网络的训练稳定性和效果。

### 2.2.3 实际效果和案例

在很多任务中,比如机器翻译、语音识别等,LSTM展现了比传统RNN更好的性能。在机器翻译任务中,LSTM能够更好地捕捉句子中的时态和语态等信息,从而提供更为流畅和准确的翻译。

### 2.2.4 LSTM与GRU的对比

LSTM的另一种变体是门控循环单元(GRU),它简化了LSTM的结构,通过两个门来控制信息流——更新门和重置门。GRU在某些情况下可以比LSTM更快地训练,但通常LSTM在捕捉长期依赖方面表现更佳。

## 2.3 LSTM与深度学习框架的结合

LSTM的成功也得益于现代深度学习框架的支持。框架如TensorFlow、PyTorch等提供了对LSTM的原生支持,并且还提供了高级API,简化了模型的构建、训练和部署过程。

### 2.3.1 在TensorFlow中的应用

在TensorFlow框架中,构建LSTM模型非常直接。开发者可以使用`tf.keras.layers.LSTM`来创建一个LSTM层,并通过高层API如`tf.keras.Sequential`来快速搭建整个网络。

```python

import tensorflow as tf

model = tf.keras.Sequential([

tf.keras.layers.LSTM(50, return_sequences=True, input_shape=(timesteps, input_dim)),

tf.keras.layers.LSTM(50, return_sequences=False),

tf.keras.layers.Dense(1, activation='sigmoid')

])

```

### 2.3.2 在PyTorch中的应用

PyTorch同样提供了`torch.nn.LSTM`层,可以像在TensorFlow中一样构建LSTM模型。此外,PyTorch对梯度计算和动态计算图有很好的支持,使得在LSTM网络训练中可以更加灵活地处理梯度相关的问题。

```

```

0

0