Scrapy分布式部署实战:多服务器协同工作的5大策略

发布时间: 2024-09-30 23:56:25 阅读量: 32 订阅数: 38

# 1. Scrapy分布式部署基础

在当今的数据驱动时代,网络爬虫作为获取互联网信息的重要工具,其效率和稳定性至关重要。Scrapy是一个快速、高层次的网页爬取和网页抓取框架,用Python编写,用于抓取网站数据并提取结构化的数据。当单机爬虫由于资源限制无法满足大规模数据抓取需求时,分布式部署成为了解决方案。在本章中,我们将介绍Scrapy分布式部署的基础知识,为接下来的深入探讨奠定基础。

首先,我们需要理解分布式爬虫的基本概念。分布式爬虫是一种爬虫架构,其中多个爬虫实例在多台机器上运行,协同完成大规模的数据抓取任务。这种架构能够充分利用网络资源,提高爬取效率,同时规避单机爬虫可能面临的IP封禁问题。

Scrapy的分布式部署依赖于Scrapy-Redis扩展,该扩展提供了Redis作为Scrapy的去重和调度中间件。通过Redis的支持,Scrapy能够实现多机器间的任务共享、去重和调度。这一特性是实现分布式爬虫的关键。接下来的章节将详细介绍如何在多服务器上协同工作,以及如何通过Scrapy-Redis快速部署高效且可扩展的爬虫环境。

# 2. 多服务器协同工作的核心原理

在当今的信息时代,数据的海洋浩瀚无垠,单一服务器的处理能力已经不能满足大规模数据爬取的需求。多服务器协同工作,或者说分布式爬虫技术,成为了大规模数据抓取和分析的首选技术方案。本章将深入探讨多服务器协同工作的核心原理,从分布式爬虫的概念和架构,到数据存储和分发策略,再到负载均衡与任务调度的机制,我们将一一展开分析。

## 2.1 分布式爬虫的概念和架构

### 2.1.1 分布式爬虫的定义和发展

分布式爬虫是一种使用多台服务器同时执行网页爬取任务的机制。它通过分解大规模爬取任务到多个子任务,并在多台机器上进行并行处理,从而提高数据获取的效率和速度。与传统的单机爬虫相比,分布式爬虫在数据吞吐量、抗封禁能力、可扩展性等方面具有明显优势。

分布式爬虫的架构设计需要考虑多个方面,包括但不限于数据的并发请求、资源的合理分配、任务的有效调度以及数据的一致性维护等。随着互联网技术的发展,分布式爬虫也在不断地演化,从最初简单的多线程或多进程爬取,发展到现在的基于云计算、大数据技术的分布式爬虫框架,如Scrapy-Redis、Splash等。

### 2.1.2 Scrapy框架架构概览

Scrapy是一个开源且应用广泛的Python框架,专门用于爬取网站数据和提取结构性数据。Scrapy的核心是它的数据流引擎,它负责控制数据在系统的流动和处理。Scrapy框架支持分布式部署,可以通过Scrapy-Redis等组件扩展为分布式爬虫。

Scrapy框架的主要组成部分包括:

- **Item**:定义了爬取到的数据类型。

- **Spider**:用于解析响应并产生Item的类。

- **Engine**:负责控制数据流在系统中的所有组件中流动,并在某些动作发生时触发事件。

- **Scheduler**:接收Engine发来的Request,按照一定的方式进行排序并调度执行。

- **Downloader**:负责下载由Scheduler发来的Request,并将下载的响应返回给Spider进行处理。

- **Downloader Middlewares**:位于引擎和下载器之间的中间件,在下载器进行下载前后提供额外的功能。

- **Spider Middlewares**:位于引擎和Spider之间的中间件,在Spider处理响应或Item前后提供额外的功能。

在分布式环境中,Scrapy的架构进一步拓展为由多台爬虫实例组成的集群,每台实例各自负责一部分任务,由统一的调度中心进行任务的分发和监控。

## 2.2 数据存储和分发策略

### 2.2.1 中间件的数据处理流程

在Scrapy分布式系统中,中间件扮演着极为重要的角色。它们位于引擎和下载器之间,负责处理发送出去的请求以及返回的响应。中间件的一个关键功能是进行请求和响应的拦截,以实现数据的预处理和后处理。

Scrapy中间件的主要流程如下:

1. 引擎将请求传递给调度器。

2. 调度器将请求传递给中间件。

3. 中间件处理请求(例如:添加或修改请求头)。

4. 中间件将请求传递给下载器。

5. 下载器下载响应。

6. 下载器将响应传递给中间件。

7. 中间件处理响应(例如:提取数据、写入到数据库等)。

8. 中间件将响应或数据传递给引擎,后者再传递给Spider。

### 2.2.2 数据存储方案对比

在分布式爬虫中,数据存储的方案选择直接影响整个系统的性能和可扩展性。常见的数据存储方案包括本地存储、分布式数据库、NoSQL数据库等。

**本地存储**通常是单机版爬虫采用的方式,但因其扩展性有限,在分布式系统中较少使用。

**分布式数据库**,如MySQL Cluster,提供高性能、高可用性,但其分布式特性和复杂性要求也较高。

**NoSQL数据库**如MongoDB、Redis等因其轻量级、水平扩展能力强、灵活的数据模型和高性能而受到青睐。它们特别适合存储爬虫收集到的半结构化或非结构化数据。

### 2.2.3 分布式存储技术选型

分布式存储技术的选择应该基于实际的数据规模、读写性能需求以及预算等因素。下面对比两种常见的NoSQL存储技术。

- **MongoDB**:一款高性能、开源的NoSQL数据库,支持大规模数据存储,适合存储结构化的数据。它提供了灵活的查询语言和索引支持,支持水平扩展,适合用于分布式爬虫的数据存储。

- **Redis**:一款内存中的数据结构存储系统,可以用作数据库、缓存和消息中间件。Redis支持多种数据类型如字符串、列表、集合、有序集合等,并支持持久化机制。由于其出色的读写性能,Redis通常用于处理高频的读写操作,比如分布式爬虫中的去重存储和队列管理。

## 2.3 负载均衡与任务调度

### 2.3.1 负载均衡的基本原理

负载均衡(Load Balancing)是分布式系统中的重要概念,其核心目的是合理分配请求到多台服务器上,从而避免单点压力过大导致的系统瓶颈,提高系统的可用性和扩展性。

负载均衡的基本原理包括以下几个方面:

- **流量分发**:根据算法将进入系统的请求平均分配到各个节点上。

- **节点管理**:实时监控节点状态,根据节点的健康情况动态调整流量分配策略。

- **容错机制**:提供故障转移功能,当某个节点发生故障时,能够迅速将流量转移到其他健康节点。

### 2.3.2 任务调度机制

任务调度是指在分布式爬虫中,如何高效地分配和管理爬取任务。任务调度机制的设计需要考虑任务的分配公平性、执行效率以及容错能力。

常见的任务调度算法包括:

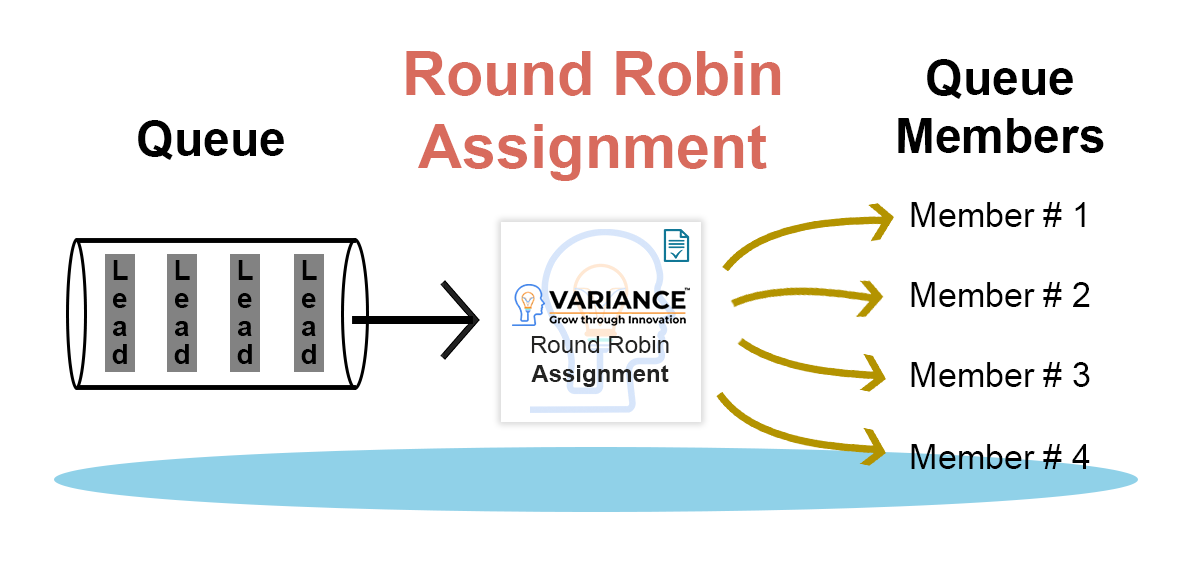

- **轮询(Round Robin)**:请求依次分配给各个服务器,是一种简单的负载均衡策略。

- **最小连接(Least Connections)**:选择当前连接数最少的服务器来处理请求。

- **随机(Random)**:随机选择一个服务器来处理请求。

- **加权(Weighted)**:根据服务器的权重来决定分配的请求数。

### 2.3.3 高可用性与故障转移策略

高可用性(High Availability, HA)是指系统能够持续提供服务的能力。分布式爬虫系统必须具备高可用性设计,以确保在出现故障时,系统能够继续提供服务而不间断。

在分布式爬虫系统中,高可用性设计通常包含以下内容:

- **主备架构**:拥有主服务器和一个或多个备用服务器,当主服务器发生故障

0

0