【Python数据处理加速秘籍】:集合操作的优化技巧大公开

发布时间: 2024-09-11 20:52:25 阅读量: 208 订阅数: 41

【java毕业设计】智慧社区在线教育平台(源代码+论文+PPT模板).zip

# 1. Python数据处理的基石:集合操作概述

在现代Python编程中,集合操作是处理数据不可或缺的一部分。它们是构建高效、准确的数据处理流程的基础。集合操作不仅仅局限于简单的列表或数组处理,它还涉及了更复杂的结构,如集合(set)和字典(dict),这些结构因其高效性在数据科学和分析中扮演着关键角色。

集合操作能够帮助我们快速实现数据的合并、交集、差集等基本操作,这些在处理大量数据时尤其有价值。Python通过内置的集合类型和相关操作,为开发者提供了一套强大的工具集来完成这些任务。此外,集合操作的不可变特性(如frozenset)以及字典推导式和集合推导式的出现,为代码的简洁性和执行效率带来了革新。

接下来的章节中,我们将深入探讨集合操作的理论基础,如何在内存和算法层面进行优化,并通过实际案例展示如何在处理大规模数据集时应用这些技巧。

# 2. 集合操作的理论基础与优化策略

## 2.1 集合操作的基本原理

集合操作是处理数据时不可或缺的一部分,它涉及到数据的比较、合并、过滤和变换等,是数据处理和分析的核心。在Python中,集合操作的基本原理基于其数据结构,主要包括列表(list)、元组(tuple)、字典(dict)和集合(set)。

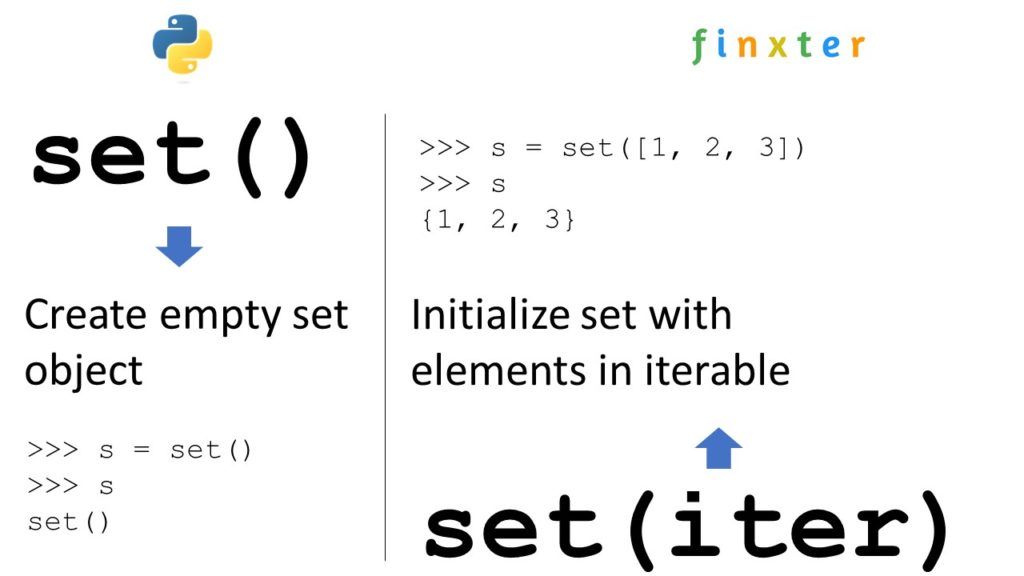

### 2.1.1 集合操作在Python中的实现

在Python中,集合操作主要依赖于内置的数据结构以及一些专门的模块。例如,列表和元组的交集、并集、差集等可以通过内置的集合操作函数实现。字典的集合操作通常涉及到键或值的集合处理,而集合类型(set)则专门为了集合操作而设计,提供了丰富的集合操作方法。

以下是一些Python中集合操作的例子:

```python

# 集合的并集操作

a = set([1, 2, 3])

b = set([3, 4, 5])

union_set = a.union(b) # 使用union方法或者 | 操作符

print(union_set) # 输出: {1, 2, 3, 4, 5}

# 集合的交集操作

intersection_set = a.intersection(b) # 使用intersection方法或者 & 操作符

print(intersection_set) # 输出: {3}

# 集合的差集操作

difference_set = a.difference(b) # 使用difference方法或者 - 操作符

print(difference_set) # 输出: {1, 2}

```

### 2.1.2 集合操作的时间复杂度分析

集合操作的时间复杂度主要取决于操作的种类以及数据结构的特性。在Python中,集合和字典是基于哈希表实现的,因此大部分的集合操作具有平均时间复杂度为O(1)的特性。而列表和元组则基于线性结构,其某些操作,如排序,可能需要O(n log n)的时间复杂度。

例如,进行两个集合的并集操作,可以使用`union`方法或者`|`操作符,其时间复杂度为O(min(len(a), len(b))),因为它涉及到一个集合中元素的哈希计算和另一个集合的遍历。

```python

# 时间复杂度分析示例

import timeit

# 使用union方法进行并集操作

time_union = timeit.timeit("a.union(b)", globals=globals(), number=10000)

print(f"Time using union method: {time_union}")

# 使用 | 操作符进行并集操作

time_operator = timeit.timeit("a | b", globals=globals(), number=10000)

print(f"Time using | operator: {time_operator}")

```

在这个例子中,我们可以看到`union`方法和`|`操作符在执行集合并集操作时的时间消耗。通常,它们之间的时间复杂度是相同的,但在某些情况下,具体的实现可能会导致微小的性能差异。

## 2.2 集合操作的内存效率优化

### 2.2.1 内存优化的基本概念

内存效率在处理大规模数据集时尤其重要。优化内存使用可以减少程序对硬件资源的需求,提高执行效率。Python通过其垃圾回收机制和引用计数系统来管理内存,但这并不意味着我们可以忽视内存优化。

### 2.2.2 避免不必要的数据复制

避免不必要的数据复制是内存优化的关键策略之一。在进行集合操作时,如果可能,应尽量避免创建数据的副本。在Python中,可以使用生成器表达式、切片操作等技术来处理数据,而不是将数据一次性全部加载到内存中。

例如,使用生成器表达式处理大规模数据集:

```python

# 生成器表达式示例

def read_large_data(file_name):

with open(file_name, 'r') as ***

***

* 读取文件中的每一行,但不一次性加载所有数据到内存

for line in read_large_data('large_dataset.txt'):

# 处理每一行数据

pass

```

通过使用生成器表达式,文件的每一行只有在被迭代处理时才会被加载到内存中,从而显著降低了内存使用。

## 2.3 集合操作的算法优化

### 2.3.1 分治法与合并排序

分治法是一种在计算机科学中广泛使用的算法设计范式。它通过将问题分解成更小的子问题,独立解决这些子问题,然后再合并这些子问题的解来解决整个问题。

在集合操作中,分治法可以用来实现高效的排序和查找算法。例如,Python内置的`sorted()`函数使用了一种高效的排序算法,它基于TimSort,这是一种结合了归并排序和插入排序的优化算法,特别适合于现实世界中数据的集合排序。

```python

# 分治法和合并排序的应用

large_list = [random.randint(0, 1000) for _ in range(10000)]

# 使用sorted函数进行排序,背后是分治法和合并排序

sorted_list = sorted(large_list)

```

### 2.3.2 哈希表与快速查找

哈希表是一种通过哈希函数将键映射到存储桶的表结构,它能够实现平均常数时间复杂度的快速查找。在Python中,集合和字典都是基于哈希表实现的。

例如,集合的查找操作:

```python

# 利用哈希表实现的快速查找

my_set = set([1, 2, 3, 4, 5])

# 快速检查元素是否存在于集合中

print(3 in my_set) # 输出: True

```

集合中的`in`操作符使用哈希表来快速确定一个元素是否存在,平均时间复杂度为O(1)。

通过理解和运用这些基础原理和优化策略,我们可以有效地执行集合操作,并在需要时对其进行优化。在下一章中,我们将深入探讨集合操作的高级应用实践,这将帮助我们更有效地处理现实世界的数据集。

# 3. 集合操作的高级应用实践

在处理复杂数据集时,高级应用实践变得至关重要。集合操作不仅能够简化代码,还能提升处理大数据的效率。本章将深入探讨如何使用Python进行集合操作的高效实践,并提出解决方案,以应对在数据处理过程中可能遇到的常见问题。

## 3.1 大数据集的高效处理技巧

在大数据环境下,内存和处理速度成为主要的瓶颈。本小节将介绍如何利用生成器和多线程来优化内存使用和提高处理速度。

### 3.1.1 使用生成器进行懒加载

生成器(Generators)是Python中一种特殊的迭代器,其核心优势在于懒加载(Lazy Evaluation),即按需产生数据,而不是一次性将所有数据加载到内存中。

```python

def read_large_file(file_name):

with open(file_name, 'r') as ***

***

***

***'big_data.log'):

process(line)

```

在这个示例中,`read_large_file` 函数以生成器的方式逐行读取大文件,这样可以有效控制内存使用,特别是在处理非常大的数据文件时。每次迭代只读取文件的下一行,而不把整个文件加载到内存中。

### 3.1.2 多线程与并行处理

Python的多线程由于全局解释器锁(GIL)的存在,并不能充分利用多核CPU的计算资源。但在IO密集型任务中,多线程能够显著提升效率,尤其是在涉及网络请求或磁盘读写时。

```python

import threading

def download(url):

# 伪代码,假设这个函数会下载数据并处理数据

pass

urls = ['url1', 'url2', 'url3']

threads = []

for url in urls:

thread = threading.Thread(target=download, args=(url,))

threads.append(thread)

thread.start()

for thread in threads:

thread.join()

```

上述代码使用了线程池来并行下载网络数据。每个线程可以独立运行,而主线程等待所有子线程完成后再继续执行。这种方法可以减少总下载时间,但需要注意线程数量的控制,以及避免线程同步问题。

## 3.2 集合操作中的常见问题及其解决方案

在集合操作过程中,一些常见的问题可能会导致数据处理效率低下。这里介绍如何识别和解决这些问题。

### 3.2.1 处理重复元素的问题

在集合操作中处理重复元素是常见问题之一。例如,合并两个列表时,可能需要去除重复的项以减少数据冗

0

0