【Python数据结构高级精讲】:揭秘高效数据管理的三大秘诀

发布时间: 2024-09-11 20:45:18 阅读量: 60 订阅数: 40

# 1. Python数据结构概述

Python作为一门高级编程语言,其内置的数据结构为开发者提供了极大的便利。理解这些数据结构的特性和适用场景是成为高效Python开发者的关键。本章首先概述Python中的基本数据结构,包括数字、字符串、列表、元组、字典和集合等。这些数据结构在存储数据和处理信息方面各有优势,例如,列表和字典支持动态变化,而元组和字符串则为不可变类型。掌握它们的使用,对于编写清晰、高效和可维护的代码至关重要。接下来的章节将深入探讨这些数据结构的特点、优势及在不同场景下的应用,以及如何通过它们实现数据处理的优化。

# 2. 高级数据类型深入解析

在上一章节我们概述了Python数据结构的基础知识,包括基本的变量和简单的数据类型如整型、浮点型和布尔型。本章将深入探讨Python中的高级数据类型,它们在实际编程中被频繁使用,并对代码的可读性和性能有着显著影响。我们将从不可变数据类型元组和字符串,到可变数据类型列表和字典,再到集合类型及其在数据去重中的应用,逐个详细解析。

### 2.1 不可变数据类型:元组和字符串

#### 2.1.1 元组的特性和应用场景

元组(Tuple)是Python中的一种不可变序列类型。一旦创建,元组中的元素不能被修改,这使得元组可以作为字典的键。由于不可变性,元组的创建和销毁比列表更快,且在多线程环境中是线程安全的。

元组常用于以下场景:

- 在函数中返回多个值。

- 作为字典的键,因为不可变对象是可哈希的。

- 存储异构数据,即不同数据类型的元素。

- 作为不可变的列表,用于保护数据不被修改。

元组的创建和访问非常直观,通过逗号分隔值即可创建。例如:

```python

a = (1, 2, 3, 'four', 'five')

```

若元组中只有一个元素,需要在值后加上逗号,以区分是元组还是简单的数值。

```python

single_element_tuple = (1,)

```

#### 2.1.2 字符串的内建方法和处理技巧

字符串(String)是Python中最常用的数据类型之一。字符串是不可变的,意味着创建后不能修改。字符串提供了许多内建方法来进行文本处理和字符串操作。

一些常见的字符串操作如下:

- `join()`: 将序列中的元素以指定的字符连接生成一个新的字符串。

- `split()`: 以指定的字符或字符串分割原字符串。

- `replace()`: 替换原字符串中的字符串片段。

- `strip()`: 移除字符串头尾指定的字符集或字符,默认为空格。

下面的例子演示了如何使用这些方法:

```python

# Join Method

sentence = ' '.join(['Hello', 'World']) # 'Hello World'

# Split Method

words = 'Hello World'.split() # ['Hello', 'World']

# Replace Method

new_sentence = sentence.replace('World', 'Python') # 'Hello Python'

# Strip Method

text = ' hello world '

clean_text = text.strip() # 'hello world'

```

在处理字符串时,应注意避免对大量数据进行重复的字符串操作,这样会显著影响性能。尽可能地使用列表推导式或生成器表达式来处理字符串的每个字符,最后再将它们合并。

### 2.2 可变数据类型:列表和字典

#### 2.2.1 列表的高级操作和内存管理

列表(List)是Python中最灵活、最常用的可变序列类型。列表允许元素的插入、删除和重新排序,支持重复元素,且可以包含不同类型的对象。

在内存管理方面,Python列表通过动态数组实现。当列表增长到现有空间无法容纳时,Python解释器会自动扩展列表的容量,通常会扩大两倍。这种机制简化了编程,但也引入了内存消耗。

列表提供了丰富的操作方法,以下是一些高级操作:

- `append()`: 在列表末尾添加一个新的元素。

- `extend()`: 使用另一个列表扩展原列表。

- `insert()`: 在指定位置插入元素。

- `pop()`: 移除并返回列表中的一个元素(默认末尾)。

- `remove()`: 移除列表中第一个值为x的元素。

- `index()`: 返回列表中第一个值为x元素的索引。

高级操作示例:

```python

fruits = ['apple', 'banana', 'cherry']

fruits.append('date')

fruits.extend(['elderberry', 'fig'])

fruits.insert(1, 'blueberry')

last_element = fruits.pop()

fruits.remove('apple')

element_position = fruits.index('banana')

```

#### 2.2.2 字典的数据结构优化和使用模式

字典(Dictionary)是一个无序的键值对集合,它提供了一种映射类型的数据结构。字典中的每个键必须是不可变类型,而值可以是任意类型。由于其快速键查找特性,字典在实际应用中非常有效。

字典提供了如下操作:

- `get()`: 返回字典中键对应的值,如果不存在则返回默认值。

- `keys()`, `values()`, `items()`: 返回字典中所有的键、值和键值对。

- `update()`: 更新字典中的键值对。

- `pop()`, `popitem()`: 移除并返回字典中的一个元素。

- `clear()`: 清空字典。

字典的性能优化方面,应当考虑:

- 避免在遍历字典时直接修改键。

- 避免使用可变类型作为字典的键。

- 字典推导式可以用来创建新字典,这通常比循环创建字典更高效。

```python

person = {'name': 'Alice', 'age': 25}

person['city'] = 'New York'

person.update({'name': 'Bob'})

age = person.get('age', 'Unknown') # 'Unknown' is the default value

keys = person.keys()

values = person.values()

items = person.items()

```

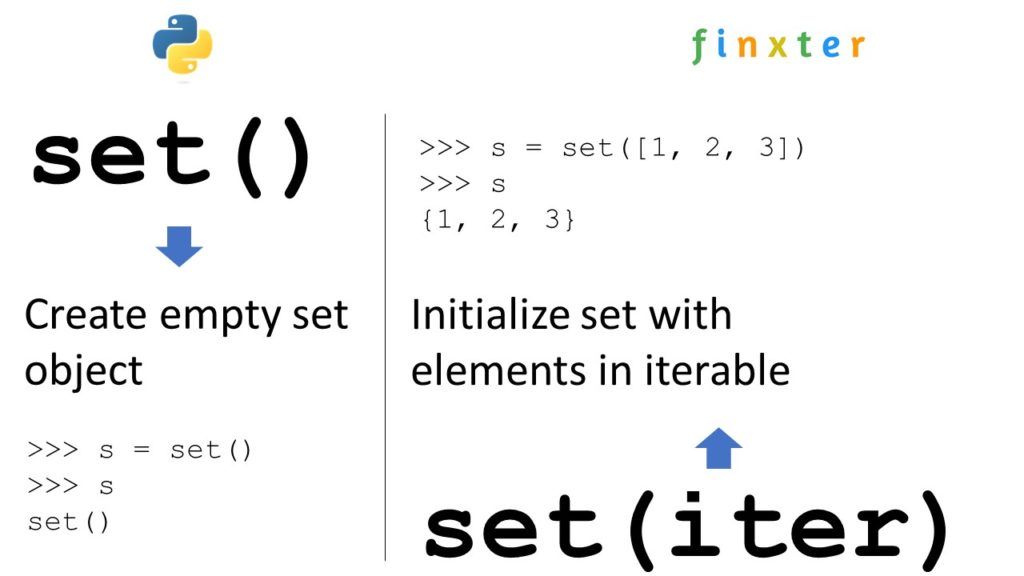

### 2.3 集合类型及其在数据去重中的应用

#### 2.3.1 集合的定义和操作

集合(Set)是一个无序的不重复元素序列。集合支持基本的数学集合运算,如并集、交集、差集等。它还提供了添加、删除和测试元素存在的操作。

集合的常见操作包括:

- `add()`: 添加一个元素到集合中。

- `update()`: 添加多个元素到集合中。

- `remove()`: 移除集合中的一个元素。

- `discard()`: 移除集合中的一个元素,如果元素不存在则不执行任何操作。

- `pop()`: 随机移除并返回集合中的一个元素。

使用示例:

```python

fruits = {'apple', 'banana', 'cherry'}

fruits.add('date')

fruits.update(['elderberry', 'fig'])

fruits.remove('apple')

fruits.discard('banana')

random_fruit = fruits.pop()

```

#### 2.3.2 集合在去重和关系运算中的妙用

集合是处理重复数据和进行关系运算的理想选择。其主要优势是元素唯一性,对于数据去重尤为有用。

集合在去重中的应用:

- 当需要从列表中删除重复项时,可以将列表转换成集合再转换回列表。

- 在集合运算中,两个集合的交集将自动去除重复项。

示例代码:

```python

# 去除列表中的重复元素

original_list = [1, 2, 2, 3, 3, 3]

unique_list = list(set(original_list))

# 求两个集合的交集

set1 = {1, 2, 3}

set2 = {2, 3, 4}

intersection = set1 & set2 # 结果为 {2, 3}

```

在本章节中,我们学习了不可变和可变的高级数据类型及其应用场景。通过示例和代码块,我们深入理解了元组、字符串、列表、字典以及集合的特性和操作方法。在接下来的章节中,我们将进一步探讨数据结构的组合与优化,以及它们在实际编程中的应用案例。

# 3. 数据结构的组合与优化

在现代编程实践中,仅仅了解单独的数据结构是远远不够的。为了构建高效、可维护的系统,必须掌握如何将这些结构组合起来,并在实际应用中进行优化。本章将深入探讨复合数据结构的设计、数据结构在算法中的应用,以及数据结构与性能优化之间的关系。

## 3.1 复合数据结构的设计

复合数据结构是由基本数据结构组合而成,能够更精确地模拟复杂问题。在Python中,我们可以利用类和对象来实现自定义的复合数据结构。

### 3.1.1 自定义对象与类的组合使用

Python是一种面向对象的编程语言,其类(class)是创建对象的蓝图。通过组合不同的类,我们可以创建复杂的数据结构。

```python

class Node:

def __init__(self, data):

self.data = data

self.next = None

class LinkedList:

def __init__(self):

self.head = None

def append(self, data):

new_node = Node(data)

if self.head is None:

self.head = new_node

return

last_node = self.head

while last_node.next:

last_node = last_node.next

last_node.next = new_node

```

这个例子中,`LinkedList` 类使用了 `Node` 类来存储数据,并通过链表的方式连接各个 `Node`。这种方法使数据的组织方式更加灵活,同时保持了数据的逻辑结构。

### 3.1.2 高效数据管理的容器选择与实践

Python提供了多种内置的容器类型,如列表(list)、字典(dict)、集合(set)等。每种容器类型都有其特定的用途和性能特点。在设计复合数据结构时,如何选择合适的容器非常关键。

```python

# 使用字典存储键值对

data_store = {'key1': 'value1', 'key2': 'value2'}

# 使用集合进行快速成员检查

unique_elements = set(['element1', 'element2', 'element3'])

```

在实际应用中,要根据数据的类型、操作的复杂度以及内存的使用等因素来决定使用哪种容器类型。

## 3.2 数据结构在算法中的应用

算法通常需要高效地操作数据结构。如何在算法设计中选择合适的数据结构,以及如何根据数据结构的特性优化算法,是提升算法性能的关键。

### 3.2.1 排序算法和数据结构的选择

不同的数据结构对于排序算法的适应性和效率有着不同的影响。例如,对于简单的数据集,插入排序(Insertion Sort)可能效率较高;而对于大规模数据集,快速排序(Quick Sort)或归并排序(Merge Sort)可能是更好的选择。

```python

# 使用Python内置的排序方法

my_list = [3, 1, 4, 1, 5, 9]

my_list.sort() # 对列表进行原地排序

```

列表的排序方法不仅简洁,而且利用了Python内部的优化,这表明了解算法与数据结构相互关系的重要性。

### 3.2.2 搜索算法中的数据结构优化

搜索算法的性能常常受到数据结构组织方式的影响。比如,在有序数据集中,二分查找(Binary Search)算法比线性搜索(Linear Search)更为高效。

```python

# 二分查找算法实现

def binary_search(arr, low, high, x):

while low <= high:

mid = (low + high) // 2

if arr[mid] == x:

return mid

elif arr[mid] < x:

low = mid + 1

else:

high = mid - 1

return -1

```

这个函数通过不断地将搜索区间减半来快速定位元素,展示了如何利用数据结构的特性来优化算法。

## 3.3 数据结构与性能优化

性能优化是开发过程中的一个永恒话题。深入理解数据结构的时间和空间复杂度是性能优化的关键。

### 3.3.1 时间和空间复杂度分析

时间复杂度表示算法运行时间随着输入数据规模增长的增长速度。空间复杂度则描述了算法执行过程中所需存储空间的增长速度。

```python

# 时间复杂度为O(n),空间复杂度为O(1)

def find_max(arr):

max_val = arr[0]

for num in arr:

if num > max_val:

max_val = num

return max_val

```

在这个查找数组中最大值的例子中,我们清晰地看到了时间复杂度与空间复杂度的考量。

### 3.3.2 数据结构在大数据处理中的应用

在处理大规模数据时,数据结构的选择尤为重要。例如,使用树结构(如红黑树)可以快速处理大量数据的插入和查找,而哈希表可以快速定位数据。

```python

# 使用字典(哈希表)来存储和快速检索数据

large_data_dict = {str(i): i for i in range(1000000)}

```

这个字典示例说明了如何使用Python的内置数据结构来处理大规模数据集,从而优化性能。

本章节介绍了如何设计复合数据结构、在算法中选择合适的数据结构,以及如何根据数据结构的特性进行性能优化。这些知识对于在复杂环境中构建高效系统至关重要。下一章将通过实践案例来进一步展示数据结构在真实世界中的应用。

# 4. Python数据结构实践案例分析

## 4.1 数据结构在Web开发中的应用

在Web开发中,数据结构不仅是实现功能的基础,也是优化性能的关键。本节将深入探讨如何在Web开发中应用不同的Python数据结构,以及这些结构如何帮助我们更高效地处理网络数据和提升用户体验。

### 4.1.1 缓存机制与字典的结合

缓存是Web应用中经常使用的一种技术,它通过将频繁访问的数据存储在内存中来减少对数据库的访问次数,从而加快数据的读取速度。Python字典是实现缓存机制的理想选择,因为它们提供了快速的键值对映射功能。

```python

cache = {}

def get_data(key):

if key in cache:

# 从缓存中获取数据

return cache[key]

else:

# 从数据库或文件中获取数据

data = retrieve_data_from_source(key)

# 将数据存入缓存

cache[key] = data

return data

```

在上述代码示例中,我们定义了一个`get_data`函数,它首先检查键`key`是否存在于缓存字典`cache`中。如果存在,直接从缓存中返回数据,否则从数据源检索数据,并将其存储在缓存中供后续使用。这样,频繁请求的数据不需要每次都进行数据库查询,可以大大减少数据库的负载并提升响应速度。

缓存策略也有多种,例如内存缓存、文件缓存和分布式缓存。在实现缓存时,还需要考虑缓存的淘汰策略,如最近最少使用(LRU)、先进先出(FIFO)等。

### 4.1.2 数据结构在网络数据处理中的角色

Web开发中另一个重要的数据结构应用是网络数据的处理。在处理HTTP请求和响应时,经常使用字典来存储请求参数和响应头。例如,Flask框架使用字典来管理请求和响应对象中的数据。

```python

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/user', methods=['GET'])

def get_user():

user_id = request.args.get('id')

# 假设get_user_data是一个根据用户ID获取用户信息的函数

user_data = get_user_data(user_id)

# 将用户数据序列化为JSON格式返回

return jsonify(user_data)

if __name__ == '__main__':

app.run(debug=True)

```

在这个例子中,`request.args`是一个字典,存储了URL查询参数。通过访问`request.args.get('id')`,我们可以获取名为`id`的查询参数值。使用字典处理此类数据非常适合,因为字典提供了快速查找和管理键值对的能力。

此外,在处理JSON数据时,Python的`json`模块可以帮助我们轻易地将JSON字符串转换为Python字典,反之亦然。

## 4.2 数据结构在数据分析中的作用

数据分析是数据科学领域中非常重要的一个环节。在这一部分,我们将探讨Python数据结构在数据清洗和高效数据存储检索中的应用。

### 4.2.1 数据结构在数据清洗中的应用

数据清洗是分析前的必要步骤,目的是确保数据的质量。Python中的列表和字典在数据清洗过程中扮演着核心角色。

假设我们有一组包含不完整记录的数据集,我们需要将这些记录清洗,确保每个记录都包含必要的字段。

```python

data = [

{'name': 'Alice', 'age': '30', 'email': '***'},

{'name': 'Bob', 'age': '', 'email': '***'},

{'name': 'Charlie', 'age': '25', 'email': ''},

]

cleaned_data = []

for record in data:

if record.get('age') and record.get('email'):

cleaned_data.append(record)

print(cleaned_data)

```

在这段代码中,我们遍历原始数据集`data`,检查每个记录的`age`和`email`字段是否存在。只有当这两个字段都存在时,记录才会被添加到清洗后的数据集`cleaned_data`中。

数据清洗中常用的Python数据结构还有`collections.Counter`来统计数据的频率分布,以及`pandas.DataFrame`来处理和分析表格数据。

### 4.2.2 高效的数据存储与检索技术

为了高效地存储和检索数据,Python提供了多种数据结构,其中`sqlite3`模块是轻量级关系数据库的首选接口,而`pandas`库则在处理大型表格数据方面表现出色。

```python

import sqlite3

import pandas as pd

# 连接到SQLite数据库

# 数据库文件是test.db,如果文件不存在,会自动在当前目录创建:

conn = sqlite3.connect('test.db')

cursor = conn.cursor()

# 创建一个表格

cursor.execute('CREATE TABLE user (id INTEGER PRIMARY KEY, name TEXT, age INTEGER)')

# 插入数据

cursor.execute('INSERT INTO user (name, age) VALUES (?, ?)', ('Alice', 30))

***mit()

# 使用Pandas读取数据

df = pd.read_sql_query('SELECT * FROM user', conn)

print(df)

# 关闭Cursor和Connection:

cursor.close()

conn.close()

```

在这个例子中,我们展示了如何使用`sqlite3`模块创建表格、插入数据,以及使用`pandas`读取数据。`pandas`的`read_sql_query`函数使得从数据库检索数据并转换为`DataFrame`对象变得非常简单。`DataFrame`对象提供了非常高效和直观的数据操作方式。

## 4.3 数据结构在机器学习中的重要性

机器学习算法的性能在很大程度上取决于数据结构的选择和使用。合适的结构可以显著提高模型的训练速度和预测准确性。本节将详细讨论数据结构在机器学习中的应用。

### 4.3.1 特征工程中的数据结构运用

特征工程是机器学习中将原始数据转换为可供算法使用的形式的过程。在这个过程中,我们经常需要使用数据结构来组织特征数据。

假设我们正在处理一个文本分类问题,我们需要将文本数据转换为向量形式,以便机器学习模型可以处理。

```python

from sklearn.feature_extraction.text import CountVectorizer

corpus = [

'This is the first document.',

'This document is the second document.',

'And this is the third one.',

'Is this the first document?',

]

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(corpus)

print(X.toarray())

```

在这个例子中,我们使用了`CountVectorizer`,它将文本数据转换为词频向量。`vectorizer.fit_transform(corpus)`生成了一个稀疏矩阵,其中包含了文档中每个词的频率。这种矩阵是机器学习中常用的结构,可以被算法有效地处理。

### 4.3.2 数据结构对算法效率的影响

在机器学习算法的实现中,数据结构的选择直接影响到算法的运行时间和空间复杂度。例如,在实现决策树时,使用合适的数据结构可以减少不必要的数据访问和计算。

```python

class TreeNode:

def __init__(self, feature=None, threshold=None, left=None, right=None, *, value=None):

self.feature = feature

self.threshold = threshold

self.left = left

self.right = right

self.value = value

class DecisionTreeClassifier:

def __init__(self, max_depth=None):

self.max_depth = max_depth

def fit(self, X, y):

self.root = self._build_tree(X, y)

def _build_tree(self, X, y, depth=0):

# 递归构建树的逻辑

pass

# 使用决策树进行分类

dt_classifier = DecisionTreeClassifier(max_depth=3)

dt_classifier.fit(X_train, y_train)

```

在这个简化的例子中,我们定义了`TreeNode`类来表示决策树中的每个节点,以及`DecisionTreeClassifier`类来构建和训练决策树模型。正确地选择和使用数据结构可以提高算法的效率,特别是在处理大型数据集时。

在决策树中,一个良好的数据结构可以帮助我们快速访问节点的属性,如特征值和分裂阈值,以及高效地构建和遍历树结构。

在本章中,我们通过一系列的实践案例分析了Python数据结构在Web开发、数据分析和机器学习中的应用。通过这些案例,我们可以看到数据结构不仅在算法实现上扮演着重要角色,而且在提升系统性能和优化用户体验方面也具有不可忽视的影响。下一章,我们将探索Python中的特殊数据结构和高级技巧,以及它们在不同领域的应用潜力。

# 5. 数据结构高级特性与技巧

## 5.1 特殊数据结构的探索

### 5.1.1 堆、栈、队列的Python实现和应用

堆、栈、队列是三种常见的特殊数据结构,它们在算法设计和数据管理中有着广泛的应用。在Python中,虽然有内置的数据结构如列表、字典和集合可以用来模拟这些特殊数据结构,但为了更好的性能和方便管理,通常会用专门的类来实现它们。

#### 堆的Python实现及应用

堆(Heap)是一种特殊的完全二叉树,其中每个父节点的值都大于或等于其子节点的值(在最小堆中),或者小于或等于其子节点的值(在最大堆中)。在Python中,可以使用heapq模块来实现堆。以下是一个简单的堆实现示例:

```python

import heapq

class MinHeap:

def __init__(self):

self.heap = []

def push(self, item):

heapq.heappush(self.heap, item)

def pop(self):

return heapq.heappop(self.heap)

def peek(self):

return self.heap[0] if self.heap else None

# 使用MinHeap类

min_heap = MinHeap()

min_heap.push(4)

min_heap.push(1)

min_heap.push(7)

print(min_heap.pop()) # 输出 1

```

堆在优先级队列、堆排序以及图的最短路径算法如Dijkstra算法中有着重要的应用。

#### 栈的Python实现及应用

栈(Stack)是一种后进先出(LIFO)的数据结构,最后一个添加到栈中的元素将是最先被移除的元素。在Python中,可以使用列表来模拟栈的行为:

```python

class Stack:

def __init__(self):

self.items = []

def is_empty(self):

return len(self.items) == 0

def push(self, item):

self.items.append(item)

def pop(self):

if not self.is_empty():

return self.items.pop()

return None

# 使用Stack类

stack = Stack()

stack.push(3)

stack.push(5)

print(stack.pop()) # 输出 5

```

栈在编译器中的语法解析、递归算法、以及回溯算法中发挥着关键作用。

#### 队列的Python实现及应用

队列(Queue)是一种先进先出(FIFO)的数据结构,第一个添加到队列中的元素将是第一个被移除的元素。Python的collections模块提供了deque类,它可以高效地实现队列:

```python

from collections import deque

class Queue:

def __init__(self):

self.items = deque()

def is_empty(self):

return len(self.items) == 0

def enqueue(self, item):

self.items.append(item)

def dequeue(self):

return self.items.popleft() if not self.is_empty() else None

# 使用Queue类

queue = Queue()

queue.enqueue(1)

queue.enqueue(2)

print(queue.dequeue()) # 输出 1

```

队列在计算机科学中用于进程同步、任务调度以及网络中的缓冲处理等领域。

### 5.1.2 图和树的基本操作及应用场景

图和树是复杂数据结构的基础,它们在处理复杂关系问题时非常有用。

#### 图的基本操作及应用

图(Graph)是由一系列顶点(vertices)和连接顶点的边(edges)组成的非线性数据结构。在Python中,图可以通过字典来实现,其中键是顶点,值是与该顶点相连的顶点集合。

```python

class Graph:

def __init__(self):

self.graph = {}

def add_vertex(self, vertex):

if vertex not in self.graph:

self.graph[vertex] = []

def add_edge(self, v1, v2):

self.graph[v1].append(v2)

self.graph[v2].append(v1)

def print_graph(self):

for key in self.graph:

print(key, '-->', self.graph[key])

# 创建图并添加顶点和边

graph = Graph()

graph.add_vertex('A')

graph.add_vertex('B')

graph.add_edge('A', 'B')

graph.print_graph() # 输出 A --> ['B'] B --> ['A']

```

图在社交网络分析、地图导航、网络设计等领域中有着广泛的应用。

#### 树的基本操作及应用

树(Tree)是一种分层数据的抽象模型,用于存储具有层次关系的数据。树的每个节点都有零个或多个子节点,没有环路和有且仅有一个根节点。

```python

class TreeNode:

def __init__(self, name):

self.name = name

self.children = []

def add_child(self, child_node):

self.children.append(child_node)

# 创建树结构

root = TreeNode('root')

child1 = TreeNode('child1')

child2 = TreeNode('child2')

root.add_child(child1)

root.add_child(child2)

# 输出树结构

def print_tree(node, level=0):

indent = ' ' * level

print(f"{indent}- {node.name}")

for child in node.children:

print_tree(child, level+1)

print_tree(root)

```

树在文件系统、数据库索引、以及HTML文档对象模型(DOM)中被广泛应用。

## 5.2 高级数据结构的内存管理

### 5.2.1 数据结构的垃圾回收机制

Python使用自动垃圾回收机制来管理内存,这使得内存管理对程序员来说几乎是透明的。Python的垃圾回收机制主要基于引用计数(reference counting)来跟踪和回收不再使用的对象。如果一个对象的引用计数变为零,Python解释器会立即回收该对象所占用的内存。

引用计数的增加发生在对象被创建或者被引用时,而减少发生在对象不再被引用时。可以通过`sys`模块的`getrefcount`函数来观察某个对象的引用计数:

```python

import sys

a = []

print(sys.getrefcount(a)) # 输出 2(一个隐式的引用:传给getrefcount的参数)

```

此外,Python还使用了循环检测器来处理引用循环问题,即两个或多个对象互相引用导致它们的引用计数无法下降至零。这种情况下,Python会周期性地运行垃圾回收器来检测和回收这些无用的循环引用。

### 5.2.2 内存泄漏的预防与诊断

尽管Python的垃圾回收机制相当强大,但是仍然可能遇到内存泄漏的问题。内存泄漏通常发生在对象被引用但不再需要时,导致这些对象一直存在于内存中。

#### 预防内存泄漏的策略

- 使用局部变量:局部变量在函数执行完毕后会被自动清理。

- 使用弱引用:当一个对象不再被需要时,可以使用弱引用(weakref模块)来引用这个对象,这样不会增加对象的引用计数。

- 避免全局变量:全局变量生命周期较长,可能会无意中维持对不需要的对象的引用。

- 定期进行内存分析:使用内存分析工具(如objgraph或memory_profiler)来检查内存的使用情况。

#### 内存泄漏的诊断

- 使用objgraph库来可视化内存中的对象,检查是否存在意外的对象引用。

- 使用内存分析工具如memory_profiler来监控内存使用情况,并找出内存消耗的热点。

```python

# 示例:使用objgraph检查对象

import objgraph

objgraph.show_backrefs([a], filename='objects_backrefs.png', refcounts=True)

```

这将生成一个图表,显示对象`a`的所有回引用,帮助我们找出导致内存泄漏的对象。

## 5.3 数据结构的递归与迭代

### 5.3.1 递归算法的设计原则和限制

递归(Recursion)是一种常见的编程技术,它允许函数调用自身。在处理具有自然递归性质的问题,如树和图的遍历、排序算法(快速排序、归并排序)以及搜索算法(二分搜索)时,递归特别有用。

设计递归算法需要遵循一些基本原则:

- **基准情形(Base Case)**:确保算法在最简单的情况下能直接返回结果,避免无限递归。

- **递归情形(Recursive Case)**:将问题分解为更小的同类问题,并递归地调用算法自身。

- **保持状态**:确保每次递归调用都能保持必要的状态,以便于达到基准情形后能够正确回溯。

例如,递归计算阶乘:

```python

def factorial(n):

if n == 0: # 基准情形

return 1

else: # 递归情形

return n * factorial(n-1)

print(factorial(5)) # 输出 120

```

尽管递归算法在某些问题上非常优雅和简洁,但它也有一些限制:

- **内存限制**:每次递归调用都会消耗内存来保存状态信息,可能导致栈溢出。

- **效率问题**:递归可能导致重复计算,降低效率。

### 5.3.2 迭代与递归性能比较及其选择策略

迭代(Iteration)是另一种遍历或重复执行算法的方法,通常使用循环结构实现。相比递归,迭代通常在空间效率上更优,因为它不需要额外的栈空间来保存函数调用的状态。

性能比较:

- **空间复杂度**:递归通常有较大的空间开销,而迭代的空间复杂度通常为O(1)。

- **时间复杂度**:递归和迭代的时间复杂度取决于算法本身的设计。

- **可读性和维护性**:递归的代码通常更简洁易读,但有时可能牺牲性能;迭代则可能较为复杂,但易于理解和维护。

选择策略:

- **问题本质**:对于具有自然递归结构的问题(如树的遍历),递归可能是更直观的解决方案。

- **性能考量**:对于大型数据集,应当评估递归和迭代的性能,选择更优的方案。

- **资源限制**:如果内存限制是一个问题,则迭代可能是更安全的选择。

例如,在计算斐波那契数列时,递归方法虽然简洁,但其性能不佳,特别是在大数计算时。而迭代方法则可以有效地避免这个问题:

```python

# 迭代计算斐波那契数列

def fibonacci(n):

a, b = 0, 1

for _ in range(n):

a, b = b, a+b

return a

print(fibonacci(10)) # 输出 55

```

通过这个示例可以看出,迭代在处理这类问题时,不仅代码简洁,而且执行效率更高。在实际应用中,我们应该根据具体问题和需求,选择最适合的算法实现方式。

# 6. 数据结构的未来趋势与挑战

## 6.1 新兴数据结构的研究进展

随着科技的发展,新的计算范式正在推动数据结构领域的研究向前迈进。量子计算作为一个新兴领域,已经开始影响数据结构的设计与应用。

### 6.1.1 数据结构在量子计算中的潜在应用

量子计算利用量子位(qubits)代替传统的二进制位(bits),这为数据结构带来了革命性的变革。量子位的叠加态和纠缠态为存储和处理信息提供了全新的方式。例如,量子计算机利用量子比特可以同时表示0和1的特性,实现了量子数据结构如量子栈和量子队列等。这些量子数据结构极大地提高了特定计算任务的效率,如量子搜索算法可以在O(√n)的时间复杂度内找到元素,比传统算法快得多。

### 6.1.2 分布式系统中的数据结构优化

在分布式系统中,数据结构需要考虑节点间的数据一致性和网络延迟问题。例如,分布式哈希表(DHT)被广泛应用于点对点网络,如BitTorrent和IPFS中,用于高效地定位和存储数据。此外,跳表(Skip List)作为一种可平行化处理的数据结构,被设计为在分布式数据库中优化查询速度和维护成本。

## 6.2 数据结构面临的挑战与机遇

数据结构不仅是IT领域的一项基础技术,它也是应对不断增长的数据量和更复杂计算任务的关键。

### 6.2.1 大数据时代的存储与处理挑战

在大数据时代,数据的规模和多样性对存储与处理提出了新的要求。例如,传统的树形结构如B树和B+树在处理大规模数据集时可能会遇到性能瓶颈。这推动了诸如LSM树(Log-Structured Merge-tree)等新型结构的发展,这些结构在优化写入性能和处理并发访问方面表现更加优异。随着数据量的增长,数据结构的设计需要更加关注水平扩展能力。

### 6.2.2 人工智能对数据结构需求的演变

人工智能(AI)领域的发展推动了对数据结构需求的演变。特别是在机器学习和深度学习模型中,数据的表示和处理方式直接影响到模型的效率和准确性。例如,稀疏矩阵的使用在深度学习中广泛存在,以应对高维数据的存储和计算需求。另外,图数据结构在处理复杂关系和模式识别中发挥着关键作用,使得神经网络可以模拟人脑的连接方式。

## 6.3 数据结构教育的现状与展望

教育是培养未来IT人才的基石,数据结构的教学同样需要适应新技术的发展和行业的变化。

### 6.3.1 现行教育体系中数据结构的教授方式

目前大多数计算机科学课程中,数据结构作为必修课程,通常在学生的基础教育阶段进行教授。传统的教学模式侧重于基本概念的讲授和经典数据结构的应用案例。而面向对象编程、递归和迭代等高级特性则被作为扩展知识点介绍。

### 6.3.2 未来数据结构教学的创新方向

随着实践技术的演变,未来数据结构的教学方法需要创新以适应新技术的发展。例如,可以通过模拟实际应用场景来加强学生对数据结构在真实世界中如何应用的理解。在教学中加入更多的实验和项目工作,使学生能够通过实际操作来掌握数据结构的设计和优化。此外,利用在线编程平台进行实时协作和编码练习,可以帮助学生更好地理解和应用数据结构。教育者应该鼓励学生将数据结构与算法、系统设计等多个领域相结合,以培养更具综合素质的IT专业人才。

0

0