HBase备份与恢复策略:实时性与一致性权衡技巧

发布时间: 2024-10-26 01:26:30 阅读量: 22 订阅数: 39

博途1200恒压供水程序,恒压供水,一拖三,PID控制,3台循环泵,软启动工作,带超压,缺水保护,西门子1200+KTP1000触摸屏

# 1. HBase备份与恢复概述

随着大数据时代的到来,HBase作为一款开源的非关系型分布式数据库,因其优秀的水平扩展性和海量数据存储能力,在业界得到了广泛应用。HBase备份与恢复机制是保障数据安全和业务连续性的关键组成部分。在本章中,我们将概述HBase备份与恢复的重要性,解析备份与恢复的基本概念,并讨论在数据丢失或系统故障情况下,如何有效地进行数据恢复,以确保数据的完整性和业务的连续性。

## 1.1 数据安全的重要性

数据是企业的生命线。在处理大规模数据的场景中,数据的安全性和完整性对于企业来说至关重要。HBase虽然提供了数据的高可用性架构设计,但是诸如硬件故障、软件缺陷、人为误操作等因素仍有可能导致数据丢失或损坏。因此,定期的备份和有效的恢复策略是必不可少的。

## 1.2 备份与恢复的基本概念

备份是创建数据副本的过程,以便在原始数据丢失或损坏时,可以从备份副本中恢复数据。而恢复是指在数据丢失或损坏时,将备份数据还原到系统中的操作。在HBase中,备份与恢复机制不仅涉及到数据层面,还包括对数据模型和存储架构的理解,确保数据的一致性和完整性。

在接下来的章节中,我们将深入分析HBase的备份机制、备份数据的一致性保障、恢复策略,以及实时性优化等关键内容。

# 2. HBase备份机制分析

## 2.1 HBase数据备份的理论基础

### 2.1.1 HBase的数据模型和存储架构

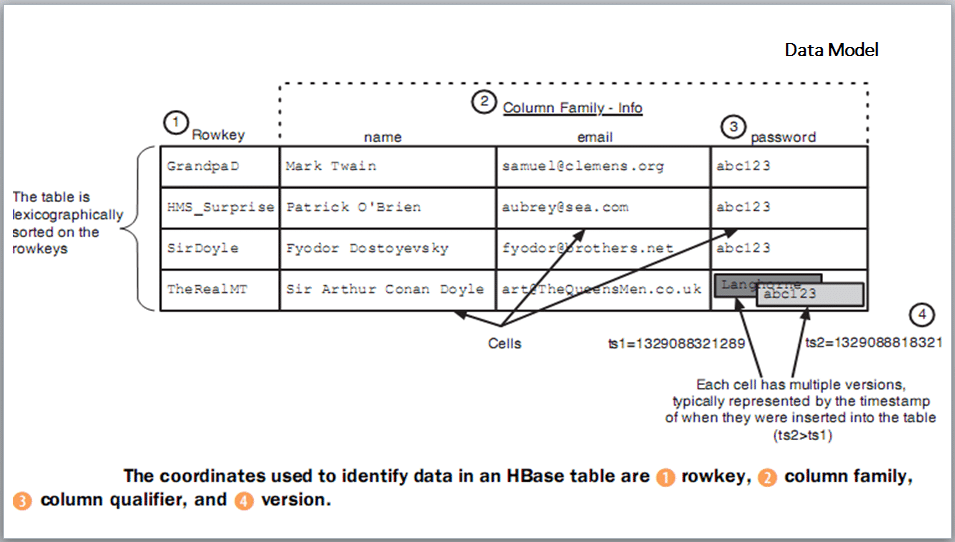

HBase是一个开源的非关系型分布式数据库(NoSQL),它构建在Hadoop文件系统(HDFS)之上,提供了高可靠性、高性能、列存储、可伸缩和实时读写的特性。HBase的数据模型与传统的关系型数据库有所不同,它采用了列族(Column Family)的概念,这是一种多维的映射结构。

HBase的存储架构主要包含以下几个核心组件:

- RegionServer:负责数据的存储和读写操作,每个RegionServer管理一部分表,这些表被水平划分为多个Region。

- Region:表的分区,是表被水平切分的片段。每个Region都由一个RegionServer负责。

- HMaster:负责整个HBase集群的管理工作,如分配Region给RegionServer,监控RegionServer的故障等。

- HFile:是HBase数据的底层存储格式,每个HFile代表一个列族中的数据存储。

### 2.1.2 HBase备份的必要性与挑战

备份是任何数据存储系统中关键的操作,它确保数据在发生故障或数据丢失时能够被恢复。HBase数据备份有其独特的必要性:

- 数据安全:防止数据损坏或硬件故障导致的数据丢失。

- 灾难恢复:在发生灾难性故障时能够快速恢复业务。

- 多数据中心备份:支持跨数据中心备份,实现更高级别的数据安全。

然而,备份HBase也面临一些挑战:

- 性能影响:备份操作可能会对集群性能造成影响,尤其是在热备份(在线备份)场景中。

- 数据一致性:保证备份数据与当前数据的一致性是一个挑战。

- 备份的时效性:需要确定备份的频率和备份策略,以平衡备份成本和数据安全性。

## 2.2 HBase数据备份技术实践

### 2.2.1 冷备份的步骤和注意事项

冷备份是指在HBase服务完全停止的情况下进行的数据备份。虽然这种方式对在线服务的影响最小,但其实用性也受到了限制。

冷备份步骤如下:

1. 停止所有HBase服务。

2. 使用HDFS的`-copyFromLocal`命令将HBase的数据目录复制到备份目录。

3. 确认备份目录下的数据完整性。

4. 重启HBase服务。

注意事项:

- 冷备份操作简单,但是每次备份都需暂停服务,不利于实时备份需求。

- 需要备份的数据包括HBase的元数据和数据文件。

- 必须确保在备份过程中数据没有被修改,否则备份可能不完整。

### 2.2.2 热备份的实现方法和限制

热备份是指在HBase集群运行的过程中进行的数据备份,它允许服务不间断地对外提供服务。

实现方法:

- 利用HBase的快照功能创建数据快照。

- 将快照导出到新的备份目录。

- 在HDFS级别复制快照文件。

限制:

- 热备份对集群性能有影响,尤其是在大集群中。

- 需要考虑快照创建和数据复制的时间窗口。

- 快照只支持列族级别的备份,不支持单个列的备份。

### 2.2.3 增量备份策略与实现

增量备份指的是备份自上次备份以来发生变化的数据,它是一种更高效的数据备份方式,能够减少备份所需时间和资源。

策略:

- 定期创建快照作为基线备份。

- 在每次增量备份时,记录自上次备份以来的变更。

- 只备份这些变更数据到备份系统。

实现:

```bash

# 创建基线备份快照

hbase> snapshot 'table_name', 'baseline_snapshot'

# 创建增量备份快照

hbase> snapshot 'table_name', 'incremental_snapshot'

# 使用hbase的shell命令或者API来获取变更数据

# 示例代码省略具体实现细节,需要根据实际变更记录进行操作

```

## 2.3 备份数据的一致性保障

### 2.3.1 一致性备份的原理

一致性备份是确保备份数据与源数据状态一致的方法。在分布式存储系统中,这个概念尤为重要,因为数据的更新可能发生在多个服务器上。

原理:

- 一致性备份通常涉及到事务管理,确保备份操作在某个时间点内原子性地完成。

- 快照是实现一致性备份的一种方法,它能够在数据的一致性点上创建整个数据集的镜像。

### 2.3.2 HBase快照功能的使用与限制

HBase提供了快照功能,允许在任意时间点创建数据的快照,这为一致性备份提供了工具支持。

使用:

```shell

# 创建表快照

hbase> snapshot 'table_name', 'snapshot_name'

# 列出所有快照

hbase> list_snapshots

# 恢复快照到新表

hbase> restore_snapshot 'snapshot_name', 'new_table_name'

```

限制:

- 快照不是数据实时更新的备份,它更适合用来备份长时间段的数据。

- 快照不包括HBase的元数据,如果需要恢复,需要额外备份元数据。

- 创建和恢复快照的过程可能会对集群性能产生影响。

### 2.3.3 事务型备份的探索与实践

事务型备份保证了在备份期间数据的一致性和完整性,是HBase备份研究的前沿方向。

探索:

- HBase的原生事务支持还在发展中,未来的版本中可能会有更完善的事务型备份解决方案。

- 使用HBase的协处理器(Coprocessor)可能是一个潜在的解决方案,可以实现对备份操作的细粒度控制。

实践:

- 通过插件或外部工具实现事务性备份。

- 利用HBase的事务日志(WAL)保证备份的数据完整性。

```java

// 示例代码展示事务型备份的开发思路

// 伪代码,需要根据HBase的实际API进行编写

Coprocessor backupCoprocessor = new BackupCoprocessor();

RegionServer.addCoprocessor(backupCoprocessor);

```

在本小节中,我们深入探讨了HBase备份机制的理论基础,实践操作,以及实现数据一致性备份的途径。接下来,我们将转向HBase恢复策略的深入分析。

# 3. HBase恢复策略探究

## 3.1 HBa

0

0