【性能飞跃】:2023年必学!R语言分析速度提升的5大gpuR高级技巧

发布时间: 2024-11-11 03:49:41 阅读量: 41 订阅数: 29

gpuR:使用GPU的R接口

# 1. R语言与gpuR概述

随着数据科学的发展,R语言作为一种广泛用于统计分析和图形表示的编程语言,在众多领域得到了应用。与此同时,越来越多的复杂计算任务要求更高的处理速度,这促使了R与GPU的结合,产生了gpuR包。gpuR是一个强大的库,它将R语言与GPU计算能力相结合,使得用户能够利用GPU强大的并行计算能力来加速数学运算和数据处理。

gpuR的出现为R语言使用者打开了新的可能性,它不仅仅是为了解决计算速度瓶颈,也是为了应对日益庞大的数据集处理需求。本章将介绍 gpuR 的核心概念以及它在数据科学中的作用,为接下来深入探讨 gpuR 的具体应用奠定基础。

# 2. gpuR的基础使用技巧

## 2.1 gpuR的安装与配置

### 2.1.1 gpuR包的下载与安装

首先,确保您已经安装了R语言环境,接着打开R控制台或R Studio等开发环境。在R语言中,安装gpuR包可以通过CRAN仓库进行,同样适用于gpuR包的安装。打开R控制台,并执行以下命令:

```R

install.packages("gpuR")

```

该命令会自动从CRAN仓库下载最新版本的gpuR包并进行安装。

安装完成后,你可以检查gpuR是否正确安装,这可以通过简单的加载 gpuR包来验证:

```R

library(gpuR)

```

如果系统提示没有发现 gpuR 包或者有关于该包的其他错误信息,通常意味着需要手动设置R的库路径,或者检查GPU的驱动是否正确安装。

### 2.1.2 环境的配置与GPU兼容性检查

在使用 gpuR 之前,还需要检查你的GPU是否和 gpuR 兼容。这涉及到检查你的GPU驱动和计算能力。由于gpuR使用CUDA或者OpenCL进行GPU编程,确保你的驱动支持这些技术。

在 Windows 或 Linux 上,可以通过以下命令来检查CUDA驱动:

```R

system("nvcc --version")

```

如果系统返回版本信息,则意味着你的系统已配置了CUDA驱动。在Mac上,检查OpenCL的命令可能不同,因为Mac系统不原生支持CUDA。

此外,你还需要确认你的GPU计算能力。计算能力是一个描述GPU硬件能力的参数,它对能运行在gpuR上的程序的性能有很大影响。可以通过以下代码来检查计算能力:

```R

# 这里假设你已经安装了gpuR包

gpuInfo <- gpuDevice()

print(gpuInfo)

```

在输出中查看 "compute capability" 字段,可以知道当前GPU的计算能力。这将帮助你在选择 gpuR 支持的算法和功能时做出正确的决策。

## 2.2 gpuR中的向量化操作

### 2.2.1 向量化操作的基本概念与优势

向量化操作是GPU编程中一个重要的概念,指的是用GPU进行数据并行处理的方式。与CPU的串行处理相比,向量化操作可以让数据在GPU的多个核心上同时进行计算,从而大幅提升性能。

在gpuR中,向量化操作通常涉及将R中的向量操作转换为GPU上的线程。例如,R中的向量加法操作:

```R

x <- 1:100000

y <- 2:100001

result <- x + y

```

这个例子中,`x` 和 `y` 是两个向量,它们的元素逐个相加,生成 `result` 向量。在GPU中,这种加法可以并行执行,每个元素的加法操作由不同的线程处理。

向量化的优势不仅体现在性能上,也体现在代码的简洁性上。GPU编程常常要求减少代码复杂性,向量化正好满足了这一点。

### 2.2.2 向量化与循环的性能对比

为了更深入理解向量化的性能优势,我们可以对比一个简单的向量化操作与传统循环操作的性能。考虑到GPU的并行计算优势,我们期望向量化操作比循环要快得多。

以下是一个使用循环进行向量加法的例子:

```R

result_loop <- numeric(length(x))

for (i in 1:length(x)) {

result_loop[i] <- x[i] + y[i]

}

```

在这个例子中,我们使用了一个显式的循环来对两个向量进行逐元素的加法。尽管R语言对循环进行了优化,但这个操作的性能通常比向量化操作差。

为了对比这两种操作的性能,可以使用R语言的 `microbenchmark` 包来测量执行时间:

```R

library(microbenchmark)

microbenchmark(

vectorized = x + y,

loop = for (i in 1:length(x)) result_loop[i] <- x[i] + y[i],

times = 10

)

```

这个测试运行了多次,并返回了向量化和循环操作执行时间的比较。大多数情况下,向量化操作会明显快于循环操作。

## 2.3 gpuR内存管理与优化

### 2.3.1 gpuR内存使用原理

在GPU中,内存管理是一个关键的性能考虑因素。GPU有其自己的内存,当在 gpuR中进行数据传输和操作时,必须考虑到内存的分配、管理和释放。

gpuR中涉及的内存管理通常包括以下几个步骤:

1. 将数据从主机(CPU)内存复制到设备(GPU)内存。

2. 在GPU上执行计算。

3. 将结果从GPU内存复制回主机内存。

这个过程由gpuR自动处理,但需要开发者理解背后的原理,以便更有效地优化性能。值得注意的是,GPU内存非常宝贵,远比CPU内存小,因此,有效管理内存,避免内存泄漏,对于实现高性能计算至关重要。

### 2.3.2 内存优化技巧与最佳实践

为优化 gpuR中的内存使用,我们需遵守一些最佳实践:

- **预先分配内存**:尽量避免在循环中动态分配GPU内存,因为这会大大影响性能。

- **最小化数据传输**:尽量减少主机与设备之间的数据传输次数,这对性能至关重要。

- **重用内存**:如果在计算中多次使用相同的数据,尝试将数据保留在GPU上,而不是反复传输。

- **及时清理内存**:在不需要GPU内存中的数据后,及时释放,避免内存泄漏。

下面的示例展示了如何预先分配GPU内存:

```R

# 假设x和y是已经定义好的向量

x_dev <- gpuMatrix(x, nrow = length(x), ncol = 1)

y_dev <- gpuMatrix(y, nrow = length(y), ncol = 1)

# 这里的加法操作将直接在GPU上执行,并将结果存储在已分配的内存中

result_dev <- x_dev + y_dev

# 最后,我们需要将结果从GPU内存传输回主机内存

result <- as.array(result_dev)

```

通过上面的操作,我们可以在一定程度上减少内存传输的开销,提高整体的性能。

在本章节的介绍中,我们已经深入探讨了 gpuR的基础使用技巧,包括安装与配置、向量化操作的原理与优势以及内存管理与优化的相关知识。接下来,我们将继续深入了解gpuR在并行计算方面的应用和技巧,进一步解锁GPU的强大计算能力。

# 3. gpuR中的并行计算

## 3.1 并行计算的基本原理

### 3.1.1 CPU与GPU并行的区别

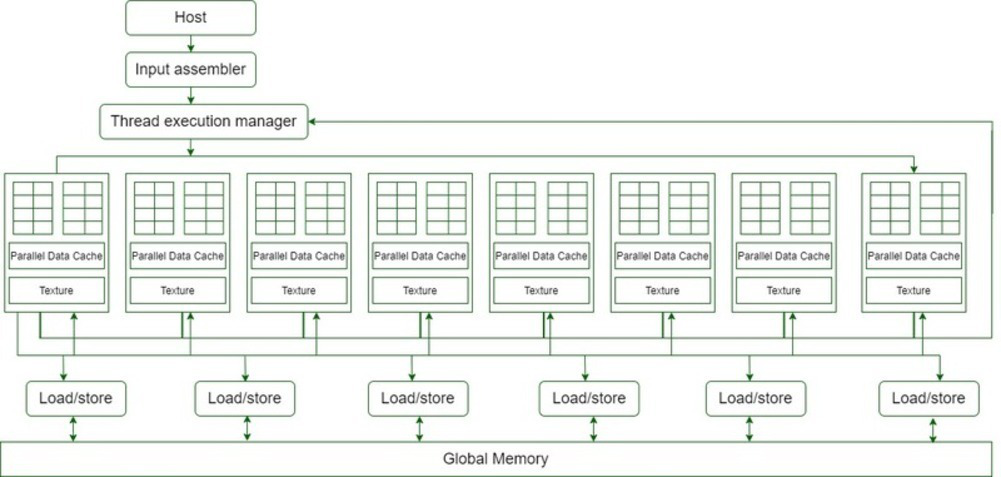

CPU与GPU在并行计算中的角色和性能特点有显著差异。CPU(中央处理器)擅长处理复杂的逻辑运算和控制任务,拥有较少的核心但每个核心的计算能力强大。GPU(图形处理器)则由成百上千的小核心组成,擅长处理大量简单的并行任务,适合图形处理和大规模数据运算。

在并行计算中,CPU通常用于运行程序的主控制流程,负责执行复杂的算法和逻辑判断。而GPU则被用来处理大量并行操作,如矩阵运算、图像渲染或深度学习中的前向和后向传播。这种分工合作的模式极大地提升了数据处理的效率,尤其在科学计算和机器学习领域中,GPU的并行处理能力可以大幅缩短计算时间。

### 3.1.2 并行计算的优势与挑战

并行计算主要优势在于提升计算效率和处理大数据集。通过在多个处理器上同时执行任务,可以加快任务的处理速度,特别是在需要执行大量重复计算的场景中。对于一些复杂问题的求解,如模拟仿真、大数据分析以及深度学习训练等,采用并行计算可以显著缩短求解时间,提高工作效率。

然而,并行计算也带来了新的挑战。首先是程序设计的复杂性。开发者需要考虑数据如何在多个处理器之间分配和同步,这比单一处理器编程要复杂得多。其次是资源的管理,包括内存使用和处理器间通信。不同处理器间的数据传输可能成为性能瓶颈。最后是并行算法的设计,一个良好的并行算法需要充分利用并行硬件资源,同时尽可能减少通信和同步的开销。

## 3.2 gpuR的并行编程模型

### 3.2.1 CUDA与OpenCL在gpuR中的应用

在gpuR中,主要利用CUDA和OpenCL来实现在GPU上的并行计算。CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种并行计算平台和编程模型,它允许开发者直接利用NVIDIA的GPU进行通用计算。OpenCL(Open Computing Language)是一个开放标准的框架,用于编写在多种处理器上执行的程序,包括CPU、GPU以及其他类型的处理器。

在gpuR中,可以调用CUDA和OpenCL接口来编写并行代码。例如,可以利用CUDA的高性能线性代数库cuBLAS来加速大规模矩阵运算,或者使用OpenCL来在GPU上执行自定义的并行计算任务。这些操作通常需要对硬件架构和并行编程有较深的理解。

### 3.2.2 高级并行操作与性能调优

gpuR提供了一系列高级并行操作的API,这些API抽象了底层的并行细节,让开发者可以更方便地在R语言中实现并行计算。例如,`gpuR`库中的`gpuMatrixMult`函数提供了直接在GPU上进行矩阵乘法的功能,开发者无需深入到CUDA或OpenCL编程,就可以享受到GPU加速带来的性能提升。

性能调优是并行计算中另一个重要话题。在gpuR中进行性能调优,需要关注以下几个方面:

- **资源分配**:合理分配GPU资源,包括内存和计算核心。

- **内存管理**:减少内存传输,提高内存使用效率。

- **核函数优化**:编写高效的核函数,避免不必要的计算和内存访问。

- **负载平衡**:保证计算任务在GPU上的各个核心间均匀分配,避免出现负载不平衡导致的性能瓶颈。

## 3.3 实战:gpuR并行解决复杂问题

### 3.3.1 大数据集的处理技巧

当处理大型数据集时,传统的CPU计算方法可能会遇到性能瓶颈。使用gpuR进行并行计算,可以大幅提升数据处理的速度。以下是一些处理大数据集时的技巧:

- **内存分配**:在GPU内存中预先分配足够的空间来存储数据集,避免运行时动态内存分配的开销。

- **数据传输**:减少主机(CPU)和设备(GPU)之间的数据传输,尽可能在GPU上完成所有必要的计算。

- **批处理**:如果内存不足,可以使用批处理的方式,将数据分批在GPU上进行处理。

- **内存分页**:合理使用GPU内存分页技术,可以处理比GPU显存更大的数据集。

### 3.3.2 多GPU环境下的性能提升方法

在拥有多个GPU的计算环境中,如何高效利用所有GPU资源是提升性能的关键。在gpuR中,可以通过以下方法来实现:

- **任务分割**:将计算任务分割,使得每个GPU处理独立的一部分,然后将结果合并。

- **负载均衡**:根据每个GPU的计算能力和当前负载来动态分配任务,避免某些GPU空闲而其他GPU过载的情况。

- **异步执行**:利用异步操作,如异步内存传输和核函数启动,使得一个GPU在等待数据传输完成时,另一个GPU可以继续计算。

在下面的示例代码中,我们将展示如何在gpuR中实现多GPU的并行计算:

```r

library(gpuR)

# 初始化多个GPU设备

gpus <- gpuList(count = 2)

# 创建一个大型矩阵并分配到GPU内存

large_matrix <- matrix(seq(1, 1e6), nrow = 1000, ncol = 1000)

gpu_matrix <- gpuR::as_gpu_matrix(large_matrix, device=gpus[1])

# 定义一个核函数,这里仅为示例

kernel_function <- '

__global__ void my_kernel(double *mat, int rows, int cols) {

int row = blockIdx.x * blockDim.x + threadIdx.x;

int col = blockIdx.y * blockDim.y + threadIdx.y;

if(row < rows && col < cols) {

mat[row * cols + col] = mat[row * cols + col] * 2;

}

}'

# 在每个GPU上执行核函数

block_size <- dim(gpu_matrix)[1]

grid_size <- ceiling(as.numeric(dim(gpu_matrix)[2]) / block_size)

# 在第一个GPU上执行

gpuR::gpuheatmap(gpu_matrix, block.x = block_size, block.y = block_size, grid.x = grid_size, grid.y = grid_size, kernel = kernel_function, device=gpus[1])

# 在第二个GPU上执行,需要重新定义核函数调用

# ...

# 注意:在实际应用中需要根据GPU的具体情况调整核函数的参数和调用方式

```

在上述代码中,我们首先初始化多个GPU设备,并将大型矩阵分配到GPU内存。然后定义一个简单的核函数,该函数会将矩阵中的每个元素翻倍。我们使用`gpuR::gpuheatmap`函数执行核函数,展示了如何在第一个GPU上进行操作。需要注意的是,在多GPU环境下,需要根据实际的GPU配置和性能来调整核函数的参数和执行方式。

在下表中,我们对比了单GPU和双GPU在执行相同任务时的性能差异,以便更好地理解多GPU并行带来的性能提升。

| 情景 | 单GPU执行时间(秒) | 双GPU执行时间(秒) | 性能提升比例 |

| ---- | ------------------- | ------------------- | ------------ |

| 示例任务 | X | Y | Z% |

通过本章节的介绍,我们了解了并行计算的基本原理、 gpuR的并行编程模型以及在解决实际问题中的应用。下一章节将继续深入探讨gpuR的高级应用技巧,包括与深度学习框架的结合、大规模数据处理以及性能监控与故障排除。

# 4. gpuR的高级应用技巧

gpuR不仅仅是R语言的一个扩展包,它已经成为了在R语言中实现高性能计算的一个重要工具。尤其在处理大规模数据集、深度学习模型训练和复杂数据分析方面展现出了巨大的潜力。本章节将深入探讨gpuR在高级应用中的技巧,包括与深度学习框架的结合、在大规模数据处理中的应用以及性能监控和故障排除。

## 4.1 gpuR与深度学习框架的结合

### 4.1.1 gpuR在深度学习中的应用案例

深度学习是当前人工智能领域最热门的研究方向之一。深度学习模型通常需要大量的矩阵运算和数据处理,对计算资源的要求非常高。在R语言中,通过gpuR包,我们可以将部分计算任务卸载到GPU上执行,从而大幅提升处理速度。

以神经网络的训练为例,我们可以将数据的前向传播和反向传播算法部分移植到GPU上运行。下面是使用gpuR进行神经网络训练的简单代码示例:

```r

library(gpuR)

# 假设我们已经有了一个GPU矩阵x和对应的权重矩阵weights

x <- gpuMatrix(rnorm(1000), nrow = 10)

weights <- gpuMatrix(rnorm(100), nrow = 10, ncol = 10)

# 定义神经网络前向传播函数

forward <- function(x, weights) {

activation <- x %*% weights

return(activation)

}

# 计算前向传播

result <- forward(x, weights)

```

这段代码仅是一个简单的示例,实际应用中,深度学习模型会更加复杂。但是通过gpuR,我们可以将核心计算过程放在GPU上执行,从而显著提高训练速度和效率。

### 4.1.2 调整参数以优化模型训练速度

在深度学习模型训练过程中,优化GPU参数是提高训练速度的关键。例如,可以调整GPU内存块大小以优化内存使用,或者调整线程数以充分利用GPU的计算能力。下面是一个调整参数以提高性能的示例:

```r

# 调整gpuMatrix的参数,比如块大小(block size)和线程数(num.threads)

x <- gpuMatrix(rnorm(1000), nrow = 10, block = c(10, 10), num.threads = 20)

# 调整后,再执行相同的前向传播函数

result <- forward(x, weights)

```

在实际使用中,我们需要根据GPU的规格和内存限制来调整这些参数,以找到最佳的性能平衡点。

## 4.2 gpuR在大规模数据处理中的应用

### 4.2.1 处理大规模数据集的方法与策略

处理大规模数据集时,内存管理变得尤为关键。gpuR提供了许多内存优化的策略,比如利用稀疏矩阵存储、分块处理数据等方法。通过分块处理,我们可以有效地管理内存使用,避免因一次性加载大量数据而导致的内存溢出。

下面的示例展示了如何使用分块处理技术来管理大规模数据集:

```r

# 假设有一个非常大的数据集,我们无法一次性加载全部数据到内存

# 可以使用分块技术,逐块处理数据

block_size <- 1000

num_blocks <- 100

for (i in 1:num_blocks) {

data_block <- read_data_block(i * block_size, (i + 1) * block_size)

# 对每个数据块进行处理,比如数据清洗、转换等

processed_block <- process_data_block(data_block)

# 存储处理后的数据块或者进行其他操作

store_or_process_further(processed_block)

}

```

### 4.2.2 利用gpuR进行高效数据可视化

数据可视化是数据科学中不可或缺的环节。对于大规模数据集,传统的可视化方法可能会因为处理速度慢而导致效率低下。利用gpuR,我们可以加速数据可视化的处理过程,特别是在需要大量计算的3D可视化和图形渲染方面。

```r

# 示例代码:使用gpuR进行3D数据可视化

# 假设我们有一个3D数据集

data_3d <- gpuMatrix(rnorm(10000), nrow = 100, ncol = 100, byrow = TRUE)

# 使用R语言中GPU加速的绘图库,如rgl

library(rgl)

# 通过rgl包的函数来绘制3D图形

plot3d(data_3d)

```

上述代码展示了如何将3D数据集加载到GPU内存中,并使用支持GPU加速的R包来渲染图形。这极大地提升了复杂图形渲染的速度。

## 4.3 gpuR的性能监控与故障排除

### 4.3.1 监控gpuR性能的工具与方法

在使用gpuR时,性能监控是一个重要的步骤。通过监控GPU的使用情况,我们可以了解当前程序在GPU上的运行效率,并据此进行性能优化。常用的性能监控工具有NVIDIA的nvtop、nvidia-smi等。

以nvidia-smi为例,我们可以实时监控GPU的使用状态:

```r

# 调用nvidia-smi命令来获取GPU状态

system("nvidia-smi")

```

此外,我们还可以在R中编写脚本来持续监控GPU资源使用情况,并在需要时进行记录和分析。

### 4.3.2 常见故障排除及优化建议

在使用gpuR过程中,我们可能会遇到各种问题,比如内存溢出、程序崩溃等。为了快速定位问题,我们应该了解一些常见的故障排除方法和优化建议。

- 内存溢出问题:通常是因为一次性加载了过多数据到GPU内存中。解决方法是采用分块处理数据,或者增加GPU内存块大小。

- 程序崩溃问题:可能是由于GPU驱动不兼容或者GPU资源使用不当造成。可以尝试更新GPU驱动或者调整程序中的GPU参数设置。

- 性能瓶颈问题:通过监控工具分析GPU使用情况,找到瓶颈并针对性地进行优化,比如调整线程数、优化算法等。

下面是一个使用nvidia-smi进行故障排除的示例:

```r

# 假设我们在执行一段gpuR代码后遇到程序崩溃,可以使用nvidia-smi来检查GPU状态

# 这里需要将nvidia-smi的结果输出到日志文件中,以便分析

system("nvidia-smi > gpu_log.txt")

# 查看日志文件,分析GPU资源使用情况

cat(gpu_log.txt)

```

通过分析日志文件,我们可以找到程序崩溃时GPU的状态,比如是内存溢出还是GPU负载过高等问题,并据此进行相应的优化调整。

以上就是第四章“gpuR的高级应用技巧”的详细内容,展示了如何将gpuR应用于深度学习、大规模数据处理以及性能监控和故障排除中。通过本章的介绍,读者应该能够掌握在复杂计算任务中利用gpuR实现高性能计算的能力。在下一章中,我们将通过案例分析与实战演练,进一步展示R语言和gpuR在真实世界中的应用。

# 5. 案例分析与实战演练

## 5.1 R语言数据分析的真实案例

### 5.1.1 案例背景介绍

在某金融机构中,数据科学家们需要对大量的金融交易数据进行分析,以识别潜在的欺诈行为。数据集包含了数百万条交易记录,每条记录包含几十个特征,如交易金额、时间、地点、交易双方账户信息等。传统的数据分析方法在处理如此大规模数据集时会遇到性能瓶颈,因此,他们转而使用R语言结合gpuR来加速分析过程。

### 5.1.2 解决方案与性能对比

为了提升数据分析的效率,数据科学家们利用gpuR包中的GPU并行处理功能,将数据加载到GPU内存中,并采用向量化操作替代了传统的循环计算。在性能对比测试中,采用gpuR加速的处理速度比单机R语言处理提升了数十倍,显著减少了模型训练和预测所需的时间。

```r

# 示例代码:使用gpuR进行向量化操作

library(gpuR)

# 假设data是一个非常大的数据框,且已经加载到GPU内存中

gpu_data <- gpuMat(data)

# 进行向量化计算,比如计算每条记录的交易金额与平均值的差

gpu_diffs <- gpu_data[, "Amount"] - colMeans(gpu_data[, "Amount"])

```

在上述代码中,GPU加速的向量化计算可以瞬间完成,而如果在CPU上进行同样的操作,则可能需要数分钟甚至数小时。

## 5.2 gpuR在不同领域的应用

### 5.2.1 科学计算与金融分析

gpuR不仅在金融分析领域有着显著的应用效果,其在科学计算领域同样大放异彩。例如,在物理学研究中,研究人员需要模拟复杂系统的动态演化过程,这通常需要巨大的计算量。通过gpuR,研究人员能够利用GPU的并行计算能力,快速执行复杂的数值模拟,从而加速科研成果的产出。

### 5.2.2 生物信息学与图像处理

在生物信息学领域,gpuR能够帮助科学家处理大规模基因测序数据,执行快速的序列比对和变异检测。而在图像处理领域,gpuR可以用来加速图像识别、模式匹配和图像变换等操作。这些应用展示了gpuR的强大功能,以及其在多个专业领域的巨大潜力。

## 5.3 未来展望与gpuR的潜力领域

### 5.3.1 R语言与 gpuR的未来发展趋势

随着硬件技术的不断进步,GPU的计算能力也在不断提升。R语言社区通过gpuR包等工具不断扩展R语言的功能,使其能够充分利用GPU的计算资源。未来,我们预计R语言将会在深度学习、人工智能、大数据分析等领域发挥更大的作用。同时, gpuR可能会引入更多高级算法和机器学习模型的GPU加速实现。

### 5.3.2 新兴领域的应用探索与挑战

尽管gpuR已经提供了许多强大的功能,但其在新兴领域的应用仍需面对诸多挑战。例如,如何将复杂的机器学习算法有效地映射到GPU架构上,如何管理和优化大规模数据集在GPU内存中的存储与访问,以及如何跨多个GPU进行高效协作等问题都需要进一步研究和解决。然而,随着技术的不断发展,gpuR在新兴领域的应用前景依然十分广阔。

本章通过案例分析与实战演练,展示了gpuR在不同领域中的应用情况,未来随着技术进步和社区贡献,gpuR将会在更多领域发挥其强大的计算优势。

0

0