【R语言中的GPU编程】:从入门到精通的5大高级应用技巧

发布时间: 2024-11-11 04:10:41 阅读量: 15 订阅数: 18

# 1. R语言GPU编程概述

在本章节中,我们将探讨R语言在GPU编程方面的概述,并为读者提供一个整体的框架,了解R语言在利用GPU加速计算中的潜力。R语言作为一种广泛使用的统计编程语言,近年来开始逐渐集成GPU加速功能,这对于处理大规模数据集和复杂计算任务尤为重要。通过结合GPU的强大计算能力,R语言用户可以显著提高数据分析和机器学习模型的运行效率,使得原本需要数小时处理的任务能在几分钟内完成。

R语言的GPU编程还在起步阶段,需要用户有一定程度的理解与操作,本章节将介绍GPU编程的基本概念,以及它如何在R语言中实现,为后续章节更深入的探讨打下基础。在后续章节中,我们将详细介绍GPU的工作原理、R语言的GPU编程环境搭建、内存管理、核心函数概念等基础知识,以及R语言GPU编程的理论与实践,高级应用技巧,最后通过案例研究与展望,提供实际应用示例并预测未来的发展方向。

# 2. R语言与GPU计算基础

## 2.1 GPU硬件与架构简介

### 2.1.1 GPU的工作原理

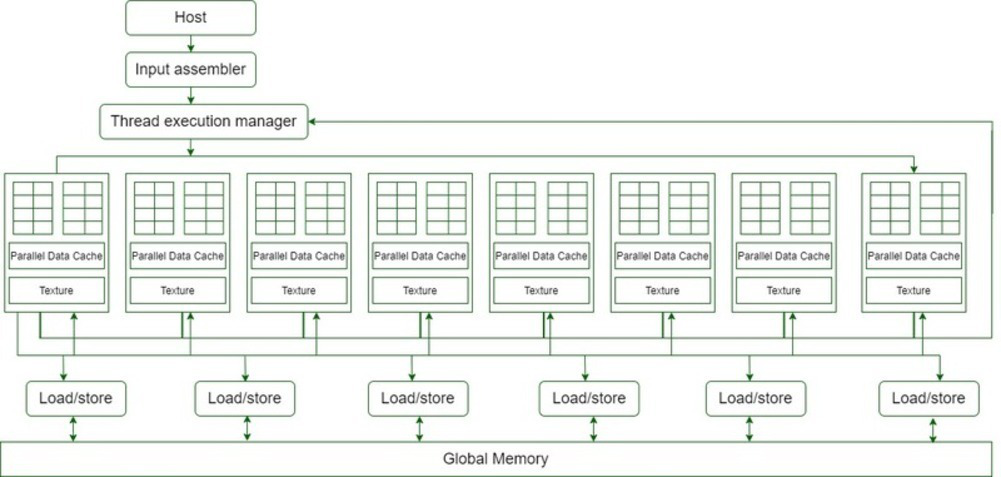

GPU(图形处理单元)是一种专为高效处理大量并行数据而设计的硬件组件。相较于CPU,GPU拥有更多计算核心,能够同时处理大量相似数据集,特别适合于图形渲染、科学计算和机器学习等需要大量并行处理的场景。

GPU的工作原理基于其独特的架构。一个GPU通常由成百上千个较小的核心组成,这些核心能够同时工作。GPU被设计为执行大量的简单操作,例如浮点数运算,从而在图形渲染、矩阵运算和并行计算等领域具有极高的效率。

核心部分由一个主处理器(通常是一个CPU)进行任务分发,主处理器将数据和指令发送到GPU,GPU内部的众多核心并行执行这些指令,最终结果被返回给CPU,或者存储到内存中供进一步处理。

### 2.1.2 GPU与CPU的协同工作

尽管GPU在并行处理方面具有优势,但其在任务管理和复杂决策处理方面仍然依赖于CPU。CPU(中央处理单元)在执行指令和处理复杂逻辑方面比GPU更为擅长,因此,在系统中通常由CPU来处理串行任务和运行操作系统。

CPU和GPU之间的协作模式通常遵循一种“主从”关系,其中CPU作为主处理器,负责分发任务、调度和管理内存等高级任务处理。而GPU作为从属处理器,专注于执行大量的、重复的数据处理任务。这种分工合作模式使得整个系统能够同时利用CPU的灵活性和GPU的高吞吐量特性。

在实际应用中,开发者可以使用特定的编程模型和API(如CUDA、OpenCL)来分配任务给GPU执行,并使用专门的数据传输接口将数据在CPU和GPU之间交换,以实现高效的数据处理和计算。

## 2.2 R语言中的GPU编程环境搭建

### 2.2.1 安装CUDA Toolkit和cuDNN库

对于想要在R中利用GPU进行计算的开发者来说,安装CUDA Toolkit是基础中的基础。CUDA(Compute Unified Device Architecture)是由NVIDIA提供的一个并行计算平台和编程模型,允许开发者使用NVIDIA的GPU进行通用计算。

CUDA Toolkit的安装步骤如下:

1. 访问NVIDIA官方网站下载CUDA Toolkit对应版本的安装包。

2. 执行下载的安装包并遵循安装向导进行安装。

3. 安装过程中,请确保选择包含cuDNN(深度神经网络库)的选项,以便后续进行深度学习相关的GPU加速。

4. 安装完成后,需要根据系统提示设置环境变量,例如添加CUDA安装路径到系统的PATH环境变量中。

5. 重启计算机以使配置生效。

### 2.2.2 配置R语言环境以支持GPU计算

安装完CUDA Toolkit和cuDNN库后,接下来需要配置R语言环境以支持GPU计算。R语言可以通过专门的GPU加速包来利用GPU进行计算,例如`gputools`、`gpuR`等。

配置R语言环境的步骤如下:

1. 打开R或RStudio,安装GPU相关的R包,例如通过以下命令安装`gpuR`包:

```R

install.packages("gpuR")

```

2. 如果需要,还可以安装其他专门用于GPU计算的R包,比如进行深度学习任务的包,如`keras`或`tensorflow`等。

3. 配置完成后,你可以通过运行一个简单的示例代码来验证GPU环境是否配置成功。例如:

```R

library(gpuR)

# 创建一个简单的GPU向量

gpu_vector <- gpuMatrix(rnorm(100), nrow = 10, ncol = 10)

# 执行一次GPU上的矩阵乘法

result <- gpu_vector %*% gpu_vector

```

4. 通过检查`result`对象的内容来确认GPU计算是否成功。

5. 为了进一步优化和调整GPU计算环境,开发者还可以考虑修改R包中的底层C++代码或者CUDA代码,根据具体的计算需求和硬件特性进行优化。

## 2.3 R语言中的基本GPU编程概念

### 2.3.1 内存管理和数据传输

在GPU编程中,内存管理和数据传输是两个基础且至关重要的概念。GPU拥有独立的显存(也称为设备内存),并且通常比CPU内存更大、访问速度更快。

正确管理内存和高效传输数据是实现GPU高效计算的前提。在R语言中使用GPU编程时,需要理解以下几个要点:

1. **显存分配和释放**:为GPU上的数据分配显存空间,并在使用完毕后释放显存,以避免内存泄漏。

2. **主机与设备数据传输**:数据在CPU(主机)和GPU(设备)之间传输时,需要明确指定传输方向和大小。

3. **内存带宽**:数据传输的速度会受到内存带宽的限制。理解带宽限制对于优化数据传输至关重要。

在R语言中使用GPU相关的包时,通常这些操作会通过封装好的函数来简化,例如在`gpuR`包中,会通过特定的函数来处理这些操作。

### 2.3.2 核函数和网格的概念

在GPU编程中,核函数(Kernel Function)是执行在GPU上的程序单元,它是并行计算中的基本执行单元。每个核函数实例在GPU上以线程(Thread)的形式运行。而网格(Grid)是线程组织的方式,由多个块(Block)组成,每个块由多个线程组成。

在R中进行GPU编程时,了解核函数和网格的组织方式,有助于编写高效的并行算法。例如,`gpuR`包中的并行计算函数会隐式地使用这些概念,将计算任务分布到多个线程和块中。

为了有效地使用核函数和网格,开发者需要了解并掌握:

1. **线程的同步和异步执行**:理解如何控制线程间的同步和异步执行,以避免竞态条件和实现数据一致性。

2. **线程的调度和负载平衡**:合理地分配线程任务,使GPU资源得到充分利用,避免某些线程空闲而其他线程过载。

3. **内存访问模式**:理解GPU内存访问模式对于编写优化的GPU代码至关重要。例如,避免线程间的内存访问冲突以及优化共享内存的使用。

通过这些基础知识,开发者能够更好地理解和运用GPU的强大计算能力来提升R语言的数据处理和分析能力。

# 3. R语言GPU编程的理论与实践

## 3.1 并行计算原理在R中的应用

### 3.1.1 任务分解与并行策略

在并行计算中,将复杂的计算任务分解为多个小任务是至关重要的。在R语言中,我们可以将数据集分割成若干子集,并为每个子集分配到不同的处理器上执行计算。这种策略被称为数据并行性。

```r

```

0

0